Wenn man das testen will, wird man natürlich nicht 80% mit statischen Daten beschreiben, 10% freilassen und nur auf 10% schreiben, aber so ähnlich dürfte es auf den meisten im Alltag genutzten SSDs ja aussehen, da wird immer etwas frei gelassen, ein großer Teil ist mit statischen Daten belegt die sich kaum ändern und nur relativ kleiner Teil wird immer wieder überschrieben. Für einen Test würde man 80 bis 90% vollmachen und dann den Rest immer wieder überschreiben, damit man den Unterschied in den P/E Zyklen schneller erhöht, eben weil sich die Schreibvorgänge natürlich zuerst einmal auf die freie Kapazität und die immer wieder überschriebenen NAND Blöcke konzentrieren. Irgendwann wird dann aber mal der Controller für ein besserer Wear Leveling sorgen müssen um einen Ausgleich zu schaffen und nicht nur immer die gleichen Zellen abzunutzen.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

840 evo 1 TB ist lahm auf "alten" Daten

- Ersteller klampf

- Erstellt am

Wird in den meisten Fällen wohl so sein. Allerdings sollte man, wenn man die 840 EVO mit massiven Test Writes belastet, bedenken, das der Hersteller eine max. Schreibleistung von 72 TBW angibt. Sollte das Wear Leveling also sehr spät einsetzen und der Tester eventuell xx TB schreiben müssen um diesen Test auszuführen, könnte dies bei einem praktisch neuem Laufwerk zu möglichen Problemen im Falle eines Garantieanspruches führen, da der Hersteller eine nicht zweckgemäße Nutzung geltend machen könnte.

Dies 72TBW sind Quatsch und künstlich gering angegeben, die halten viel mehr aus und man braucht ja auch nicht so viele Daten zu schrieben um das Wear Leveling auszulösen. Einige haben das Problem ja offenbar schon bei durchschnittlich 3 P/E Zyklen, wenn man also 5 oder 10 mal die Kapazität der SSD beschrieben hat, sollte das schon ausgelöst haben.

Auch das mag so sein, allerdings habe ich an keiner Stelle etwas Gegenteiliges behauptet. Die 72 TBW sind Bestandteil der Spezifikation und somit vermutlich auch ein Kriterium für eventuelle Garantiefälle, nicht mehr und nicht weniger.

Einige vermuten das Problem sogar schon bei durchschnittlich 0 P/E Zyklen.

Einige vermuten das Problem sogar schon bei durchschnittlich 0 P/E Zyklen.

H

highks

Gast

Ja so ein Mist... ich habe gerade erst ein Drobo Mini mit 4 Samsung 840 Evo 1TB bestückt.

Naja, die Performance des Drobo mit SSDs ist sowieso nicht gut, und jetzt lese ich noch von diesen Problemen der Evo - das Ganze war wohl ein kompletter Griff ins Klo

Ich werde es jedenfalls auch mal beobachten, ob die vier Evos im Drobo auch Probleme mit älteren Dateien bekommen. Wie gesagt, die Leistung ist sowieso nicht so berauschend... das kommt davon, wenn man sich auf Verkäufer im Laden verlässt...

Naja, die Performance des Drobo mit SSDs ist sowieso nicht gut, und jetzt lese ich noch von diesen Problemen der Evo - das Ganze war wohl ein kompletter Griff ins Klo

Ich werde es jedenfalls auch mal beobachten, ob die vier Evos im Drobo auch Probleme mit älteren Dateien bekommen. Wie gesagt, die Leistung ist sowieso nicht so berauschend... das kommt davon, wenn man sich auf Verkäufer im Laden verlässt...

Ich habe meine EVO ein paar Tage in Ruhe gelassen und nur minmal benutzt und habe keine Änderung bemerkt.

Am WE habe ich dann angefangen sie wieder relatvi stark zu belasten, aber mit zumindest für praxisrelevanten Aufgaben.

Mal gucken, ob und wann der Effekt einsetzt.

Der Samsung Support hat nochmal nachgefragt, ob ich Tests der SSD schicken kann. Kann ich nicht so gut, da ich am Anfang blöderweise kein Screenshot von HD Tune gemacht habe.

Die von mir immer wieder angegebenen Threads, scheinen die sich nicht anzugucken.

Im overclockers-thread ging es am WE noch gut ab und ein weiteres Testtool wurde entwickelt, seit dem hatte ich leider keine Zeit zum Lesen.

Am WE habe ich dann angefangen sie wieder relatvi stark zu belasten, aber mit zumindest für praxisrelevanten Aufgaben.

Mal gucken, ob und wann der Effekt einsetzt.

Der Samsung Support hat nochmal nachgefragt, ob ich Tests der SSD schicken kann. Kann ich nicht so gut, da ich am Anfang blöderweise kein Screenshot von HD Tune gemacht habe.

Die von mir immer wieder angegebenen Threads, scheinen die sich nicht anzugucken.

Im overclockers-thread ging es am WE noch gut ab und ein weiteres Testtool wurde entwickelt, seit dem hatte ich leider keine Zeit zum Lesen.

Es scheint als bestätigt Samsung den Fehler jetzt und soll jetzt wohl an einem Fix arbeiten: http://www.anandtech.com/show/8550/...40-evo-read-performance-bug-fix-is-on-the-way

Blublah

Lt. Commander

- Registriert

- März 2009

- Beiträge

- 1.981

Hier ist auch ein Artikel auf pcper.com:

http://www.pcper.com/reviews/Editorial/Samsung-840-840-EVO-susceptible-flash-read-speed-degradation-over-time

Ich hab mal die Redaktion angeschrieben ob sie nicht auch darüber berichten wollen.

Hier ist noch die neuste Version von FileBench zum analysieren der Geschwindigkeit und zum Neu-Schreiben alter Dateien (auf eigene Gefahr):

Anhang anzeigen File Bench 006a.zip

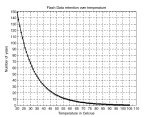

Übrigens hab ich noch was gefunden. Die Leserate scheint auch mit steigender Temperatur stark zu sinken. Und zwar in einem Temperaturbereich der eigentlich recht normal sein sollte (32-52 Grad).

Noch dazu sieht es so aus als ob die Datenrate mit höherer Temperature je mehr sinkt desto älter die Daten sind:

Neueste: 510 -> 507 MB/s = - 0.8%

2 Wochen alt: 477 -> 427 MB/s = - 10.5%

3 Wochen alt: 278 -> 211 MB/s = - 24%

4 Wochen alt: 289 -> 177 MB/s = - 39%

Hier sieht man die Messungen von den gleichen 100GB bei 32 und 52 Grad:

Hier hat noch jemand seine 840 nicht EVO getestet:

http://www.pcper.com/reviews/Editorial/Samsung-840-840-EVO-susceptible-flash-read-speed-degradation-over-time

Ich hab mal die Redaktion angeschrieben ob sie nicht auch darüber berichten wollen.

Hier ist noch die neuste Version von FileBench zum analysieren der Geschwindigkeit und zum Neu-Schreiben alter Dateien (auf eigene Gefahr):

Anhang anzeigen File Bench 006a.zip

Ergänzung ()

Übrigens hab ich noch was gefunden. Die Leserate scheint auch mit steigender Temperatur stark zu sinken. Und zwar in einem Temperaturbereich der eigentlich recht normal sein sollte (32-52 Grad).

Noch dazu sieht es so aus als ob die Datenrate mit höherer Temperature je mehr sinkt desto älter die Daten sind:

Neueste: 510 -> 507 MB/s = - 0.8%

2 Wochen alt: 477 -> 427 MB/s = - 10.5%

3 Wochen alt: 278 -> 211 MB/s = - 24%

4 Wochen alt: 289 -> 177 MB/s = - 39%

Hier sieht man die Messungen von den gleichen 100GB bei 32 und 52 Grad:

Hier hat noch jemand seine 840 nicht EVO getestet:

Zuletzt bearbeitet:

Ich habe (mit etwas Mühe) die Threads auf overclockers verfolgt und der Effekt ist absolut eindeutig.

Blublah hat sogar die ganze Zeit schreibend mitgehalten und dauernd sein Tool verbessert

Wenn Anandtech das verlinkte schreibt, ist das vermutlich tatsächlich bei Samsung angekommen.

Ich bin sehr gespannt, was da kommen wird.

Sehr spannend auch die gefundene, unbenutzte 840 evo mit dem 1 Jahr alten 400 GB File, das komplett lahm ist. Damit ist wirklich klar, dass allein das Alter der Faktor ist.

Die Daten werden also nicht langsamer, weil sie immer mehr und schlecht reorganisiert werden.

Ein weiterer Hinweis darauf:

Zwischenzeitlich hatte ich ja meine 840 evo 1 TB wieder "unter Last" gesetzt. In der letzten Woche wurde darauf ziemlich genau 1 TB geschrieben. Es fing mit TBW 3,9 an und ist jetzt bei 4,9.

Am Anfang waren auf der SSD rund 600 GB belegt und 400 GB frei. Die 600 GB wurden nicht verändert und die Schreibzugriffe gingen alle in neue Files, die in den 400 GB zum liegen kamen.

Bisher hat sich an dem Lesespeed aller Daten, egal ob alt oder neu nichts geändert. Das legt auch nahe, dass es nicht an einer falschen Reorganisation liegt, denn die meine Evo war schon bei einem TBW von < 3 lahm geworden. Da hätte das inzwischen auch wieder was passieren müssen.

Blublah hat sogar die ganze Zeit schreibend mitgehalten und dauernd sein Tool verbessert

Wenn Anandtech das verlinkte schreibt, ist das vermutlich tatsächlich bei Samsung angekommen.

Ich bin sehr gespannt, was da kommen wird.

Sehr spannend auch die gefundene, unbenutzte 840 evo mit dem 1 Jahr alten 400 GB File, das komplett lahm ist. Damit ist wirklich klar, dass allein das Alter der Faktor ist.

Die Daten werden also nicht langsamer, weil sie immer mehr und schlecht reorganisiert werden.

Ein weiterer Hinweis darauf:

Zwischenzeitlich hatte ich ja meine 840 evo 1 TB wieder "unter Last" gesetzt. In der letzten Woche wurde darauf ziemlich genau 1 TB geschrieben. Es fing mit TBW 3,9 an und ist jetzt bei 4,9.

Am Anfang waren auf der SSD rund 600 GB belegt und 400 GB frei. Die 600 GB wurden nicht verändert und die Schreibzugriffe gingen alle in neue Files, die in den 400 GB zum liegen kamen.

Bisher hat sich an dem Lesespeed aller Daten, egal ob alt oder neu nichts geändert. Das legt auch nahe, dass es nicht an einer falschen Reorganisation liegt, denn die meine Evo war schon bei einem TBW von < 3 lahm geworden. Da hätte das inzwischen auch wieder was passieren müssen.

Das scheint dann am Auslesen zu liegen und dürfte schwerer zu beheben sein. Wobei ich nicht ganz verstehe, wie die SSD die Schrank lang das Alter bemerkt hat, die haben ja keine eingebaute Uhr und die NANDs einer so neuen SSD sollten noch nicht in so kurzer Zeit signifikant an Ladung verlieren. Aber Samsung ist jetzt ja am Thema dran.

Der eine Typ formuliert ja eine "Lesekalibration-Theorie", dass die SSD eine Vorhersage haben müsste wie weit die Level einer Zelle abnehmen.Holt schrieb:Das scheint dann am Auslesen zu liegen und dürfte schwerer zu beheben sein.

Was auf jeden Fall als Maßnahme möglich wäre, ist das Neuschreiben, wenn die Daten unter eine bestimmte Geschwindigkeit gefallen sind. Das ginge in der Firmware. Wäre aber nur eine Frickellösung.

Ich kann mir schwer vorstellen, dass die eigentlichen Flashbausteine wirklich bewusst unter Akzeptanz des gezeigten Verhaltens entwickelt wurden.

Blublah

Lt. Commander

- Registriert

- März 2009

- Beiträge

- 1.981

Holt schrieb:Das scheint dann am Auslesen zu liegen und dürfte schwerer zu beheben sein. Wobei ich nicht ganz verstehe, wie die SSD die Schrank lang das Alter bemerkt hat, die haben ja keine eingebaute Uhr und die NANDs einer so neuen SSD sollten noch nicht in so kurzer Zeit signifikant an Ladung verlieren. Aber Samsung ist jetzt ja am Thema dran.

Das hier vielleicht:

Data Retention

Data retention explains how long a flash cell will retain its data, statistically. NAND flash found its growth, and was originally optimized for consumer applications where the flash device is treated as temporary storage, such as digital cameras. Read: nobody expected the device to be data-resilient over time, unlike what enterprise applications require.

So flash cells lose their charge over time. The weaker the cell, the faster it can lose its charge. For enterprise storage, suppliers should be able to explain what they do to refresh data over time to account for the loss of charge to the flash cells. Whether using SSDs or packaged chips, some explanation of error detection ヨ and correction (called ECC) should be in the conversation.

http://www.purestorage.com/resources/introduction-to-flash-memory.html

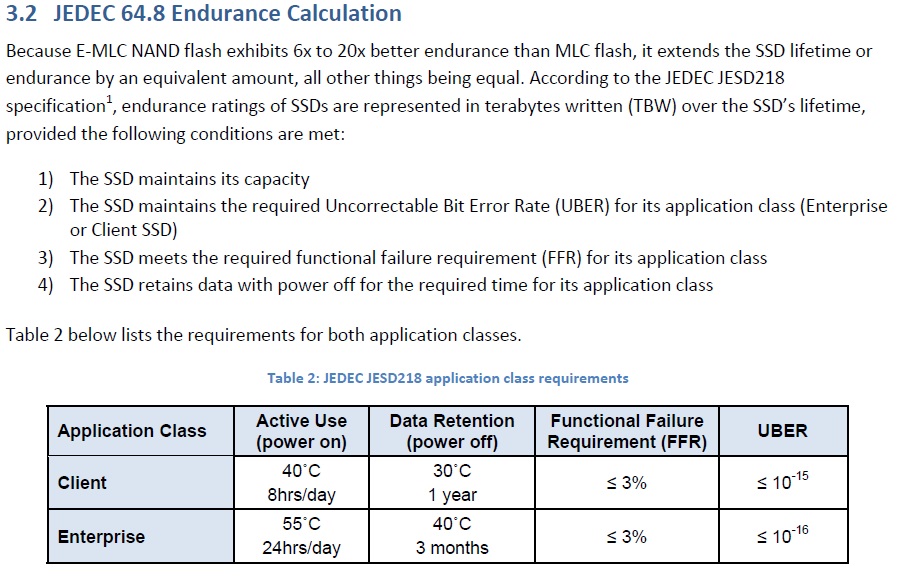

Natürlich verlieren die Zellen mit der Zeit Ladung und dann musst man eben aufwendiger Lesen, also mit anderen Thresholds mehrfach die Ladung auslesen um die Werte zu rekonstruieren, dass dauert dann halt. Aber die JEDEC schreibt in der JESD 218 für Consumer (Client) SSDs u.a. vor, dass die Daten 12 Monate bei 30°C erhalten bleiben (für Enterprise SSDs 3 Monate bei 40°C) und trotzdem bestimmte Fehlerraten nicht überschritten werden:

Das gilt bis zum Erreichen der spezifizierten Zyklen und die DRT fällt erst gegen Ende der Lebensdauer von NANDs wirklich massiv ab:

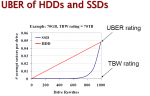

Das kann man umgekehrt auch an der UBER ablesen, also der Rate der nicht korrigierbaren Bitfehler:

Dann hängt es mit der Temperatur zusammen:

Damit könnte man es vermutlich eingrenzen. Dazu müsste man am besten zwei neue Evos einmal beschreiben und die eine dann in den Kühlschrank und die anderen in einen Ofen bei konstant 60 oder 70°C legen. Bei der im Kühlschrank dürfte es viel länger dauern bis die Verlangsamung eintritt als bei der im Ofen, wenn es mit Ladungsverlust zu tun hat. Dann wäre Samsung aber wohl wirklich gezwungen die Daten regelmäßig intern umzukopieren um das zu vermeiden.

Das gilt bis zum Erreichen der spezifizierten Zyklen und die DRT fällt erst gegen Ende der Lebensdauer von NANDs wirklich massiv ab:

Das kann man umgekehrt auch an der UBER ablesen, also der Rate der nicht korrigierbaren Bitfehler:

Dann hängt es mit der Temperatur zusammen:

Damit könnte man es vermutlich eingrenzen. Dazu müsste man am besten zwei neue Evos einmal beschreiben und die eine dann in den Kühlschrank und die anderen in einen Ofen bei konstant 60 oder 70°C legen. Bei der im Kühlschrank dürfte es viel länger dauern bis die Verlangsamung eintritt als bei der im Ofen, wenn es mit Ladungsverlust zu tun hat. Dann wäre Samsung aber wohl wirklich gezwungen die Daten regelmäßig intern umzukopieren um das zu vermeiden.

Zuletzt bearbeitet:

Tabelle Seite 27

Wenn sich der Controller auf 52 °C erwärmt, dann dürfte der NAND sich auf Dauer auf ähnlicher Temperatur erwärmen.

Mal sehen ob sich Samsung ausführlich äußert.

Wenn sich der Controller auf 52 °C erwärmt, dann dürfte der NAND sich auf Dauer auf ähnlicher Temperatur erwärmen.

Mal sehen ob sich Samsung ausführlich äußert.

Holt schrieb:Natürlich verlieren die Zellen mit der Zeit Ladung und dann musst man eben aufwendiger Lesen, also mit anderen Thresholds mehrfach die Ladung auslesen um die Werte zu rekonstruieren, dass dauert dann halt. Aber die JEDEC schreibt in der JESD 218 für Consumer (Client) SSDs u.a. vor, dass die Daten 12 Monate bei 30°C erhalten bleiben (für Enterprise SSDs 3 Monate bei 40°C) und trotzdem bestimmte Fehlerraten nicht überschritten werden:

Danke, das Du wieder diesen Textbaustein hier einfügst, allerding bin mit der Interpreation der JESD nicht deiner Meinung. EIne DRT von 3 Monaten für wesentlich hochwertige eMLC Chips stehen doch mehr als deutlich im Widerspruch zu einer einjährigen DRT für einfache Consumer MLCs. Da machen auch 10 Grad Temp-Differenz keinen entscheidenden Grund dieser Aussage zu folgen. Hier ist definitv irgendein Fehler drin!

@juenger

Wenn die eMLC als Consumer SSD deklariert wäre, dann müsste sich diese auch an die Consumer Spezifikation halten.

SSDs mit eMLC sind mir bis jetzt nur als Enterprise SSDs bekannt.

Edit:

Wir sprechen hier von der Art der Vermarktung und nicht vom Anwendungsfall.

Wenn die eMLC als Consumer SSD deklariert wäre, dann müsste sich diese auch an die Consumer Spezifikation halten.

SSDs mit eMLC sind mir bis jetzt nur als Enterprise SSDs bekannt.

Edit:

Wir sprechen hier von der Art der Vermarktung und nicht vom Anwendungsfall.

Ist schon klar, aber gerade die JESD 218 wurde eigentlich definiert um einen Standard für die jeweiligen Anwendungsszenarien zu realisieren und entsprechende Sicherheit in die Frage der TBW und die damit verbundene Datenintegrität zu bringen. Entschuldigung wenn ich da etwas durcheinander gebracht habe.

Ähnliche Themen

- Antworten

- 23

- Aufrufe

- 1.625

- Antworten

- 27

- Aufrufe

- 1.815

- Antworten

- 6

- Aufrufe

- 499

- Antworten

- 7

- Aufrufe

- 611