SeS

Lt. Junior Grade

- Registriert

- Aug. 2010

- Beiträge

- 390

Blublah schrieb:Nein, sollte in Ordnung sein. HDTach hat so seine eigenen Probleme mit der EVO.

Nimm mal HDTune (sektororientiert wie HDTach) oder FileBench (dateiorientiert).

http://www.hdtune.com/

Anhang anzeigen 442442

Ausserdem benutz mal die Energieeinstellung 'Hohe Performance' in Windows beim messen. Das kann auch noch einen Unterschied machen.

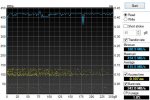

Ok besten Dank. Habe nun einmal HD Tune laufen lassen und es ist bis auf den Anfang und zwei Außreißer bei 2/3 über 400 mb/s. Jetzt bin ich wieder beruhigt.

Ob es nun wirklich so ist oder ich mir das einbilde, aber gefühlt ist mein System wieder erheblich schneller. Habe die SSD nun fast 8 Monate und da waren dann doch sehr alte Dateien bei!

N8 zusammen,

Gruß SeS