moshimoshi

Captain

- Registriert

- Juli 2008

- Beiträge

- 3.897

wie sehr unterscheidet sich das zu sweet fx?

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Das behauptest duSontin schrieb:"...

deaktiviert man die Gameworks-Effekte in beiden Spielen, hat man eine annährend 1:1 Kopie der Konsolenversion...

http://www.geforce.com/whats-new/gu...far-cry-4-nvidia-hbao-plus-ambient-occulusionSSBC is Ubisoft's new in-house AO technique, designed for current-generation consoles, where by all reports it performs admirably. Compared to SSAO it is far more accurate, far more stable (fewer temporal artifacts), and shadows fine detail that SSAO leaves untouched.

Vielleicht hat Ubsoft gar nicht optimiert? Vielleicht hatte Ubisoft z. B. auch gar keine Möglichkeit in bestimmten Bereichen zu Optimieren? (unabhängig davon, worauf sie programmiert habenSontin schrieb:Aber wahrscheinlich hat Ubisoft die Konsoleneffekte auf nVidia-hardware programmiert, gell.

Sontin schrieb:Nö. Ich muss garnichts behaupten. Ohne Gameworks sind es exakt die Konsolenspiele mit den selben Effekten.

Hier von nVidia(!):

http://www.geforce.com/whats-new/gu...far-cry-4-nvidia-hbao-plus-ambient-occulusion

Aber wahrscheinlich hat Ubisoft die Konsoleneffekte auf nVidia-hardware programmiert, gell.

Dai6oro schrieb:Schöner Test zur falschen Zeit. Die Tests müssten nach Release gemacht werden. Nach starker Kritik hat es Ubisoft doch tatsächlich geschafft in ACU im 4. Patch die interne Handbremese zu lösen siehe:

http://ht4u.net/news/30512_ac_unity...erungen_-_insbesondere_amd-grafik_profitiert/

Fakt ist. Nvidia hat damit ereicht was es wollte. Zu Beginn wenn die Spielbenches gemacht werden steht AMD doof da. Wenn jeder das Spiel durch hat und kein Hahn mehr danach kräht, kann man dier Bremse ruhig lösen.

Das gleiche werden wir in allen folgenden GW Titeln beobachten können.

Hättet ihr mal lieber einen aktuellen GW Vertreter genommen:

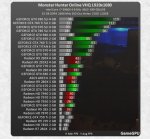

Anhang anzeigen 467040

http://gamegpu.ru/mmorpg-/-onlayn-igry/monster-hunter-online-benchmark-test-gpu.html

Und jetzt behauptet nochmal GW würde AMD nicht ausbremsen.

Sebbi schrieb:naja da sieht mal wieder wie Nvidia es nötig hat, andere Hersteller auszubremsen, damit die eigenen Karten nicht so überteuert daher kommen und ein besseres P/L Verhältniss haben.

und ja, mir ist das das bashing ist, aber es ist nunmal so wie auch die Nvidia Beführworter nicht abstreiten können!

Auch nicht wie Nvidia es auch schon nötig hatte, bei benchmarks zu schummeln.

viele tester machen welche in unterschiedlichen benchmarks und viele leser achten nur auch die benchmarks mit max einstellungenzeromaster schrieb:Ach bitte, die meisten Vergleichstests werden ohne Sondereffekte gemacht, welcher Vorteil bleibt denn da?

Mars2k8 schrieb:Fragt sich halt wie neutral die Engines sind... also wie performant die auf AMD-Karten wäre, wenn Gameworks nicht verwendet werden würde bzw. Ubisoft und Nvidia keine Kooperation hätte.

Dass die Gameworks-Option "abgeschaltet" ist heißt ja längst nicht, dass da nicht trotzdem rumgefuscht wird bzw. das Framework trotzdem nicht irgendwie Performance kostet oder whatever.

Mod Arse Nulpe schrieb:Hier wird wieder nichts anderes weiter aufgezeigt das nVIDIA wie üblich schneller ist, bin kein Fanboy ,habe momentan eine R9 290 verbaut.

Dai6oro schrieb:Schöner Test zur falschen Zeit. Die Tests müssten nach Release gemacht werden. Nach starker Kritik hat es Ubisoft doch tatsächlich geschafft in ACU im 4. Patch die interne Handbremese zu lösen siehe:

http://ht4u.net/news/30512_ac_unity...erungen_-_insbesondere_amd-grafik_profitiert/

fox40phil schrieb:Ich Will man hier wieder täuschen?

Sephiroth51 schrieb:Der ganze Test ist aussagelos hätte man sich sparen können.

Das Nvidia schneller ist mit einer GTX 980 kann ich nachvollziehen ist ja auch eine gute Karte aber hier wird nicht aufgeklärt ob was an den Behauptungen was drann ist man hätte auch noch eine GTX 970 mit in den Test nehmen sollen.

So bleibt es eher eine Nvidia Werbung.

Das Nvidia schneller ist.