Nvidia führt GeForce PhysX ein

Vergangenen Februar übernahm Nvidia das angeschlagene Unternehmen Ageia, welches sich auf die Entwicklung von Physik-Beschleunigerkarten (PPU) spezialisiert hatte. PhysX-Effekte konnten bislang über eine CPU oder die schnellere PPU berechnet werden. Nvidia lässt die PPU jedoch auslaufen und wird die Berechnung über eine GPU ermöglichen.

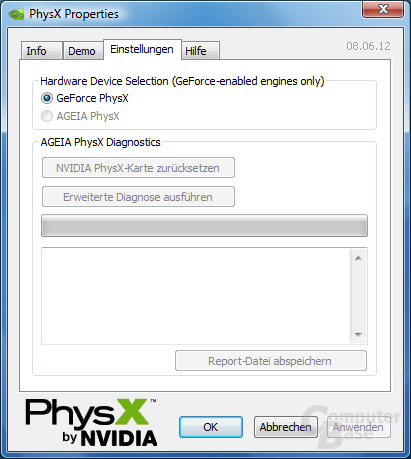

Mit der Einführung von GeForce PhysX ist der Tod von Ageias PPU nun also besiegelt. Durch neue Treiber, den GeForce 177.39 und den PhysX 8.06.12, ermöglicht Nvidia erstmals die Berechnung von PhysX über eine Nvidia-GPU, welche durch ihre hohe Anzahl von Shader-Prozessoren wesentlich besser hierfür geeignet ist, als eine gewöhnliche CPU. Offiziell erlauben die Treiber zunächst eine Unterstützung von GeForce PhysX nur mit einer GeForce GTX 280 und GTX 260 sowie einer GeForce 9800 GTX und der frisch angekündigten 9800 GTX+. Schon in der kommenden Woche soll der Support jedoch für die kompletten Familien der GeForce 8 und 9 angekündigt werden.

Bei den Kollegen von Expreview finden sich erste Ergebnisse, die sowohl die Taktskalierung zwischen einer GeForce 9800 GTX (675/1675/1100 MHz) und der schnelleren 9800 GTX+ (738/1836/1100 MHz) im 3DMark Vantage als auch den Leistungsvorteil einer GPU gegenüber einer CPU in Unreal Tournament 3 aufzeigen sollen. Während im 3DMark Vantage allerdings nur der CPU Test 2 PhysX unterstützt, kamen im Test mit Unreal Tournament 3 ausschließlich Maps mit PhysX-Unterstützung, unter anderem aus Ageias PhysX-Mod-Kit, zum Einsatz. Der 3DMark Vantage wurde im relativ niedrig auflösenden Performance-Preset durchlaufen, um die CPU-Last hoch zu halten. Die übrigen Grafiktests relativieren das Ergebnis zwar etwas, doch liegen die Ergebnisse mit 7.081 beziehungsweise 7.892 Punkten deutlich über den Werten, die eine GeForce 9800 GTX mit gut 6.000 Punkten üblicher Weise erreicht. In entsprechenden Anwendungen, wie den ausgewählten Maps von Unreal Tournament 3, kann sich GeForce PhysX deutlich in Szene setzen.