HDD vs. SSD: G.Skill, Intel und Transcend gegen Western Digital

2/10Testprobanden

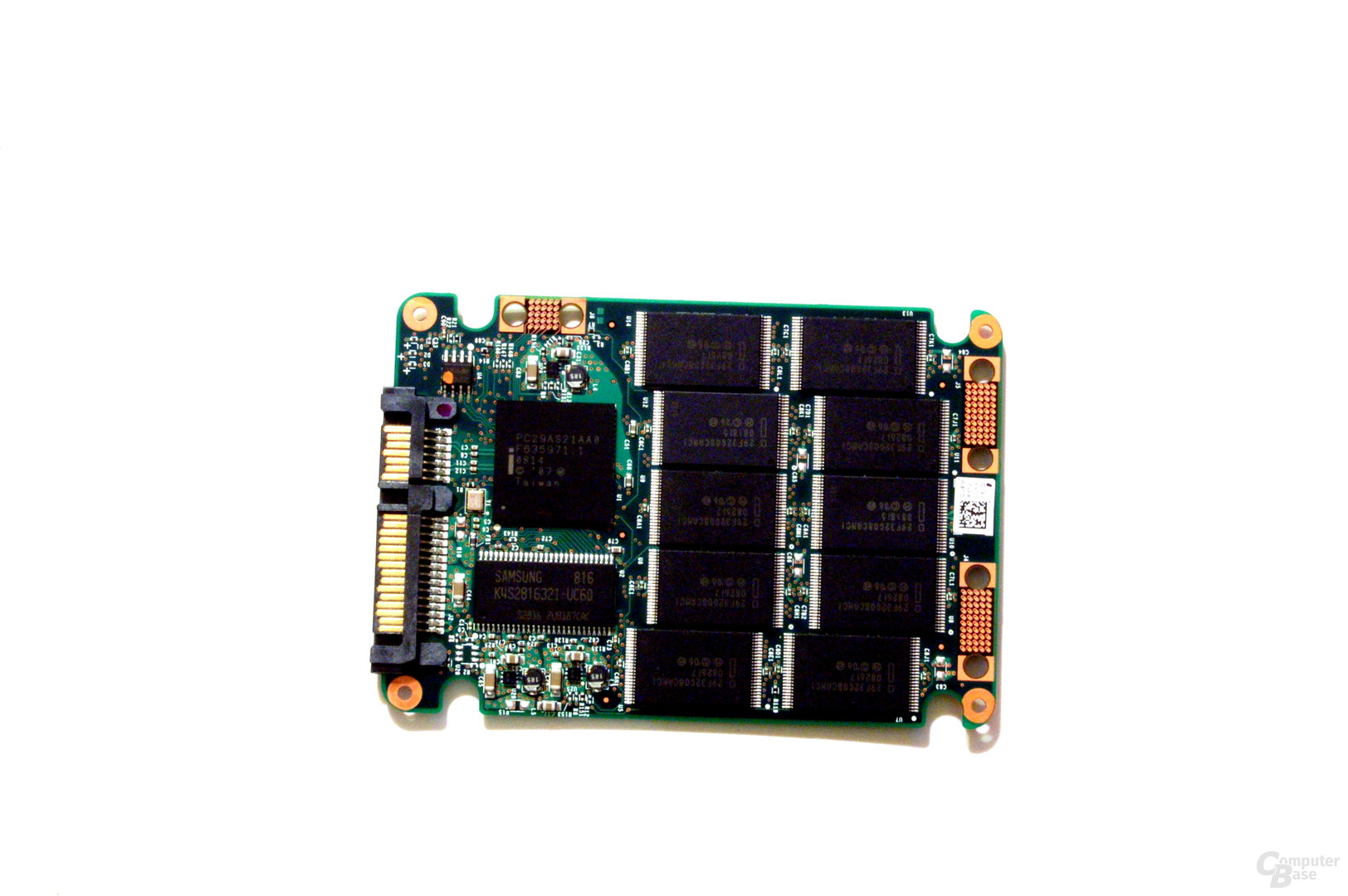

G.Skill Titan

G.Skills „Titan“ ist mit einer Kapazität von 256 GB ein Riese unter den Solid State Drives. Um diese vergleichsweise hohe Speicherkapazität zu erreichen, kommen 16 Large-Block-MLC-Flashbausteine von Samsung zum Einsatz. Als Controller dient mit dem „JMF602B“ die überarbeitete Version des bei den Herstellern so beliebten Chips von JMicron mit acht Speicherkanälen – in doppelter Ausführung. Zwei Controller zu verbauen mag zwar im ersten Moment seltsam erscheinen, ergibt aus Performance-Sicht jedoch durchaus einen Sinn. Denn hinter dem S-ATA-Anschluss der Titan verbirgt sich eigentlich ein RAID-0-Verbund.

Dazu sitzt auf der Platine neben den beiden jeweils mit acht Speicherchips verbundenen Controllern noch ein weiterer Chip von JMicron. Der „JMB390“ ist ein S-ATA-Port-Multiplier mit RAID-Unterstützung und sorgt dafür, dass der Kunde die Titan trotz des RAID 0 wie jede andere Festplatte nutzen und gleichzeitig vom höheren Datendurchsatz profitieren kann. G.Skill gibt die sequenziellen Lese- und Schreibraten entsprechend mit maximal 200 respektive 160 MB/s an. Inwieweit der RAID-Verbund Vorteile bei den zufälligen Schreibzugriffen mit sich bringt, werden wir uns im Benchmarkteil etwas genauer ansehen. Unabhängig davon soll den Herstellern zufolge die überarbeitete Version des Controllers die Performance im Vergleich zu früheren Modellen verbessern. Die MTBF liegt bei 1,5 Mio. Betriebsstunden, die Garantie beträgt zwei Jahre.

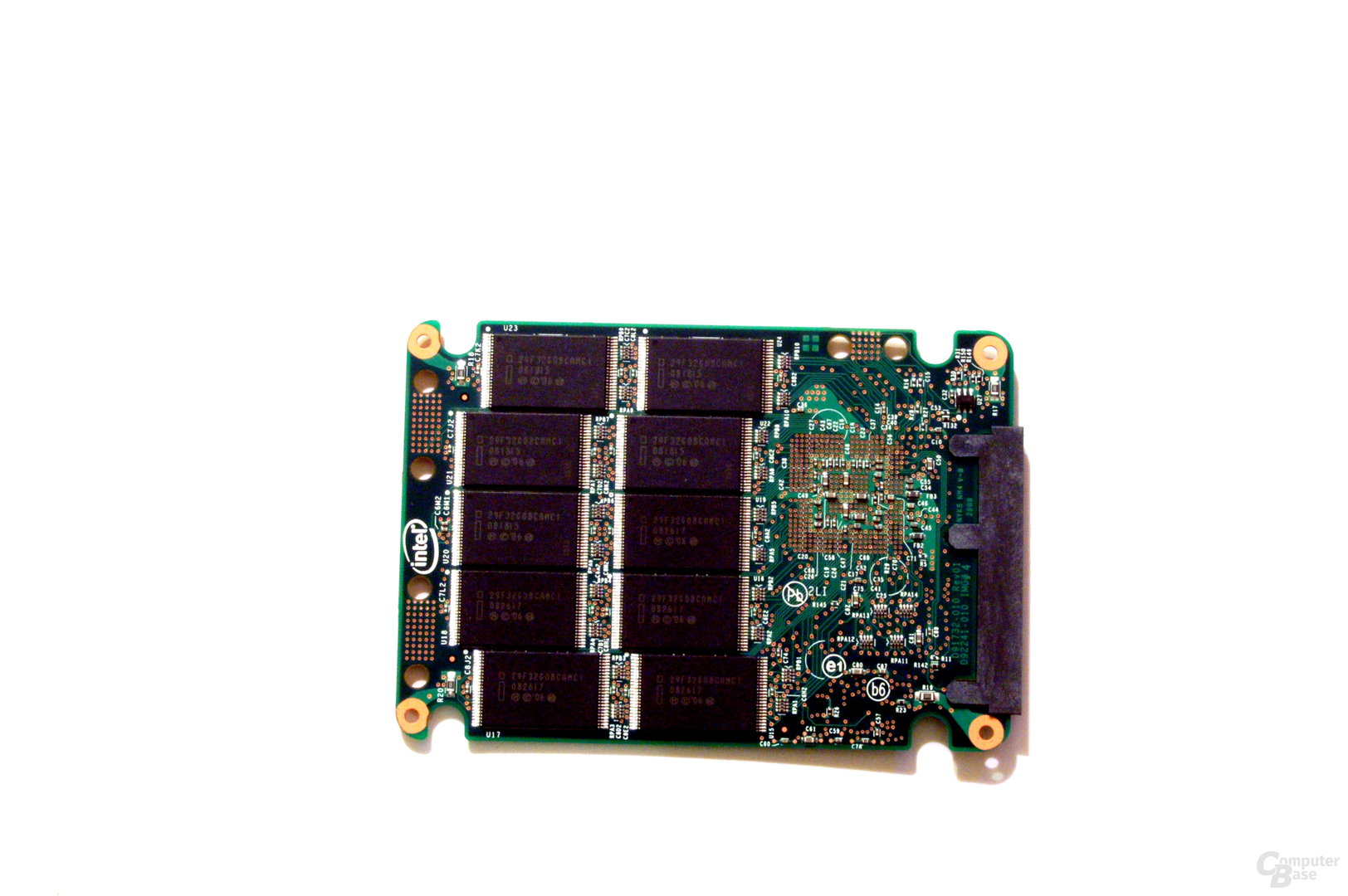

Intel X25-M

Eigentlich war es nur eine Frage der Zeit, bis der weltgrößte Halbleiterhersteller Intel in Zeiten schrumpfender Margen im Prozessorgeschäft auf den SSD-Zug aufspringen würde. Es hat zwar ein wenig gedauert, doch letztendlich betrat das Unternehmen mit den Modellen X25-M und X18-M für den Privatkundenmarkt sowie X25-E für den Servermarkt im letzten Jahr die Bühne. Der entscheidende Unterschied zwischen den Mainstream- und den Extreme-Modellen liegt in den verwendeten Flash-Chips. Während erstere mit MLC-Chips gefertigt werden, setzt man bei den Unternehmensmodellen auf performantere SLC-Chips, die allerdings bei gleicher Strukturgröße eine geringere Kapazität bieten. Die beiden M-Baureihen unterscheiden sich lediglich im Formfaktor von 2,5 bzw. 1,8 Zoll.

Doch was kann man vom Intel-Label auf dem Solid State Drive erwarten? Nur ein weiteres Standarddesign, wie man es von so vielen der am Markt befindlichen Produkte kennt? Mitnichten. Während das Gros der Hersteller auf MLC-Speicherchips von Samsung in Verbindung mit JMicrons berühmt-berüchtigtem Controller mit Bezeichnung „JMF602“ setzt, haben die Intel-Ingenieure einen eigenen Controller entwickelt, der mit den in einem 50-nm-Prozess gefertigten MLC-Chips über zehn parallele Speicherkanäle kommuniziert – jeweils zwei Speicherchips hängen an einem Kanal – und Native Command Queuing (NCQ) beherrscht. Ihm zur Seite stehen – und darin unterscheidet sich der Intel-Controller ebenso von den meisten anderen SSD-Lösungen – 16 MB Cache, die zur effizienten Ausführung der „Wear Leveling“-Algorithmen und des NCQ benötigt werden. Die Wear-Leveling-Algorithmen sollen für die gleichmäßigen Nutzung aller Speicherbausteine sorgen, um den frühzeitigen Ausfall einiger Blöcke zu verhindern.

Zudem soll die sogenannte „Write Amplification“minimiert werden. Dabei handelt es sich um einen Faktor, der angibt, wie viel mehr Zellen bei Schreibvorgängen angesprochen und damit abgenutzt werden, als dies eigentlich nötig wäre. Denn die Blockgröße bei NAND-Bausteinen in den für SSDs benötigten Größen beträgt 128 KB. Zwar sind die in einem Block zusammengefassten Pages nur 2.048 Byte groß, beim Löschen werden jedoch immer alle Pages eines Blocks gleichzeitig angesprochen, auch wenn eigentlich nur eine einzelne Page gelöscht werden müsste. Wenn man sich nun ins Gedächtnis ruft, dass die Zahl der Schreib-/Löschzyklen bei Flashspeicher begrenzt ist (10.000 bei MLC und 100.000 bei SLC), ist es natürlich entscheidend jeweils so wenige Pages wie möglich zu löschen, zumal die Performance ebenfalls davon profitiert. Durch den Cache können die Daten nun zwischengespeichert und effizienter in Paketen auf die verschiedenen Blöcke geschrieben werden. Bei der Entwicklung der SSDs legte Intel neben einer langen Nutzungsdauer zudem besonderen Wert auf eine hohe IOPS-Leistung (Input/Output Operations per Second) auch bei Random Writes sowie eine geringe Leistungsaufnahme. Gerade die Random Writes haben sich beispielsweise als Achillesverse des JMF602 erwiesen. Die MTBF liegt bei 1,2 Mio. Betriebsstunden, die Garantie bei drei Jahren.

Fragmentierungsprobleme?

Im Rahmen der CeBIT wurden wir von Intel auf einen Artikel der Kollegen von PC Perspective angesprochen, den der Hersteller aus Santa Clara in dieser Form bereits kurz nach Veröffentlichung als nicht stichhaltig kommentiert hatte. Intel wollte von uns wissen, ob auch wir ähnliche Entdeckungen gemacht haben. Worum geht es konkret?

Von HDDs ist bekannt, dass die Leistung der Festplatte – je nach Dateisystem – mit zunehmender Nutzungsdauer nachlässt, da die Daten fragmentieren. Mit einem Defragmentierungsprogramm lässt sich dieses Problem aus Windows heraus allerdings in einem überschaubaren Zeitrahmen lösen, ohne dabei selbst viel Arbeit verrichten zu müssen. Auch Intels X25-M hat wie jede Festplatte mit Fragmentierungsproblemen zu kämpfen und kann aus diesem Grund laut PC Perspective (dies gibt Intel in geringem Umfang auch unumwunden zu) abhängig von den Anwendungsszenarien mit zunehmender Betriebszeit einen erheblichen Teil der maximalen Leistung einbüßen. In diesem Fall ist die Problemlösung – die Verkürzung der Lebensdauer durch die intensiven Schreib- und Löschvorgänge beim Defragmentieren einmal außen vor – jedoch ein wenig komplizierter als bei HDDs, denn das Betriebssystem kann nicht direkt auf die Speicherorte der Dateifragmente zugreifen, um eine Defragmentierung durchzuführen, da zwischen ihm und den Flashchips die Lookup-Tabelle der SSD steht. Das Laufwerk ist daher auf interne Mechanismen zur Defragmentierung angewiesen, was jedoch nur dann geschieht, wenn größere Dateien auf den Datenträger geschrieben werden. Aus ihren Ergebnissen schlussfolgerten die Kollegen, dass bei der X25-M hier etwas grundlegend nicht zu stimmen scheint.

Intel gab diesbezüglich zu Protokoll, dass die eigenen Ingenieure diese massiven Leistungseinbrüche derzeit nicht nachvollziehen könnten. Zudem entsprächen die von den Kollegen simulierten Systemlasten nicht realen Lastszenarien. Diesbezüglich kann man Intel zumindest insoweit auf jeden Fall Recht geben, dass beispielsweise die Simulation eines Fileservers auf jeden Fall nicht dem von Intel vorgesehenen Nutzungsschema für die X25-M entspricht, die ja gerade auf die Anforderungen in mobilen Geräten hin optimiert wurde. Dies könnte sich auch in den durch den Controller verwendeten Algorithmen widerspiegeln, die für die für Mobil-Systeme ungewöhnlichen Lastsimulationen ungeeignet sein könnten. Hier wären entsprechende Vergleiche mit der SLC-Variante X25-E hilfreich, die ja wiederum gerade für den Einsatz in Servern optimiert wurde.

Wir konnten bei unseren Tests keine Veränderungen in der Leistung der X25-M feststellen, haben jedoch auch keine Langzeitnutzung simuliert, so dass damit auch nicht wirklich zu rechnen war. Es wird interessant zu sehen sein, was Intel nach einer Analyse noch bezüglich der Testmethoden von PC Perspective veröffentlichen wird. Da diesbezüglich momentan noch Unklarheit herrscht, haben wir von einem eigenen Test der Langzeitleistung vorerst abgesehen und lassen in die Bewertung lediglich die Leistung in den von uns verwendeten Benchmarks einfließen.

Sollte es dennoch zu Performanceinbußen kommen, gibt Intel derzeit (an einer einfacheren Lösung arbeiten die Intel-Ingenieure) als Lösungsvorschläge das mehrfache Beschreiben der SSD mit großen Dateien oder einen Reset der logischen Blockadressierung mittels entsprechender Tools an. Wirklich praktikabel ist jedoch keine der beiden Varianten. Für beide gilt, dass die SSD dazu keine Daten mehr enthalten sollte. Wird im Anschluss ein zuvor erstelltes Image wieder aufspielt, führt die identische Anordnung der Daten erneut zu denselben Leistungseinbußen.