RAM-OC mit Intel-CPUs im Test: Core (X) trifft übertakteten Arbeitsspeicher

tl;dr: Seit AMD Ryzen ist die Wichtigkeit von schnellem RAM für die maximale Leistung in Spielen einem breiten Publikum präsent. Aber nicht nur AMDs Prozessoren profitieren im CPU-Limit von einer optimalen Balance aus Speicher-Latenz und -Bandbreite, auch bei Intel ist das der Fall.

Der Autor dieses Artikels ist kein Redaktionsmitglied, sondern aktives Mitglied der RAM-OC-Community im Forum von ComputerBase. Nachdem die Community-Expertise zum Thema RAM-OC auf AMD Ryzen 3000 bereits ihren Auftritt auf ComputerBase hatte, hat sich Friedrich Günther jetzt der Intel-Perspektive angenommen.

Wann limitiert der Prozessor beim Spielen?

Grob vereinfacht wird die Spieleleistung eines Computers hauptsächlich durch den Prozessor und die Grafikkarte bestimmt. Limitiert der Prozessor die Spieleleistung (also die Bilder pro Sekunde), dann wird eine schnellere Grafikkarte (aus der gleichen Serie wie die verbaute) nicht für mehr Leistung sorgen. Andersherum bringt ein schnellerer Prozessor nicht mehr Bilder pro Sekunde, wenn der bereits verbaute die Grafikkarte schon voll auslasten kann. Allgemein ist ein Grafikkarten-Limit „angenehmer“ als ein Prozessor-Limit, denn letzteres geht oft mit einer unstetigen Bildabfolge einher – den so genannten Mikrorucklern.

In Frametime-Diagrammen wie dem Folgenden (entnommen aus dem ComputerBase-Test zu Shadow of the Tomb Raider) kann man Mikroruckler als größere Ausreißer erkennen.

Ein Wechsel der Grafikkarte kann auch abseits deren Leistungsfähigkeit verändern, ab wann der Prozessor die Leistung limitiert. Ein möglicher Grund dafür sind Grafiktreiber. Unterschiedliche Architekturen des gleichen Herstellers können sich unterschiedlich verhalten, aber im Besonderen zwischen Nvidia und AMD-Grafikkarten macht der Treiber potentiell große Unterschiede bei der CPU-Auslastung und CPU-Belastung. Zum Beispiel haben es AMD-Grafikkarten oft in OpenGL- oder DX11-Titeln schwer (prominent zu beobachten bei Doom), in Spielen, die stark auf Multicore-Ausnutzung ausgelegt sind, sind AMD-Karten ab und zu im Vorteil.

Die zwei Prozessorfeinde in Spielen

Im Wesentlichen gibt es zwei Prozessorfeinde beim Spielen: Titel, die inhärent hohe Anforderungen an den Prozessor stellen (zum Beispiel Strategiespiele), und eine hohe angestrebte Anzahl Bilder pro Sekunde. In beiden Fällen ist es nicht unüblich, dass der Prozessor bestimmt, wie viele Bilder pro Sekunde berechnet werden können.

Das Problem im zweiten Fall ist, dass man einem üblichen Grafikkartentest selten entnehmen kann, welcher Prozessor erforderlich ist, um eine gewisse Anzahl an Bildern pro Sekunde wahrscheinlich zu erreichen – eine Frage, die mit der stetig wachsenden Popularität von Bildschirmen mit Bildwiederholraten jenseits von 120 Hz immer mehr an Relevanz gewinnt. Die Redaktion wird sich dem Thema „High-FPS-Gaming“ in naher Zukunft annehmen.

Die üblicherweise leistungshungrigsten Grafikeinstellungen, die mit dem Prozessor überhaupt nichts zu tun haben, sind Auflösung und Kantenglättung. Andere Aspekte wie beispielsweise die Sichtweite oder die Anzahl der NPCs belasten den Prozessor zusätzlich. Eine Möglichkeit, die Leistungsfähigkeit von Prozessoren in Spielen zu testen, ist also, die Titel in einer möglichst niedrigen Auflösung und ohne Kantenglättung, aber mit ansonsten maximierten Details zu prüfen. Dabei wird idealerweise verhindert, dass die Grafikkarte die Leistungsfähigkeit des Prozessors verschleiert.

Wie kann herausgefunden werden, wer limitiert?

Bei der Suche nach Flaschenhälsen im System empfiehlt sich Software wie der MSI Afterburner, der eine Einblendung vieler Sensor- und Auslastungsdaten in Echtzeit auf dem Bildschirm erlaubt. Ist die Grafikkartenauslastung meist unter 95 Prozent, liegt eine andere Limitierung – üblicherweise durch den Prozessor – vor.

Eine Möglichkeit um herauszufinden, für wie viele Bilder pro Sekunde der Prozessor Daten bereitstellen kann, ist es, die Grafikdetails zu maximieren und Auflösung sowie Kantenglättung so weit zu reduzieren, bis die Grafikkarte nicht mehr voll ausgelastet werden kann. Der zeitlose Artikel von ComputerBase-Leser HisN ist Anlaufstelle für alle Wissbegierigen.

Welche Rolle spielt der Arbeitsspeicher?

Der Anteil des Arbeitsspeichers an der Spieleleistung eines Computers ist versteckt in der Leistung des Prozessors, denn der Arbeitsspeicher ist ausschließlich mit dem Prozessor über dessen Speichercontroller verbunden und versorgt die CPU mit den Daten für die durchgeführten Berechnungen. Vor allem zwei Metriken sind hierbei wichtig: Wie schnell kommen Daten aus dem Arbeitsspeicher zum Prozessor oder umgekehrt (Latenz)? Und wie viele davon schaffen es auf einmal (Bandbreite)?

Die reine Speicherlatenz und die Speicherbandbreite werden pro Speichermodul durch den Speichertakt und die Speicher-Timings bestimmt. Die bestmögliche Kombination sind hier ein hoher Speichertakt bei gleichzeitig niedrigen Timings für eine hohe Bandbreite und niedrige Latenz.

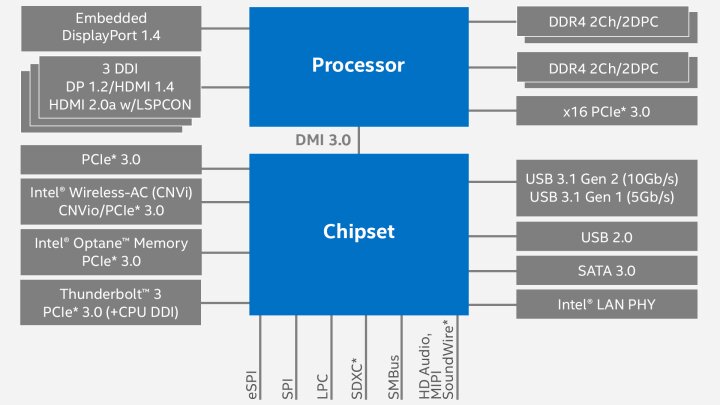

Für die effektive Bandbreite spielt die Anzahl der Speicherkanäle und für die effektive Latenz die Länge der Leiterbahnen und die Prozessorarchitektur eine zusätzliche Rolle. Zum Beispiel: Mit welcher Anzahl an Prozessortaktzyklen kann der Prozessor Daten einmal in den RAM schreiben beziehungsweise aus dem RAM lesen? Oder wie werden die Daten innerhalb des Prozessors weitertransportiert? Das heißt: Auch der Prozessortakt und der Cache-Takt (beziehungsweise Infinity-Fabric-Takt) haben Auswirkungen auf die effektive Speicherlatenz.

Ringbus, Mesh und Infinity Fabric

Was die „Transportgeschwindigkeit“ angeht, unterscheiden sich die drei aktuell verwendeten Cache-Systeme, nämlich der Ringbus für Mainstream-Prozessoren (Core) beziehungsweise Mesh für HEDT-Prozessoren (Core X) bei Intel oder Infinity Fabric bei AMD, deutlich. Die geringsten Latenzen bietet üblicherweise der Ringbus, gefolgt vom Mesh und die höchsten Latenzen bringt das Infinity Fabric mit sich. Auch Größe und Organisation des Caches (pro Kern oder geteilt) sind wichtig, denn mit größeren Caches können mehr Daten im Prozessor vorgehalten und manche Zugriffe auf den Arbeitsspeicher vollständig eingespart werden. Das hilft beispielsweise den Ryzen-3000-Prozessoren im Vergleich zu ihren Vorgängern.

Leistungszugewinne in Spielen durch schnelleren Speicher sind nur dann möglich, wenn der Prozessor die Grafikkarte ausbremst – und zwar dann, wenn selbiger die Grafikkarte besser auslasten könnte, wenn er schneller mit Daten versorgt würde. Allgemein hilft schnellerer Arbeitsspeicher auch in Anwendungen, wenn die CPU mehr leisten könnte, wenn sie schneller mit Daten versorgt würde.

Was heißen die Spezifikationen und was ist RAM-OC?

Die Speichercontroller aktueller Intel-Prozessoren sind folgendermaßen spezifiziert:

| Architektur | Speichertakt |

|---|---|

| Skylake (7. Gen Core) | 2.400 MHz |

| Coffee Lake-S (8./9. Gen Core) | 2.666 MHz |

| Comet Lake-S (10. Gen Core) | 2.666/2933 MHz |

| Skylake-X (7. – 9. Gen Core X) | 2.666 MHz |

| Cascade Lake-X (10. Gen Core X) | 2.933 MHz |

Diese Spezifikationen bedeuten, dass funktionierender Arbeitsspeicher mit diesem Speichertakt in Intel-Systemen garantiert ordnungsgemäß arbeitet. Ganz ähnliche Spezifikationen gibt es auch für die Speichercontroller in AMD-Prozessoren.

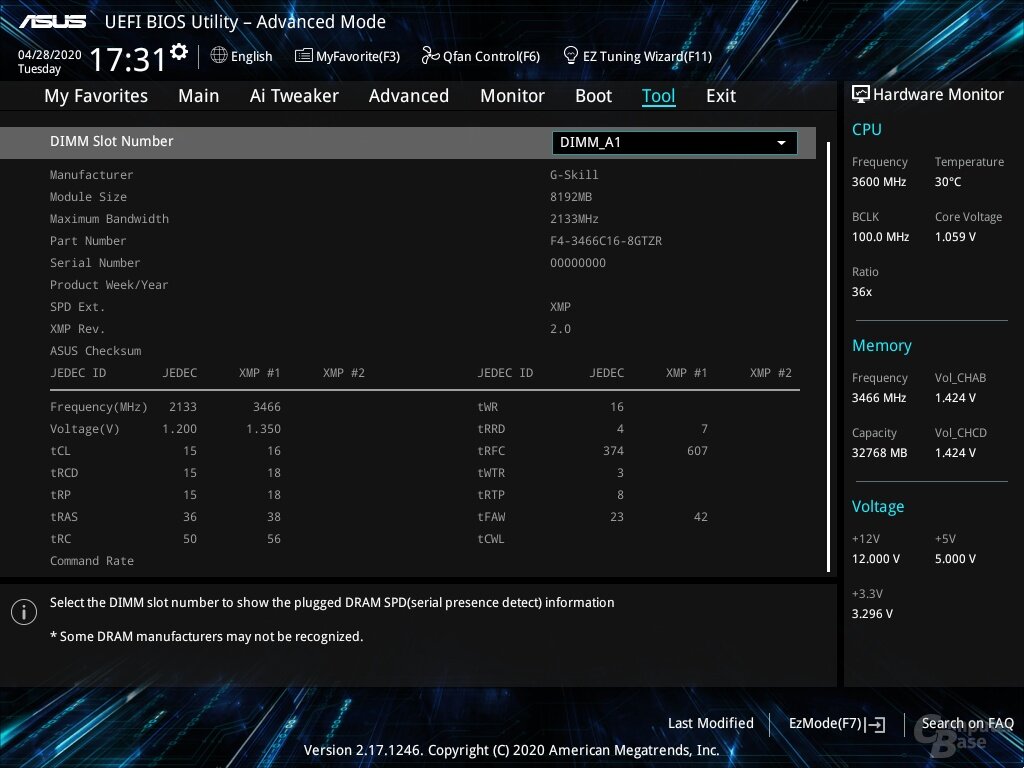

Speicher-Kits werden auch mit Spezifikationen verkauft, die aber etwas detaillierter sind: Der Speicherhersteller garantiert den Betrieb des Speichers bei einem gewissen Speichertakt und gleichzeitig gewissen Speicher-Timings bei bestimmter Speicherspannung. Üblicherweise sind diese Daten in einem XMP-Profil auch auf dem RAM hinterlegt. Das „Problem“ bei XMP-Profilen ist, dass nur sehr wenige Daten tatsächlich vorgegeben sind, üblicherweise sind das die sogenannten Primär-Timings, die wichtigsten Sekundär-Timings, der Speichertakt und die Speicherspannung. Die restlichen Sekundär- und Tertiär-Timings (und vieles mehr) trainiert das Mainboard oder müssen manuell vorgegeben werden.

Grundlegendes zu Timings: Ein Speicherchip ist eine Matrix, also eine Anordnung von Zeilen und Spalten, sogenannter Speicherzellen. Die Speicherzellen tragen Bits. Ein Timing wird als Zahl angegeben, die für eine gewisse Anzahl an Speichertaktzyklen, die eine bestimmte Handlung erfordert, steht. Hier gibt es exakte Anzahlen von Taktzyklen oder Schranken. Zum Beispiel steht das erste Primär-Timing tCL für die genaue Anzahl der Taktzyklen, die nötig sind, um das erste Bit aus einer bereits geöffneten Speicherzeile zu lesen. Das Timing tRCD steht für die minimale Anzahl Taktzyklen, die nötig sind, um eine Speicherzeile zu öffnen und auf die in ihr enthaltenen Speicherspalten zuzugreifen.

Es gibt einen (englischen) Artikel von Gamers Nexus, der die Primär-Timings erklärt. Nachfolgeartikel zu Sekundär- und Tertitär-Timings sind offiziell schon lange geplant; es bleibt abzuwarten, ob sie noch erscheinen.

In der Regel bedeutet XMP schon OC

Der Betrieb des Arbeitsspeichers über dem Minimum der beiden Spezifikationen ist bereits Übertakten, oft ist man in dieser Situation also schon durch das Laden eines XMP-Profils. RAM-OC ist der Betrieb des Arbeitsspeichers außerhalb der Spezifikationen des Speicherherstellers. Wie immer bei Übertaktung gilt: Erfolg kann nicht garantiert werden und erreichte Werte hängen stark von den verwendeten Komponenten („Silicon lottery“, zu Deutsch „Siliziumlotterie“) ab. Im Grenzbereich sind sowohl der Speichercontroller des Prozessors, der Speicher selbst als auch das Mainboard mögliche Limitierungen.

RAM-OC kann die Datenintegrität beeinträchtigen

Mehr noch als für Übertaktung des Prozessors oder der Grafikkarte, wo eine instabile Konfiguration üblicherweise sofort in Anwendungs- oder Systemabstürzen mündet, ist bei RAM-OC Vorsicht geboten. Eine instabile Konfiguration kann auch ohne Anwendungs- oder Systemabsturz zu korrupten Dateien führen und so eine Betriebssysteminstallation unbrauchbar machen und zu schleichendem Datenverlust führen.

Um das so gut wie möglich auszuschließen, sind zeitaufwendige Stabilitätstests wie HCI Memtest, Karhu oder GSAT nötig. Für Speicherübertaktung sind ab einem gewissen Punkt auch die Speichertemperaturen wichtig, sodass ein Top-Blow-Kühler auf dem Prozessor, ein dedizierter Lüfter über dem RAM oder gar ein RAM-Kühler helfen kann.

Im Podcast erinnern sich Frank, Steffen und Jan daran, wie im Jahr 1999 alles begann.