KAOZNAKE schrieb:

Du machst es dir zu einfach und gehst davon aus, dass man einfach immer nur Kerne ranhängen muss, um schneller zu werden. Der Rest der Architektur muss aber auch passen. Wieder ein beliebter Auto-Vergleich: Nem Smart kannst du auch keine 200 PS verpassen ohne Probleme mit dem Fahrwerk zu bekommen.

ja klar, das versteht sich ja von selbst. Dennoch geht immerhin 3x ein Quadcore Athlon II inklusive aller Infrastrukturen Cache / Interfaces / SI etc. in einen BD rein, sofern der kleine Wert von 1,2 Mrd T auch stimmt.

Hätte ich den reinen Wert der zwei zusätzlichen Kerne genommen (beim Athon II) wäre ich mit den 50mm² und 50Mio Transistoren ja bei einem 20 Kerner rausgekommen ^^

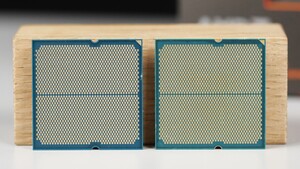

Gut, man muss sich ja nur die DIE des Bulldozer FX ansehen und sieht direkt, dass nahezu der L3 die Hälfte davon ausmacht. Was dieser L3 wirklich an Leistung bringt kann man nicht sagen, es gibt ja keinen FX ohne L3.

Also 4 Kerne mehr und dann noch 800MHz auf allen Kernen finde ich beeindruckend, wobei das durch die geringere IPC wieder etwas relativiert wird. Wobei man das bei Servern so pauschal wieder nicht sagen kann, da hängt es einfach zu sehr von der Workload ab.

Klar, die technischen Daten sind beeindrucken und für die Masse an "Kernen" ist der Verbrauch mit 140W (TDP) auch vertretbar. Die Mehrleistung hätten aber selbst die Vorgänger geschafft, wenn man davon ausgeht, dass 32nm auch hier nochmal beim Takt etwas gebracht hätte. Denn 3,3 Ghz schaffen auch die K10 Kerne oder die Stars im Llano.

Im Grunde siehst im Server Umfeld genau wie im Desktop aus, nur wird da meist auf Maximalleistung gebencht bzw diese auch angerufen, und hier hatte ich BD eigentlich 50% vorne erwartet. Imho 2 Kerne mehr + 30% mehr Takt und eine höher IPC hätte man auch fast erwarten können.

Wie gesagt, das ist ja auch alles Theorie... Bei Intel sieht das immer sehr "einfach" aus - die DIE ist sehr geordnet , 2 Kerne dazu, fertig, GPU DIE vergrößern, fertig.

Gut, Intel hat wohl auch die Mittel 5 Masken parallel zu fahren.

Ich bin mal gespannt ob eventuell ein L3 gestutzter FX auf Piledriver Basis zeitnah kommt.