VelleX schrieb:

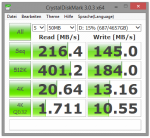

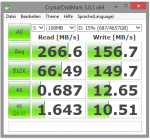

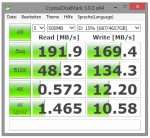

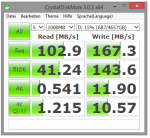

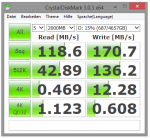

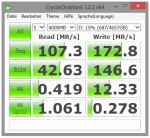

Von der 8TB Archive gibts ja auch CrystalDiskMark Werte, die jedoch bischen komisch sind

http://akiba-pc.watch.impress.co.jp/docs/sp/20141220_680650.html

Danke für den Hinweis, die sehen ja wirklich sehr komisch aus, vor allem der ganz rechte mit 100MB. Das sieht ja fast aus als wenn es da auf dem Testrechner einen Cache geben würde, zumal solche Werte gar nicht über SATA übertragbar sind. Das würde auch die hohen 4k Schreibraten auf dem linken Bild erklären, sonst müsste Seagate ja eine ähnliche Technik wie

HGST bhei der neuen Ultrastar C10K1800 verwenden, die die Daten erst auf Spuren in der Nähe der Kopfposition schreibt und dann im Idle auf die endgültige Position überträgt.

lordZ schrieb:

Das ist insofern schwer aus den Köpfen zu bekommen, da selbst in der Fachliteratur Raid immer in Zusammenhang mit Sicherheit genannt wird.

Sicherheit ist ja nichts absolutes, ein wenig Sicherheit, eben bei dem Ausfall einer Platte und wenn man

kein Problem wegen der UBER bekommt, gibt es ja. Das ist aber nur eine sehr geringe Sicherheit und alle Profis machen deshalb auch zusätzlich Backups.

lordZ schrieb:

ein Beispiel ist der Wikipedia Artikel über Raid. Das Wort "Sicherheit" kommt darin unzählige Male vor.

Wikipedia ist doch keine Fachliteratur! Also wirklich, lies Dir mal meine Signatur durch!

lordZ schrieb:

denn es ist sehr wohl problematisch, wenn man Geld für Verfügbarkeit ausgibt und man dann allerdings keine Verfügbarkeit hat, weil im unrealistischen, aber durchaus vorkommenden Szenario alle Platten ausgefallen sind.

Wie die Sicherheit auch gibt es eben auch bei der Verfügbarkeit eine absoluten Werte, sondern Massnahmen um diese für verschiedene Szenarien zu gewährleiste und mit dem gewünschten Niveau steigen dann die Kosten. Das muss man eben immer im Einzelfall abwägen, das maximal mögliche Niveau wird man sich privat nie leisten können und wollen, also muss man sehen wogegen man sich absichern sollte und welche Restrisiken man eingeht.

lordZ schrieb:

Wenn es für jemanden unproblematisch ist, Backups einzuspielen, weil er genug Zeit dafür hat, oder warum auch immer, warum sollte er dann Geld für ein Raid ausgeben?

Es gibt einiges Gründe für ein RAID, aber letzlich ist das eben eine Entscheidung die jeder selbst treffen sollte und muss, man sollte sich nur keine Illusionen machen was man dann nun konkret bei welcher Entscheidung für eine Sicherheit und/oder Verfügbarkeit erreicht.

lordZ schrieb:

Dann sehe ich für uns alle schwarz, denn die Autoren dieser Literatur bilden unsere zukünftigen Ingenieure aus und verleihen ihnen die Diplome.

Deswegen gibt es dann nach dem Studuim oft genug den Praxisschock.

lordZ schrieb:

Und den Wikipedia-Artikel über RAID kann mal also offensichtlich auch in die Tonne werfen.

Das ist bei Wikipedia nicht selten, die Illusion von der Schwarmintelligenz ist bei vielen noch in den Köpfen, aber dazu kann ich mich nur Dieter Nuhr anschliessen: "Geist addiert sich nicht, Dummheit leider schon."

lordZ schrieb:

Jeder Firma und jeder Privatperson steht es schließlich frei zu entscheiden, wie wertvoll die Daten sind und wie sie folglich zu schützen sind.

So ist es, das Problem sind nur die Fehleinschätzungen, wenn also z.B. ein RAID baut meint damit eine absolute Sicherheit für seine Daten zu haben, dann wird es eben kritisch und wenn hinterher die Daten weg sind, ist die Enttäuschung groß. Eine weitere große Falle sind die ganzen NAS, da glauben auch viele die Daten wären total sicher und verzichten auf Backups. Noch sind die meisten Systeme und Platten drin ja recht neu, aber wenn dann die Platten nach ein paar Jahren kaputt gehen, werden sich noch viele wundern.