Shaav

Fleet Admiral

- Registriert

- Okt. 2009

- Beiträge

- 12.093

Moin moin,

ich finde das Thema Photogrammetrie total interessant aber auch unheimlich schwer gute Ergebnisse zu erzielen. Ich interessiere mich sehr dafür wie eure Erfahrungen diesbezüglich sind. Insbesondere wäre ich dankbar für Tipps die euch sehr weitergeholfen haben euer Ergebnis zu verbessern. Ich scheitere derzeit an der Aufnahme eines Blumentopfes (samt Pflanze) was echt nicht sein muss. Für die korrekte Abbildung eines ganzen Raumes fehlt mir glaube ich die Rechenleistung.

Was habt ihr so photografiert? Woran seid ihr gescheitert? Welcher Tipp hat euch sehr weitergeholfen?

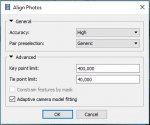

Nutzt ihr auch PhotoScan? Wieviel Bilder habt ihr benötigt, aus wievielen Punkten bestehen eure Punktwolken?

Folgende Tipps haben mir sehr weitergeholfen:

- RAW

- Blende F11 oder höher

- kein direktes Sonnenlicht

- keine spiegelnden oder eintönigen Flächen

Meine Hardware:

Core i5

8GB RAM

GTX 970

ich finde das Thema Photogrammetrie total interessant aber auch unheimlich schwer gute Ergebnisse zu erzielen. Ich interessiere mich sehr dafür wie eure Erfahrungen diesbezüglich sind. Insbesondere wäre ich dankbar für Tipps die euch sehr weitergeholfen haben euer Ergebnis zu verbessern. Ich scheitere derzeit an der Aufnahme eines Blumentopfes (samt Pflanze) was echt nicht sein muss. Für die korrekte Abbildung eines ganzen Raumes fehlt mir glaube ich die Rechenleistung.

Was habt ihr so photografiert? Woran seid ihr gescheitert? Welcher Tipp hat euch sehr weitergeholfen?

Nutzt ihr auch PhotoScan? Wieviel Bilder habt ihr benötigt, aus wievielen Punkten bestehen eure Punktwolken?

Folgende Tipps haben mir sehr weitergeholfen:

- RAW

- Blende F11 oder höher

- kein direktes Sonnenlicht

- keine spiegelnden oder eintönigen Flächen

Meine Hardware:

Core i5

8GB RAM

GTX 970

Zuletzt bearbeitet: