Koto schrieb:

Ja was erwartet Du von den einem Angestellten von Seagate ("Alvin Cox, Chef der JEDEC und offiziell beim Speicherspezialisten Seagate angestellt"), also einem HDD Hersteller der es bisher nicht geschafft hat wirklich einen Fuß in die Tür bei NAND und SSDs zu bekommen? Außerdem wird wenn ich mich recht erinnere, der Link ist gerade nicht verfügbar, auch das Worst Case Scenario betrachtet, nämlich eine SSD die bei extrem geringen Temperaturen betrieben und dann bei extrem hohen Temperaturen gelagert wird. Bei geringen Temperaturen ist die Isolierschicht weniger durchlässig und leidet beim Schrieben und Löschen, wenn die Elektronen dort durchgeschossen werden, auch mehr, verschleißt also dabei auch stärker. Dafür werden die Elektronen dann auch länger gehalten, also bleibt die Ladung auch ohne Spannungsversorgung und damit ohne Refreshs länger erhalten.

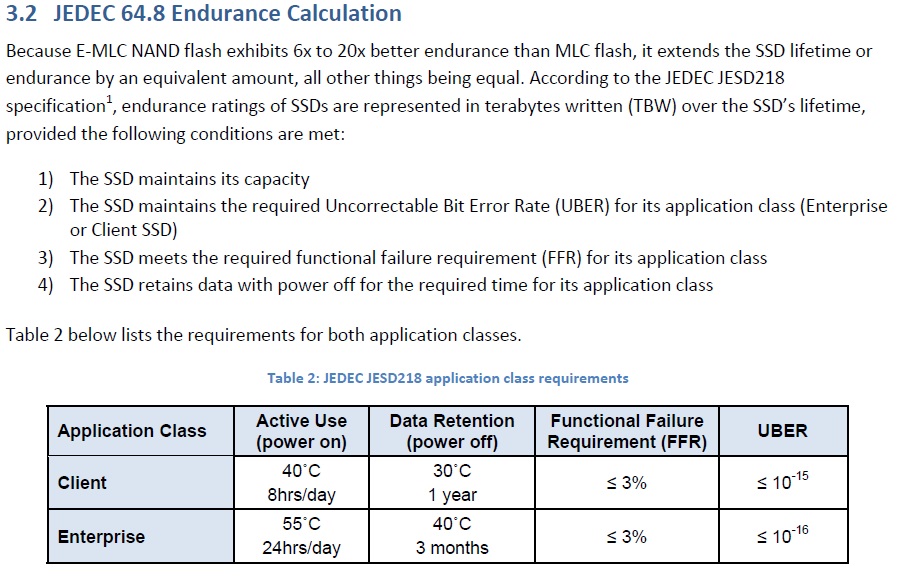

Die JEDEC geht in der JESD218 auch von 40° Betriebs- und 30°C Lagertemperatur für Client SSDs (bei Enterprise SSD jeweils 10°C mehr) aus, weil eben die SSDs im Betrieb normalerweise wärmer sind als die Umgebung in der der Rechner steht und so wie dann wahrscheinlich auch "gelagert" werden, z.B. indem sie in einem ausgeschalteten Rechner stecken.

Diese Horrorrechnung bei der die Daten dann nur eine Woche erhalten bleiben geht aber von den umgekehrten Bedingungen aus und unterstellt geringe Betriebs- aber viel höhere Lagertemperaturen. Sowas wäre vielleicht bei einem Rechner der in einem Kühlhaus in den Tropen steht und dann mal eine Weile dort rausgenommen und in einem stickigen Lager aufbewahrt wird möglich, ist aber für Heimanwender sich nicht im Geringsten relevant. Außerdem bezieht es sich wie die Anforderungen der JESD218 auf den Zustand in dem die TBW erreicht ist, wobei die TBW bei Enterprise SSDs nicht wie heutzutage bei Consumer SSDs künstlich gering angegeben wird und daher gut mit den spezifizierten P/E Zyklen korreliert und somit für Consumer SSD wohl eher statt mit dem Erreichen der TBW mit dem der spezifizierten P/E Zyklen gleichzusetzen ist. Aber selbst die oft gering angegebenen TBW werden ja von nur ganz wenigen Heimanwendern überhaupt je erreicht, meist wird die SSD vorher gegen eine größere ersetzt.

Koto schrieb:

Ok der Artikel weiß darauf hin das es mumpitz ist im Privatkunden Bereich.

Das ist nicht nur bei Privatkunden Mumpitz, sondern auch bei Enterpriseanwendern wohl kaum realistisch. Zwar sind die Rechenzenten klimatisiert, aber innerhalb der Rechner wird es schon wärmer als im Rechenzentrum und damit würde eine SSD dann auch wärmer betrieben als gelagert und wenn sie dann in den Büros liegt, dürfte das noch der Fall sein. Es geht bei der ganzen Vorgabe ja auch vor allem darum die Daten einer SSD deren Lebenserwartung sich dem Ende neigt, auf die Ersatz-SSD übertragen zu können und dafür wird auch in einer Enterpriseumgebung wohl kaum jemand 3 Monate brauchen, zumal auch SSDs in einem Storage gewöhnlich in einem echten RAID (also einem mit Redundanz) laufen.

Koto schrieb:

Eben, genau das sage ich doch und da steht es auch:

Klar, die altern SSDs werden eingelagert und man ist auf die Daten auf denen auch noch angewiesen :Freak

Man die alten SSDs gehen zum Schreddern, aber wahrscheinlich war der LKW mit denen auf dem Weg zur NAS um es denen zu ersparen die Daten übers Internet ziehen zu müssen

chithanh schrieb:

Eben und bei Samsung steht z.B. im

White Paper der 950 Pro:

Percentage Used: Contains a vendor-specific estimate of the percentage of the device life used based on the

actual device usage and the manufacturer’s prediction of the device life. A value of 100 indicates that the estimated

endurance of the device has been consumed, but may not indicate a device failure. This value is allowed to exceed

100. Percentage values greater than 254 shall be represented as 255. This value shall be updated once per poweron

hour (when the controller is not in a sleep state).

Refer to the JEDEC JESD218 standard for SSD device life and endurance measurement techniques.

Die machen also auch klar, dass sie sich an die JESD218 halten.

chithanh schrieb:

Passiert in der Tat. In dem Fall (USB-Stick >=1 Jahr stromlos) wird bei Leseproblem oft geraten

Da wird nicht geraten und wie kommst Du da überhaupt drauf? Wenn es dann länger dauert die Daten zu lesen, so dürfte der Stick immerhin eine LDPC Fehlerkorrektur haben und die funktioniert so, dass die NAND Zellen mehrfach mit verschiedenen Schwellwerten ausgelesen werden und aufgrund der Ergebnisse die Fehlerkorrektur die realen Werte ermittelt. Das dauert länger, ist aber kein Rate sondern Mathematik, auch wenn Leute die mit dem kleinen 1x1 Probleme haben dies nie glauben werden, sondern lieber "Mathe ist ein Arschloch und Physik seine kleine Schwester" schreien.

Vor Kurzem haben ich meinen allerersten USB Stick wiedergefunden, was war noch einer mit 256MB und das älteste Archive darauf war von 2003 und das jüngste von 2008 und alle waren mit 7z geprüft noch fehlerfrei. Dabei ist hier wo ich lebe die Jahresdurchschnittstemperatur mehr doppelt so hoch wie in Deutschland, sogar noch über 25°C und die Klimaanlage habe ich auch bei weitem nicht dauernd an.

chithanh schrieb:

Sie hält prinzipiell noch viel länger ihre Daten, nur der Hersteller garantiert dann nicht mehr die Einhaltung der Fehlerrate.

Mit der Fehlerrate bei NAND verhält es sich eben so:

Die Werte der X- und Y-Achsen sind beispielhaft und das TBW Rating wird wie gesagt heutzutage bei Consumer SSDs oft künstlich geringer angegeben, auch hält sich bei der Spezifikation der P/E Zyklen nicht jeder Hersteller an die Vorgaben der JESD218, aber wenn sieht es etwa so aus. Wobei die SSDs nach der JESD218 immer wenigstens eine UBER von 1:10^15 einhalten müssen, viele Consumer HDDs aber nur eine UBER von 1:10^14 haben. Bei NAND schlechter Qualität kann die Kurve auch schon gleich zu Beginn nicht bei 0 stehen und dann noch schneller ansteigen, solche NANDs für Speichermedien zu verwenden kommt zwar vor, ist aber unseriöse und in SSDs haben die schon gleich gar nichts verloren. Wobei ich aber nicht sagen kann, wie weit dies noch für die aktuellen planaren NANDs aus 15/16nm Fertigung gilt, denn bei weniger als 20nm sind auch die Zellabstände i.d.R. schon so gering, dass die Nachbarn die Ladung massiv beeinflussen und daher ist dort eben auch eine weitaus aufwendigere Fehlerkorrektur und ein viel regelmäßigere Refreshen der Ladung nötig als bei früheren NANDs auf die sich diese Darstellung noch bezieht. Wie gesagt werden eben auch bei NANDs die technischen Eigenschaften mit den Shrinks zumeist schlechter, weil zumindest bei den planaren NANDs eben dort das Ziel ist die Zellen und Zellanstände zu verkleinern um die Datendichte zu steigern und die Kosten zu verringern. Hart an den Grenzen ist man heute also nicht nur die HDDs, sondern auch bei den planaren NANDs. Geringere Kosten sind aber eben das wichtigste, vor allem bei der Consumer HW.