yaegi

Commodore

- Registriert

- März 2005

- Beiträge

- 4.280

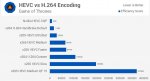

muss es zwingend h265 sein? h264 geht in der tat deutlich schneller.

und falls hardware enconding für dich eine option wäre:

ich habe grade mal angetestet. mit einer 980 Ti dauert das umwandeln eines standardfilms per h265/NVENC ungefähr 20min. allerdings unterstützt das handbrake (noch) nicht.

und falls hardware enconding für dich eine option wäre:

ich habe grade mal angetestet. mit einer 980 Ti dauert das umwandeln eines standardfilms per h265/NVENC ungefähr 20min. allerdings unterstützt das handbrake (noch) nicht.