KlaasKersting schrieb:

Ist dem denn überhaupt so?

SATA und USB 3.0 haben über den Daumen gepeilt (~15%) die selbe Bandbreite.

Mit NVMe war hier eher "per PCIe angebundene" NVMe-SSD gemeint. Die Samsung SM961 ist auchnicht viel teurer als SATA-SSDs aber bei allen Parametern deutlich schneller..

KlaasKersting schrieb:

Es braucht eine Möglichkeit, schnellere Speichermedien auch als Ziel zu nutzen.

Aktuell ginge das so:

1. 2x 10 Gbit Ethernet NIC, entsprechende Hausverkabelung und ein 2. Rechner mit PCIe-SSD oder RAID

2. 2x Thunderbolt-Karte, entsprechende (schweineteure) Verkabelung und ein 2. Rechner mit PCIe-SSD oder RAID

3. eine zweite interne PCIe-SSD oder internes RAID (als Backup natürlich Schwachsinn)

Für Privatanwender alles nicht kosteneffizient bzw. für die meisten auch zu kompliziert.[/QUOTE]

"Schnell" ist heute ein manigfalitges Attribut. Die gängige Software (tar, zip, Paragon) liest viele kleine Files ein und packt das in einen großen Datenstrom (von Kompression mal abgesehen).

Bei eriner Windows-Systempartition mit 4k-Clustern zeigt der Taskmanager 100% Auslastung an, obwohl nur 250MB/s gelesen wird. Hier (wie auch bei Datenbanken) ist die kurze Latenz enorm wichtig und eben daß der Weg zur CPU kurz ist. Die halbe Welt wartet auf CPUs mit ausreichend Lanes, ich denke, darauf zielt auch intel mit der Optane-Technik.

Der große Datenstrom, vor allem übers Netzwerk, hat jede Menge Puffer implementiertund schickt die Datenpakete asynchron auf die Reise. 2x10GBit (=~2000 MByte/s) wären für die produzierbaren 250MB/s garnicht nötig.

Wenn ich aber z.B. ein virtuelles Laufwerk initialisiere, werden mit bei der SM961 tatsächlich Werte zwischen 1,5-2 GByte/s angezeigt. Bei einem 100GB-Laufwerk dauert das dann zwar immer noch eine Minute, aber das ist viel besser als früher.

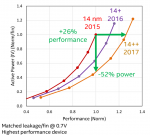

Als Backup-Medium eine SSD einzusetzen kann auch ins Auge gehen. Hier im Test gibt es ja dieses Diagram zur Leistungsbeständigkeit.. Und auch beim Transfertest im Vergleich mit den großen HDDs sind SSDs daran gescheitert nur für 30-100 Sekunden in voller Geschwindigkeit schreiben zu können und anschließend auf 1/10 zurückzufallen.

Für den Anwender ist ein Backup immer noch zu kompliziert. Die aufkommenden Cloud-Backups allerdings eine Katastrophe für den Datenschutz. Hier sehe ich am ehesten noch Potential, daß sich eine Firma mal ein Stück vom Kuchen der Locky-Trojaner abschneiden könnten.