hoxi schrieb:

1. Offensichtlich kann AMD seine CPUs mit 8+ Cores deutlich günstiger produzieren und dadurch INTEL auch immer im Preis signifikant unterbieten. Die Gründe dafür sind in der extrem flexiblen Infinity Fabric und der einfachen Skalierung durch das Multi Chip Module Design zu finden.

Richtig, daher macht AMD dies auch und es gibt auch bei Intel Überlegungen auf so ein Design zu wechseln, da die Entwicklungskosten der Dies explodieren je kleiner die Strukturen werden und diese damit irgendwann nicht mehr durch den Absatz von genug CPUs mit so großen Dies eingespielt werden können. Der Nachteil ist aber, was man schon bei den RYZEN 7 mit 2 CCX auf nur einem Die sieht, dass die Kommunikation zwischen den Kernen unterschiedlicher CCX mehr Latenz hat, bei RYZEN sind kommen da noch mal so 100ns auf die 40ns drauf die entstehen, wenn die Kerne auf dem gleichen Die sind. Auch die Doppelringe der großen Intel CPUs haben so ein ein Verhalten, aber bei weiten nicht so ausgeprägt. Dieser Nachteil macht die neuen AMD CPUs vor allem für Anwendungen interessant wo jeder Kern viel für sich auf einem eigenen Teil der Daten arbeitet, wie es etwa beim Rendering typischerweise der Fall ist und daher scheiden die RYZEN dort auch sehr gut ab.

Ist aber viel Interaktion zwischen den Threads der SW und damit den Kernen der CPU gefragt, wie es bei Simulationen und dazu gehören gerade auch Spiele, der Fall ist, so fällt selbst ein 8 Kern RYZEN zuweilen hinter einen Intel 4 Kerner zurück. Die Leistung der CPUs hängt als sehr von der Anwendung ab und die Herausforderung gerade für Intel wird sein, ein MCM Design zu entwickeln bei den die Kommunikation zwischen den Kernen der unterschiedlichen Dies eben nicht signifikant mehr Latenz aufweist, was bei Threadroller der Fall sein dürfte, denn bestenfalls bleibt es dort auch über die Grenzen eines Dies hinweg bei den 100ns die schon bei RYZEN extra anfallen wenn die Kerne auf unterschiedlichen CCX sind, vermutlich dürfte es aber eher noch mehr sein. Aber selbst wenn nicht, so hat man schon statisch den Nachteil, dass ja bei RYZEN immerhin 50% der Kern auf dem gleichen CCX sind, bei Threadroller aber nur rund 25%.

hoxi schrieb:

2. Sieht man sich die Xeon CPUs von INTEL genauer an, kann man erkennen, dass jene Prozessoren, die sehr viele Kerne haben, im Basistakt (aber auch im Turbo) oftmals nur wesentlich geringer getaktet werden können. Vermutlich wurden auch deshalb noch keine Taktraten von den 12-18 Core Skykale X CPUs bekannt gegeben.

Das ist anzunehmen, man sollte aber auch nicht vergessen welchen Einfluss die Verbesserung der Fertigung hat und da ist bei Intel über die Zeit eine Menge passiert, mit dem 14++ sind gegenüber dem ursprünglichen 14nm Prozess inzwischen auf Transistorebene entweder 50% weniger Leistungsaufnahme bei gleichem Takt oder 26% mehr Takt bei gleicher Verlustleistung bzw. eine Mischung daraus möglich und die Optimierung geht ja noch weiter.

hoxi schrieb:

3. Es erscheint offensichtlich, dass bei den viel größeren Prozessoren von AMD (Threadripper und Epyc) die Wärme bei vergleichbarer TDP mit den INTEL Pendants viel einfacher abgeführt werden kann.

Angeblich sollten die Skylake-X, zumindest die mit dem LCC Die, ja nicht mehr verlötet sein wie es noch bei Broadwell-E der Fall war, wäre die Wärmeabfuhr ein Problem, so muss entweder die verwendete WLP plötzlich der Verlötung in diesem Punkt sogar überlegen sein oder Intel wird dies weiterhin verlöten. Außerdem sagt die TDP wenig über die reale Leistungsaufnahme aus, die Broadwell-E kommen in kaum einem Test mal zwischen Last und Idle ihrer TDP nahme, der RYZEN 7 1800X überschreit dort aber seine 95W teils deutlich.

115W Unterschied hat CB mit Cinebench Multithreaded ermittelt, während der i7 6900k dort nur auf 100W bei 140W TDP kommt. Nur Prime und AVX überschreitet der 6900K diesen Wert dann und nimmt sich 56W mehr als bei Cinebench, während der 1800X dort nur 9W mehr braucht, aber da es keine Ergebnisse zur Leistung mit Prime gibt und

AVX bei RYZEN nicht immer problemlos voll genutzt wird, kann man hier nur raten wieso dem so ist und sollte die Leistungsaufnahme mit der Nutzung von AVX Befehlen besser getrennt betrachten.

Aber Vergleiche mit den alten Boardwell-E sind bzgl. ThreadRipper sowieso recht egal, da der sich mit Skylake-X rumschlagen muss und nicht mehr mit dessen Vorgänger. Angesichts der Preise die Intel für die Skylake-X schon angegeben hat, wird sich jetzt wohl kaum noch jemand einen Broadwell-E kaufen.

hoxi schrieb:

Die kommenden Monate und Jahre werden jedenfalls noch sehr interessant, auch ohne hier Partei für einen der beiden Hersteller ergreifen zu wollen.

Das auf jeden Fall, es ist jetzt wieder so viel Bewegung im Markt wie seit Jahren nicht mehr. Die CPUs und die Plattformen von AMD und Intel haben jeweils Vor- und Nachteile, welches für die jeweilige Nutzung die bessere ist, kann man pauschal nicht sagen und wird es auch nicht einfach aus den Ergebnissen eines Benchmarks ablesen können. Man wird da schon Benchmarks entsprechend gewichten nehmen müssen wie es der eigenen Nutzung an nächsten kommt.

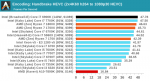

Bei der Singlethreadperformance dürfte Skylake-X klar die Nase vorne habe, erlaubt Intel dort den meisten Modelle einzelne bzw. zwei Kerne bis auf 4,5GHz zu takten. ThreadRipper basiert auf RYZEN Dies, die gehen bisher bestenfalls so bis 4.1GHz und selbst wenn die Fertigung schon Fortschritte gemacht hat und die besten 100MHz mehr schaffen, muss man dann auch noch das Glück haben das zwei so gut laufenden Dies im eigenen Threadripper stecken. Dazu zeigt dann auch der Vergleich der Leistungsaufnahme zwischen dem 1700X und dem 1800X wie massiv diese steigt wenn man jenseits von 3,5GHz noch etwas Takt drauflegt.

Bei Multithread dürfte ThreadRipper dann im Vorteil sein, sofern die Threads nicht so viel interagieren. Da punktet er schon über den Preis der deutlich geringer sein wird. Dazu hat die Plattform den Vorteil mehr PCIe Lanes zu bieten, selbst bei den kleinen CPUs während die bei Intel auf 28 Lanes beschnitten wurden und ECC RAM zu unterstützen, hoffentlich endlich auch offiziell damit es kein Glücksspiel wird ob das Boardhersteller dies auch korrekt implementiert hat, was bei Intel vermutlich wieder nur den Xeon vorbehalten bleibt. Intels Plattform ist dafür ausgereifter und bietet Dinge wie Unterstützung für RAIDs von PCIe SSDs und bei Skylake-X offenbar nun nicht mehr nur wenn diese an den PCIe Lanes des Chipsatzes hängen. Auch da muss also jeder seine Prioritäten setzen.