Schnitz schrieb:

Warum führt man nicht wieder 5,25" Platten ein, dann wären auch schon größere Einzelplatten möglich. Im Enterprise Bereich gibt es ja auch 3,5" SSDs

Was für 3.5" SSDs spielen denn im Enterprisesegment wirklich eine Rolle? Das sind doch allenfalls Exoten. 5.,25" HDDs wird es wegen der Vibrationen ebensowenig geben wie 3.5" HDDs mit größere Bauhöhe, also längeren Achsen. Das ist auch der Grund warum die HDDs mit mehr als 7200rpm schon seit einiger Zeit nur noch als 2.5" Modelle gebaut werden.

Simon schrieb:

Um ehrlich zu sein: In acht Jahren interessiert sich vermutlich niemand mehr für 40 TB große drehende Festplatten.

Das ist extrem unwahrscheinlich, da auch die Kosten für NANDs immer schwerer zu senken sind. HDDs werden noch sehr lang und vermutlich sogar für immer einen Kostenvorteil gegenüber SSDs und damit für bestimmte Anwendungen eine Daseinsberechtigung haben.

Simon schrieb:

Sowohl hinsichtlich Datendichte als auch Betriebskosten sind 2025 die SSDs vermutlich klar an jeglicher Magnettechnik vorbei gezogen.

Bei der Datendichte haben sie schon gewonnen und daher kann es ja nach Anwendung auch sein, dass sie bei der ToC gewinnen, aber eben nicht in jedem Fall und schon gar nicht, wenn die Performance keine große Rolle spielt.

Simon schrieb:

Der Preisverfall bei NAND-Flash ist aktuell durch die hohe Nachfrage gebremst, aber das muss nicht so bleiben.

Der Presverfall wird aber auch nach dem Ende der aktuellen Angebotsknappheit nicht ewig so weitergehen wie vorher. Shrinks sind schon nicht mehr möglich gewesen, da sonst die Zellen zu klein werden und deren Abstände ebenso, was zu Übersprechen führt. Dann ging man, bzw. geht man jetzt in die 3. Dimension und hat dabei die Abstände und Größen der Zellen auch wieder erhöht, außerden erhöht man die Anzahl der Layer. Aber jeder Layer kostet Bearbeitungsschritte und erhöht das Risiko bei einem Fehler den ganzen Wafer unbrauchbar zu machen, weshalb die Zahl der Layer die wirtschaftlich herstellbar ist, auch begrenzt sein wird. Man ging vor einiger Zeit davon aus, dass das Limit bei so 128 Layer liegen dürfte, natürlich dürfte dieser Wert mit der Zeit steigen, aber lass es 256 Layer sein, was dann 4x so viel wäre wie bei den neusten NANDs mit 64 Layern und vergessen wir mal die Kosten der zusätzlich Bearbeitungsschritte, so wäre der Preis dann ein Viertel des heutigen und damit immer noch weit über den Kosten pro GB einer HDD.

Man kann die Größen und Abstände der Zellen dann wieder etwas verringern, dann wird es aber schwer bis unmöglich mehr Bits pro Zelle zu speichern, da das eine das andere ausschließt. Auch bei den Kosten für NANDs wird es also immer langsamer gehen, weil es immer schwerer wird diese zu senken.

Simon schrieb:

2018 wird es vermutlich die ersten Flash Systeme mit 1 PB Kapazität pro Höheneinheit geben.

Was aber an den Kosten pro TB für die SSDs nichts ändert und allenfalls bei der TCO für große Unternehmen einen Vorteil bringt, nicht aber dem Heimanwender.

xexex schrieb:

Weil Platten mit Kapazitäten jenseits von 10TB auch jetzt schon reine Nischenware im Endkundenbereich sein dürften und im Rechenzentrum schon 3,5" Platten immer seltener anzutreffen sind.

Für Heimanwender vielleicht, wobei diejenigen die ein NAS oder Heimserver haben, schon eher zu so großen HDDs greifen. Ob so große HDDs in Rechnezentren zu finden sind, hängt sehr davon ab was die Firma macht die dieses Rechnenzentrum betreibt. Wenn da sehr große Datenmengen gespeichert werden müssen die auch noch ständig wachsen, dann dürften da schon so große HDDs zu finden sein und immer mehr von denen dort ein Zuhause finden.

xexex schrieb:

Ganz abgesehen davon wären die Zugriffszeiten solcher Platten schlecht und die Herstellung solchen riesigen Datenträger mit modernen Speichertechnik kaum oder gar nicht umsetzbar.

Auch wenn manche es nicht glauben, aber es gibt eine Menge Daten auf die gar kein häufiger und damit schneller Zugriff nötig ist, sehr wahrscheinlich dürften derartige Cool und Cold Daten sogar die ganz große Mehrheit aller Daten ausmachen die weltweit gespeichert werden.

xexex schrieb:

Eine Platte gehört auch nicht in einen Schrank. Sie gehört in ein SAN oder NAS mit entsprechenden Fehlerprüfung und bei Bedarf einem Austausch.

Richtig!

Limit schrieb:

Bei der Datendichte sind sie doch schon länger an den HDDs vorbei. Bei den Kosten sehe ich SSDs im günstigsten Fall da, wo HDDs heute schon sind.

Sehe ich auch so, wobei letzteres schon sehr schwer werden dürfte, zumal bis 2025.

Limit schrieb:

Die Samsung 850 Evo mit 4TB wird mit 3.6W angegeben, die Seagate IronWolf 12TB mit 6.8W. Für gleiche Kapazität bräuchte man also drei SSDs (3*3.6W = 10.8W), die dann mehr verbrauchen als die eine Seagate.

Wobei dies alleine aus Sicht des Heimanwenders ist, Enterprise SSDs gibt es auch mit größeren Kapazitäten als die 4TB der größten 850 Evo. Außerdem schreiben die drei Evo zusammen viel schneller als die eine 12TB HDD, sind also schneller wieder Idle und damit sparsamer bzw. schreibt ggf. nur einer der 3 SSDs, während die anderen beiden Idle sind und selbst dann ist die eine SSD noch schneller. Wenn dauernd gelesen- oder geschrieben werden muss, dann wäre die HDD von der Leistung her vermutlich zu lahm und die SSDs schon deswegen im Vorteil. Praktisch dürften die SSDs also auch bei der Leistungsaufnahme im Vorteil sein, selbst wenn man drei 850 Evo 4TB mit einer 12TB HDD vergleicht.

Limit schrieb:

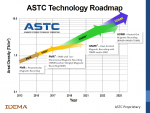

Ansonsten hört sich die Technologie interessant an. Der Zeitplan deckt sich mit dem Zeitplan von Seagate für HAMR.

Wobei Seagate den Zeitplan für HAMR ja schon ewig immer weiter rausschiebt. Es wird also spannend sein zu sehen wer zuerst mit was auf den Markt kommt.

zonediver schrieb:

Einen Motor von 1939 optimiere ich ja auch ned ständig weiter - neue Techniken werden das Getue sicher bald ablösen...

Auch fast die ganzen heutigen Verbrennungsmotoren basieren noch auf der Technik der Motoren von 1939, auch wenn sich seither bei Zündung, Gemischaufbereitung und vor allem der Steuerung und Abgasbehandlung viel getant hat, denn der einzige Versuch etwas radikal anders zu machen war der Wankelmotor und dessen Erfolg blieb doch sehr beschränkt. Die heutigen HDDs haben selbst mit denen von vor 10 bis 15 Jahren auch nicht mehr gemein als die heutigen Automotoren mit solchen von 1939, da hat sich ähnlich viel getan, nur sieht man davon noch weniger als bei den Motoren. Aber wie bei den Motoren hat sich selbst die Schmierung geändert.

andr_gin schrieb:

Bei SSDs wurde dieses sogar schon erreicht und man musste durch die 3D Fertigung wieder einen Schritt zurück machen ohne die Zuverlässigkeit extrem zu gefährden (Stichwort NAND cell decay bei TLC Speicher).

Diesen Schritt zurück habe man bzgl. der Größe und Abstände der Zellen getan.

andr_gin schrieb:

nach der Flut in Thailand 2011 bzw. dass durch diese 2 Hersteller die Chance genutzt haben aus dem Dumpingpreismarkt auszusteigen.

Kurz vor der Flut war der Verdrängungswettbewerb massiv, der dann ja auch mit den Übernehmen der Festplattensparten von Hitachi und Samsung geendet hat.

andr_gin schrieb:

Man darf nur nicjt den Fehler machen teure Serverplatten mit dem billigsten TLC Consumerplatten zu vergleichen, die man irgendwo auf Geizhals finden kann.

Eben, aber viele vergleichen ja auch bei HDDs die Preise teurer Enterprise Nearline HDDs mit denen der billigsten Desktopplatten, einfach weil ihnen die Unterschiede dazwischen überhaupt nicht klar sind.

andr_gin schrieb:

Bei 5.25" hat man eine um ca. 50% höhere Zugriffzeit auf Grund der niedrigeren Drehzahl während 2 3.5" Festplatten die doppelten IOPS bzw. Bandbreite bringen, da sie ja im RAID arbeiten.

Vorteil des Ganzen: So ziemlich keiner

Nur die Vibrationen die bei dem größeren Radius der Platter dann am Ende auch größere Amplituden erreichen würden und diese sind umso weniger zu handeln je geringer die Abstände wegen der höheren Datendichten werden.

luckysh0t schrieb:

Nach mehrmaligem lesen, komme ich zum Schluss : Das Magnetfeld ist schwächer, weil die Köpfe selbst kleiner werden, also kommen zB Hinter (oder sonst wo) den Köpfen diese Magnetfeldgeneratoren zum Einsatz um das auszugleichen...

Ich bitte um korrektur/bestätigung

Bestätigt, die kleinen Köpfe erzeugen keine so hohen Feldstärken und daher ja auch der Ansatz bei HAMR die Magentschicht zu erwärmen, da dann die Ummagnetisierung leichter ist, außerdem muss der Schreibkopf dann gar nicht so klein sein, er kann auch größer ausfallen als der Bereich der ummagntisiert werden soll, da dessen Karft dafür ja nur im erwärmten Bereich ausreicht.

Sebbi schrieb:

Solange SSDs die Daten nicht wenigstens 3 Jahre zuverlässig speichern kann im stromlosen Zustand, werden die Magnetspeicher weiterhin gefragt sein!

Erstens gibt es auch NANDs die für 10 Jahre und mehr DRT spezifiziert sind und zweitens sollte man auch HDDs nicht 3 Jahre im Schrank liegen lassen, da die Hersteller üblicherweise maximal 1 Jahr Lagerbarkeit angeben. Das kann also auch böse daneben gehen, wenn man die HDDs nach 3 Jahren im Schrank wieder in Betrieb nimmt.

https://www.youtube.com/watch?v=xb_PyKuI7II

https://www.youtube.com/watch?v=xb_PyKuI7II