Baal Netbeck

Fleet Admiral

- Registriert

- Apr. 2008

- Beiträge

- 11.936

Dies ist ein ausgelagertes Thema aus diesem Hauptthread:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Intro:

Elex ist ein neues RPG, das an die Erfolge von Gothic anknüpfen möchte.

Ich bin noch nicht dazu gekommen es wirklich zu spielen, der Einstieg ist aber sehr klassisch und gefällt mir.

Grafisch ist das Spiel kein AAA Titel, mir gefällt es trotzdem .

.

Es wird die DX11 API verwendet und trotzdem sind wir fast immer GPU limitiert.

Für einen CPU Benchmark ist das Spiel also nur bedingt geeignet.

Ich teste es hier trotzdem, auch um ein schönes Beispiel zu haben, wie langweilig CPU Tests im GPU limit sind.

Die Testkandidaten sind wieder mein Ryzen 1800X in verschiedenen Konfigurationen gegen einen i5 3570K.

Beide mit meiner Vega64 LC(undervolted) gepaart.

In diesem Review zeige ich diverse Aspekte wie:

Einflüsse von 4 vs 8 Kernen, SMT an/aus, Skalierung mit Ramgeschwindigkeit, verschiedene CCX Konfigurationen für Ryzen. IPC Vergleiche, Einfluss des HBCC, Einfluss von CPU und RAM Optimierungen und eine Betrachtung der Infinity Fabric Skalierung.

Fangen wir mit der Testszene an.

https://www.youtube.com/watch?v=UkpnKiNwG4I&index=7&list=PLP9fskJGwUOT5CByAJMJrXaggyMuUgsFt

Meine Messung beginnt und ich beginne direkt loszulaufen.

Ich halte Shift um so viel wie möglich zu rennen.

Bei dem Sprung benutze ich das Jetpack mit zwei Schüben und die Messung endet wenn ich am Ende wieder in den Büschen stehen bleibe.

Wer die Szene selbst testen möchte findet im Video die Grafikeinstellungen.

Und hier das benutzte savegame:

https://drive.google.com/drive/folders/1Hahuj2q234W1LTFi5WLAZOo_uR4tF-qu?usp=sharing

Frametimegraphen:

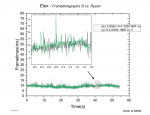

Zuerst der Vergleich meines Ryzen 7@3,8GHz und des Ivy Bridge i5 mit 4,4GHz

Wie man sieht, hat das Spiel eine relativ gleichbleibende Belastung.

Beide CPUs liefern fast gleiche Ergebnisse, schaut man genau hin, erkennt man etwas stärkere Schwankungen beim ivy i5.

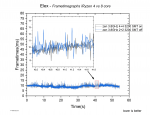

Das gleiche Bild zeigt sich mit 4 Kernen und 4 Threads eines Ryzen wie hier zu sehen:

Die 4 Kerne laufen minimal schlechter, im Grunde aber gleich.

Um diesem Auf und Ab eine quantitative Entsprechung zu geben benutze ich eine Reihe statistischer Werte die ich aus der Auswertung von jeweils fünf Messungen gewinne.

Die gezeigten Frametimeverläufe waren jeweils die zweit besten was die 0.1% low Werte angeht.

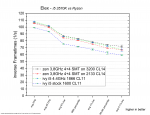

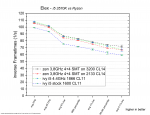

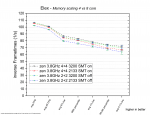

i5 vs. Ryzen

Zur Erklärung des Diagramms:

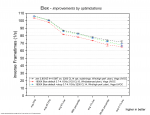

Wie schon in den Frametimegraphen zu sehen, liegen Ryzen und der ivy i5@4,4GHz praktisch gleich.

Selbst das senken des DDR4 Takt auf 2133 verschlechtert das Ergebnis praktisch nicht.

Erst das absenken der i5 Taktraten auf den Basis Takt hat einen Einfluss auf die Performance.

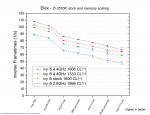

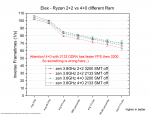

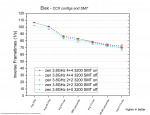

Ryzen CCX Konfiguration und SMT

Alles sieht gleich aus, bis auf 4+0 3200MHz....und hier sehen wir später, das es sich vermutlich um eine unlogische und falsche Messung handelt.

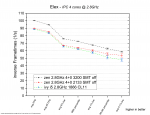

Leistungsaufspaltung beim i5

Während mit 4,4GHz und 1866er DDR3 noch für das volle GPU limit reicht, reicht schon weniger Ram speed um dies zu ändern und zumindest in diese Szene FPS Unterschiede zu zeigen.

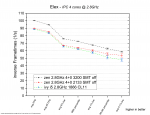

IPC Vergleich

Drei mal vier Kerne, ohne HT/SMT, bei 2,8GHz im Vergleich.

Ryzen ist zweimal vertreten und zwar einmal mit schnellem und einmal mit langsamem Ram.

Bei diesem Vergleich sehen wir auch zum ersten Mal Unterschiede bei Ryzen.

Generell kann Ryzen sich hier etwas durch die IPC absetzen....ein großer Teil ist jedoch der Ram.

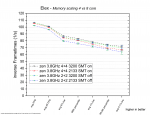

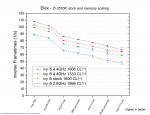

Unterschiedliche Ram Skalierung bei anderen Kern und Thread Anzahlen?

Wenn wir hier etwas genauer hingucken, sehen wir auch mit 8 Kernen etwas Einfluss durch den Ram.

Mit 4 Kernen ist der Unterschied jedoch größer, 2133er DDR4 ist aber trotzdem kein Problem.

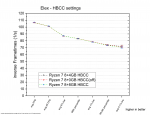

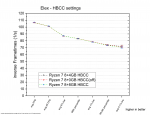

HBCC settings

Abolut keine Unterschiede zu finden.

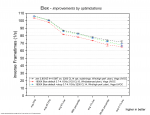

Ryzen optimieren und übertakten

Mit dem 1800X habe ich bereits das stärkste Modell der Ryzen 1000er Serie.

Aber wie viel Leistung verschenkt man wenn man weder den Ram im Bios einstellt noch den Energiesparplan ändert?

Und wie viel Leistung kann man mit einem minimalen OC auf 3,8GHz und optimieren von Subtimings noch herausholen?

Der Unterschied von Stock Taktraten und dopc Profil zu meinen Optimierungen ist praktisch nicht vorhanden.

Die Bios defaults fallen etwas ab, vermutlich ist ein Teil davon der Wechsel von ausbalanciert zu Höchstleistung.

Der ausbalancierte Energiesparplan sollte inzwischen auch für Ryzen funktionieren und nicht mehr die Kerne schlafen legen aber auf Höchstleistung wird nicht heruntergetaktet.

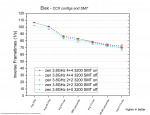

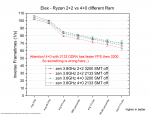

Einfuss von Ramtakt auf den Infinity Fabric

Hintergrund:

Eigentlich sollte hier ein Diagramm zum IF stehen, das ich allerdings nicht veröffentlichen möchte.

Stattdessen zeige ich nur die zugrundeliegenden Messungen:

Wie wir sehen können scheint die Messung mit 4+0 und 3200er DDR4 nicht gelungen zu sein. Eventuell hat die Grafikkarte nicht getaktet wie sie soll, oder etwas lief im Hintergrund.

Eigentlich hätte ich erwartet das sie die beste Leistung liefern sollte aber das scheint schief gegangen zu sein.

Da ich inzwischen neue Grafikkartentreiber und einige neue Windows updates drauf habe kann ich die Messungen auch nicht vergleichbar zu den anderen wiederholen.

Fazit:

Da ist er also....der erste meiner Test mit so gut wie keinem Wissensgewinn.

Solange man nicht vier Kerne mit wenig GHz und langsamem Ram hat, zeigen sich keine nennenswerten Unterschiede.

Die meisten Messungen zeigen nur unbedeutende Variationen eines GPU limits.

In diesem GPU limit liefern die 4,4GHz des i5 etwas mehr avg FPS als der Ryzen und bei den X% low Werten kann dann der Ryzen eine minimale Führung halten.

Wenn man das Video anguckt, sieht man das die CPU Belastung zwischen 20-30% liegt, was grob vier voll ausgelasteten CPU Kernen entspricht.

Spürbare Unterschiede gab es aber nur mit gesenkten Taktraten.

Die Auswertung des IF war leider nicht möglich.

HBCC war egal und optimieren ist dank GPU limit auch nicht wichtig.

Danke, wer sich dies bis hier her angetan hat ..... bald sollten interessantere Tests kommen.

..... bald sollten interessantere Tests kommen.

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Intro:

Elex ist ein neues RPG, das an die Erfolge von Gothic anknüpfen möchte.

Ich bin noch nicht dazu gekommen es wirklich zu spielen, der Einstieg ist aber sehr klassisch und gefällt mir.

Grafisch ist das Spiel kein AAA Titel, mir gefällt es trotzdem

Es wird die DX11 API verwendet und trotzdem sind wir fast immer GPU limitiert.

Für einen CPU Benchmark ist das Spiel also nur bedingt geeignet.

Ich teste es hier trotzdem, auch um ein schönes Beispiel zu haben, wie langweilig CPU Tests im GPU limit sind.

Die Testkandidaten sind wieder mein Ryzen 1800X in verschiedenen Konfigurationen gegen einen i5 3570K.

Beide mit meiner Vega64 LC(undervolted) gepaart.

In diesem Review zeige ich diverse Aspekte wie:

Einflüsse von 4 vs 8 Kernen, SMT an/aus, Skalierung mit Ramgeschwindigkeit, verschiedene CCX Konfigurationen für Ryzen. IPC Vergleiche, Einfluss des HBCC, Einfluss von CPU und RAM Optimierungen und eine Betrachtung der Infinity Fabric Skalierung.

Fangen wir mit der Testszene an.

https://www.youtube.com/watch?v=UkpnKiNwG4I&index=7&list=PLP9fskJGwUOT5CByAJMJrXaggyMuUgsFt

Meine Messung beginnt und ich beginne direkt loszulaufen.

Ich halte Shift um so viel wie möglich zu rennen.

Bei dem Sprung benutze ich das Jetpack mit zwei Schüben und die Messung endet wenn ich am Ende wieder in den Büschen stehen bleibe.

Wer die Szene selbst testen möchte findet im Video die Grafikeinstellungen.

Und hier das benutzte savegame:

https://drive.google.com/drive/folders/1Hahuj2q234W1LTFi5WLAZOo_uR4tF-qu?usp=sharing

Frametimegraphen:

Zuerst der Vergleich meines Ryzen 7@3,8GHz und des Ivy Bridge i5 mit 4,4GHz

Wie man sieht, hat das Spiel eine relativ gleichbleibende Belastung.

Beide CPUs liefern fast gleiche Ergebnisse, schaut man genau hin, erkennt man etwas stärkere Schwankungen beim ivy i5.

Das gleiche Bild zeigt sich mit 4 Kernen und 4 Threads eines Ryzen wie hier zu sehen:

Die 4 Kerne laufen minimal schlechter, im Grunde aber gleich.

Um diesem Auf und Ab eine quantitative Entsprechung zu geben benutze ich eine Reihe statistischer Werte die ich aus der Auswertung von jeweils fünf Messungen gewinne.

Die gezeigten Frametimeverläufe waren jeweils die zweit besten was die 0.1% low Werte angeht.

i5 vs. Ryzen

Zur Erklärung des Diagramms:

Aufgetragen auf der y- Achse sind die "inversen Frametimes". Das sind im Grunde die FPS aber halt nicht durch "Zählen von Frames über einen Zeitraum" bestimmt, sondern über den Kehrwert der Frametimes gebildet.

Wenn ihr hier bei einem Wert links(avg FPS) 44 in 1/s seht, dann würde euch Fraps auch 44 FPS anzeigen.

Aus dem Frametimeverlauf bestimme ich einen effektiven Frametimeverlauf. Diesen habe ich ausführlich im Hauptthread unter "Nomenklatur" diskutiert.

"avg eff FPS" ist der Kehrwert des Durchschnitts dieses effektiven Frametimeverlaufs.

Um so stärker dieser Wert gegenüber den avg FPS abfällt um so stärker sind die relativen Schwankungen der Frametimes ....eine Art "Mikroschwankungsindikator".

Es folgen die Xth percentile und X% low Werte, die sich Stück für Stück immer weiter den schlechten Frametime Werten zuwenden und daher für das Spielgefühl besonders wichtig sind.

5%low und 99th percentile sind dabei noch eher auf den allgemeinen Spielfluss konzentriert und bekommen wenig bis nichts von einzelnen Frametimepeaks(Rucklern) mit.

Die letzten drei Werte werden je nach Spiel mehr oder weniger von diesen Frametimepeaks dominiert und sind meiner Meinung nach oft das beste Mittel um zu beschreiben ob und wie "Ruckelig" sich das Spiel anfühlt.

Leider basieren sie nur auf einem kleinen Teil der Frametimes und daher unterliegen sie größeren Ungenauigkeiten.

Auch wenn ich die 0,1% low Werte sehr schätze, bieten sie oft zu schlechte Reproduzierbarkeiten und daher bin ich ein großer Fan der 1% low Werte.

Diese sind in der Regel noch gut zu reproduzieren und entsprechen sinnvoll dem Spielgefühl.

Die Linien zwischen den Symbolen sind extra gestrichelt, da sie nur zur besseren Lesbarkeit beitragen sollen und keine Punkte dazwischen suggerieren sollen.

In der Legende sieht man die Symbolformen und Farben der verscheidenen Testkandidaten.

Die Wertepunkte selbst sind Durchschnittswerte aus den drei besten Werten von fünf Messungen und haben zusätzlich Fehlerbalken, die sich aus der empirischen Standardabweichung dieser drei besten Werte ergeben.

Wenn ihr hier bei einem Wert links(avg FPS) 44 in 1/s seht, dann würde euch Fraps auch 44 FPS anzeigen.

Aus dem Frametimeverlauf bestimme ich einen effektiven Frametimeverlauf. Diesen habe ich ausführlich im Hauptthread unter "Nomenklatur" diskutiert.

"avg eff FPS" ist der Kehrwert des Durchschnitts dieses effektiven Frametimeverlaufs.

Um so stärker dieser Wert gegenüber den avg FPS abfällt um so stärker sind die relativen Schwankungen der Frametimes ....eine Art "Mikroschwankungsindikator".

Es folgen die Xth percentile und X% low Werte, die sich Stück für Stück immer weiter den schlechten Frametime Werten zuwenden und daher für das Spielgefühl besonders wichtig sind.

5%low und 99th percentile sind dabei noch eher auf den allgemeinen Spielfluss konzentriert und bekommen wenig bis nichts von einzelnen Frametimepeaks(Rucklern) mit.

Die letzten drei Werte werden je nach Spiel mehr oder weniger von diesen Frametimepeaks dominiert und sind meiner Meinung nach oft das beste Mittel um zu beschreiben ob und wie "Ruckelig" sich das Spiel anfühlt.

Leider basieren sie nur auf einem kleinen Teil der Frametimes und daher unterliegen sie größeren Ungenauigkeiten.

Auch wenn ich die 0,1% low Werte sehr schätze, bieten sie oft zu schlechte Reproduzierbarkeiten und daher bin ich ein großer Fan der 1% low Werte.

Diese sind in der Regel noch gut zu reproduzieren und entsprechen sinnvoll dem Spielgefühl.

Die Linien zwischen den Symbolen sind extra gestrichelt, da sie nur zur besseren Lesbarkeit beitragen sollen und keine Punkte dazwischen suggerieren sollen.

In der Legende sieht man die Symbolformen und Farben der verscheidenen Testkandidaten.

Die Wertepunkte selbst sind Durchschnittswerte aus den drei besten Werten von fünf Messungen und haben zusätzlich Fehlerbalken, die sich aus der empirischen Standardabweichung dieser drei besten Werte ergeben.

Wie schon in den Frametimegraphen zu sehen, liegen Ryzen und der ivy i5@4,4GHz praktisch gleich.

Selbst das senken des DDR4 Takt auf 2133 verschlechtert das Ergebnis praktisch nicht.

Erst das absenken der i5 Taktraten auf den Basis Takt hat einen Einfluss auf die Performance.

Ryzen CCX Konfiguration und SMT

Alles sieht gleich aus, bis auf 4+0 3200MHz....und hier sehen wir später, das es sich vermutlich um eine unlogische und falsche Messung handelt.

Leistungsaufspaltung beim i5

Während mit 4,4GHz und 1866er DDR3 noch für das volle GPU limit reicht, reicht schon weniger Ram speed um dies zu ändern und zumindest in diese Szene FPS Unterschiede zu zeigen.

IPC Vergleich

Drei mal vier Kerne, ohne HT/SMT, bei 2,8GHz im Vergleich.

Ryzen ist zweimal vertreten und zwar einmal mit schnellem und einmal mit langsamem Ram.

Bei diesem Vergleich sehen wir auch zum ersten Mal Unterschiede bei Ryzen.

Generell kann Ryzen sich hier etwas durch die IPC absetzen....ein großer Teil ist jedoch der Ram.

Unterschiedliche Ram Skalierung bei anderen Kern und Thread Anzahlen?

Wenn wir hier etwas genauer hingucken, sehen wir auch mit 8 Kernen etwas Einfluss durch den Ram.

Mit 4 Kernen ist der Unterschied jedoch größer, 2133er DDR4 ist aber trotzdem kein Problem.

HBCC settings

Abolut keine Unterschiede zu finden.

Ryzen optimieren und übertakten

Mit dem 1800X habe ich bereits das stärkste Modell der Ryzen 1000er Serie.

Aber wie viel Leistung verschenkt man wenn man weder den Ram im Bios einstellt noch den Energiesparplan ändert?

Und wie viel Leistung kann man mit einem minimalen OC auf 3,8GHz und optimieren von Subtimings noch herausholen?

Der Unterschied von Stock Taktraten und dopc Profil zu meinen Optimierungen ist praktisch nicht vorhanden.

Die Bios defaults fallen etwas ab, vermutlich ist ein Teil davon der Wechsel von ausbalanciert zu Höchstleistung.

Der ausbalancierte Energiesparplan sollte inzwischen auch für Ryzen funktionieren und nicht mehr die Kerne schlafen legen aber auf Höchstleistung wird nicht heruntergetaktet.

Einfuss von Ramtakt auf den Infinity Fabric

Hintergrund:

Wer sich mit Ryzen beschäftigt hat, der wird öfter gehört haben, dass Ryzen schnellen Ram braucht, weil sonst die Kommunikation zwischen den CCX durch einen lansamen IF behindert wird.

Aber ist dem auch so? Ich habe noch keinen brauchbaren Test gesehen, der das untersucht hat und habe mir was eigenes überlegt.

Theoretisch ist da schonmal was dran. Gerade in neueren PC Spielen wird die Arbeit auf mehrere Kerne aufgeteilt und es findet viel Kommunikation statt um alles synchron zu halten und die Ergebnisse zusammenzuführen.

Der IF ist an den Takt des Ram gekoppelt und es gibt Veröffentlichungen, die zeigen das sich die Latenzen von einem CCX zum anderen mit schnellerem Ram verbessern.

Die Frage ist, ob dies rein theoretisch ist oder wirklich so signifikant, dass es sich auch in der Spieleperformance niederschlägt.

Leider steigt mit schnellerem Ram auch die Spieleperformance und es wird schwer zu sehen, was davon die IF Verbesserung war und was einfach der schnelle Ram.

Die IF Unterschiede von 2+2 zu 4+0 werden durch den doppelten L3 Cache bei 2+2 verschleiert.

Vorgehen

Bei den Ryzen 8 Kernern hat man die Möglichkeit über das Bios Kerne zu deaktivieren und dies habe ich einmal als 2+2 und einmal als 4+0 Konfiguration gemacht. SMT war deaktiviert.

Dann habe ich beides einmal mit 2133 und einmal mit 3200er Ram getestet.

Dann habe ich den prozentualen Performance Gewinn(2133 zu 3200) einmal für 2+2 und für 4+0 ermittelt und die Differenz gebildet.

Unter der Annahme, das der Gewinn durch den schnelleren Ram gleich sein sollte, zeigt die Differenz also den reinen Einfluss durch den beschleunigten IF.

Die Ergebnisse beruhen allerdings auf je vier fehlerbehafteten Größen und wenn man mit Gaußscher Fehlerfortpflanzung die Fortpflanzung dieser Fehler in das Endergebnis berechnet, zeigen sich leider große Unsicherheiten.

Aber ist dem auch so? Ich habe noch keinen brauchbaren Test gesehen, der das untersucht hat und habe mir was eigenes überlegt.

Theoretisch ist da schonmal was dran. Gerade in neueren PC Spielen wird die Arbeit auf mehrere Kerne aufgeteilt und es findet viel Kommunikation statt um alles synchron zu halten und die Ergebnisse zusammenzuführen.

Der IF ist an den Takt des Ram gekoppelt und es gibt Veröffentlichungen, die zeigen das sich die Latenzen von einem CCX zum anderen mit schnellerem Ram verbessern.

Die Frage ist, ob dies rein theoretisch ist oder wirklich so signifikant, dass es sich auch in der Spieleperformance niederschlägt.

Leider steigt mit schnellerem Ram auch die Spieleperformance und es wird schwer zu sehen, was davon die IF Verbesserung war und was einfach der schnelle Ram.

Die IF Unterschiede von 2+2 zu 4+0 werden durch den doppelten L3 Cache bei 2+2 verschleiert.

Vorgehen

Bei den Ryzen 8 Kernern hat man die Möglichkeit über das Bios Kerne zu deaktivieren und dies habe ich einmal als 2+2 und einmal als 4+0 Konfiguration gemacht. SMT war deaktiviert.

Dann habe ich beides einmal mit 2133 und einmal mit 3200er Ram getestet.

Dann habe ich den prozentualen Performance Gewinn(2133 zu 3200) einmal für 2+2 und für 4+0 ermittelt und die Differenz gebildet.

Unter der Annahme, das der Gewinn durch den schnelleren Ram gleich sein sollte, zeigt die Differenz also den reinen Einfluss durch den beschleunigten IF.

Die Ergebnisse beruhen allerdings auf je vier fehlerbehafteten Größen und wenn man mit Gaußscher Fehlerfortpflanzung die Fortpflanzung dieser Fehler in das Endergebnis berechnet, zeigen sich leider große Unsicherheiten.

Stattdessen zeige ich nur die zugrundeliegenden Messungen:

Wie wir sehen können scheint die Messung mit 4+0 und 3200er DDR4 nicht gelungen zu sein. Eventuell hat die Grafikkarte nicht getaktet wie sie soll, oder etwas lief im Hintergrund.

Eigentlich hätte ich erwartet das sie die beste Leistung liefern sollte aber das scheint schief gegangen zu sein.

Da ich inzwischen neue Grafikkartentreiber und einige neue Windows updates drauf habe kann ich die Messungen auch nicht vergleichbar zu den anderen wiederholen.

Fazit:

Da ist er also....der erste meiner Test mit so gut wie keinem Wissensgewinn.

Solange man nicht vier Kerne mit wenig GHz und langsamem Ram hat, zeigen sich keine nennenswerten Unterschiede.

Die meisten Messungen zeigen nur unbedeutende Variationen eines GPU limits.

In diesem GPU limit liefern die 4,4GHz des i5 etwas mehr avg FPS als der Ryzen und bei den X% low Werten kann dann der Ryzen eine minimale Führung halten.

Wenn man das Video anguckt, sieht man das die CPU Belastung zwischen 20-30% liegt, was grob vier voll ausgelasteten CPU Kernen entspricht.

Spürbare Unterschiede gab es aber nur mit gesenkten Taktraten.

Die Auswertung des IF war leider nicht möglich.

HBCC war egal und optimieren ist dank GPU limit auch nicht wichtig.

Danke, wer sich dies bis hier her angetan hat

Zuletzt bearbeitet: