- Registriert

- Nov. 2002

- Beiträge

- 8.623

Bei ATi ist dies seit dem R520 der Fall, dass im 2D-Part Chipteile deaktiviert werden. Wie das bei nVidia ist, weiß ich jetzt nicht genau, schätze aber mal, dass das nicht viel anders ist.wie darfich das verstehen? werden im idle mittlererweile teile des chips deaktiviert?

ich dachte man wär grad ma auf dem niveau der taktreduzierung und seit kurzem auch spannungssenkung

Vergleiche mal das Erscheinungsdatum des Artikels mit dem des ForceWare 91.45 - dann dürfte deer Grund bekannt sein, und ich glaube, du hast eine falsche Vorstellung davon, wie schnell man soeben einen neuen Treiber testet.Warum wurde nicht mit dem 91.45 getestet? Noch nicht verfügbar gewesen? Oops, der .37 war auch schon für Q-SLI,sry.

nenn mir eine mainstreamkarte auf der n chip klebt in dem mehrere kerne sind die sich die arbeit teilen..

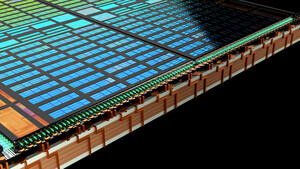

Jede handelsübliche GPU ist seit mehreren Jahren bereits Multi-Core.Oder was glaubst du, was 24 Pixel-pipelines sind?

Mhm, tolle Kritik. Der FX60 ist also langsam und der nForce 4 x16 Chipsatz bietet pro Lane nur acht PCIe-Lanes - aha...was für ein schlechter test warum eigentlich auf einer nforce 4 platine mit dem alten fx60 ? und nur 2x 8 lines für quad sli