Kopi80 schrieb:

Am besten du beliest dich vllt. gleich mal mit den verlinkten anderen Artikeln zum Thema (bei genauerem Hinsehen finden diese sich sogar am Ende dieses Artikels -.-). Hoffe geholfen zu haben.

Ja genau, das und die mathematisch korrekten, dafür grottenhässlichen Schatten- und Spiegeleffekte sind die einzigen Vorteile von Raytracing, und zu welchem Preis? Um in drei, vier Jahren auf einem HighEnd-Rechner das schon heute hässliche Quake Wars Raytraced flüssig spielen zu können? Na danke, ich passe

Zudem stellt sich die Frage, ab wann genau die Polygonberechnung mit Raytracing effizienter wird. Die Bildschirmauflösung gibt nunmal vor, wie viele Polygone in einer Szene überhaupt noch Sinn machen, ohne dass das Bild abartig zu flimmern anfängt, da Polys bereits kleiner als Pixel sind. Bedenkt man, dass der PC fast nur noch mit Konsolenports überschüttet wird, und dort der Standard bei 720p (1280*720 = 921.600 Pixel) liegt, fällt die Performance unter Rasterizer erheblich besser aus als unter Raytracing. Nächste Konsolen-Generation, die wohl bis 2016 geht, wird der Standard 1080p betragen. Das lässt in der Theorie ein maximales Polygonbudget von 2 Mio. zu (in der Praxis werden es wesentlich weniger sein, da

immer irgendein etwas größeres Objekt ohne allzu viele Polygone ins Bild ragt). Auch da ist die Performance unter Rasterizer noch Welten besser als unter Raytracing.

Sicherlich gibt's die Leute mit astronomischen Auflösungen von 2560*1600 oder sowas in der Art, aber an diese Minderheit wird das Polygonbudget sicher nicht angepasst, sonst würde es wie gesagt bei allen anderen ekelig flimmern. Wobei es auch dann noch anzuzweifeln wäre, ob Raytracing selbst in so einem Fall performanter rechnen würde...

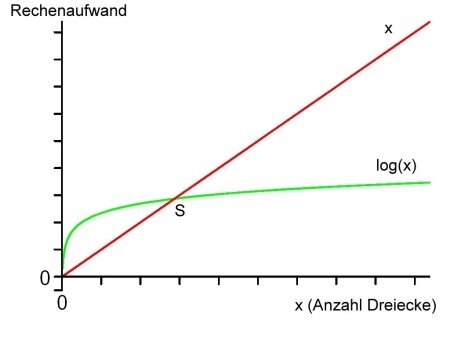

Also, WO GENAU soll Raytracing einen Durchbruch bringen? Die Performance ist unterirdisch, der logarithmische Rechenaufwand für Polygone in den nächsten paar Jahrzehnten in der Praxis nicht zu gebrauchen und die Schatten sehen in der Standardausführung grottenhässlich aus - es sei denn man verwendet spezielle Verfahren wie diffuses Raytracing oder Path Tracing für Softshadows, wodurch die Performance nochmal zusätzlich ins Bodenlose rutscht. Unterm Strich geht mir das Gehype von Herrn Pohl gehörig auf die Eier^^ Für Animationsfilme von Pixar & Co oder bestimmte Fake-Raytracing-Techniken in Rasterizer-Engines (wie etwa beim Parallax Occlusion Mapping) mag Raytracing ganz nett sein. Eine vollwertige Raytracing-Engine in Spielen ist jedoch Mumpitz.