minyita

Cadet 4th Year

- Registriert

- Apr. 2019

- Beiträge

- 73

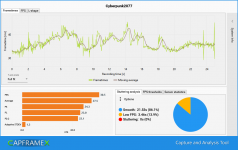

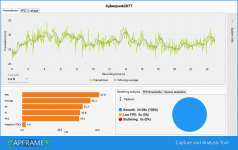

5hred schrieb:Diese Ergebnisse hier scheinen aber die Vermutung von oben teils zu widerlegen, dass die 1080 Ti nur wegen der schwachen CPU nicht die gewohnte Leistung abliefern kann: trotz einer recht aktuellen CPU (3700X) performt sie schlechter als eine 2070S und das Leistungsdelta zur 2080 in Kombination mit i7-6850K ist deutlich größer (21%) als dies normal sein sollte, da zum Launchzeitpunkt der 2080 die 1080 Ti mindestens gleichwertig war und teils auch schneller (wenn ich mich recht entsinne)...

Wird die 1080Ti nur noch stiefmütterlich behandelt? Man kann nur hoffen, dass Karten der älteren Generation nicht bewusst verlangsamt werden (treiberseitig oder spielseitig).

Du hast mir als GTX 1080Ti & 7700K User echt gerade meinen Frust von der Seele geschrieben. Das der olle 4 Kerner nicht mehr das wahre ist, ist mir auch klar, und das war vermutlich das erste & einzige Setup in meinem Leben, wo die CPU früher fliegt als die GPU - dachte ich.

Ich mein Ryzen hat gerade mit der 3xxx Serie gut aufgemischt, und schon vorher 6-8 Kerne als den neuen Standard definiert, da war der 7700K sowieso der größte Fehlkauf 2017.

Dass die 1080 Ti allerdings so abschmiert, eine GPU die locker auf dem Niveau einer RTX 2080 (nicht die Super) ist, und dazu noch 3GB mehr VRAM hat, regt mich gerade ehrlich gesagt nur auf. Wie kann meine 3 Jahre alte Highend GPU bei einem neu erschienenen Game nicht mal 60FPS in Full HD auf hoch-ultra packen, wenn der Trend doch eh zu WQHD und 4K geht?

Die 1080 Ti ist von der puren Benchmarkleistung immer noch in der Top 15 oder so, und schmiert hier ab gegen Vega Grafikkarten, gegen eine 3060, 2070, etc?

Das liegt ja wohl echt eher an der Optimierung als an der puren Leistung, ich hab mich drauf eingestellt den i7 bald zu ersetzen, aber die 1080 Ti wollt ich eig noch ne Weile behalten, gerade weil die neuen AMD Karten quasi nicht zu bekommen sind und die neuen Nvidia absolut unverschämt bepreist.