PhysX-Beschleunigung auf ATi Radeon HD 3800?

Nach der Übernahme von Ageias PhysX-Technologie hatte es Nvidia in wenigen Monaten geschafft, das PhysX-SDK in das eigene CUDA-SDK zu implementieren und bietet seit kurzem entsprechende Treiber zur GPU-Beschleunigung von PhysX an. Nun soll es einem findigen Anwender gelungen sein, PhysX auch mit einer ATi-GPU zu beschleunigen.

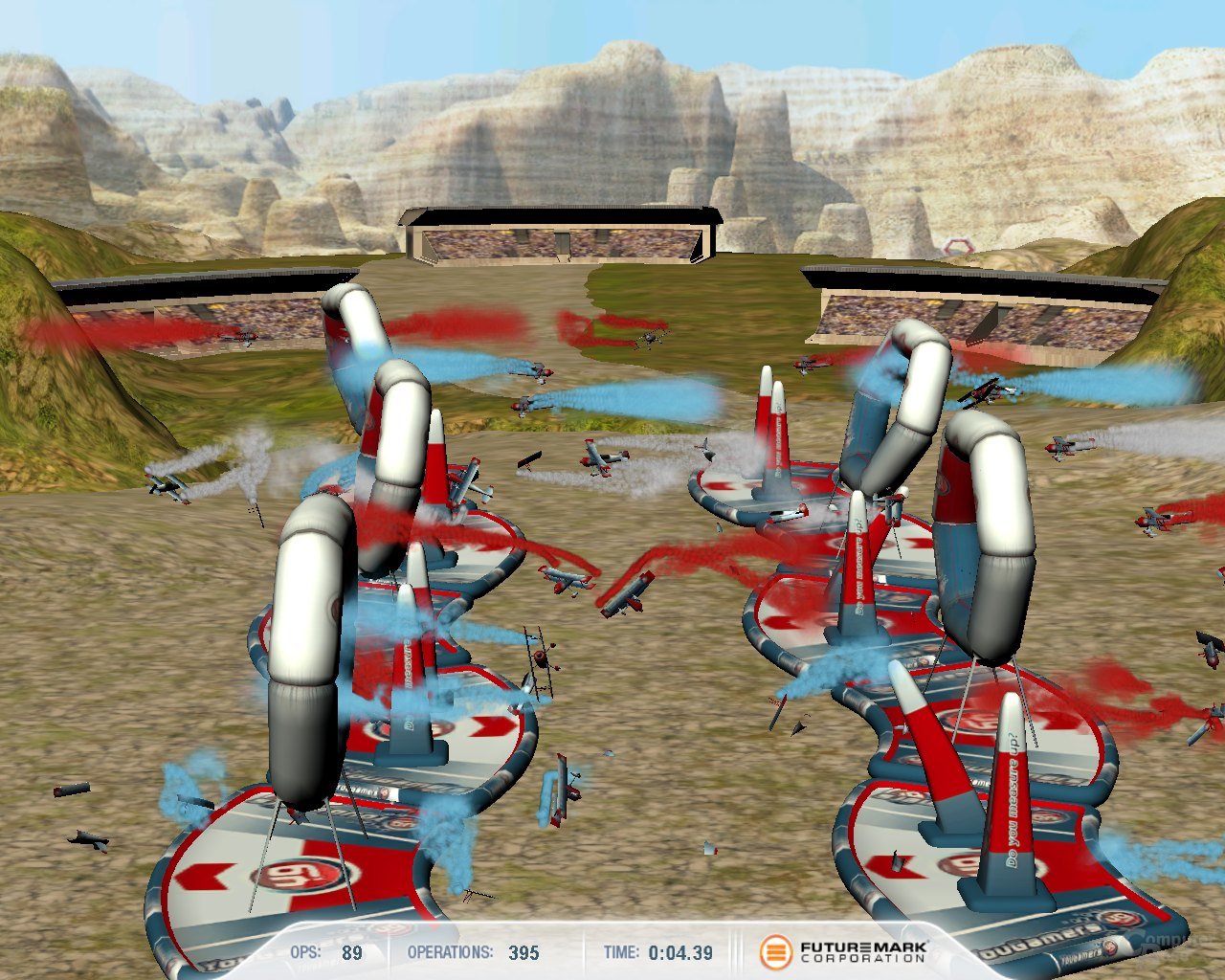

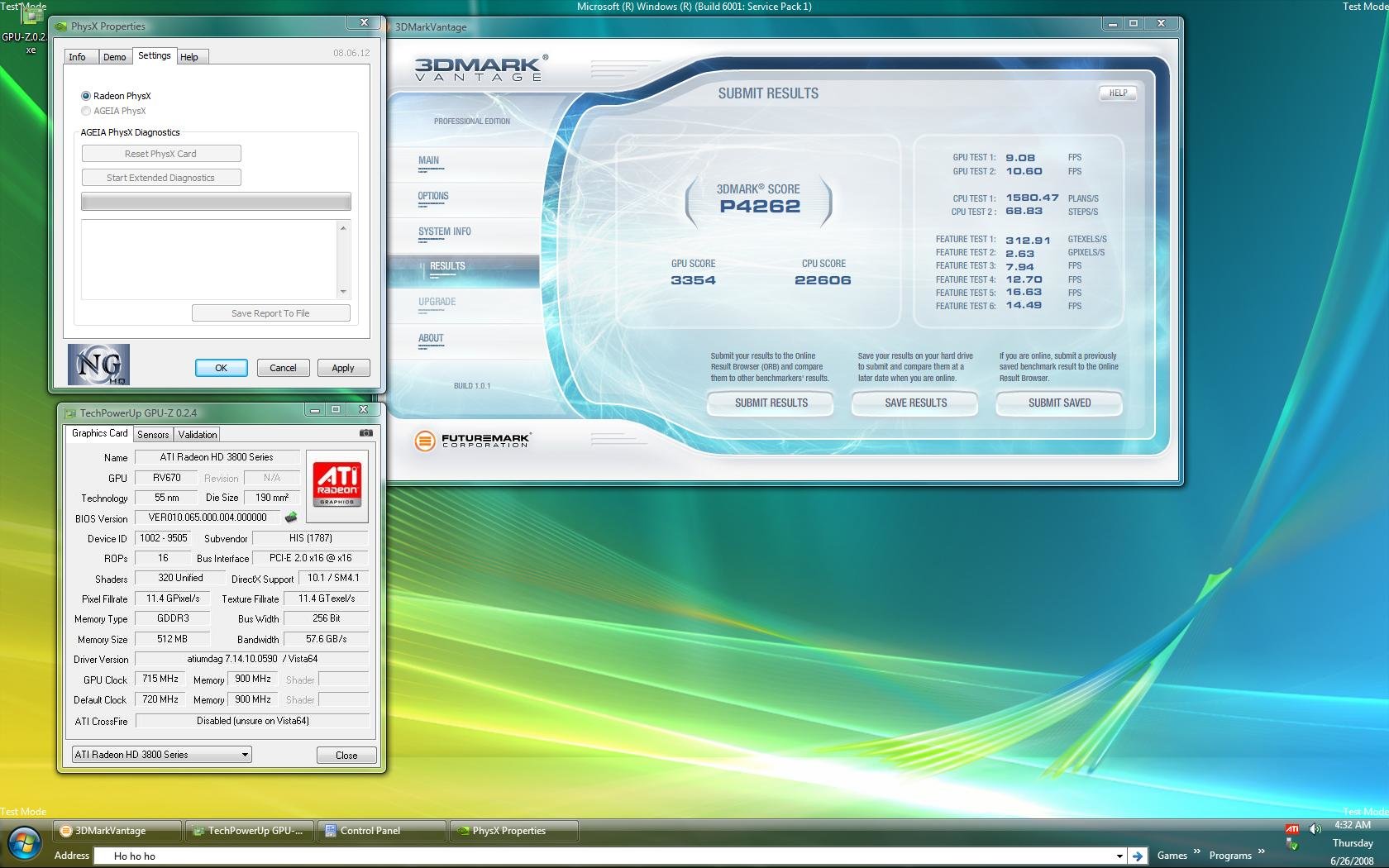

So will sich Eran Badit von NGOHQ.com mit dem CUDA- und PhysX-SDK etwas auseinander gesetzt haben und mit relativ geringem Aufwand es geschafft haben, PhysX mit einer ATi Radeon HD 3850 (RV670) zu beschleunigen. Bei einem GPU-Takt von 715 MHz und einem Speichertakt von 900 MHz (Standard: 670/830 MHz) konnten einem Screenshot zufolge 68,83 Operationen pro Sekunde (OPS) im PhysX-relevanten CPU Test 2 aus Futuremarks 3DMark Vantage erreicht werden.

Eine von uns getestete, nicht übertaktete GeForce 8800 GT bringt es auf 93,67 OPS, womit das Ergebnis der HD 3850 in guter Relation zur Grafikleistung der beiden Grafikkarten stehen würde. Mit einem auf 3,15 GHz übertakteten Intel Core 2 Duo E4300 lassen sich gerade einmal 7,45 OPS berechnen.

Eran Badit gab bekannt, dass er das selbst entwickelte Software-Tool, welches die PhysX-Beschleunigung auf einer ATi-GPU ermöglicht, auf NGOHQ.com zur Verfügung stellen werde, sobald er es mit weiteren Grafikkarten getestet habe. Eine Unterstützung für die neue Radeon HD 4800 (RV770) könne er noch nicht zusagen, da NGOHQ.com bislang noch keine entsprechenden Karten von ATi zur Verfügung gestellt bekommen habe.

Bereits im vergangenen April hatte Nvidia angekündigt, dass PhysX jedem verfügbar gemacht werden solle, der daran interessiert sei – auch anderen Grafikkartenherstellern. Sollte es sich bei dem auf NGOHQ.com aufgetauchten Screenshot nicht um einen Fake handeln, hätte Eran Badit damit bereits eindrucksvoll bewiesen, dass es für ATi aus technischer Sicht nur ein kleiner Schritt wäre, die nicht so recht in Schwung kommende Physik-Beschleunigung voran zu treiben.