Nein es wird im Moment nur der LPDDR5 produziert, da für "richtigen" DDR5 noch keine Abnehmer vorhanden sind.

Intel und AMD verbauen beide durchgehend DDR4 Controller in deren CPUs und somit kein Bedarf an DDR5.

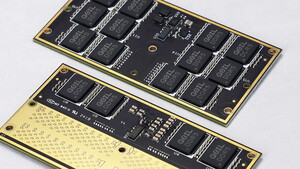

Die Produktion der Ramchips für DDR5 im PC wird im verlauf des Jahres starten und steigen während DDR4 langsam gedrosselt wird und die Preise langsam steigen.

Vorerst gibts aber nur Vorserienmodelle um die Fertigung, Mainboards, Speichercontroller usw. zu optimieren.

Bei AMD wirds anscheinend 2021 soweit, dass DDR5 in die Desktops kommt. Bei den EPYCs eventuell schon 2020.

Bei allem sollte man sich aber nicht zu früh freuen, da DDR5 vorerst mal wesentlich teurer als DDR4 sein wird und vor allem nicht unbedingt viel schneller.

Wenn man bedenkt, dass DDR4-2133 sich am anfang gegen DDR3-1600 oder gar 2133 MHz behaupten musste und aufgrund der Timings usw. nicht wirklich schneller war, reichts auch wenn man 2022 oder 2023 dann sehr gute, schnelle und vergleichsweise günstige DDR5 Module bekommt.

nanoworks schrieb:

Beispiel Batch Rendering:

Warum sollte man sich für rechenintensive Anwendungen wie Maya und Co noch eine sauteure Hochleistungsworkstation kaufen, wenn man sich einfach bei den großen Cloud Anbietern (Google, MS, Amazon) einen Slot für die Aufgabe mieten kann? Du sparst Strom, Wartungskosten, du musst nicht immer aufrüsten, hast keine Treiberprobleme und das Rechenzentrum erledigt die Aufgabe ohnehin schneller.

Falsch: du sparst keinen Strom, er wird wo anders verbraucht und dort eventuell effizienter genutzt. Der Unterschied ist, dass du keinen PC, Strom usw. zahlst sondern einfach eine Dienstleistung.

Brauchst du diese Workstation aber dauerhaft fürs rendern, kanns auch sein, dass auf dauer eine eigene Renderfarm billiger als die Cloud ist.

Eins kann ich dir aus eigener Erfahrung sagen: Wenn du Leistung brauchst, ist auch die Cloud sauteuer denn es hat keiner was zu verschenken.