Nvidia Ampere: A100 80GB GPU zieht in DGX Station und DGX/HGX A100 ein

Auf die Ankündigung der „A100 80GB GPU“ lässt Nvidia entsprechend ausgestattete Systeme folgen. Für Datenwissenschaftler ist die Workstation DGX Station A100 mit vier der Ampere-GPUs vorgesehen. Im Datacenter kommen hingegen neue Generationen von DGX A100 direkt von Nvidia sowie HGX A100 von Partnern zum Einsatz.

Durch den Wechsel von HBM2 zu HBM2e kann Nvidia die A100-GPU erstmals in einer Konfiguration mit 80 GB Speicher anbieten, die einen Speicherdurchsatz von knapp über 2 TB/s erreicht. Diese Rechenleistung stellt Nvidia nicht nur im Datacenter zur Verfügung, sondern fortan auch auf dem Desktop, wo mit der DGX Station A100 ein entsprechendes Produkt noch dieses Quartal angeboten werden soll. Einen Preis hat Nvidia bisher nicht genannt, der Vorgänger mit vier Tesla V100 lag jedoch bei 49.900 US-Dollar (netto) für das erste System und 69.000 US-Dollar für jedes weitere.

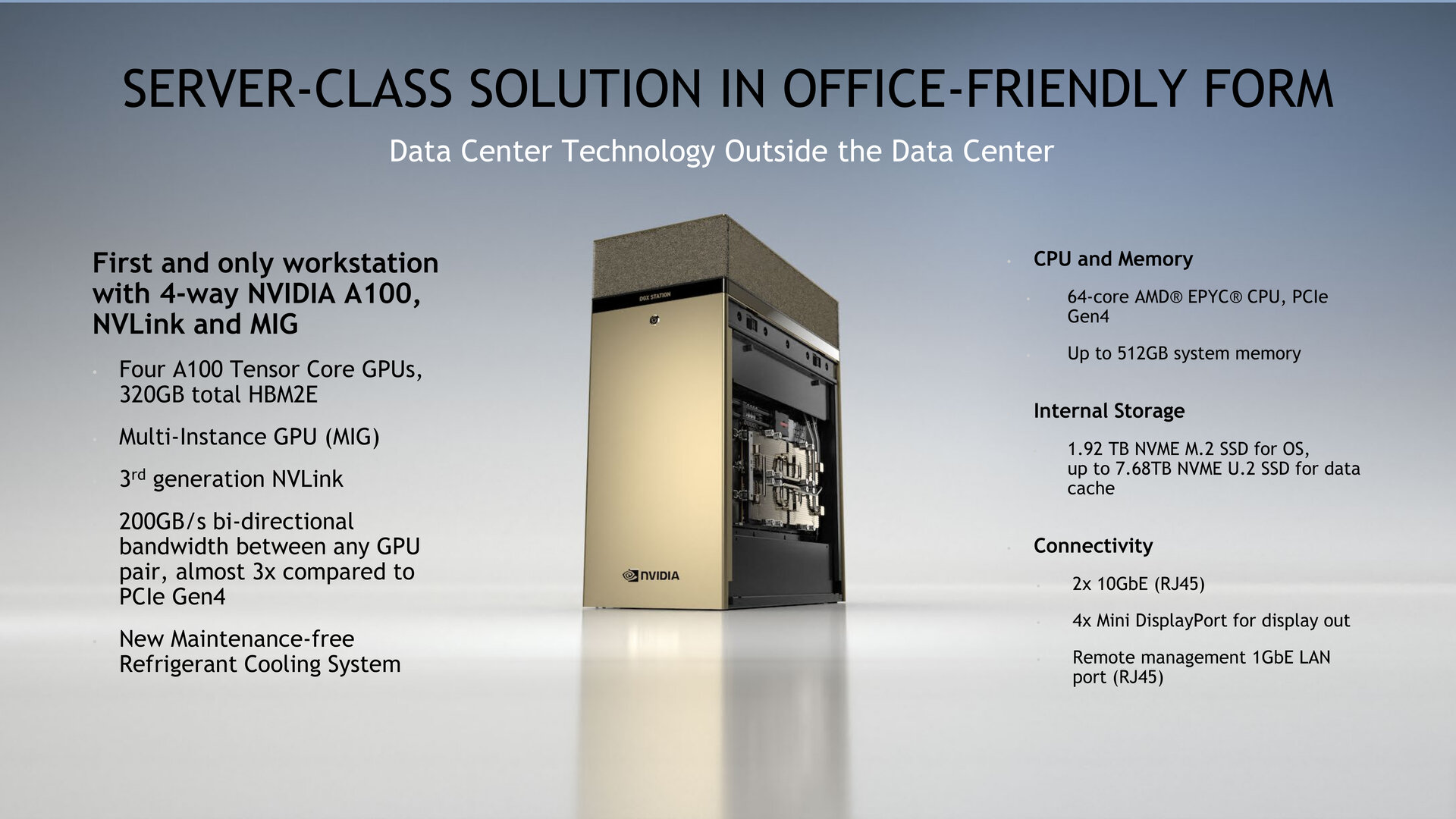

Desktop-Workstation mit vier A100 80GB

Zur Vorstellung der Ampere-Architektur im Mai hatte Nvidia noch keine entsprechend ausgestattete DGX Station vorgestellt und sich auf den Einsatz im Datacenter fokussiert. Zwischenzeitlich bietet Nvidia die A100-GPU auch als einzelne PCIe-Steckkarte für Server an. In der neuen Workstation sind hingegen gleich vier der neuen „A100 80GB GPU“ verbaut, sodass insgesamt 320 GB Speicher zur Verfügung stehen. Diese sind untereinander mit dem NVLink der dritten Generation mit einer bidirektionalen Bandbreite von 200 GB/s zwischen jedem GPU-Paar verbunden. Die GPUs lassen sich in insgesamt 28 Instanzen (7 pro GPU) mit jeweils 10 GB zugewiesenem Speicher unterteilen. Alternativ ist die Workstation mit der im Mai vorgestellten 40-GB-Variante verfügbar.

AMD liefert erneut die CPU

Das System ist darüber hinaus mit einem AMD Epyc mit 64 Kernen als CPU, bis zu 512 GB Arbeitsspeicher, einer 1,92 TB großen NVMe-SSD für das Betriebssystem und bis zu 7,68 TB SSD-Speicher mit U.2-Anbindung als Datencache ausgerüstet. Für Konnektivität im Netzwerk stehen zweimal 10GbE und einmal Gigabit-Ethernet speziell für den Remote-Zugriff zur Verfügung. Die Bildausgabe erfolgt über einen speziellen „DGX Display Adapter“ mit viermal Mini DisplayPort, die 4K-Auflösung unterstützen.

Die Kühlung der DGX Station A100 übernimmt eine geschlossene Kompressorkühlung, vergleichbar mit der eines Kühlschrankes, die für CPU und GPUs zuständig ist.

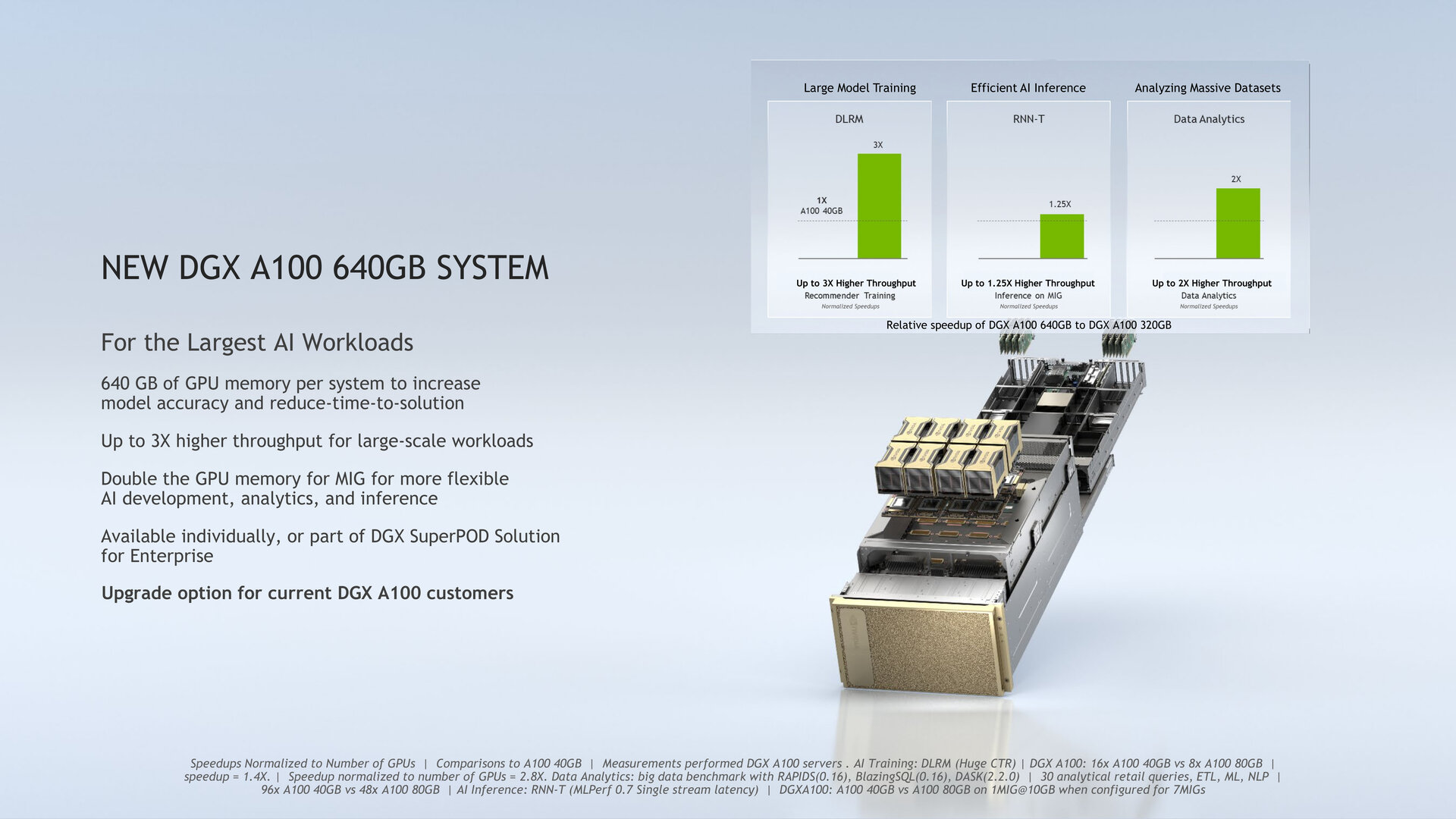

DGX A100 erhält Upgrade

Darüber hinaus bietet Nvidia den KI-Server DGX A100 ab sofort mit einer neuen Konfiguration aus acht „A100 80GB GPU“ an, die für bestehende Kunden der Variante mit achtmal 40 GB auch als Upgrade angeboten wird. Bisher liegen für den neuen Server oder das Upgrade noch keine Preise vor, für das bisherige DGX A100 ruft Nvidia 199.000 US-Dollar vor Steuern auf.

CAMBRIDGE-1 mit 80 Ampere-GPUs

Aus dem DGX A100 lässt sich der sogenannte DGX SuperPOD als schlüsselfertiger Server direkt von Nvidia in Konfigurationen ab 20 DGX-Systemen erstellen. Der bereits im Mai vorgestellte SuperPOD lässt sich nun auch mit dem aktualisierten DGX-Server mit 80-GB-GPU bestücken. Der erste Einsatz erfolgt im Vereinigten Königreich im Supercomputer CAMBRIDGE-1, der mit 80 DGX A100 bestückt ist und 50 TB GPU-Speicher, 400 PetaFLOPS KI-Leistung, 20 TB/s über Mellanox InfiniBand und 2 PB NVMe-Speicher bei einem Verbrauch von 500 kW bietet.

400 Gbit/s mit neuen Mellanox-Adaptern

Für höhere Geschwindigkeiten im Netzwerk des Datacenters hat Nvidia parallel das Mellanox 400G InfiniBand vorgestellt, das mit 400 Gbit/s arbeitet. Neben dem neuen Netzwerkadapter gibt es eine aktualisierte Data Processing Unit (DPU) mit zusätzlichen ARM-Kernen, die nun ebenfalls 400 Gbit/s schafft, sowie einen zugehörigen Switch mit 64 400 Gbit/s-Ports und 128 200 Gbit/s-Ports. Mit den zugehörigen optischen Kabeln sowie (aktiven) Kupferkabeln liefert Nvidia/Mellanox weitere benötigte Komponenten.

HGX A100 folgt im zweiten Halbjahr 2021

Für das zweite Halbjahr 2021 ist eine Neuauflage des HGX A100 geplant. HGX A100 ist Nvidias Plattform, mit der Partner wie Atos, Dell, Fujitsu, Gigabyte, Hewlett Packard Enterprise, Inspur, Lenovo, Quanta und Supermicro eigene Server in Konfigurationen mit vier oder acht „A100 80GB GPU“ anbieten können, die dem DGX A100 ähneln.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühest mögliche Veröffentlichungszeitpunkt.