Eigene CPU und ASIC: Microsoft rüstet für den AI-Wettstreit deutlich auf

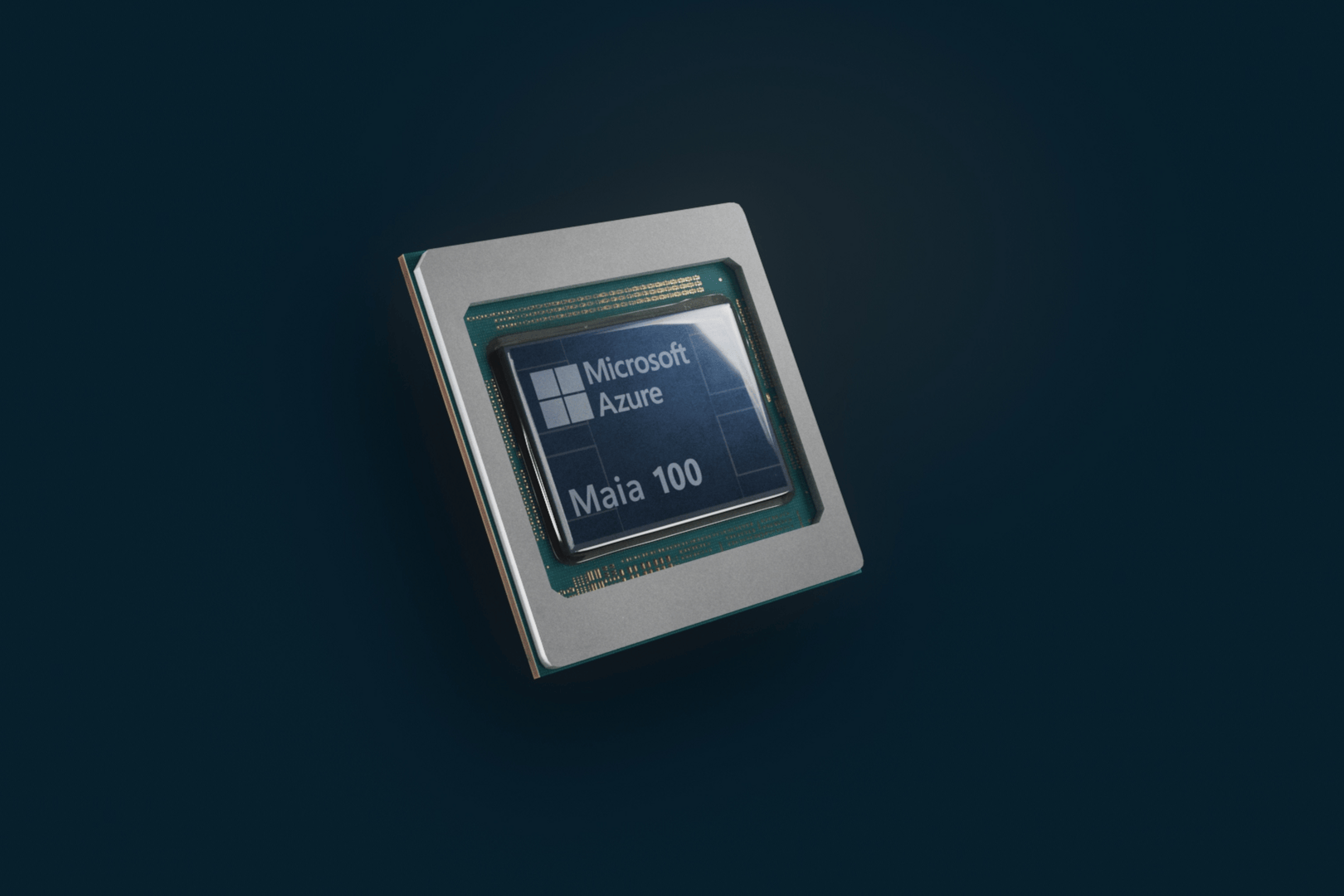

Mit dem Microsoft Azure Maia AI Accelerator und der Microsoft Azure Cobalt CPU will das Unternehmen im AI-Wettstreit vorn mitmischen. Diese Custom-Lösungen sind, wie der Name schon darlegt, auf die eigene Azure-Umgebung in der Cloud gedacht und sollen ab 2024 eingeführt werden.

Zwei neue Custom-Chips für die eigene Cloud

Azure Maia ist ein KI-Beschleuniger-Chip, der für Cloud-basiertes Training und Inferencing für KI-Workloads wie OpenAI-Modelle, Bing, GitHub Copilot und ChatGPT entwickelt wurde. Da aber nicht alles gleich Künstliche Intelligenz braucht, steht ein Bindeglied für die herkömmlichen Sachen an dessen Seite: Azure Cobalt ist ein Cloud-nativer Chip, der auf der Arm-Architektur basiert und für Leistung sowie Energie- und Kosteneffizienz bei allgemeinen Arbeitslasten optimiert ist.

Die technischen Details zu beiden Lösungen sind von offizieller Seite bestenfalls dünn gesät, zum großen Teil nicht vorhanden. Von der Cobalt-CPU ist bekannt, dass sie auf Arm Neoverse N2 basiert. 128 Kerne werden von einem 12-Kanal-Speicherinterface flankiert, die Leistung soll gegenüber dem nicht genauer benannten Vorgänger um 40 Prozent höher liegen.

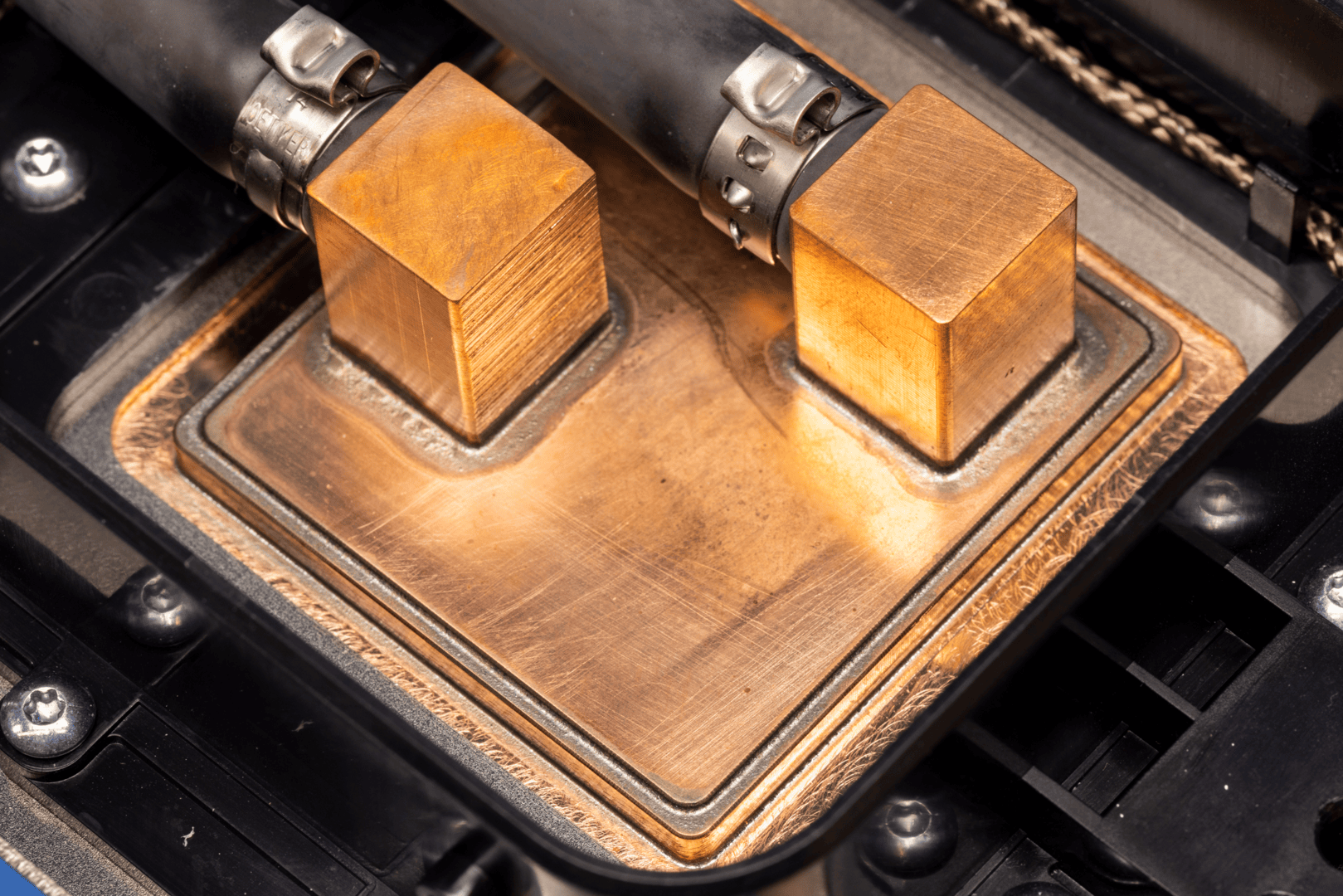

TSMCs 5-nm-Fertigung sorgt auch für das Herzstück von Maia. Das Produktbild lässt auch die passende CoWoS-Packaging-Technologie erkennen, vier HBM-Chips an den Seiten des „Grafikchips“, in dem Fall eigentlich eher ein ASIC, stehen zur Verfügung. Einen Vergleich scheut Microsoft hier erst einmal komplett.

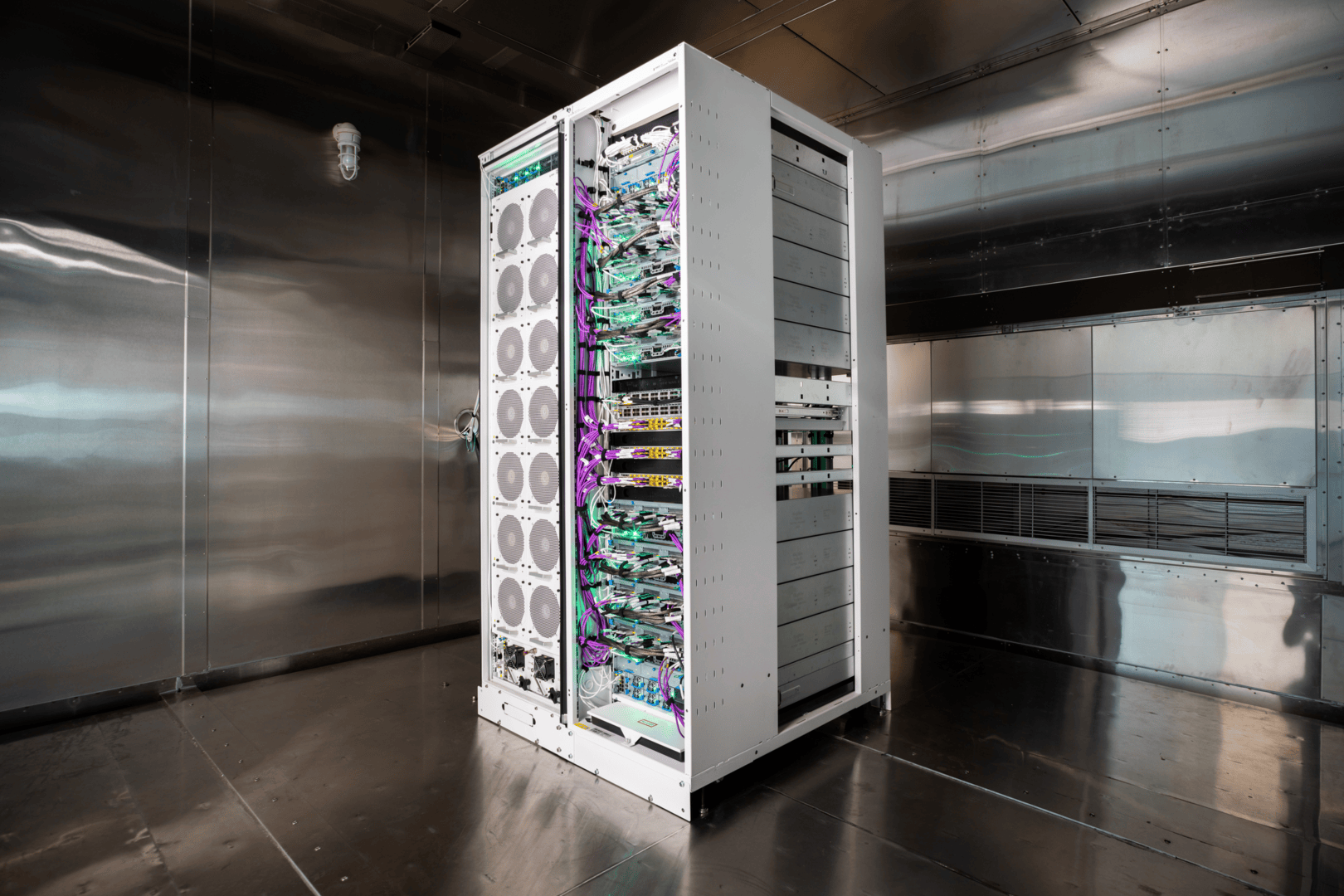

Microsoft betont, dass man mit den Custom-Lösungen den Kundenwünschen besser nachkommen kann. Angepasste Software und die eigenen Rechenzentren – die ersten werden aktuell mit den neuen Chips bestückt – sollen einen Mehrwert gegenüber der starken Konkurrenz bieten.

Auch Microsoft-Systeme mit AMD MI300X und Nvidia H100/H200

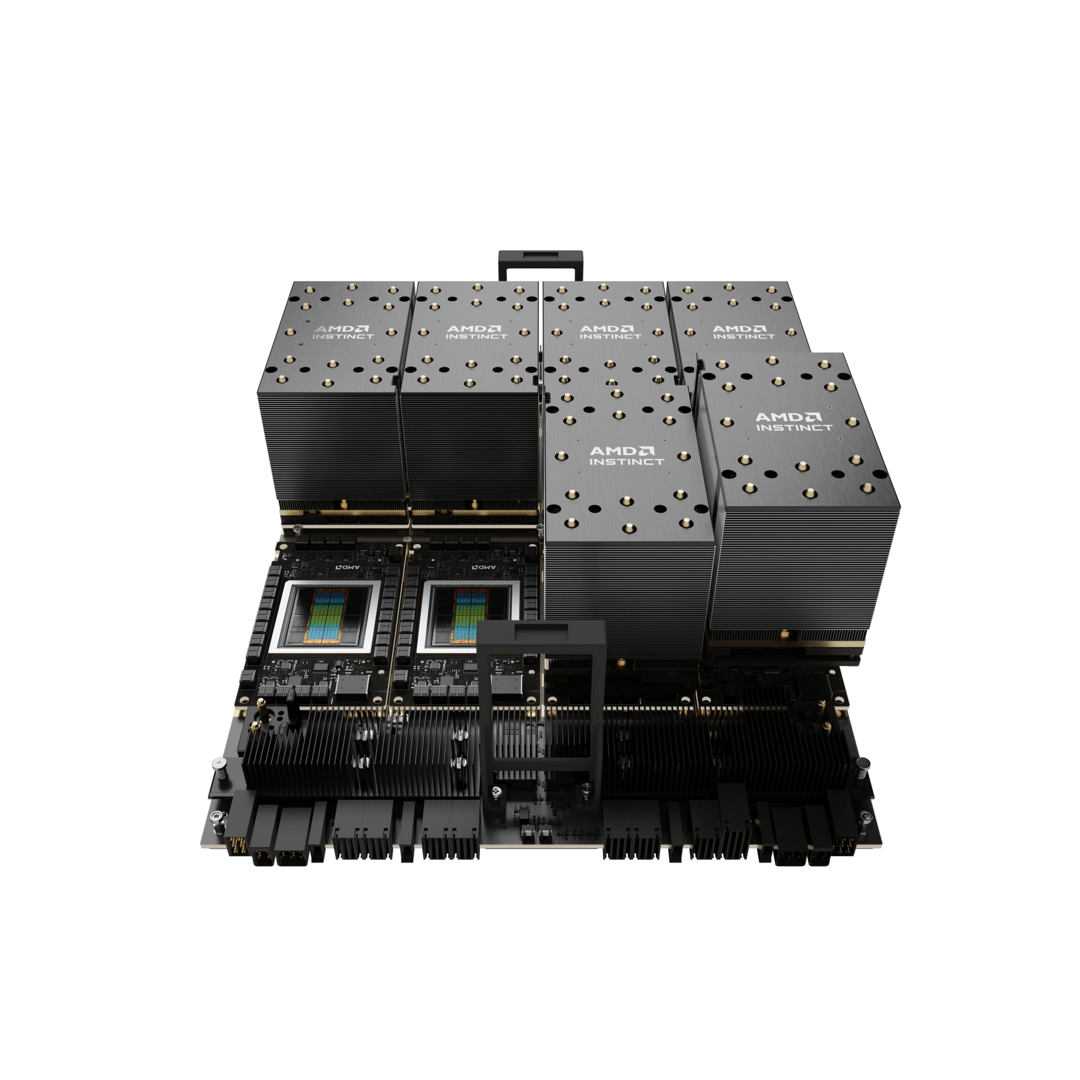

Zusätzlich zu den neuen Eigenentwicklungen baut Microsoft seine Partnerschaften mit Hardware-Anbietern aus, um seinen Kunden weitere Infrastruktur-Auswahlmöglichkeiten anbieten zu können. So wird man unter anderem AMD Instinct MI300X beschleunigte virtuelle Maschinen (VMs) zu Azure hinzufügen. Die ND MI300 VMs wurden entwickelt, um die Verarbeitung von KI-Workloads für das Training von KI-Modellen mit hoher Reichweite und für generative Inferenz zu beschleunigen. Offiziell startet die MI300-Familie von AMD am 6. Dezember.

Die Preview der neuen NC H100 v5 Virtual Machine Series, die für Nvidia H100 entwickelt wurde, bietet mehr Leistung, Zuverlässigkeit und Effizienz für das Training künstlicher Intelligenz im mittleren Leistungsbereich und für generatives KI-Inferencing, erklärt das Unternehmen. Außerdem kündigt Microsoft seine Pläne für die ND H200 v5 Virtual Machine Series an, eine KI-optimierte VM mit der kommenden neuen Nvidia H200.