AMD Instinct MI375: Auf die MI350 soll ein weiterer Chip mit 288 GB HBM3e folgen

Während aufgrund der Marktdominanz Nvidias kommende KI-Beschleuniger der Generation Blackwell in aller Munde sind, bereitet auch AMD neue Modelle der Instinct-Serie vor. Nach der MI350 wird es angeblich die MI375 geben. Beide sollen mit 288 GB HBM3e bestückt sein.

Das berichten die Analysten von TrendForce, die bereits zuvor die MI350 ins Spiel gebracht hatten. Von einer MI375 ist jetzt indes erstmals die Rede.

TrendForce ist für Marktanalysen bei Speicherprodukten bekannt und beschäftigt sich aufgrund des High Bandwidth Memory (HBM) in letzter Zeit auch verstärkt mit dem Thema KI-Beschleuniger, die nun einmal Unmengen dieses Speichers beanspruchen.

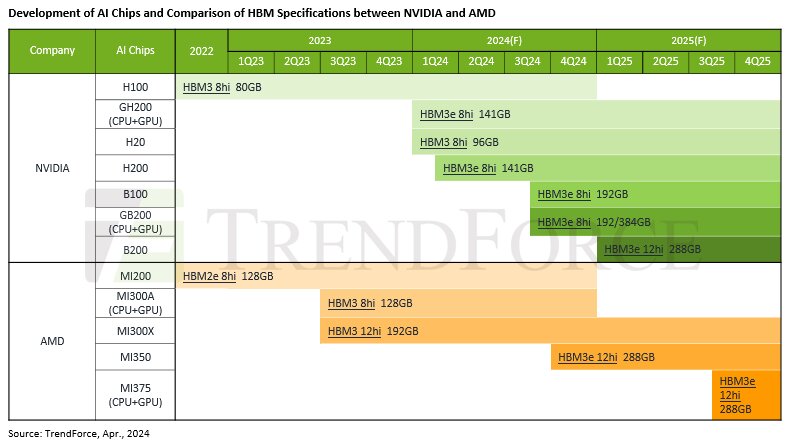

Roadmap für KI-Beschleuniger von AMD & Nvidia

Die von TrendForce gezogene Roadmap für KI-Beschleuniger von AMD und Nvidia besagt, dass zunächst Nvidias B100 als erster Vertreter der Blackwell-Generation im Laufe des dritten Quartals 2024 mit 192 GB HBM3e erscheint. Parallel soll die Nvidia GB200 als Ableger mit zusätzlicher Grace-CPU („G“ steht für Grace und „B“ für Blackwell) erscheinen und 192 GB oder 384 GB an HBM3e bieten.

Etwas später und somit in Richtung viertes Quartal 2024 wird AMDs MI350 erwartet, von der schon zuvor berichtet wurde. Die MI350 soll gegenüber der MI300-Serie auf Chiplets aus einem verfeinerten Herstellungsverfahren (TSMC 4 nm statt 5 nm) setzen. Was sich im Detail technisch ändert, ist noch völlig unbekannt. Zumindest gilt ein Speicherupgrade von HBM3 auf HBM3e als gesichert, denn genau das hatte AMDs Mark Papermaster für eine neue Generation in Aussicht gestellt.

Jetzt berichtet TrendForce konkreter von 288 GB HBM3e mit Packages aus 12 übereinander gestapelten DRAM-Dies (hier als 12hi bezeichnet). Die gleiche Speichermenge sollen dann Nvidias B200 Anfang 2025 sowie die erstmals erwähnte AMD MI375 aufweisen, die aber erst im zweiten Halbjahr 2025 zu erwarten sei.

Nicht auf der Roadmap steht die in dem Bericht erwähnte potenzielle Übergangslösung „MI32x“, die noch vor der MI350 mit HBM3e erscheinen könnte. Hier wäre ein reines Speicherupgrade von der MI300-Serie denkbar.

Meanwhile, AMD plans to launch the new MI350 by the end of the year and may introduce interim models like the MI32x in the meantime to compete with the H200, with both utilizing HBM3e.

TrendForce

Das Manko bleibt die Software

Während schon AMDs MI300-Serie auf dem Papier durchaus konkurrenzfähig zu Nvidias Lösungen war, gilt dies nicht für das Software-Ökosystem. Hier ist Nvidias CUDA schlicht die erste Wahl, während AMDs Open-Source-Ansatz ROCm noch nicht wirklich überzeugt.

Ob AMD wirklich an einem „CUDA Killer“ arbeitet, wie kürzlich Seeking Alpha berichtet hat, bleibt abzuwarten. Mit Sicherheit ist die Software aber die größte Baustelle bei AMD, wie auch der bekannte Software-Entwickler George Hotz alias „geohot“ jüngst wieder einmal feststellte. heise online schreibt, dass Hotz daher sein eigenes KI-Framework tinygrad für AMDs Rechenbeschleuniger anpasst. Hotz wurde vor Jahren für den ersten iPhone-Hack bekannt und hatte 2015 die Firma Comma.ai für autonomes Fahren gegründet.