Warum denken eigentlich immer alle, dass das nur ein E-Penis Vergleich ist? Jedes Land kann sich teherotisch einen Rechner mit einer beliebigen rechenleistung hinstellen, es ist alles nur eine Frage des Kosten / Nutzen Faktors. Es gehört kein technologischer Vorsprung einer Nation dazu, einen großen Rechencluster hinzustellen.

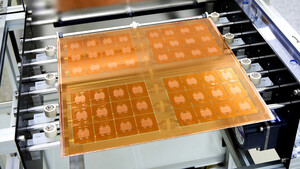

Und so Neu ist die Idee mit den GPUs für die neuen Ammirechner auch nicht... Der Titan (ja es gibt auch einen Rechner mit dem Namen) bezieht ja auch ein großteil seiner rechenleistung aus den GK110 Tesla K20x Grafikkarten).

Die Anwendungsbereiche sind ziemlich vielseitig. Hauptsächlich werden diese Rechner für Simulationen genutzt. Die Klimaforschung basiert zum Größtenteilen aus Simulationen. Die Automobilbranche kann damit Materialberechnungen, Crashtests, physikalische Verhaltensmuster etc. berechnen. Die Ammis berechnen darauf auch ihre Atombomben tests. Materialforschung etc. Die Anwendungsbereiche sind vielseitig.

In den USA dürften auch Geheimdienste und das Militär dankbare Abnehmer sein. Die NSA kann mit solchen Rechnern (Wobei ich mir fast sicher bin, dass die ihre ganz eigenen rechenanlagen haben) Verschlüsselungen versuchen zu knacken, das Militär nutzt Superrechner zur auswertung von Satellitenbildern, Kommunikationsverarbeitung etc. Auch in der Medizin sind diese Anlagen wichtig. Proteinstrukturen werden verglichen (kennen vielleicht noch einige vom Folding @ Home Projekt), Genproben verglichen und solche Dinge. Selbst die Unterhaltungsindustrie hat daran interesse. Kinofilme werden auf ähnlichen Anlagen gerendert. Der Rendering Rechner auf dem zum beispiel Avatar gerendert wurde, befand sich damals auch unter der Top 500 Liste.

Ich finde es aber schon echt krass, dass man heutige Hardware kaufen kann, die theoretisch ein vielfaches der Rechenleistung von ehemaligen Superrechnen haben, Der schnellste Rechner aus dem Jahr 2000 leistete zum beispiel ca 7,2 TFlops. Mit einem einzigsten übertakteten GK110 Grafikchip kann man zumindest bei einfacher genauigkeit leicht in diese leistungsregionen vordringen. Ein Vollausgebauter GK110 leistet bei ca 1300mhz (was viele dieser Chips durchaus leisten) rein rechnerisch bereits fast 7,7 TFLOPS. Natürlich ist das nur sehr theoretisch, aber es zeigt doch ganz gut, dass die Entwicklung wirklich krasse Ausmaße annimmt...