Z

ZeroStrat

Gast

Der User @Ned Flanders hat einen besonderen Tweak entdeckt, der die Leistung auf Ryzen Systemen drastisch verbessert, wenn Intel's MKL zum Einsatz kommt.

Nähere Infos + eine Anleitung siehe hier: https://www.techpowerup.com/261241/...oosts-amd-ryzen-mkl-performance-significantly

Der Originalartikel bei reddit ist hier zu finden: https://www.reddit.com/r/matlab/comments/dxn38s/howto_force_matlab_to_use_a_fast_codepath_on_amd/

Der Thread soll dazu dienen, unterschiedliche Benchmarks zusammenzutragen. Dabei soll sich nicht nur auf Matlab beschränkt werden. Python ist wohl ebenso betroffen.

Ihr seid herzlich eingeladen, eure Ergebnisse zu posten und den Sachverhalt zu diskutieren. Bitte kein Gebashe gegen Intel. Das ist ein Sachthread.

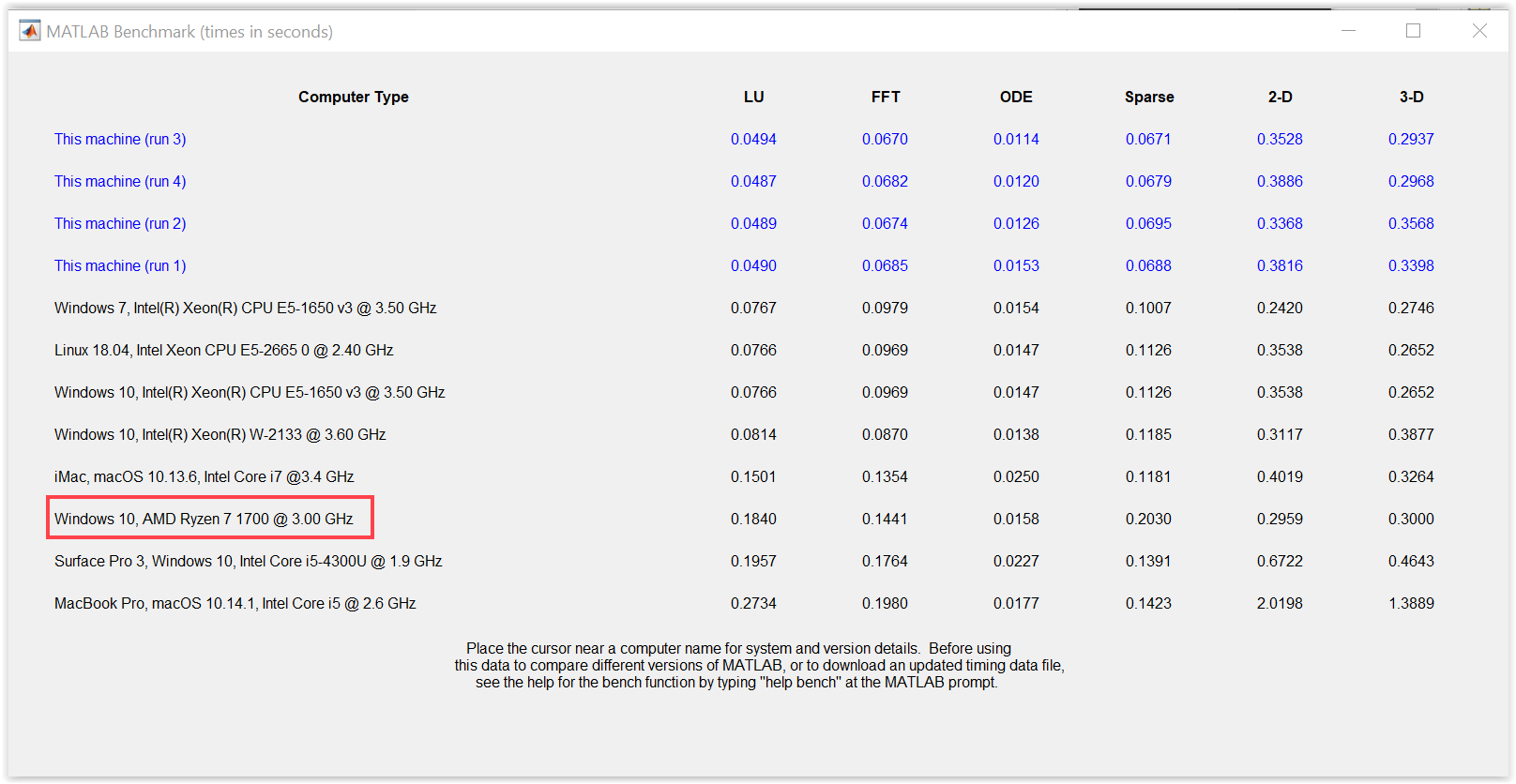

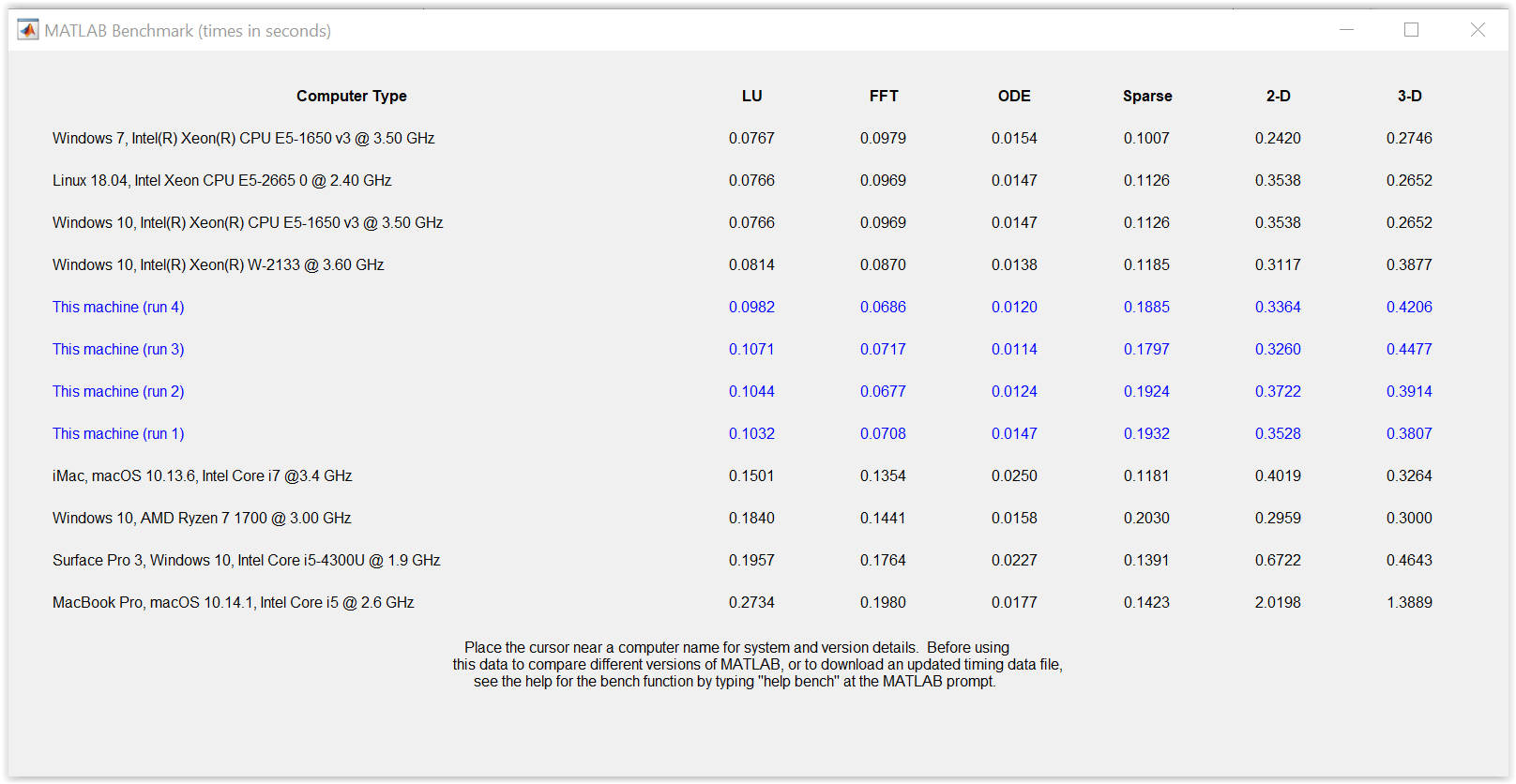

Ich habe als erstes den internen Benchmark von Matlab verwendet, welcher mit bench(n) aufgerufen wird.

Aktiver AVX2 Tweak R9 3900X@stock:

Kein AVX2 Tweak R9 3900X@stock:

Nähere Infos + eine Anleitung siehe hier: https://www.techpowerup.com/261241/...oosts-amd-ryzen-mkl-performance-significantly

Der Originalartikel bei reddit ist hier zu finden: https://www.reddit.com/r/matlab/comments/dxn38s/howto_force_matlab_to_use_a_fast_codepath_on_amd/

Der Thread soll dazu dienen, unterschiedliche Benchmarks zusammenzutragen. Dabei soll sich nicht nur auf Matlab beschränkt werden. Python ist wohl ebenso betroffen.

Ihr seid herzlich eingeladen, eure Ergebnisse zu posten und den Sachverhalt zu diskutieren. Bitte kein Gebashe gegen Intel. Das ist ein Sachthread.

Ergänzung ()

Ich habe als erstes den internen Benchmark von Matlab verwendet, welcher mit bench(n) aufgerufen wird.

Aktiver AVX2 Tweak R9 3900X@stock:

Kein AVX2 Tweak R9 3900X@stock:

Zuletzt bearbeitet von einem Moderator: