Echt? Meine RTX 3070 war mit optimierten ~145W immer noch so schnell wie eine stock RTX 3070.Piecemaker schrieb:Mit 160 Watt landest du unter 3060 Ti Niveau.

Wie @HisN schon desöfteren angeführt hat...max bedeutet all in...und dafür sind die Grafikkarten einfach zu schwach. Es wird immer eine Einstellung geben die eine Grafikkarte in die Knie zwingt.

Ausserdem haben Spiele mit den Reglern ein mächtiges Werkzeug, mit denen man Spiele auch ohne Augenkrebs spielen kann. Den Verbrauch drückt man so ganz nebenbei.

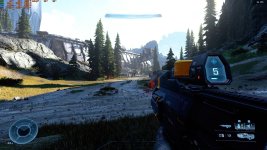

Einmal Stock....nur Karte optimiert....Spiel und Karte optimiert

Wenn Cyberpunk für Dich ausschlaggebend ist würde ich über Karten unter einer RTX 4070 nicht nachdenken.

Da muss man für ~600€ noch die wenigsten Kompromisse eingehen.

Zuletzt bearbeitet: