Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Schöner Spielen mit HDR: Benchmarks zeigen geringere Leistung auf AMD und Nvidia

Mcr-King

Vice Admiral

- Registriert

- Juli 2016

- Beiträge

- 7.092

Richtig ein HDR 600 Display kann nicht auf einmal HDR1000 ausgeben dass funktioniert nicht. Bei HZ kann man Manuell uber SW was machen und Freesync ist Vesa Standard genauso wie HDR, ausser NV die haben keine Vesa Standards weder Sync noch HDR noch SDR.

Ohne jetzt die 10 Seiten Walltext von Hardware_Hoshi im Detail zu zitieren werfe ich mal ein:

Die Ausgabehelligkeit des Displays hat doch nichts aber auch gar nichts mit der Anzahl der Farben zu tun die die GPU berechnet.

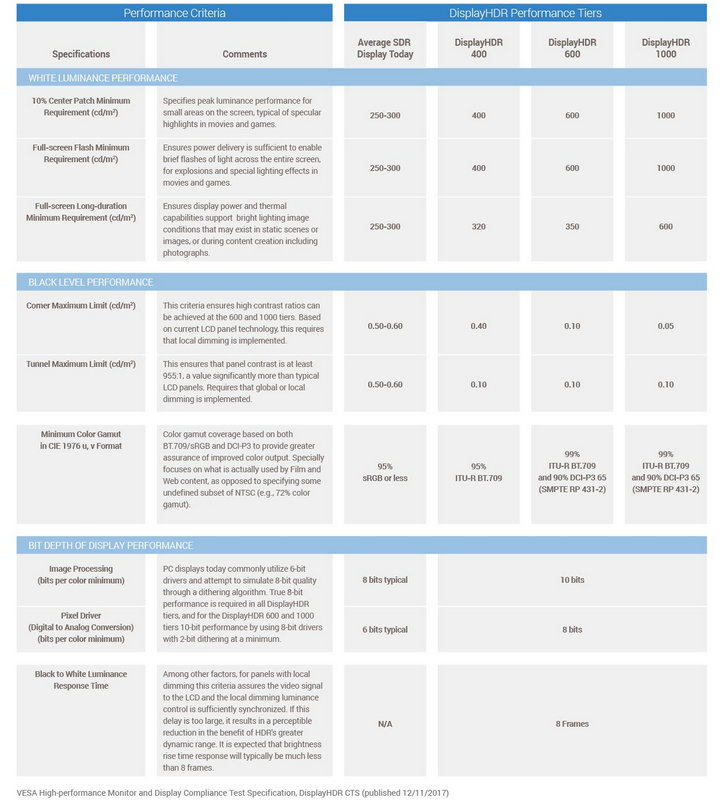

ALLE HDR-Standards rechnen mit 10bit Farbtiefe. Behauptet zumindest die VESA:

siehe die Einträge bei "bit depth of display performance".

Genau diese 10bit-Farbtiefe müssen a) berechnet werden und b) übertragen werden zum Display (weshalb es eben Stand Display Port 1.4 und HDMI 2.0 auch keine 144Hz -HDR10bit Displays GEBEN KANN da die Übertragungsraten nicht ausreichen).

https://displayhdr.org/performance-criteria/

Die relative Helligkeit und Brillianz der Darstellung des Displays hängt absolut GAR Nicht performancetechnisch davon ab was die GPU zu liefern hat. HDR-10bit = HDR 10bit (für die GPU).

Der Rest ist was das Display macht. Da hier aber das identische Display benutzt wurde und auch ALLE HDR-Varianten mit 10bit zu rendern bleibt also die Frage bricht nVidia hier ein weil die GPU-Bandbreite wegen des ca 25% höheren Aufwands eben nicht mehr reicht ? Oder hat es andere Gründe.

Davon abgekoppelt müsste man dann noch die BQ analysieren. Sind die HDR-Bilder die nVidia und AMD liefert auch "gleich".

Wiederum davon abgekoppelt muss man dann noch vergleichen welche Unterschiede durch die Unterschiedlichen Displays und Sub-Typen von HDR zu tage treten im DARGESTELLTEN Bild (im berechneten Bild darf hier eigentlich nichts anders sein da alle sub-typen 10bit Farbtiefe verlangen !)

Nachtrag:

Übrigens KEINER der G-Sync displays hier erfüllt den von dir dargelegente Fall dass er HDR-1000 kann....soviel zur Überlegenheit des G-Sync HDR-Standard den du oben propagierst.

https://www.computerbase.de/preisve...59_10bit+(10bit+ohne+FRC)~11992_NVIDIA+G-Sync

denn die Displays haben nur 300cd/m2 Leuchtstärke. (Was IMO eh völlig reicht wenn man sich nicht die Augen wegbrennen will - die 600cd aus dem Standard der VESA sind doch völliger overkill)...Zuhause korrigiert man dann die Display Helligkeit auf 10% runter damit einem nicht die Augen weh tun wenn da 600cd/m2 anliegen.

Die Ausgabehelligkeit des Displays hat doch nichts aber auch gar nichts mit der Anzahl der Farben zu tun die die GPU berechnet.

ALLE HDR-Standards rechnen mit 10bit Farbtiefe. Behauptet zumindest die VESA:

siehe die Einträge bei "bit depth of display performance".

Genau diese 10bit-Farbtiefe müssen a) berechnet werden und b) übertragen werden zum Display (weshalb es eben Stand Display Port 1.4 und HDMI 2.0 auch keine 144Hz -HDR10bit Displays GEBEN KANN da die Übertragungsraten nicht ausreichen).

https://displayhdr.org/performance-criteria/

Die relative Helligkeit und Brillianz der Darstellung des Displays hängt absolut GAR Nicht performancetechnisch davon ab was die GPU zu liefern hat. HDR-10bit = HDR 10bit (für die GPU).

Der Rest ist was das Display macht. Da hier aber das identische Display benutzt wurde und auch ALLE HDR-Varianten mit 10bit zu rendern bleibt also die Frage bricht nVidia hier ein weil die GPU-Bandbreite wegen des ca 25% höheren Aufwands eben nicht mehr reicht ? Oder hat es andere Gründe.

Davon abgekoppelt müsste man dann noch die BQ analysieren. Sind die HDR-Bilder die nVidia und AMD liefert auch "gleich".

Wiederum davon abgekoppelt muss man dann noch vergleichen welche Unterschiede durch die Unterschiedlichen Displays und Sub-Typen von HDR zu tage treten im DARGESTELLTEN Bild (im berechneten Bild darf hier eigentlich nichts anders sein da alle sub-typen 10bit Farbtiefe verlangen !)

Nachtrag:

Mustis schrieb:Die Gsync HDR Monitore benutzen Vesa HDR 1000. Immer.

Übrigens KEINER der G-Sync displays hier erfüllt den von dir dargelegente Fall dass er HDR-1000 kann....soviel zur Überlegenheit des G-Sync HDR-Standard den du oben propagierst.

https://www.computerbase.de/preisve...59_10bit+(10bit+ohne+FRC)~11992_NVIDIA+G-Sync

denn die Displays haben nur 300cd/m2 Leuchtstärke. (Was IMO eh völlig reicht wenn man sich nicht die Augen wegbrennen will - die 600cd aus dem Standard der VESA sind doch völliger overkill)...Zuhause korrigiert man dann die Display Helligkeit auf 10% runter damit einem nicht die Augen weh tun wenn da 600cd/m2 anliegen.

Zuletzt bearbeitet:

(quote vergessen)

r4yn3

Admiral

- Registriert

- Mai 2006

- Beiträge

- 7.685

Da man ja immer die zu geringe Bandbreite als Schuldigen sieht, könnte man nicht hier einfach den Speicher runtertakten und ansehen ob die Leistung im Vergleich zum SDR Leistungsverlust im HDR Modus überproportional niedriger ausfällt?

Oder habe ich hier einen Denkfehler?

Sprich -10% Takt, -1% Leistung bei SDR, -10% bei HDR?

Oder habe ich hier einen Denkfehler?

Sprich -10% Takt, -1% Leistung bei SDR, -10% bei HDR?

Hier: darum geht es doch bei Games Und GPUs:

https://de.wikipedia.org/wiki/High_Dynamic_Range_Rendering

"HDRR als Technologie für Computerspiele wurde etwa zeitgleich mit dem Shader Model 3.0 von DirectX verfügbar. Allerdings haben diese beiden Technologien nur wenig miteinander zu tun, was sich z. B. daran zeigt, dass theoretisch jede DirectX-9-Grafikkarte in der Lage ist, die HDRR-Effekte darzustellen: Jede DirectX-9-Grafikkarte muss im Pixel-Shader intern mindestens 24 Bit pro Farbkanal unterstützen („FP24“) und Texturen mit 32 Bit pro Farbkanal („FP32“) einlesen können, was jedoch auf älteren Karten zu deutlichen Leistungseinbrüchen führen würde. "

Die Frage ist nun also OB diese Leistungseinbrüche bei nVidia irgendwie damit zusammenhängen...

Beim "klassisschen" 8bit Farbraum für SDR gibt es eben 8bit die die Farbe kodieren:

http://alt.3dcenter.org/artikel/2006/01-01_b.php

Bitte vor allem den unteren Teil lesen wo dann auf die Details beim HDR-Rendering eingegangen wird (und das zu Zeiten von PixelShader 3.0).

"Mit 64-Bit-Rendering lassen sich viele Probleme lösen. Die Bitstellen haben wir nun, aber welches Datenformat wäre zu empfehlen? Für die Dynamik sind Gleitkomma-Formate günstiger als Festkomma-Formate, weshalb man zukünftig im gleichen Zuge auf die aufwändigen Gleitkomma-Units setzen wird. Seit NV40 (GeForce 6800) bzw. R520 (Radeon X1800) werden entsprechende Render-Target (mit Blending-Operationen) unterstützt. Dabei ist das viel aufwändiger, als würde man Festkomma-Daten bieten. Warum dieser Aufwand?

Der durschnittliche Rundungsfehler im Festpunkt-Format ist, absolut gesehen, immer gleich groß. Doch stört er bei kleinen Zahlen viel mehr, da die relative Abweichung dann sehr groß ist. Im Gleitkomma-Format ist der durchschnittliche relative Rundungsfehler viel gleichmäßiger verteilt. Damit wird auch das durch die unvermeidlichen Rundungsfehler hervorgerufene Rauschen gleichmäßig verteilt und tritt nicht etwa nur im Dunklen, dort aber besonders krass, zutage (einen ähnlichen Effekt kann man auch bei Digitalkameras beobachten: Hellt man dunkle Bereiche der Fotos auf, sieht man starkes Rauschen). Durch die gleichmäßigere Verteilung des Rundungsfehlers beim HDR-Rendering mit Nutzung eines Gleitkomma-Formates steigt die Chance, dass das Rauschen, jetzt etwa gleich stark im Hellen wie im Dunklen, gänzlich unsichtbar wird.

Wird ein im HDR-Format vorliegendes Bild zur Monitor-Ausgabe auf LDR-Darstellung komprimiert, sinkt auch das während der Berechnung auftretende Rauschen. Das endgültige Bild ist um vieles besser als wenn es gleich als monitortaugliches LDR-Format errechnet würde. Deswegen bringt HDR-Rendering auch dann klare Vorteile, wenn man nur einen gewöhnlichen LDR-Monitor benutzt."

EDIT: Nachtrag:

Um eben auf "echte" 10bit Farbraum zu kommen muss intern in der GPU mit einem höheren Farbraum gerechnet werden. Durchs Tone-Mapping wird dieser dann auf das weiterruntergerechnet was der Monitor ausgeben kann.

Um 10bit pro Farbe zu erreichen müsste man also intern mit 3x10 bit =30Bit Floats arbeiten - da man aber noch weitere 8bit für die Helligkeitswerte selbst braucht) kommt man bei SDR-8bit-"Farbraum" auf 4x8 = 32bit Float-Precision die minimum notwendig ist.

Für 10bit-HDR braucht man mindestens 3x10bit+x bit für die Helligkeit....wenn diese auch noch erhöht werden solle auf 10bit sind wir bei 4x10 bit = FP40...

Es gibt nun bei GPUs aber nur Stufen FP8, FP16, FP32, FP64...rat mal welche GPUs beson

=> für HDR-R mit mind. 10bit Farbrraum wird eine GPU FP64 nutzen müssen anstelle von FP32 wie es für SDR "reicht". (4x8 = 32)

https://de.wikipedia.org/wiki/High_Dynamic_Range_Rendering

"HDRR als Technologie für Computerspiele wurde etwa zeitgleich mit dem Shader Model 3.0 von DirectX verfügbar. Allerdings haben diese beiden Technologien nur wenig miteinander zu tun, was sich z. B. daran zeigt, dass theoretisch jede DirectX-9-Grafikkarte in der Lage ist, die HDRR-Effekte darzustellen: Jede DirectX-9-Grafikkarte muss im Pixel-Shader intern mindestens 24 Bit pro Farbkanal unterstützen („FP24“) und Texturen mit 32 Bit pro Farbkanal („FP32“) einlesen können, was jedoch auf älteren Karten zu deutlichen Leistungseinbrüchen führen würde. "

Die Frage ist nun also OB diese Leistungseinbrüche bei nVidia irgendwie damit zusammenhängen...

Beim "klassisschen" 8bit Farbraum für SDR gibt es eben 8bit die die Farbe kodieren:

http://alt.3dcenter.org/artikel/2006/01-01_b.php

Bitte vor allem den unteren Teil lesen wo dann auf die Details beim HDR-Rendering eingegangen wird (und das zu Zeiten von PixelShader 3.0).

"Mit 64-Bit-Rendering lassen sich viele Probleme lösen. Die Bitstellen haben wir nun, aber welches Datenformat wäre zu empfehlen? Für die Dynamik sind Gleitkomma-Formate günstiger als Festkomma-Formate, weshalb man zukünftig im gleichen Zuge auf die aufwändigen Gleitkomma-Units setzen wird. Seit NV40 (GeForce 6800) bzw. R520 (Radeon X1800) werden entsprechende Render-Target (mit Blending-Operationen) unterstützt. Dabei ist das viel aufwändiger, als würde man Festkomma-Daten bieten. Warum dieser Aufwand?

Der durschnittliche Rundungsfehler im Festpunkt-Format ist, absolut gesehen, immer gleich groß. Doch stört er bei kleinen Zahlen viel mehr, da die relative Abweichung dann sehr groß ist. Im Gleitkomma-Format ist der durchschnittliche relative Rundungsfehler viel gleichmäßiger verteilt. Damit wird auch das durch die unvermeidlichen Rundungsfehler hervorgerufene Rauschen gleichmäßig verteilt und tritt nicht etwa nur im Dunklen, dort aber besonders krass, zutage (einen ähnlichen Effekt kann man auch bei Digitalkameras beobachten: Hellt man dunkle Bereiche der Fotos auf, sieht man starkes Rauschen). Durch die gleichmäßigere Verteilung des Rundungsfehlers beim HDR-Rendering mit Nutzung eines Gleitkomma-Formates steigt die Chance, dass das Rauschen, jetzt etwa gleich stark im Hellen wie im Dunklen, gänzlich unsichtbar wird.

Wird ein im HDR-Format vorliegendes Bild zur Monitor-Ausgabe auf LDR-Darstellung komprimiert, sinkt auch das während der Berechnung auftretende Rauschen. Das endgültige Bild ist um vieles besser als wenn es gleich als monitortaugliches LDR-Format errechnet würde. Deswegen bringt HDR-Rendering auch dann klare Vorteile, wenn man nur einen gewöhnlichen LDR-Monitor benutzt."

EDIT: Nachtrag:

Um eben auf "echte" 10bit Farbraum zu kommen muss intern in der GPU mit einem höheren Farbraum gerechnet werden. Durchs Tone-Mapping wird dieser dann auf das weiterruntergerechnet was der Monitor ausgeben kann.

Um 10bit pro Farbe zu erreichen müsste man also intern mit 3x10 bit =30Bit Floats arbeiten - da man aber noch weitere 8bit für die Helligkeitswerte selbst braucht) kommt man bei SDR-8bit-"Farbraum" auf 4x8 = 32bit Float-Precision die minimum notwendig ist.

Für 10bit-HDR braucht man mindestens 3x10bit+x bit für die Helligkeit....wenn diese auch noch erhöht werden solle auf 10bit sind wir bei 4x10 bit = FP40...

Es gibt nun bei GPUs aber nur Stufen FP8, FP16, FP32, FP64...rat mal welche GPUs beson

=> für HDR-R mit mind. 10bit Farbrraum wird eine GPU FP64 nutzen müssen anstelle von FP32 wie es für SDR "reicht". (4x8 = 32)

Zuletzt bearbeitet:

M

Mustis

Gast

Iscaran schrieb:Übrigens KEINER der G-Sync displays hier erfüllt den von dir dargelegente Fall dass er HDR-1000 kann....soviel zur Überlegenheit des G-Sync HDR-Standard den du oben propagierst.

https://www.computerbase.de/preisve...59_10bit+(10bit+ohne+FRC)~11992_NVIDIA+G-Sync

denn die Displays haben nur 300cd/m2 Leuchtstärke. (Was IMO eh völlig reicht wenn man sich nicht die Augen wegbrennen will - die 600cd aus dem Standard der VESA sind doch völliger overkill)...Zuhause korrigiert man dann die Display Helligkeit auf 10% runter damit einem nicht die Augen weh tun wenn da 600cd/m2 anliegen.

Vll liegt es daran, dass es eben nur G-Sync Monitore sind und keine G-Sync HDR Monitore...

Die Gsync-HDR Monitore erfüllen die Vesa HDR 1000 Specs jedenfalls: https://geizhals.de/?cat=monlcd19wide&xf=13219_NVIDIA+G-Sync+HDR

Zudem darf man sich gerne auch informieren, G-Sync HDR setzt als Mindeststandard den VESA HDR 1000 vor raus. Ansonsten gibt es keine G-Sync HDR Label...

Ansonsten hast du nicht verstanden, was HDR ist, wie es funktioniert und warum 600 bzw. 1000cd wichtig dafür sind, dass es funktioniert. Es geht hier keineswegs darum, dass die Monitore dauerhaft mit 600 oder 1000 cd leuchten.

@r4yn3 interessante Idee !

Das könnte ein guter Hinweis sein ob hier tatsächlich AMD auch in SDR quasi immer nativ mit 64bit Farbindex rechnet und nVidia z.B. eben nur mit 48bit...

Bei HDR müssen es bei beiden ja 64bit (oder mehr sein). Durch die Verwendung höherer Gleitkommagenauigkeit steigt vor allem der Bedarf an Bandbreite, damit sollte es eigentlich ziemlich genau so sein wie du schreibst.

@Mustis die beiden Monitore von dir sind aber auch keine HDR-1000 Monitore (da sie keine 10bit farbtiefe nutzen, zumindest der Asus ROG simuliert 10bit nur mittel 8bit + FRC):

https://geizhals.de/asus-rog-swift-pg27uq-90lm03a0-b01370-a1571346.html?hloc=at&hloc=de

Farbtiefe 10bit (8bit mit FRC)

Beim Predator schweigen sich die Specs darüber aus welche echte Farbtiefe benutzt wird: https://geizhals.de/acer-predator-x27bmiiphzx-um-hx0ee-009-a1615513.html?hloc=at&hloc=de

Diese Monitore haben wenigstens laut Spec echte 10bit farbtiefe:

https://www.computerbase.de/preisvergleich/?cat=monlcd19wide&v=l&hloc=de&sort=t&xf=11959_10bit+(10bit+ohne+FRC)~11992_NVIDIA+G-Sync

Das habe ich sehr wohl, deswegen ist die Diskussion ob die Performance hier einbricht wegen HDR auch "völlig" losgelöst von Display XYZ....

Was die GPU intern rendert ist hier die Kernfrage, und nicht wie gut oder schlecht ein Display das gerendert dann tatsächlich "farbgetreu" darstellt !

Das könnte ein guter Hinweis sein ob hier tatsächlich AMD auch in SDR quasi immer nativ mit 64bit Farbindex rechnet und nVidia z.B. eben nur mit 48bit...

Bei HDR müssen es bei beiden ja 64bit (oder mehr sein). Durch die Verwendung höherer Gleitkommagenauigkeit steigt vor allem der Bedarf an Bandbreite, damit sollte es eigentlich ziemlich genau so sein wie du schreibst.

Ergänzung ()

@Mustis die beiden Monitore von dir sind aber auch keine HDR-1000 Monitore (da sie keine 10bit farbtiefe nutzen, zumindest der Asus ROG simuliert 10bit nur mittel 8bit + FRC):

https://geizhals.de/asus-rog-swift-pg27uq-90lm03a0-b01370-a1571346.html?hloc=at&hloc=de

Farbtiefe 10bit (8bit mit FRC)

Beim Predator schweigen sich die Specs darüber aus welche echte Farbtiefe benutzt wird: https://geizhals.de/acer-predator-x27bmiiphzx-um-hx0ee-009-a1615513.html?hloc=at&hloc=de

Diese Monitore haben wenigstens laut Spec echte 10bit farbtiefe:

https://www.computerbase.de/preisvergleich/?cat=monlcd19wide&v=l&hloc=de&sort=t&xf=11959_10bit+(10bit+ohne+FRC)~11992_NVIDIA+G-Sync

Ergänzung ()

Ansonsten hast du nicht verstanden, was HDR ist, wie es funktioniert ...

Das habe ich sehr wohl, deswegen ist die Diskussion ob die Performance hier einbricht wegen HDR auch "völlig" losgelöst von Display XYZ....

Was die GPU intern rendert ist hier die Kernfrage, und nicht wie gut oder schlecht ein Display das gerendert dann tatsächlich "farbgetreu" darstellt !

Zuletzt bearbeitet:

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.136

HDR600 oder 1000 ?

Für die meisten User reicht HDR600 aus.

Bsp. mein Moni:

http://www.guru3d.com/articles_pages/samsung_c32hg70_freesync_2_hdr_monitor_review,1.html

Zugunsten des P/L reichen auch die Dimmingzonen vollkommen aus.(siehe Verdict im lnk)

Fakt = der CHG70 ist bereits > 1Jahr verfügbar. (passend zu Vega56) = im Paket 2017 =1000€ !!! (1399 bei Cf)

Gsync-HDR ist überteuert und kaum verfügbar. (Turing ist noch nicht verfügbar) = Paket = MONDPREIS

Die "Theorien" zu verminderten Berechnungen mit AMD-HDR1000 sind für mich mit HDR600 nicht praxisrel., die Unfähigkeit von Pascal schon. Alle Besitzer einer SWBF2-StarwarsEdition sollten Lederjacke verklagen.

Gedi hatte damals vor allem auch der Temp.anstieg bei seiner Ti gestört. - CB bitte messen -

Für die meisten User reicht HDR600 aus.

Bsp. mein Moni:

http://www.guru3d.com/articles_pages/samsung_c32hg70_freesync_2_hdr_monitor_review,1.html

Zugunsten des P/L reichen auch die Dimmingzonen vollkommen aus.(siehe Verdict im lnk)

Fakt = der CHG70 ist bereits > 1Jahr verfügbar. (passend zu Vega56) = im Paket 2017 =1000€ !!! (1399 bei Cf)

Gsync-HDR ist überteuert und kaum verfügbar. (Turing ist noch nicht verfügbar) = Paket = MONDPREIS

Die "Theorien" zu verminderten Berechnungen mit AMD-HDR1000 sind für mich mit HDR600 nicht praxisrel., die Unfähigkeit von Pascal schon. Alle Besitzer einer SWBF2-StarwarsEdition sollten Lederjacke verklagen.

Gedi hatte damals vor allem auch der Temp.anstieg bei seiner Ti gestört. - CB bitte messen -

Zuletzt bearbeitet:

Hardware_Hoshi

Lt. Commander

- Registriert

- Jan. 2008

- Beiträge

- 1.478

Iscaran schrieb:Für 10bit-HDR braucht man mindestens 3x10bit+x bit für die Helligkeit....wenn diese auch noch erhöht werden solle auf 10bit sind wir bei 4x10 bit = FP40...

Es gibt nun bei GPUs aber nur Stufen FP8, FP16, FP32, FP64...rat mal welche GPUs beson

=> für HDR-R mit mind. 10bit Farbrraum wird eine GPU FP64 nutzen müssen anstelle von FP32 wie es für SDR "reicht". (4x8 = 32)

Demnach würde Vega die FP64-Fähigkeiten für HDR nutzen, während Nvidia aufgrund fehlender FP64-Fähigkeit der Geforce-Serie die Berechnungen dann in FP32 die Extrarunde drehen lassen. Also demnach mehr Rechenaufwand für die Geforce und damit Performanceverlust.

Das wäre bisher noch die logischste Erklärung. Falls ware hätten wir hier eine technisch messbare Einflussgröße.

GerryB schrieb:HDR600 oder 1000 ?

Für die meisten User reicht HDR600 aus.

Bsp. mein Moni:

http://www.guru3d.com/articles_pages/samsung_c32hg70_freesync_2_hdr_monitor_review,1.html

Zugunsten des P/L reichen auch die Dimmingzonen vollkommen aus.(siehe Verdict im lnk)

Es fehlt noch an Langzeiterfahrung und Material für HDR. Die HDR-Stufe hängt auch von den Entwicklern ab. Bauen die Studios z.b. viele Gegenlichtaufnahmen oder hell/dunkel-Wechsel ein, kann sich das alles blitzschnell ändern.

Preis-/Leistung mag ein Kriterium sein. HDR-600 wird oft von vielen Testseiten als minimum für HDR genannt. Bei einer solchen Pioniertechnik wie HDR ist die Bewertung schwierig. Wartet man auf bessere Technik oder geht man als early Adopter blind ins Rennen. Die PC-Fraktion sieht mit neidischen Blicken auf die 10.000 Nits von Dolby Vision im TV-Sektor.

Im klassichen HDTV hatte 16 Millionen Farben. HDR erweitert dies auf über eine Milliarde. Wenn man den Unterschied live sieht, möchte man nicht mehr zurück. Wieviel einem Gamer das selbst wert ist, muss jeder für sich selbst entscheiden.

GerryB schrieb:Die "Theorien" zu verminderten Berechnungen mit AMD-HDR1000 sind für mich mit HDR600 nicht praxisrel., die Unfähigkeit von Pascal schon.

Wenn du von Unfähigkeit sprichst, musst du den Bereich auch nennen, der Unfähig ist. Was ist unfähig und warum ist das so? Ich würde gerne wissen auf was man hier achten sollte.

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.136

@hoshi

Wenn z. Bsp. bei mir Erfahrung seit Nov.2017 nicht reicht , wie lang denn noch ?

Komm mal in die Puschen. Wahrscheinlich noch nie selbst HDR benutzt. Da sind Deine Theorien auch nix wert.

Alle Reviews zu dem Moni haben keine Auffälligkeiten festgestellt. Und mir gefällst.

Pascal kann seine Performance nicht halten = unfähig.

User sprachen auch von laggy Handling z.Bsp. in SWBF2. Und wenn dann die Temps auch schlechter werden, kann das im Wohnzimmer schon stören.

Wenn z. Bsp. bei mir Erfahrung seit Nov.2017 nicht reicht , wie lang denn noch ?

Komm mal in die Puschen. Wahrscheinlich noch nie selbst HDR benutzt. Da sind Deine Theorien auch nix wert.

Alle Reviews zu dem Moni haben keine Auffälligkeiten festgestellt. Und mir gefällst.

Pascal kann seine Performance nicht halten = unfähig.

User sprachen auch von laggy Handling z.Bsp. in SWBF2. Und wenn dann die Temps auch schlechter werden, kann das im Wohnzimmer schon stören.

Zuletzt bearbeitet:

Hardware_Hoshi

Lt. Commander

- Registriert

- Jan. 2008

- Beiträge

- 1.478

GerryB schrieb:@hoshi

Wenn z. Bsp. bei mir Erfahrung seit Nov.2017 nicht reicht , wie lang denn noch ?

HDR ist nach wie vor nicht sonderlich verbreitet. Liegt mitunter an einer relativ kleinen Anzahl an verfügbaren Bildschirmen und nur einer handvoll gute HDR-fähiger Spiele.

Es wird wohl noch 2-3 Jahre dauern bis die Masse auf HDR umschenkt.

GerryB schrieb:Komm mal in die Puschen. Wahrscheinlich noch nie selbst HDR benutzt. Da sind Deine Theorien auch nix wert.

Alle Reviews zu dem Moni haben keine Auffälligkeiten festgestellt. Und mir gefällst.

Klar, bei deinem genannten Samsung C32HG70 ... wie soll ich es sagen. Bei 2560x1440 haben viele wohl aufgehört zu lesen. Ist ja schon fast retro für manche Gamer.

Komm mit 3440x1440, 4k oder einer bliebigen UWQHD-Auflösung dazwischen. Danach suchen Aufrüstwillige im Monitorbereich zurzeit. HDR treibt momentan eher den Preis, weil es ein Luxusfeature ist.

GerryB schrieb:Pascal kann seine Performance nicht halten = unfähig.

Bei Vega würde ich mich nicht zu weit aus dem Fenster lehnen. Ein Riesenchip, der seine Performance nicht halten kann ... wie gut, dass Vega jetzt mit HDR wenigstens ein funktionierendes Feature hat.

Lassen wir beide die Polemik sein! Ich hatte nach einer technischen Erklärung gefragt.

Demnach würde Vega die FP64-Fähigkeiten für HDR nutzen, während Nvidia aufgrund fehlender FP64-Fähigkeit der Geforce-Serie die Berechnungen dann in FP32 die Extrarunde drehen lassen. Also demnach mehr Rechenaufwand für die Geforce und damit Performanceverlust.

Das wäre bisher noch die logischste Erklärung. Falls ware hätten wir hier eine technisch messbare Einflussgröße

Korrekt. Technisch gemessen -10% AVG vs -1% avg.

Das das HDR-Display auch korrektes HDR anzeigt nehm ich jetzt mal als gesetzt und all die "Feinheiten" die diskutiert wurden ob nun Display XY G-S/F-S mit HDR400, 600 oder 1000 umsetzt etc. sind Feinheiten des Displays und in der Darstellung.

NICHTS davon würde sich auf die Rohleistung der GPU auswirken !

M

Mustis

Gast

Hier übrigens mal ne Liste, welcher Monitor welchen Standard erfüllt: https://displayhdr.org/certified-products/

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.136

@hoshi

Die techn. Erklärung für die Pascalschwäche ist die für HDR10 nicht zulässige Farbkompression.

Letztes Bsp. zur Erfahrung:

Crysis läuft im Fenstermodus mit HDR. (wieviele Jahre alt ? )

Ich gehe davon aus, daß die Programmierer und Grakahersteller genügend Zeit und Erfahrung hatten.

Lederjacke hat bewusst gespart an der Bandbreite und versucht zu tricksen. (MEA mit Half16)

Mir tuen nur die Käufer leid, die demnächst mal wieder wechseln müssen.

Wer aus 3,5+0,5 nicht schlau geworden ist, dem ist halt nicht zu helfen.

Die techn. Erklärung für die Pascalschwäche ist die für HDR10 nicht zulässige Farbkompression.

Letztes Bsp. zur Erfahrung:

Crysis läuft im Fenstermodus mit HDR. (wieviele Jahre alt ? )

Ich gehe davon aus, daß die Programmierer und Grakahersteller genügend Zeit und Erfahrung hatten.

Lederjacke hat bewusst gespart an der Bandbreite und versucht zu tricksen. (MEA mit Half16)

Mir tuen nur die Käufer leid, die demnächst mal wieder wechseln müssen.

Wer aus 3,5+0,5 nicht schlau geworden ist, dem ist halt nicht zu helfen.

@Mustis:

Ja OK der "Pixel Driver" muss nur 8bit + Dithering können....aber die Grundsätzliche Farbberechnung soll mit 10bit erfolgen. Das Display darf dann die "zuvielen" Farben mit 8bit +FRC etwas runterbrechen...

Das ist also ein Kompromiss den man dem Display zugesteht. Das Display kann aber aus 8Bit Input Farbkanal auch keine 10Bit (bzw. 8bit+FRC) zaubern.

=> Wenn die GPU keine 10bit-liefert ginge das nicht.

=> Warum brechen nVidia GPUs hier also ein wenn 10bit gefordert werden (pro Kanal)

=> Möglicherweise wegen der Erklärung von aths auf 3DC (aus dem Jahr 2010 !!!) bei HDR-R 2010 musste man damals auf FP32 gehen um überhaupt 8bit schon vollständig abzudecken.

Will man das auf 10bit Farbraum aufweiten muss man GPU-seitig auf FP64 gehen ! (oder ein Zwischending was aber kein Sinn macht).

FP64 ist das wovon Vega und Polaris (relativ zu Pascal) ÜPPIG über haben die "ungenutzt" verfallen.

=> Kein Performance drop.

EDIT:

Polaris RX580 hat ~370 (GFlops FP64)

Vega64 hat ~720-859

Pascal GTx1080 hat 257-288

Lies die VESA HDR Anforderungen normal durch. Die 8 Bit bei FRC sind genau das, was er vorgibt...

Ja OK der "Pixel Driver" muss nur 8bit + Dithering können....aber die Grundsätzliche Farbberechnung soll mit 10bit erfolgen. Das Display darf dann die "zuvielen" Farben mit 8bit +FRC etwas runterbrechen...

Das ist also ein Kompromiss den man dem Display zugesteht. Das Display kann aber aus 8Bit Input Farbkanal auch keine 10Bit (bzw. 8bit+FRC) zaubern.

=> Wenn die GPU keine 10bit-liefert ginge das nicht.

=> Warum brechen nVidia GPUs hier also ein wenn 10bit gefordert werden (pro Kanal)

=> Möglicherweise wegen der Erklärung von aths auf 3DC (aus dem Jahr 2010 !!!) bei HDR-R 2010 musste man damals auf FP32 gehen um überhaupt 8bit schon vollständig abzudecken.

Will man das auf 10bit Farbraum aufweiten muss man GPU-seitig auf FP64 gehen ! (oder ein Zwischending was aber kein Sinn macht).

FP64 ist das wovon Vega und Polaris (relativ zu Pascal) ÜPPIG über haben die "ungenutzt" verfallen.

=> Kein Performance drop.

EDIT:

Polaris RX580 hat ~370 (GFlops FP64)

Vega64 hat ~720-859

Pascal GTx1080 hat 257-288

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.136

@Mustis

Die Performance von Vega kannst Du Dir in den Vega-Foren anschauen. Da mit optimalen Settings.

Das gehört auch nicht unbedingt hierher.

Wenn Du mit der 1080 in 4k HDR spielen möchtest - gerne. Ist ja Deine Sache.

Aber ein NEU-Käufer sollte doch gewarnt werden, bevor er die Reste von Pascal günstig erwirbt.

Für die Konsolen ist 8-bit+FRC statt 10-bit wg. HDMI-Bandbreite nicht anders möglich gewesen.

Schönes WE.

Die Performance von Vega kannst Du Dir in den Vega-Foren anschauen. Da mit optimalen Settings.

Das gehört auch nicht unbedingt hierher.

Wenn Du mit der 1080 in 4k HDR spielen möchtest - gerne. Ist ja Deine Sache.

Aber ein NEU-Käufer sollte doch gewarnt werden, bevor er die Reste von Pascal günstig erwirbt.

Für die Konsolen ist 8-bit+FRC statt 10-bit wg. HDMI-Bandbreite nicht anders möglich gewesen.

Schönes WE.

M

Mustis

Gast

Wer jetzt neu kauft, sollte ohnehin auf die neue Generation warten oder auf günstigere Preise bei der jetzigen. Aber wo AMD jetzt hier ne brauchbare Alternative sein soll, wenn sie für mehr Geld auch unter HDR nur vergleichbare Leistung bringt, ist mir schleierhaft.

Ich selber habe eine 180TI und zocke auf WQHD. Danke für deine Sorge...

Ich selber habe eine 180TI und zocke auf WQHD. Danke für deine Sorge...

Ähnliche Themen

- Antworten

- 34

- Aufrufe

- 4.010

- Antworten

- 3

- Aufrufe

- 1.699

- Antworten

- 30

- Aufrufe

- 9.750

- Antworten

- 101

- Aufrufe

- 18.425

- Artikel

- Antworten

- 1

- Aufrufe

- 1.164