x.treme

Captain

- Registriert

- Sep. 2008

- Beiträge

- 3.099

Hallo zusammen,

ich nutze in meinem HP MiniPC eine 1TB Transcend TS1TMTE220S für Proxmox

Der Backup einer meiner virtuellen Maschinen führte immer reproduzierbar zu einem Systemabsturz aufgrund EA-Errors.

In den Logs findet sich folgender Fehler:

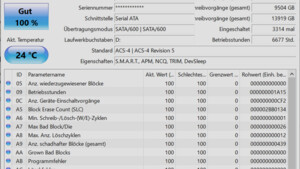

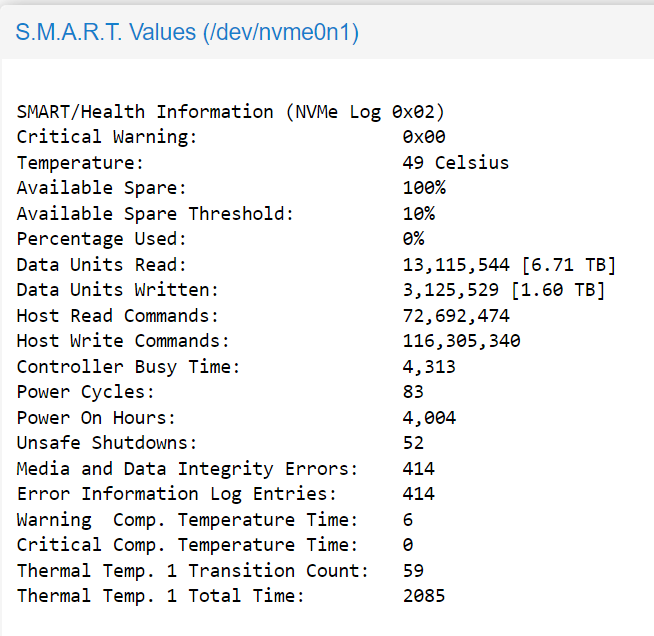

SMART gibt zwar "Passed" aus, aber es sind "Media and Data Integrity Errors" im Log.

Ich habe die betroffende VM gelöscht und durch ein Backup ersetzt - jetzt läuft wieder alles.

Aber kann ich die NVME überhaupt noch guten Gewissens verwenden?

Und falls nicht - was wäre eine alternative NVMe, die eine längere Lebensdauer (auch bei den ggf. problematischen Temperaturen in einem MiniPC) aufweist?

ich nutze in meinem HP MiniPC eine 1TB Transcend TS1TMTE220S für Proxmox

Der Backup einer meiner virtuellen Maschinen führte immer reproduzierbar zu einem Systemabsturz aufgrund EA-Errors.

In den Logs findet sich folgender Fehler:

Code:

nvme0n1: I/O Cmd(0x2) @ LBA 371154584, 136 blocks, I/O Error (sct 0x2 / sc 0x81) MORE

kernel: critical medium error, dev nvme0n1, sector 371154584 op 0x0:(READ) flags 0x80700 phys_seg 5 prio class 2SMART gibt zwar "Passed" aus, aber es sind "Media and Data Integrity Errors" im Log.

Ich habe die betroffende VM gelöscht und durch ein Backup ersetzt - jetzt läuft wieder alles.

Aber kann ich die NVME überhaupt noch guten Gewissens verwenden?

Und falls nicht - was wäre eine alternative NVMe, die eine längere Lebensdauer (auch bei den ggf. problematischen Temperaturen in einem MiniPC) aufweist?