RTX A6000 und A40: Nvidia bringt Ampere mit Vollausbau ins Profisegment

Zum Start der Herbst-Ausgabe der GPU Technology Conference (GTC) hat Nvidia das Ampere-Portfolio für professionelle Lösungen erweitert. Die aktiv gekühlte RTX A6000 ist dabei für den Einsatz in Workstations gedacht und die passive A40 für Server. Beide Varianten setzen auf den Vollausbau der GA102-GPU mit 10.752 CUDA-Cores.

Nach der Premiere der Ampere-Architektur als GA100-GPU und dem ersten davon abgeleiteten Produkt A100 für den Einsatz im Datacenter für das KI-Training und Inferencing im Mai, folgten im September die ersten Gaming-Ampere-Ableger in Form der GeForce RTX 3090, 3080 und 3070, bevor nun das Segment der professionellen Visualisierung mit einer ersten Grafikkarte und einer weiteren Server-Lösung auf Basis von Ampere bedient wird. Die ehemals Quadro genannten Grafikkarten kommen unter anderem beim 3D-Rendering (mit Raytracing), der Videobearbeitung oder KI-Berechnungen zum Einsatz. Mit der neuen Generation hat Nvidia den Namen Quadro aber abgelegt. Die beiden neuen Lösungen heißen schlicht RTX A6000 und A40.

RTX A6000 und A40 nutzen GA102-Vollausbau

Die erste Workstation-Grafikkarte der auf Basis von Ampere heißt RTX A6000, während die A40 für den Einsatz in einem Server gedacht ist – seit Nvidia die Bezeichnung „Tesla“ gestrichen hat, haben die Server-Varianten auch keinen erkennbaren Namen mehr. Die RTX A6000 wird aktiv gekühlt, während die A40 die passiv gekühlte Variante darstellt, die für Server entwickelt wurde und dort über den Luftstrom im Gehäuse gekühlt wird. Trotz der deutlich voneinander abweichenden Bezeichnungen vereint beide Ableger eine Eigenschaft: der Vollausbau der GA102-GPU, die auch die Basis der Spieler-Grafikkarten GeForce RTX 3090 und 3080 bildet, wenngleich sie dort teildeaktiviert genutzt wird.

Wie ComputerBase im Technik-Artikel zu Gaming-Ampere erklärt, sind bei der GA102-GPU selbst auf dem größten Ableger GeForce RTX 3090 innerhalb der 7 GPCs (Graphics Processor Cluster) mit je 12 SMs (Streaming Multiprocessors) insgesamt 2 SMs deaktiviert, sodass 10.496 FP32-ALUs, bei Nvidia CUDA-Cores genannt, zur Verfügung stehen. Diese Teildeaktivierung zugunsten einer höheren Chip-Ausbeute (Yield) gibt es bei RTX A6000 und A40 allerdings nicht, sodass in allen 7 GPCs jeweils die vollen 12 SMs zur Verfügung stehen, woraus sich insgesamt 10.752 CUDA-Cores (7 GPC * 12 SM * 128 ALU) ergeben. Deshalb gibt es mit 84 auch 2 zusätzliche Raytracing-Kerne der 2. Generation und mit 336 auch 8 weitere Tensor-Kerne der 3. Generation.

| RTX A6000 | A40 | GeForce RTX 3090 | GeForce RTX 3080 | |

|---|---|---|---|---|

| GPU | GA102 | |||

| GPC | 7 | 6 | ||

| SM | 84 | 82 | 68 | |

| FP32-ALUs pro SM (CUDA-Cores) | 128 | |||

| FP32-ALUs (CUDA-Cores) | 10.752 | 10.496 | 8.704 | |

| RT-Kerne | 84 2nd Gen | 82 2nd Gen | 68 2nd Gen | |

| Tensor-Kerne | 336 3rd Gen | 328 3rd Gen | 272 3rd Gen | |

Welche Rechenleistung bei RTX A6000 und A40 genau zur Verfügung steht, lässt sich mangels Angaben zum Chiptakt derzeit noch nicht sagen. Entsprechende Angaben will Nvidia erst mit Näherrücken der Verfügbarkeit offenlegen, die für die Karten selbst Mitte Dezember dieses Jahres und über Workstation- und Server-Anbieter Anfang des kommenden Jahres gegeben sein soll.

48 GB GDDR6 mit ECC

Die neuen Profi-Lösungen bringen auch abseits der Anzahl der Rechenwerke einige Änderungen gegenüber den Gaming-Ablegern mit sich. Im Vergleich zur GeForce RTX 3090 (Test) hat Nvidia den Speicher von 24 GB GDDR6X auf 48 GB GDDR6 mit ECC verdoppelt. Das im Profisegment noch kein GDDR6X zum Einsatz kommt, ist auf die fehlende Verfügbarkeit entsprechender Chips mit doppelter Kapazität zurückzuführen, da schon bei der GeForce RTX 3090 beide Seiten des PCBs vollständig bestückt sind. RTX A6000 und A40 bleiben damit auf dem Niveau des Turing-Vorgängers Quadro RTX 8000. Entsprechend ist die Speicherbandbreite geringer als bei der GeForce RTX 3090. Diese gibt Nvidia bei der RTX A6000 mit 768 GB/s (16 Gbps) an, bei der A40 sind es 696 GB/s (14,5 Gbps). Über NVLink mit bidirektional 112,5 GB/s Bandbreite lassen sich zwei RTX A6000 oder A40 für ein Memory-Pooling von 96 GB verbinden.

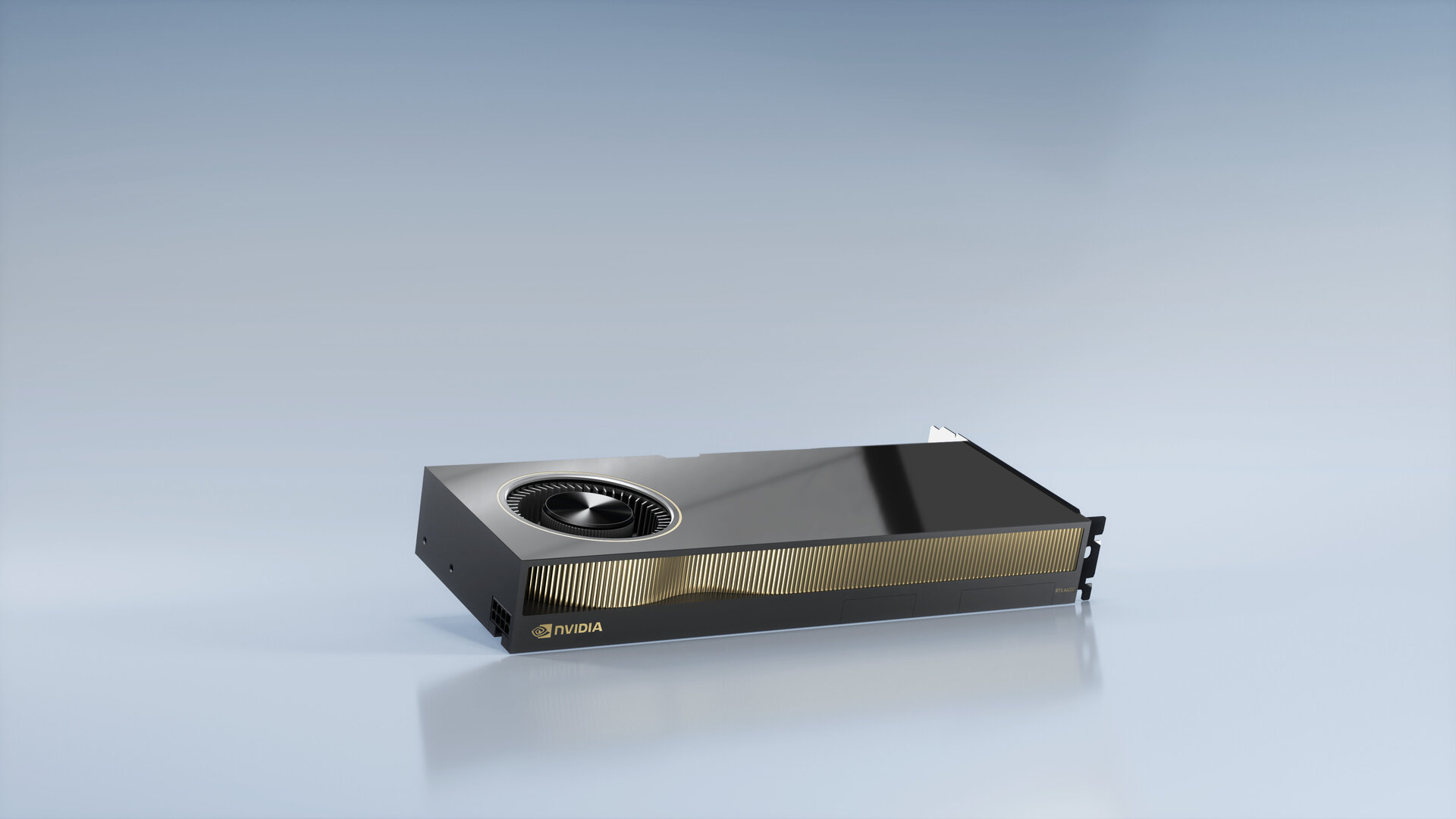

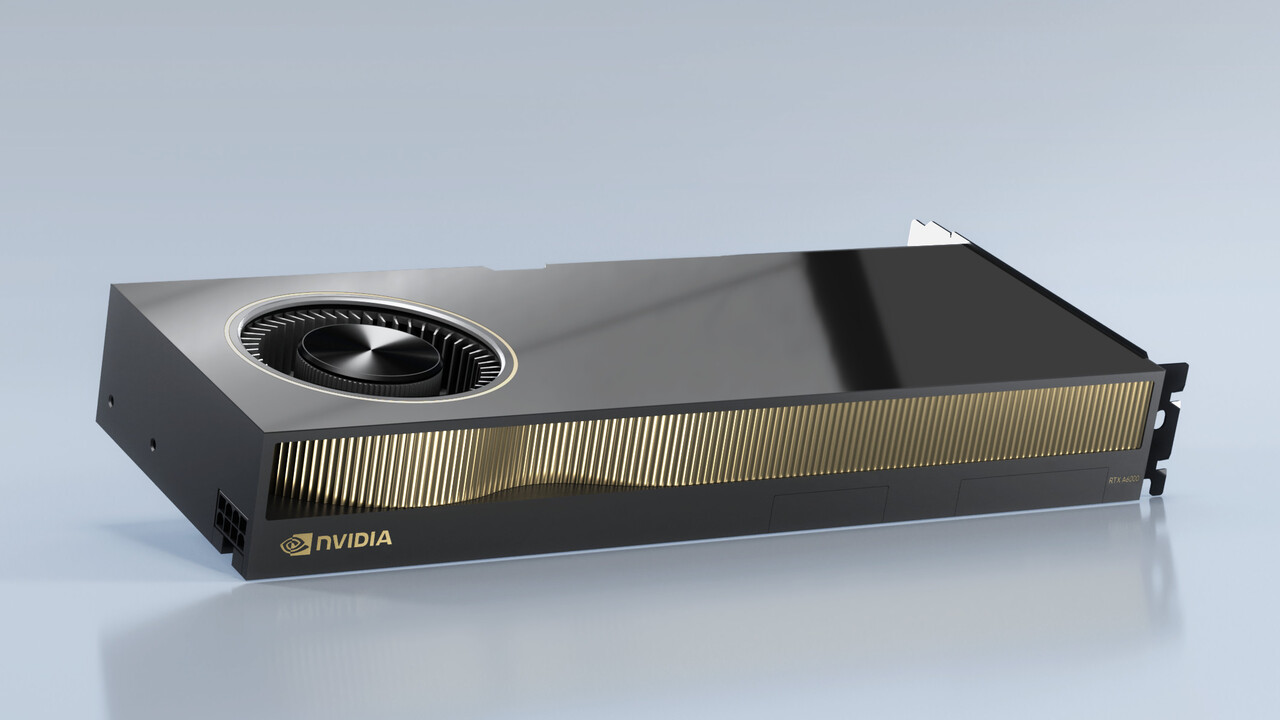

Klassisches 2-Slot-Design für Workstations und Server

Die aktive Kühlung der RTX A6000 fällt mit einem Radiallüfter klassisch aus und orientiert sich an bisherigen Quadro-Lösungen. Nvidia will mit dieser Umsetzung und dem 2-Slot-Design für maximale Kompatibilität in Workstations sorgen. Die aufwendigen Veränderungen am Kühler bei der GeForce RTX 3090 und GeForce RTX 3080 werden damit nicht in das Workstation-Segment übertragen. Selbiges gilt für den Netzteilanschluss, der mit einmal 8-Pin traditionell bleibt, anstatt den neuen 12-Pin-Stecker der Founders Edition zu übernehmen. Dabei handelt es sich nicht um den bei Desktop-PCs bekannten 8-Pin-Stecker, die auf den Profi-Karten eingesetzte Version kann deutlich mehr Energie aufnehmen. Nvidia gibt diese mit maximal 300 Watt für RTX A6000 und A40 an, während die GeForce RTX 3080 FE eine TDP von 320 Watt und die GeForce RTX 3090 eine von 350 Watt aufweist.

DisplayPort 1.4 auch für Server

Hinsichtlich der Anschlüsse bietet die aktiv gekühlte Variante RTX A6000 viermal DisplayPort 1.4. Im Server-Segment gibt es üblicherweise keine Bildausgabe direkt über die Grafikkarte, doch mit der A40 schlägt Nvidia einen anderen Weg ein. Da es bei der Zielgruppe eine entsprechende Nachfrage gegeben habe, stehen nun auch dort dreimal DisplayPort 1.4 zur Verfügung, wenngleich die Ausgänge standardmäßig deaktiviert sind. Denn nur mit deaktivieren Ausgängen lässt sich Nvidias vGPU-Software für die Unterteilung in mehrere virtuelle GPUs mit eigenem Speicherbereich auf einer physischen GPU verwenden. Dieselbe Einschränkung gilt für die RTX A6000, wenngleich dort standardmäßig die Anschlüsse aktiviert und somit vGPU deaktiviert ist. Nvidia 3D Vision und 3D Vision Pro werden weiterhin über einen 3-Pin-Mini-DIN-Anschluss unterstützt.

Marktstart Mitte Dezember

Nvidia RTX A6000 und A40 sollen zunächst Mitte Dezember als Karten von den Channel-Partnern PNY, Leadtek, Ingram Micro, Ryoyo und auf Nvidias eigener Webseite angeboten werden, wobei keine unverbindlichen Preisempfehlungen genannt wurden. Der Vorgänger Quadro RTX 8000 ist im Preisvergleich für rund 6.000 Euro zu finden. OEM-Anbieter von Workstations, darunter BOXX, Dell, HP und Lenovo, sollen Anfang des kommenden Jahres folgen. Dann sind zudem erste entsprechend ausgestattete Server von Cisco, Dell, Fujitsu, Hewlett Packard Enterprise und Lenovo geplant.

| RTX A6000 | A40 | RTX 3090 | RTX 3080 | |

|---|---|---|---|---|

| Architektur | Ampere | |||

| GPU | GA102 | |||

| Prozess | Samsung 8 nm Custom-Prozess | |||

| Chipgröße | 628,4 mm² | |||

| Transistoren | 28,3 Mrd. | |||

| GPC | 7 | 6 | ||

| SM | 84 | 82 | 68 | |

| FP32-ALUs pro SM | 128 | |||

| FP32-ALUs | 10.752 | 10.496 | 8.704 | |

| RT-Kerne | 84 2nd Gen | 82 2nd Gen | 68 2nd Gen | |

| RT-Kerne + ALUs synchron | Ja | |||

| Tensor-Kerne | 336 3rd Gen | 328 3rd Gen | 272 3rd Gen | |

| Basis-Takt | ? | ? | 1.400 MHz | 1.450 MHz |

| Boost-Takt | ? | ? | 1.700 MHz | 1.710 MHz |

| FP32-Leistung | ? | ? | 35,7 TFLOPS | 29,8 TFLOPS |

| FP16-Leistung | ? | ? | 35,7 TFLOPS | 29,8 TFLOPS |

| FP16-Leistung über Tensor | ? | ? | 143 TFLOPS 285 TFLOPS (Sparsity) |

119 TFLOPS 238 TFLOPS (Sparsity) |

| Textureinheiten | 336 | 328 | 272 | |

| ROPs | 112 | 96 | ||

| Speicher | 48 GB GDDR6 + ECC | 24 GB GDDR6X | 10 GB GDDR6X | |

| Speicher-Geschwindigkeit | 16 Gbps | 14,5 Gbps | 19,5 Gbps | 19,0 Gbps |

| Speicher-Interface | 384 Bit | 320 Bit | ||

| Speicher-Bandbreite | 768 GB/s | 696 GB/s | 936 GB/s | 760 GB/s |

| L2-Cache | 6 MB | 5 MB | ||

| TDP | 300 Watt | 350 Watt | 320 Watt | |

| Slot-Anbindung | PCIe 4.0 x16 | |||

| UVP | ? | ? | 1.499 Euro | 699 Euro |

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühest mögliche Veröffentlichungszeitpunkt.