AMD Instinct: MI300X mit 192 GB HBM3 und 153 Milliarden Transistoren

Für den AI- und HPC-Sektor hat AMD bereits im Januar die APU MI300A mit Zen-4-Kernen und CDNA-3-GPU angekündigt. Jetzt folgt eine rein GPU-basierte Variante: Die MI300X erhöht auf 153 Milliarden Transistoren und 192 GB HBM3, um darin große LLMs auszuführen.

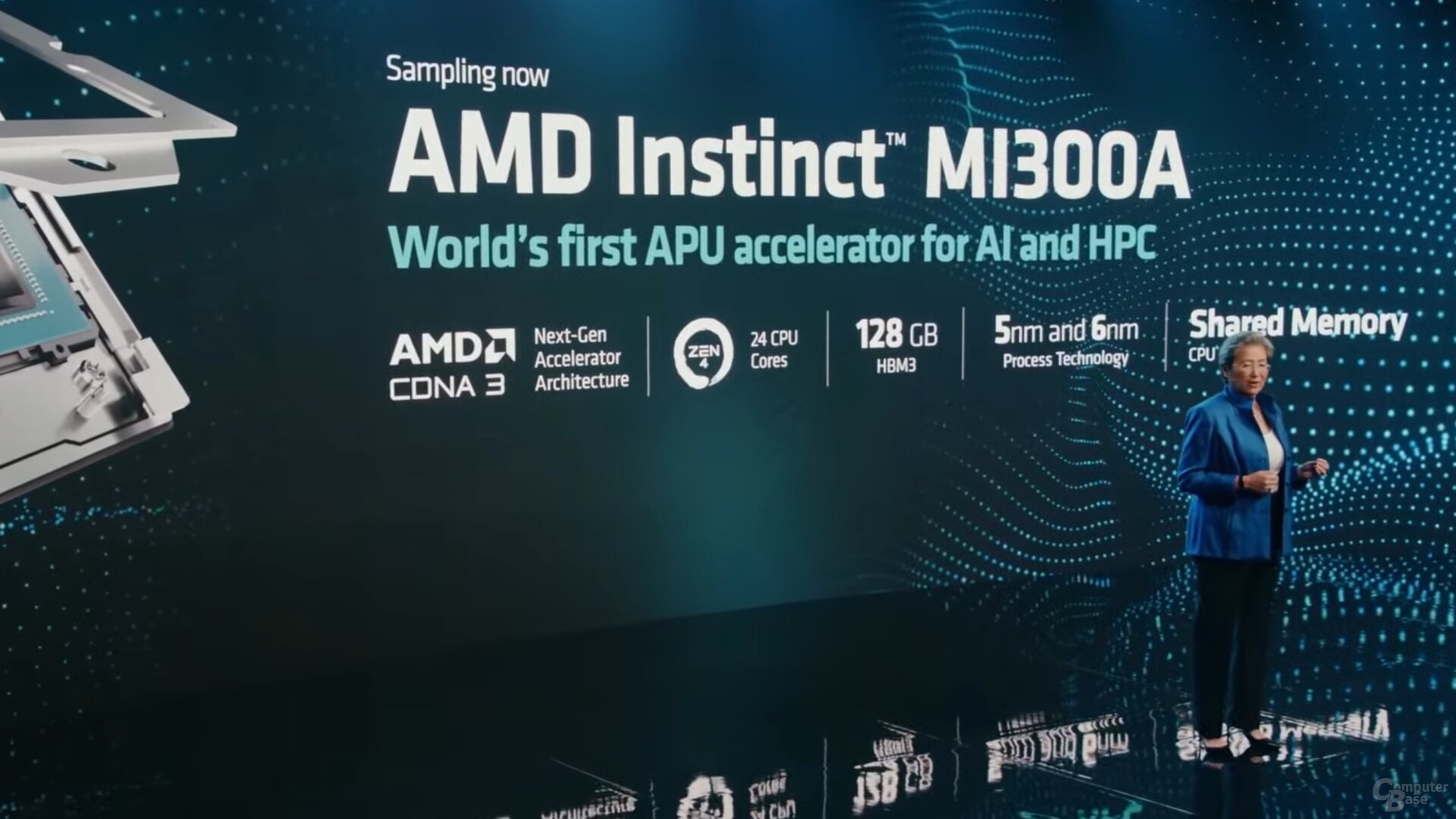

Regen Gebrauch vom Chiplet-Design mit unterschiedlichen Chips, die auf Interposer-Chips zu einem Package zusammengefügt werden, macht AMD bei der MI300-Serie in der Produktfamilie AMD Instinct. Die im Januar auf der CES vorgestellte MI300A setzt sich aus 6 GPU-Dies der CDNA-3-Generation sowie 3 CPU-Dies mit je acht Zen-4-Kernen zusammen. Diese 9 Chiplets sitzen auf 4 „Base Dies“ mit dem sogenannten Infinity Fabric, der auch für die Anbindung von 128 GB HBM3 sorgt. Insgesamt kommt MI300A somit auf 13 Chiplets und mehr als 146 Milliarden Transistoren.

MI300X tauscht Zen 4 gegen mehr GPU-Kerne

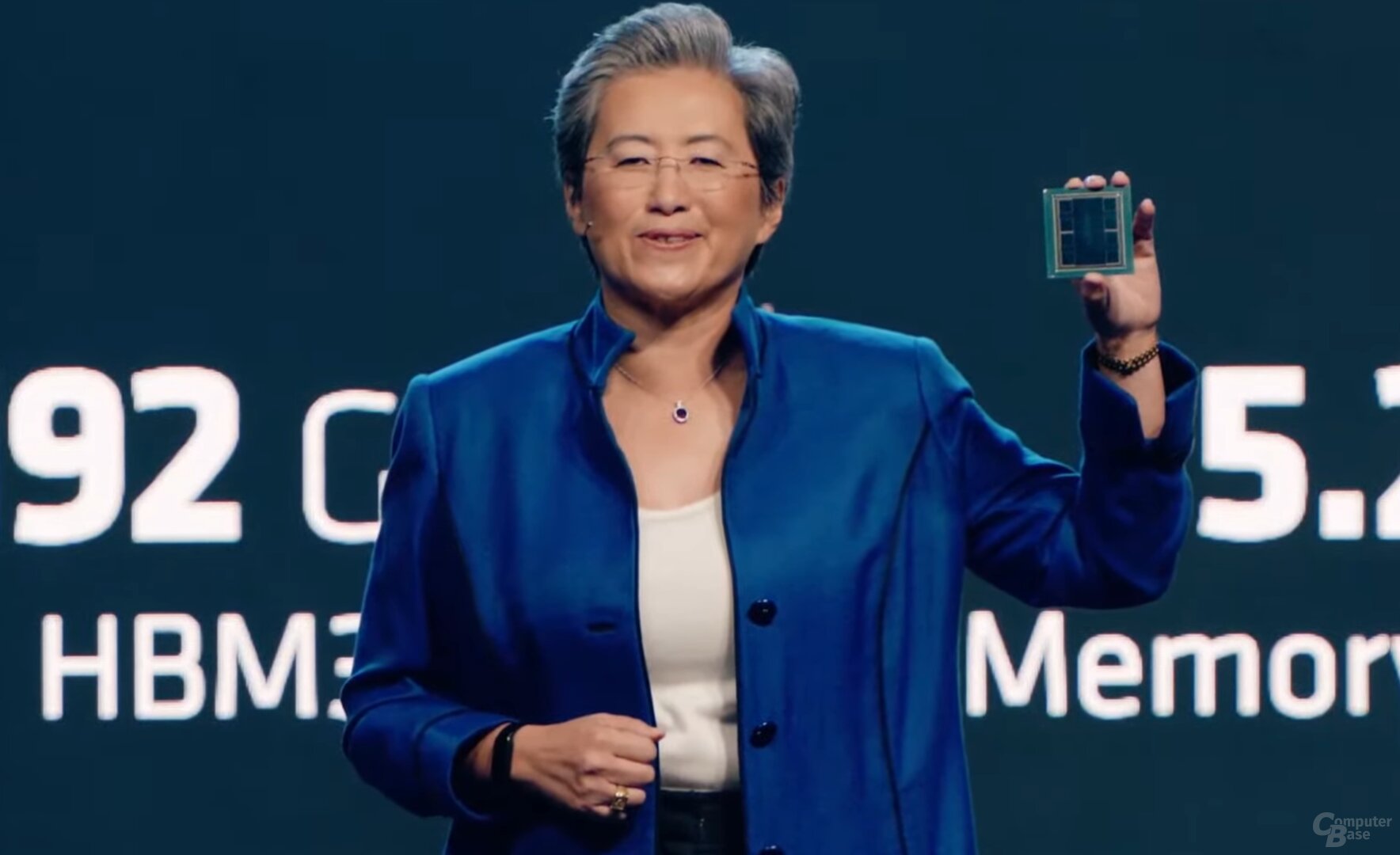

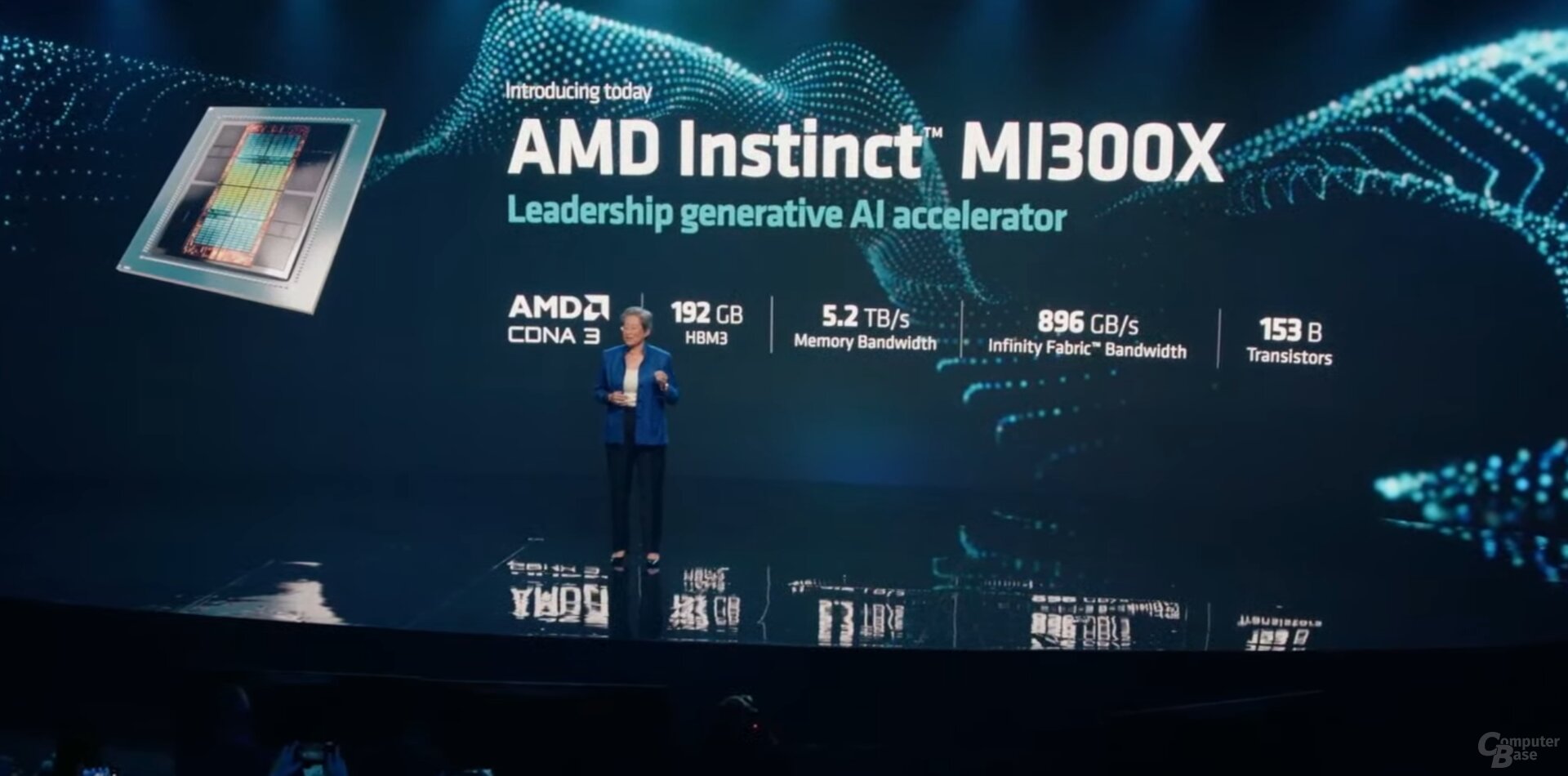

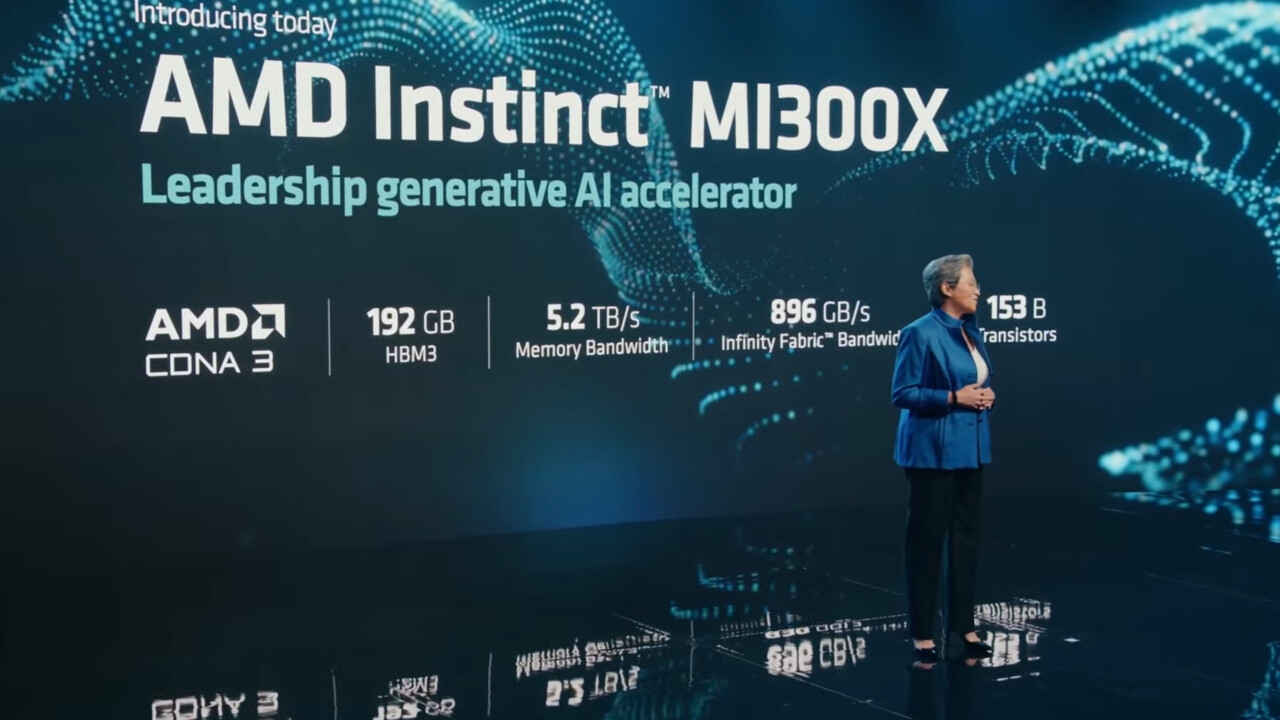

Im Rahmen der „AMD Data Center and AI Technology Premiere“ hat AMD-CEO Lisa Su jetzt eine neue Variante vorgestellt: MI300X. Bei dieser Version werden die drei CPU-Chiplets durch zwei GPU-Chiplets ersetzt. Somit gibt es keine Zen-4-Kerne aber dafür acht statt sechs CDNA-3-Chiplets für mehr GPU-Leistung. Ferner wurde der Speicher auf 192 GB HBM3 aufgestockt, der für einen Durchsatz von 5,2 TB/s sorgen soll. Dieser rein GPU-basierte AI-Beschleuniger bringt es sogar auf 153 Milliarden Transistoren, so AMD.

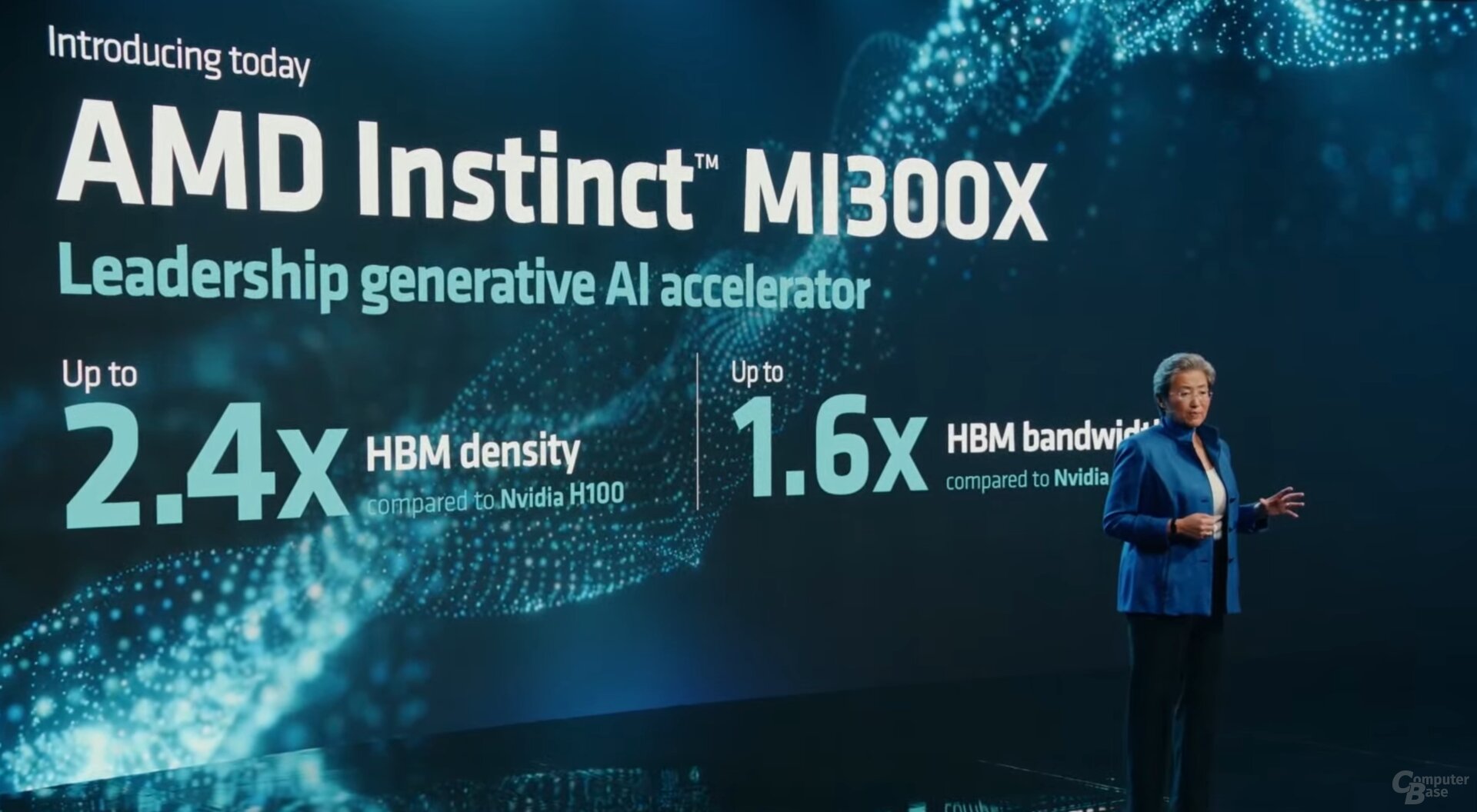

Allein der riesige Speicher soll einen klaren Vorteil gegenüber der Nvidia H100 bieten, die „nur“ über 80 GB HBM3 verfügt. Somit lassen sich mit deutlich weniger GPUs riesige Large Language Models (LLM) mit vielen Milliarden Parametern unterbringen. Demonstriert wurde dies mit dem LLM Falcon-40 mit 40 Milliarden Parametern, das auf einer einzigen MI300X betrieben wurde.

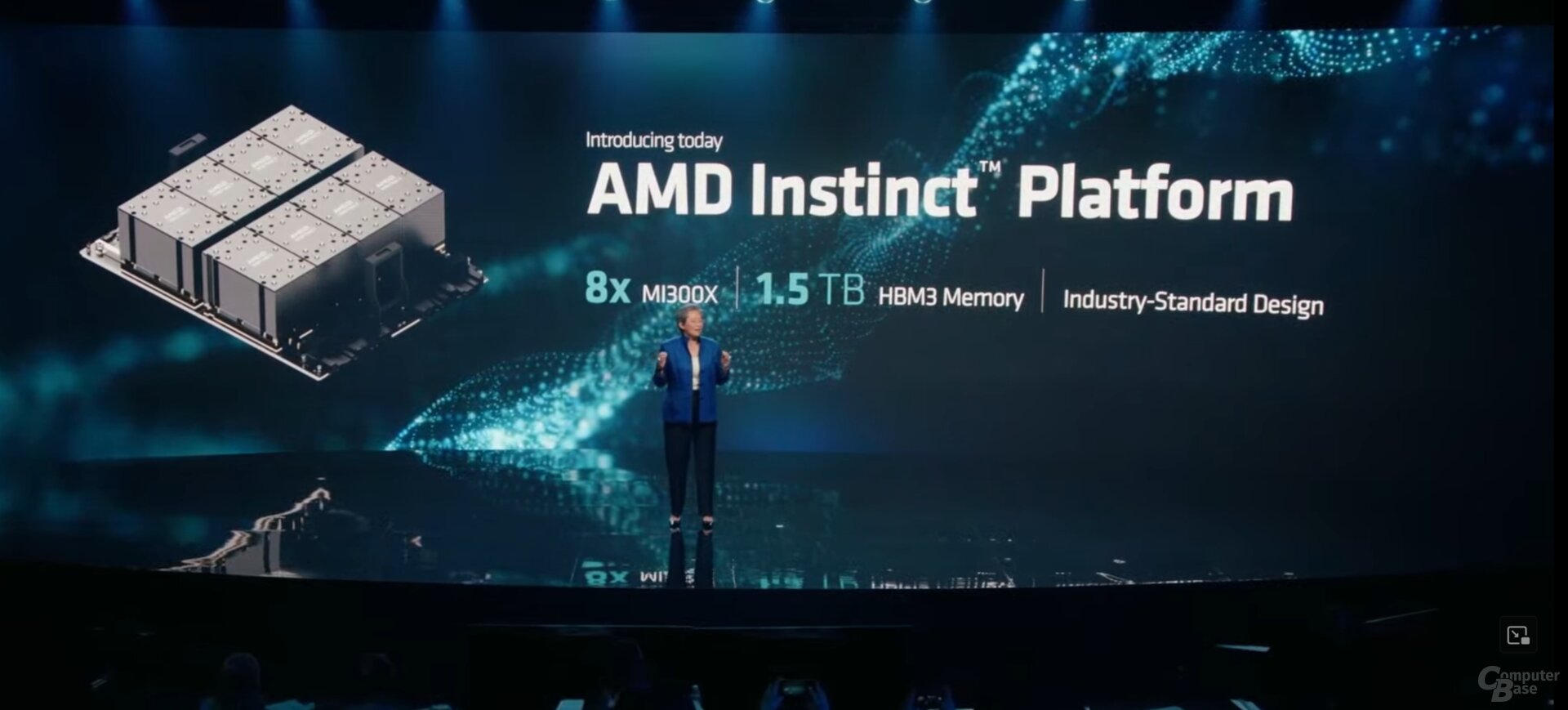

AMD hat aber auch die sogenannte Instinct Platform vorgestellt, bei der acht MI300X mit zusammen 1,5 TB HBM3 auf einer Hauptplatine untergebracht sind. Auch Nvidia sieht Systeme mit bis zu acht GPUs (vier Paare) auf Basis der H100 NVL vor, die aber zusammen nur auf 752 GB HBM3 kämen. Was den Leistungsvergleich angeht, müssen Tests abgewartet werden. In puncto Rechenleistung dürfte aber Nvidia vorn liegen, das könnte auch der Grund dafür sein, dass AMD bisher keine Angaben zur Rechenleistung der MI300-Produkte macht.

Während die MI300A mit CPU und GPU bereits die Bemusterung (Sampling) durchlaufe, werde dies bei der MI300X im nächsten Quartal erfolgen. Die Serienfertigung soll im vierten Quartal hochgefahren werden.

MI300A im 2-ExaFLOPS-Supercomputer

Die MI300A wird auch in einem neuen Supercomputer der ExaFLOPS-Klasse eingesetzt. Nächstes Jahr soll El Capitan damit eine Rechenleistung von über 2 ExaFLOPS erreichen. Der amtierende Spitzenreiter Frontier bringt es auf rund 1,2 ExaFLOPS. Doch auch Intel will mit dem kommenden System Aurora auf dem ersten Platz stehen.