Amazon Graviton4: Neueste Arm-CPU für AWS verspricht hohe Leistungssteigerungen

Der Sprung von Amazons Arm-CPU Graviton3 auf die Graviton4 ist nicht mehr so groß wie von 2 auf 3, aber weiterhin beachtlich. Nun wird am Scale-up gefeilt, denn die Graviton4 ist erstmals Dual-Sockel-fähig. Gepaart mit 50 Prozent mehr Kernen als der Vorgänger sollen die neuen AWS-Instanzen viel mehr Möglichkeiten bieten.

Vierte Generation der Arm-CPU von AWS

Zwei Jahre nach der Einführung von Graviton3 Ende 2021 schickt AWS die neue Generation an den Start. Die Basis ist nun Arms Neoverse V2, in TSMCs N4-Fertigung entsteht so ein Chip mit 96 Kernen pro Sockel. Das sind nicht nur 50 Prozent mehr als beim Vorgänger, auch sollen die Cores jeweils rund 30 Prozent schneller arbeiten, obwohl der Takt nur von 2,6 auf 2,7 GHz steigt. Zum neuen Gesamtpaket gehört auch ein deutlich aufgebohrter Speichercontroller. Dieser nutzt nun zwölf Kanäle nach Standard DDR5-5600. Auch mehr PCIe-Lanes spendiert AWS dem Design, 96 nach fünfter Generation sind es hier.

Graviton4 ist erstmals ein echter Dual-Sockel-Prozessor. Sein Vorgänger hatte jedoch die besondere Eigenschaft, dass AWS bereits drei CPUs in einem Server untergebracht hat, die über eine Nitro-Management-Karte mit der Außenwelt verbunden wurden. Wie das beim neuen Graviton4 aussieht, ist bisher noch nicht kommuniziert worden.

Zur Vorstellung im Rahmen der Hausmesse „re:Invent“ betonte AWS den Erfolg der bisherigen Lösungen. Obwohl sie eigentlich nur im eigenen Haus eingesetzt werden, hat AWS bereits über 2 Millionen Einheiten abgesetzt – davon träumen andere Arm-Server-CPU-Hersteller. Mit den neuen R8g-Instanzen verspricht AWS einmal mehr ein sehr gutes Preis-Leistungs-Verhältnis, ab Anfang 2024 sollen die Instanzen angeboten werden.

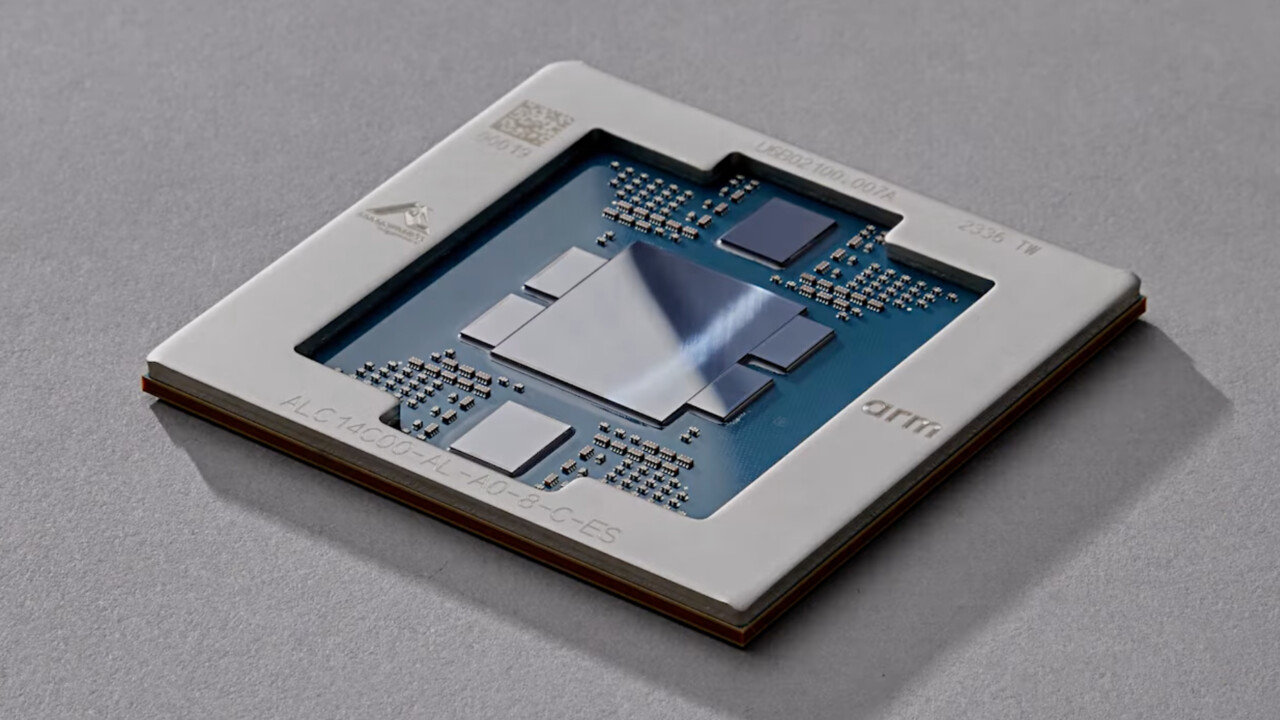

Trainium2 für Training von Foundation Models (FMs) und Large Language Models (LLMs)

Mit Trainium2 bringt AWS auch eine aktualisierte Version seines Training-Chips. Dieser soll vier Mal schneller als der Vorgänger sein, dazu die dreifache Speichermenge bieten. Die Effizienz soll dabei ebenfalls um den Faktor 2 zulegen. In sogenannten EC2 UltraClustern sollen sich bis zu 100.000 dieser Lösungen zusammenschalten lassen und so Foundation Models (FMs) und Large Language Models (LLMs) in kürzester Zeit trainieren. Eine normale EC2-Trn2-Instanz setzt auf 16 dieser Chips.

AWS nutzt das jährliche re:Invent für unzählige Neuvorstellungen und Anpassungen im Portfolio. Allein in den ersten beiden Tagen sind über 150 Pressemitteilungen zu Neuheiten aus diversen Bereichen des Unternehmens erschienen. Die Konferenz, die in Las Vegas abgehalten wird, läuft noch bis Freitag.