Nvidia & AWS: Der schnellste Cloud-AI-Supercomputer nutzt 16.384 GH200

Nvidia rückt näher an Amazon Web Service (AWS) heran, GPUs gibt es in vielen neuen Instanzen. Auch ein AI-Supercomputer kommt für die Cloud, hierfür stellt Nvidia 16.384 GH200 alias Grace Hopper Superchip bereit, der schnellste seiner Art soll so entstehen. Basis dafür ist die neue „GH200 NVL32 Multi-Node-Plattform“.

Nvidias GH200-Chip für AI bei AWS

Seit dem Jahr 2010 arbeiten Nvidia und Amazon zusammen. Beide Unternehmen sind seitdem massiv gewachsen, können und wollen aber auch in Zukunft voneinander profitieren. Amazons Cloud-Dienst, der einst als interne Lösung entwickelt wurde, dann jedoch weit über sich hinausgewachsen ist, will auch in Zukunft einer der absoluten Marktführer bleiben. Deshalb kooperiert Amazon nun noch stärker mit Nvidia, um beim AI-Hype (Künstliche Intelligenz) vorne mitspielen zu können.

Dafür bringt Nvidia unter anderem den GH200-Chip mit. Dieser feierte zuletzt viele Zuschläge von Kunden, kommt weltweit in sehr großen Systemen in naher Zukunft zum Einsatz.

16 Trays mit GH200 + 9 Trays mit NV Link

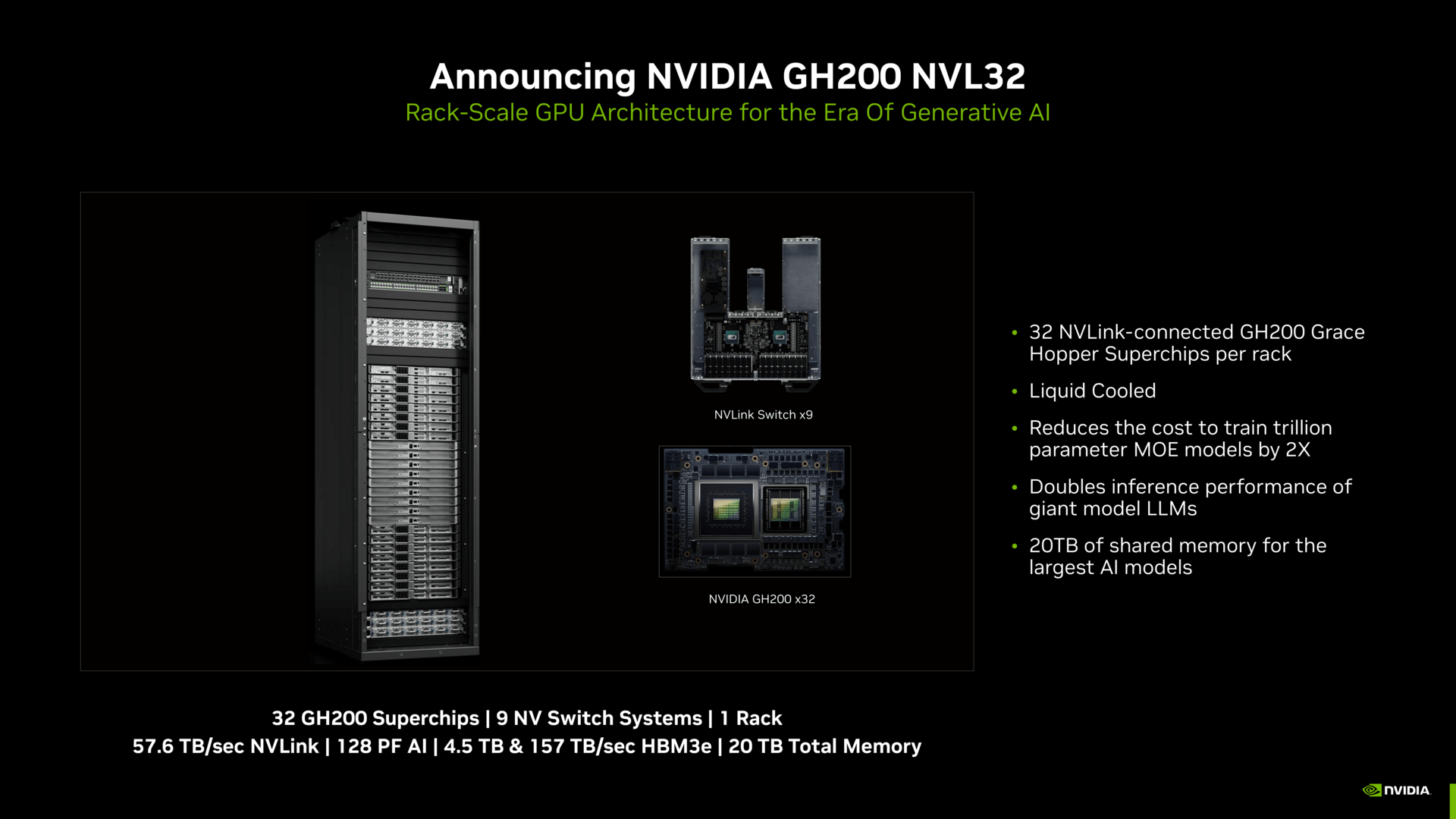

Neu ist eine schmale Rack-Lösung: 32 GH200 werden in 16 Trays in einem Rack verstaut, hinzu kommen beachtliche neun Trays für die NV-Link-Switches, die in der Mitte liegen. Das ganze Paket ist flüssigkeitsgekühlt, soll extrem hohe Leistung auf kleinem Raum bieten und als Amazon-EC2-Instanz angeboten werden.

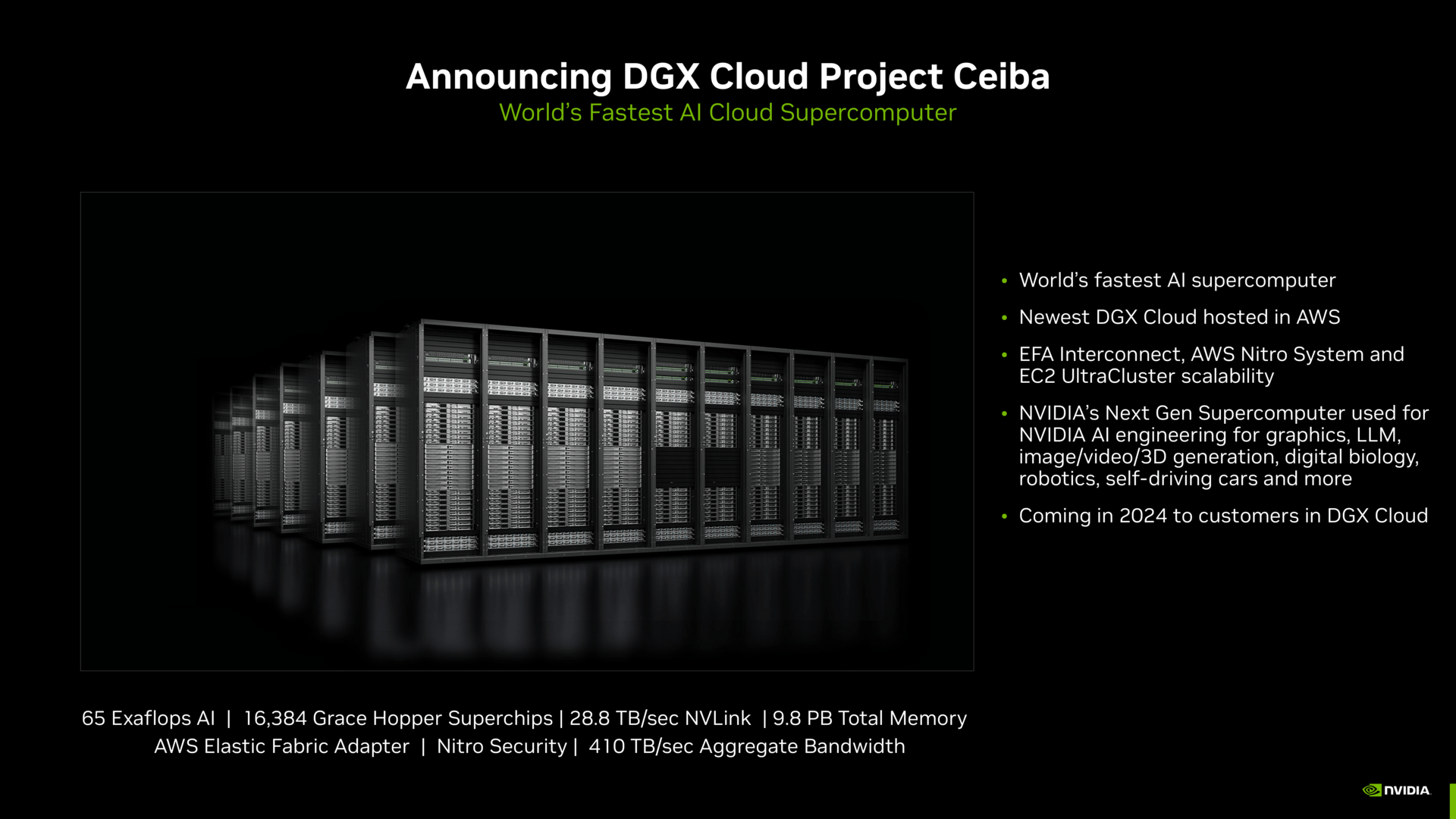

Auch das Project Ceiba, ein AWS-Supercomputer für AI, basiert auf diesem neuen Rack. Laut Nvidia wird Ceiba der schnellste seiner Art in der Cloud. Mit 16.384 GH200 ist er etwas kleiner als der kürzlich angekündigte Jupiter-Supercomputer für das Forschungszentrum Jülich in Deutschland, der auf 23.752 GH200 setzt, aber eben keine Cloud-Lösung ist. Project Ceiba wird in einem Rechenzentrum von AWS in den USA aufgebaut und soll wiederum primär Nvidia selbst als DGX-Cloud-Einsatzplattform dienen, um künftige Lösungen zu entwickeln.

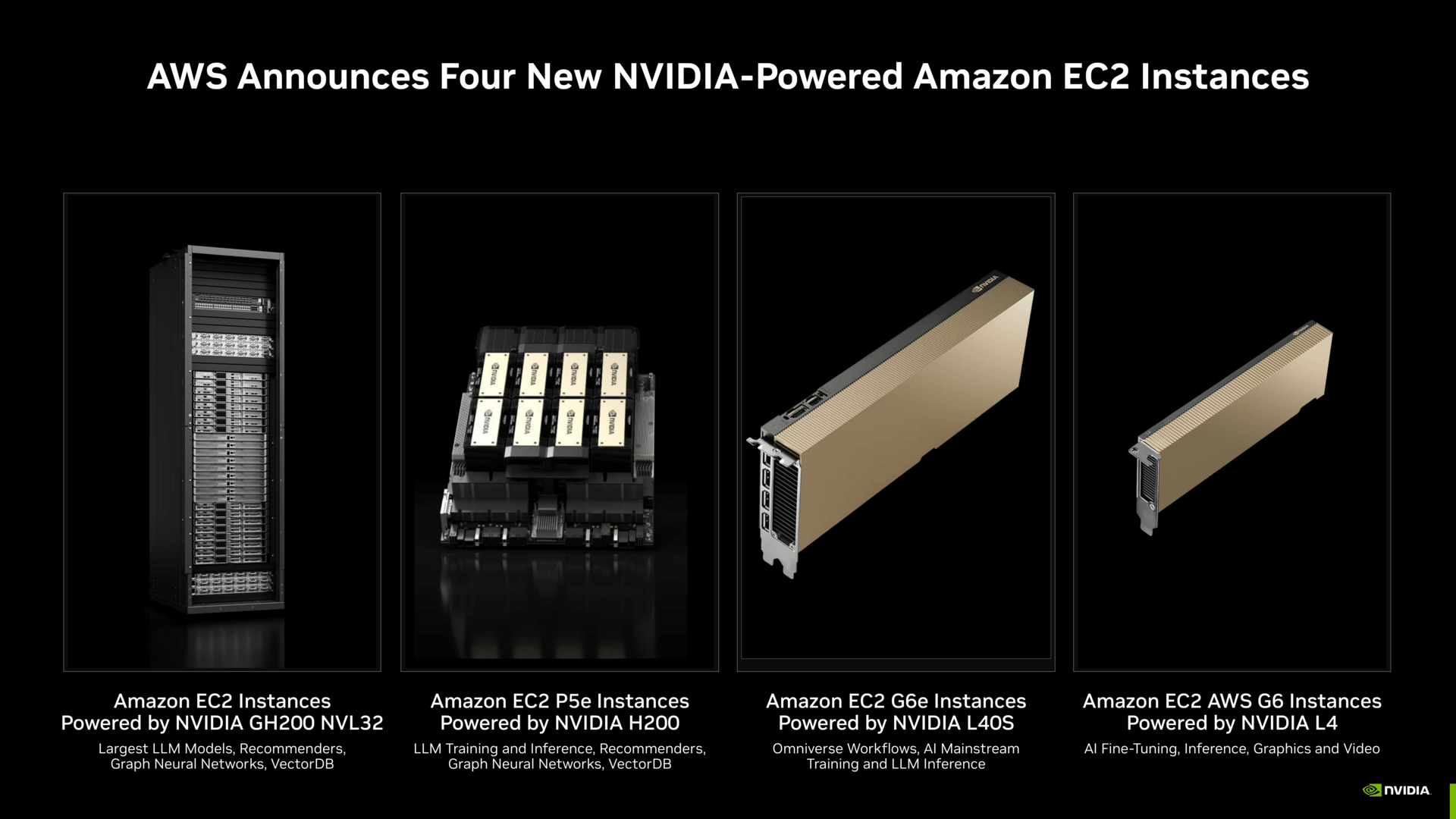

Reguläre AWS-Kunden können auf eine Vielzahl an Nvidia-Lösungen zugreifen. Diese erstrecken sich vom besagten Rack über ganz neue GH200-Lösungen ab nächstem Jahr bis hin zu Instanzen mit kleineren Nvidia L40S und L4. AWS und Nvidia wollen für jede mögliche Kundschaft ein passendes Produkt im Portfolio haben.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.