Salamimander

Captain

- Registriert

- Okt. 2019

- Beiträge

- 4.015

Hi,

aktuell verwende ich ein TrueNAS Server mit Raidz2 auf dem ich auch, mittels bhyve, virtualisiere. Da B-Hyve mmn totaler Käse ist für Linux VMs (Bei BSD mag das anders aussehen, aber soll garnicht diskutiert werden).

Auf Grund dessen und weil ich gerne rumspiele und lerne, möchte ich das ganze auf Proxmox umbauen und den TrueNAS Part am Ende einfach virtualisieren.

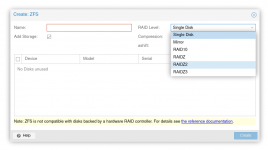

Wie sieht das bei proxmox mit ZFS aus? Ja klar, es geht. Aber wie stabil ist das ganze? Production Ready? Vom Aufbau her hätte ich gerne die Installation auf einem RaidZ2 samt SSD-Cache.Letzteres hänge ich später auch einfach dran, kein Thema. Da ZFS aber arg Memorylastig ist, frage ich mich, wie das geregelt ist? Muss ich das, ähnlich wie bei FreeBSD händisch limitieren? TrueNAS ist mir anfänglich gerne mal mit einem OOM weg geflogen und das tut weh, das will ich bei Proxmox gerne direkt verhindern. Es stehen 32GB für alles zur Verfügung.

Was habe ich überhaupt vor?

5 VMs (Debian)

Bei einem Neuaufbau besteht auch die Möglichkeit, Teile zu Containerisieren, dH ich könnte das weiter aufdröseln. Allerdings ist der Overhead bei proxmox Containern wohl doch bedeutend höher als bei Docker.

Zur (betagten) Hardware:

Intel Core i5-7600k

2x 16 GB DDR4

4x4TB HDD

1x 500GB SSD

1x 120GB SSD

1x 1GBit Realtek

2x 1GBit Intel (LACP geplant)

Natürlich könnte man jetzt auch neue Hardware kaufen, RAM nachstecken und und und, möchte ich aber an dieser Stelle nicht. Sobald der 5600G von AMD billiger wird, steht ein Systemwechsel an, vorher nicht.

Steht meinem Plan im Grundsatz irgendwas im Wege? Migration der Daten plane ich nicht wirklich. Es wird ein Backup der Daten des TrueNAS erstellt sowie config exports der Dienste (Jenkins, unifi, HomeAssistant, rsnapshot usw)

Aus der Doku:

Arbeitsspeicher: mind. 2 GB für OS und Proxmox VE-Dienste. Für jeden Gast zusätzlichen Arbeitsspeicher. Zusätzlicher Arbeitsspeicher für Ceph oder ZFS, ca. 1 GB Speicher pro TB genutztem Storage.

--> Es sind knapp 6TB Storage beim RaidZ2 über. dH 8GB RAM der 32 abziehen. Aber muss dazu etwas konfiguriert werden? Wie gesagt, bei FreeBSD muss ich das tatsähclich in den parametern limitieren sonnst gibt es OOM Fehler.

Des weiteren Frage ich mich, Kann ich den System Storage auch als VM Storage nutzen, dH kann ich VMs direkt auf dem "root ZFS" erstellen auf dem auch die Installation liegt?

aktuell verwende ich ein TrueNAS Server mit Raidz2 auf dem ich auch, mittels bhyve, virtualisiere. Da B-Hyve mmn totaler Käse ist für Linux VMs (Bei BSD mag das anders aussehen, aber soll garnicht diskutiert werden).

Auf Grund dessen und weil ich gerne rumspiele und lerne, möchte ich das ganze auf Proxmox umbauen und den TrueNAS Part am Ende einfach virtualisieren.

Wie sieht das bei proxmox mit ZFS aus? Ja klar, es geht. Aber wie stabil ist das ganze? Production Ready? Vom Aufbau her hätte ich gerne die Installation auf einem RaidZ2 samt SSD-Cache.Letzteres hänge ich später auch einfach dran, kein Thema. Da ZFS aber arg Memorylastig ist, frage ich mich, wie das geregelt ist? Muss ich das, ähnlich wie bei FreeBSD händisch limitieren? TrueNAS ist mir anfänglich gerne mal mit einem OOM weg geflogen und das tut weh, das will ich bei Proxmox gerne direkt verhindern. Es stehen 32GB für alles zur Verfügung.

Was habe ich überhaupt vor?

5 VMs (Debian)

- Unifi/Unbound/pihole (Kann alles in eine VM, weniger Overhead)

- jenkins

- HomeAssistant

- Backup Server (rsnapshot --> Remote Sicherung)

- TrueNAS

Bei einem Neuaufbau besteht auch die Möglichkeit, Teile zu Containerisieren, dH ich könnte das weiter aufdröseln. Allerdings ist der Overhead bei proxmox Containern wohl doch bedeutend höher als bei Docker.

Zur (betagten) Hardware:

Intel Core i5-7600k

2x 16 GB DDR4

4x4TB HDD

1x 500GB SSD

1x 120GB SSD

1x 1GBit Realtek

2x 1GBit Intel (LACP geplant)

Natürlich könnte man jetzt auch neue Hardware kaufen, RAM nachstecken und und und, möchte ich aber an dieser Stelle nicht. Sobald der 5600G von AMD billiger wird, steht ein Systemwechsel an, vorher nicht.

Steht meinem Plan im Grundsatz irgendwas im Wege? Migration der Daten plane ich nicht wirklich. Es wird ein Backup der Daten des TrueNAS erstellt sowie config exports der Dienste (Jenkins, unifi, HomeAssistant, rsnapshot usw)

Aus der Doku:

Arbeitsspeicher: mind. 2 GB für OS und Proxmox VE-Dienste. Für jeden Gast zusätzlichen Arbeitsspeicher. Zusätzlicher Arbeitsspeicher für Ceph oder ZFS, ca. 1 GB Speicher pro TB genutztem Storage.

--> Es sind knapp 6TB Storage beim RaidZ2 über. dH 8GB RAM der 32 abziehen. Aber muss dazu etwas konfiguriert werden? Wie gesagt, bei FreeBSD muss ich das tatsähclich in den parametern limitieren sonnst gibt es OOM Fehler.

Des weiteren Frage ich mich, Kann ich den System Storage auch als VM Storage nutzen, dH kann ich VMs direkt auf dem "root ZFS" erstellen auf dem auch die Installation liegt?