Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Raptor Lake Refresh: Intel Core i7 wird von 8 auf 12 E-Kerne aufgewertet

- Ersteller Volker

- Erstellt am

- Zur News: Raptor Lake Refresh: Intel Core i7 wird von 8 auf 12 E-Kerne aufgewertet

DKK007 schrieb:Die E-Cores sind die Kerne der alten und lahmen ATOM-CPUs.

Nur halt mit ein paar Verbesserungen in der Architektur, etwas besserer Fertigung und mehr Takt als im Netbook.

Ich halte das fuer irrefuehrend. Die Bonnell-Architektur (2008) der ersten Atoms (die auch damals in den Netbooks drinnen waren) war offenbar so lahm, dass Intel das gleich wieder aufgegeben und 2013 den sehr anderen Silvermont-Kern in diesem Marktsegment (billige und sparsame Kerne) herausgebracht hat. Insbesondere verwendet Bonnell in-order execution und Silvermont out-of-order execution; angesichts von fuenf Jahren zwischen den Prozessoren kann man davon ausgehen, dass Silvermont zum Grossteil eine voellige Neuentwicklung ist. Seither kamen dann regelmaessig verbesserte Ableger von Silvermont heraus. Im Vergleich zu den jeweils aktuellen P-Cores sind die zwar schon deutlich langsamer, aber im Vergleich zum Bonnell viel schneller. Wenn wir z.B. LaTeX messen (die Zahl hinten ist die Zeit in Sekunden):

Code:

- Intel Atom 330, 1.6GHz, 512K L2 Zotac ION A, Debian 9 64bit 2.368

- Celeron J1900 (Silvermont) 2416MHz (Shuttle XS35V4) Ubuntu16.10 1.052

- Celeron J3455 (Goldmont) 2300MHz, ASRock J3455-ITX, Ubuntu16.10 0.712

- Celeron J4105 (Goldmont+) 2500MHz Ubuntu 18.04 64b 0.540

- Celeron N4500 (Tremont) 2.8GHz, Debian 11 (64-bit) 0.519

- Core i7-4790K, 4400MHz (Turbo), 8MB L3, Debian Jessie (64-bit) 0.204

- Xeon W-1370P (=Core i7-11700K), 5200MHz, Debian 11 (64-bit) 0.175Wobei die auf dem Tremont und Rocket Lake (Xeon W-1370P) laufende Version des Benchmarks ca. 1.3 mal mehr Befehle ausgefuehrt hat und Tremont und Rocket Lake damit etwas schlechter ausschauen als sie sind. Alder/Raptor Lake konnte ich noch nicht messen.

Na jedenfalls ist der Tremont trotz dieses Handycaps 4.56 mal schneller als der Bonnell (Atom 330) und 2.97 mal langsamer als der Rocket Lake, braucht aber auch deutlich weniger Strom und Flaeche. Die Fortschritte seit 2013/2014 (Silvermont/Haswell R (4790K)) sind bei den E-Cores deutlich groesser als bei den P-Cores.

danyundsahne

Commodore

- Registriert

- Okt. 2007

- Beiträge

- 4.135

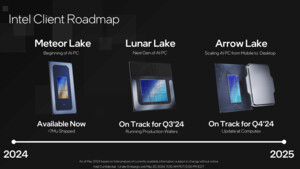

Da ARL erst für nächstes Jahr angedacht ist, kann sich Intel eben nicht bis dahin mit RPL zufrieden geben.

Intel versucht eben mit mehr E-Cores und etwas mehr Takt (und zusammen wohl mit deutlichem Mehverbrauch) hier zumindest noch etwas auf die X3D CPUs aufzuholen (im Gaming) und im MC kann man damit nochmal n kleines deutliches Plus bei ein paar Modellen rausholen.

Komme was wolle. Das ist wohl die Strategie dahinter.

Die einzige bemerkenswerte Neuerung wird dann wohl der 14700k sein? Weil der 14900k verbleibt ja bei 24C/32T.

Aber vll bekommt auch der 14600k mehr E-Cores und wird dann zum 6P+12E Core Variante. Was dann allerdings sehr stark wäre MC technisch.

Alles in allem ist das wohl das Einzige was Intel noch bleibt bis ARL.

Intel versucht eben mit mehr E-Cores und etwas mehr Takt (und zusammen wohl mit deutlichem Mehverbrauch) hier zumindest noch etwas auf die X3D CPUs aufzuholen (im Gaming) und im MC kann man damit nochmal n kleines deutliches Plus bei ein paar Modellen rausholen.

Komme was wolle. Das ist wohl die Strategie dahinter.

Die einzige bemerkenswerte Neuerung wird dann wohl der 14700k sein? Weil der 14900k verbleibt ja bei 24C/32T.

Aber vll bekommt auch der 14600k mehr E-Cores und wird dann zum 6P+12E Core Variante. Was dann allerdings sehr stark wäre MC technisch.

Alles in allem ist das wohl das Einzige was Intel noch bleibt bis ARL.

DKK007

Lt. Commander

- Registriert

- Nov. 2015

- Beiträge

- 1.298

mae schrieb:Wenn wir z.B. LaTeX messen (die Zahl hinten ist die Zeit in Sekunden):

Code:- Intel Atom 330, 1.6GHz, 512K L2 Zotac ION A, Debian 9 64bit 2.368 - Celeron J1900 (Silvermont) 2416MHz (Shuttle XS35V4) Ubuntu16.10 1.052 - Celeron J3455 (Goldmont) 2300MHz, ASRock J3455-ITX, Ubuntu16.10 0.712 - Celeron J4105 (Goldmont+) 2500MHz Ubuntu 18.04 64b 0.540 - Celeron N4500 (Tremont) 2.8GHz, Debian 11 (64-bit) 0.519 - Core i7-4790K, 4400MHz (Turbo), 8MB L3, Debian Jessie (64-bit) 0.204 - Xeon W-1370P (=Core i7-11700K), 5200MHz, Debian 11 (64-bit) 0.175

Wobei die auf dem Tremont und Rocket Lake (Xeon W-1370P) laufende Version des Benchmarks ca. 1.3 mal mehr Befehle ausgefuehrt hat und Tremont und Rocket Lake damit etwas schlechter ausschauen als sie sind. Alder/Raptor Lake konnte ich noch nicht messen.

Na jedenfalls ist der Tremont trotz dieses Handycaps 4.56 mal schneller als der Bonnell (Atom 330) und 2.97 mal langsamer als der Rocket Lake, braucht aber auch deutlich weniger Strom und Flaeche. Die Fortschritte seit 2013/2014 (Silvermont/Haswell R (4790K)) sind bei den E-Cores deutlich groesser als bei den P-Cores.

Aber schau dir mal den Vergleich zum inzwischen 10 Jahre alten Haswell an. Der ist immer noch doppelt so schnell wie der Atom.

Interessant wäre es die CPUs mal alle bei fixierten 2 GHz laufen zu lassen um die Unterschiede in der Architektur zu sehen.

Wie viele Threads nutzt Latex?

Anon-525334

Banned

- Registriert

- Dez. 2010

- Beiträge

- 1.478

Geht dein PC nicht in den Energiesparmodus`?Schrotti schrieb:Nix für mich. Statt mehr E-Kernen sollte Intel endlich mal mehr P Kerne dazupacken (+2 oder so).

Ergänzung ()

Es gibt auch Leute, die nicht nur zocken und wenn die Kiste dann am idlen ist, hat AMD ein Problem.

Hatte selbst einen AMD RYZEN 5 3600 und später einen RYZEN 9 5950X. Stromverbrauch im Leerlauf war und ist eine Katastrophe.

MalWiederIch

Lt. Commander

- Registriert

- März 2023

- Beiträge

- 1.258

Das tut sie doch lediglich wenn du hier bei Prime95 im CB Test schaustEasy1991 schrieb:Ich weiß nicht ob es einer erwähnt hat,

Eine cpu die 250w Abwärme produziert, wird immer die gleiche Wärme im Raum blasen, egal ob der Kühler xxl ist und 40 Grad hält oder klein und bei 90 Grad ist, die Abwärme bleibt trotzdem die selbe.

Im Gaming liegen zwischen 7950X3D und 13700K laut CB 35W …

Dazu eine RTX 4090 mit 400W+ für 2.000€ und dann willst du dich über ein Mehr an Stromkosten im Centbereich und Abwärme, die bei 5% vom Gesamtsystem liegt, beschweren

Ergänzung ()

Du kennst nur Gaming oder Energiesparmodus? Seltsamer Anwendungsfall, dürfte die Masse nicht betreffen.mcsteph schrieb:Geht dein PC nicht in den Energiesparmodus`?

Zuletzt bearbeitet:

Anon-525334

Banned

- Registriert

- Dez. 2010

- Beiträge

- 1.478

Du hast von IDLE gesprochen! Die Masse betrifft nicht den Energiesparmodus? Obwohl er Default in jedem System eingestellt ist? Wird ja immer verrückter.

Oder meinst du Teillast:

https://www.computerbase.de/2023-04...t/#abschnitt_leistungsaufnahme_in_anwendungen

Da sind alle CPUs auf einem ähnlichen Niveau. Dein AMD Bashing kannst du dir sparen.

Oder meinst du Teillast:

https://www.computerbase.de/2023-04...t/#abschnitt_leistungsaufnahme_in_anwendungen

Da sind alle CPUs auf einem ähnlichen Niveau. Dein AMD Bashing kannst du dir sparen.

Zuletzt bearbeitet:

N85

Cadet 3rd Year

- Registriert

- Aug. 2022

- Beiträge

- 48

Auf die Leistungsaufnahme unter Vollast bin ich ja mal gespannt, wird sicherlich noch über der Vorgängergen liegen. Mit dem neuen Update von AMD die Idle-Last der 7000er zu verringern, fallen die Intels für mich eigentlich komplett aus dem Rennen. Wenn da nicht ein ordentlicher Effizienzschub passiert, was nicht passieren wird, dann fliegt AMD Intel mit der 8.Gen endgültig davon. Nutze einen 8600k und warte nur noch auf den richtigen Moment für einen 7900 ohne x

DKK007 schrieb:Aber schau dir mal den Vergleich zum inzwischen 10 Jahre alten Haswell an. Der ist immer noch doppelt so schnell wie der Atom.

Sogar mehr als zehn mal so schnell. Wenn Du mit "Atom" den Tremont meinst (auf dem "Celeron" steht, nicht "Atom"), ja.

Wenn Du den Bonnell (Atom 330) und den Tremont (Celeron N4500) in einen Topf wirfst, ignorierst Du den grossen Unterschied zwischen ihnen.

Interessant wäre es die CPUs mal alle bei fixierten 2 GHz laufen zu lassen um die Unterschiede in der Architektur zu sehen.

Da dieser Benchmark wenige Cache misses hat, kannst Du einfach die Zeit mit den GHz multiplizieren, um die Leistung pro Takt anzunaehern; dann bleibt noch der Faktor 1.3 in den ausgefuehrten Befehlen zwischen den auf Debian 11 laufenden Systemen und den anderen.

Aber die "Leistung pro Takt" hat auch seine Schwaechen: Die E-Kerne koennen einfach nicht mit so einem hohen Takt laufen wie die P-Kerne.

Umgekehrt koennte man sich auch ueberlegen, die Kerne mit gleichem Verbrauch laufen zu lassen (z.B. 3W pro Kern), aber die P-Kerne wurden eben dazu entworfen, mit mehr Verbrauch zu laufen, das waere auch irrefuehrend.

Wie viele Threads nutzt Latex?

Einen.

MalWiederIch

Lt. Commander

- Registriert

- März 2023

- Beiträge

- 1.258

Nicht wirklich, warum sollte jemand der sowieso schon einen Rechner mit 13700K sein eigenen nennt HomofficeTaurus104 schrieb:Ich habe nichts davon geschrieben das man im Homeoffice keinen Intel sollte!

Es geht darum das für Homeoffice Rechner wo wirklich nur Office genutzt wird wohl kaum sinnvoll ist CPUs der Leistungsklasse 13600k-13900k einzusetzen. Das ist wäre mit Ryzen 7700-7950X genauso wenig sinnvoll.

Wenn du einen vorhandenen Privatrechner fürs Homeoffice nutzt ok.

In den meisten Fällen stellt doch aber der AG hier eher einen Firmenlaptop der bei reinen Office sinnvoller ist.

Hier gibt es ja auch schon lange Desktopstations zur Erweiterung wenn man es braucht.

Ein AG wird für normales Office wohl kaum einen Desktop PC für mit 13700k oder Ryzen 7900 stellen.

Sollte man im Homeoffice natürlich mehr Video, Fotos bearbeiten oder richtige Compute Anwendungen nutzen ist solch ein Desktoprechner durchaus sinnvoll aber diese PCs befinden sich während der Arbeitszeit wohl kaum dauerhaft im Idle.

Ich hoffe ich konnte es nun besser verständlich machen vielleicht.

Kein Grund für Schnappatmungmcsteph schrieb:Du hast von IDLE gesprochen! Die Masse betrifft nicht den Energiesparmodus? Obwohl er Default in jedem System eingestellt ist? Wird ja immer verrückter.

Oder meinst du Teillast:

https://www.computerbase.de/2023-04...t/#abschnitt_leistungsaufnahme_in_anwendungen

Da sind alle CPUs auf einem ähnlichen Niveau. Dein AMD Bashing kannst du dir sparen.

Hier sind 20W auch entsprechend in Richtung 20-40% des Gesamtverbrauchs.

Beim Gaming wie im Test mit einer RTX 4090 liegt der Gesamtverbrauch bei ~550W und entsprechend 35W laut CB Test mit dem 7950X3D darunter.

In dem Fall sind es nur 6% des Gesamtverbrauchs oder 0,0098€ pro Stunde im CPU Limit

Und das lediglich hierfür?

…

Zuletzt bearbeitet:

GERmaximus

Rear Admiral

- Registriert

- Sep. 2015

- Beiträge

- 5.288

Was bringen mir als Gamer die e Cores?

DKK007

Lt. Commander

- Registriert

- Nov. 2015

- Beiträge

- 1.298

GERmaximus schrieb:Was bringen mir als Gamer die e Cores?

Wenn sonst nichts läuft aktuell vermutlich nichts.

Wenn nebenbei noch andere Sachen auf dem PC laufen, können die zusammen mit Windows die E-Cores nutzen und das Spiel hätte die P-Cores alleine.

mae schrieb:Sogar mehr als zehn mal so schnell. Wenn Du mit "Atom" den Tremont meinst (auf dem "Celeron" steht, nicht "Atom"), ja.

Wenn Du den Bonnell (Atom 330) und den Tremont (Celeron N4500) in einen Topf wirfst, ignorierst Du den grossen Unterschied zwischen ihnen.

Ja ich meinte den Tremont-Atom.

Tornavida

Commodore

- Registriert

- Okt. 2020

- Beiträge

- 4.988

Der 14700K hört sich interessant an aber auch Nix wo man ein feuchtes Höschen bekommen müsste wenn man eine halbwegs aktuelle CPU hat.

2P Kerne mehr und Kerne mit mehr Cache wie bei x3d und diesen Taktraten fände ich deutlich aufregender. Mal schauen was beim Ram geht und was die Dinger bei MC ziehen werden. Cool ist es allemal was Intel mit dieser Fertigung hinbekommt.

2P Kerne mehr und Kerne mit mehr Cache wie bei x3d und diesen Taktraten fände ich deutlich aufregender. Mal schauen was beim Ram geht und was die Dinger bei MC ziehen werden. Cool ist es allemal was Intel mit dieser Fertigung hinbekommt.

MalWiederIch

Lt. Commander

- Registriert

- März 2023

- Beiträge

- 1.258

Ob nun 500W oder 540W fallen bei ihm bestimmt stark ins GewichtSnoop7676 schrieb:Dann hast du nicht nur die Grafikkarte "mit ohne Spulenfiepen" wie in deiner Signatur, sondern auch eine "mit ohne Effizienz" CPU dazu.

Über die Mehrkosten von einem einzigen Cent (!) im CPU Limit macht er sich bestimmt auch viele Gedanken bei Hardwarekosten von ~3.000€

Rockstar85

Admiral

- Registriert

- Sep. 2004

- Beiträge

- 8.385

Dieser User wurde gesponsort von Intel?

Alter manche Leute haben echt keine Hobbys

Ich kaufe erst dann einen Cove wieder, wenn Intel es schafft ihre ~20W pro P-Core einzubremsen..

AMD verbaut in der Größenordnung fast 2 Kerne.

Alter manche Leute haben echt keine Hobbys

Ich kaufe erst dann einen Cove wieder, wenn Intel es schafft ihre ~20W pro P-Core einzubremsen..

AMD verbaut in der Größenordnung fast 2 Kerne.

Snoop7676

Lt. Commander

- Registriert

- Mai 2019

- Beiträge

- 1.099

Geb ich dir recht.MalWiederIch schrieb:Über die Mehrkosten von einem einzigen Cent (!) im CPU Limit macht er sich bestimmt auch viele Gedanken bei Hardwarekosten von ~3.000€

Aber bist du "nur" gamer gibt es keinen Grund einen Intel einem AMD mit ordentlich extra Cache vorzuziehen.

Shader Compilen bei manchen Spielen ! 1x ! bei Start ist auch kein Argument.

Da die Spiel.exe sowieso automatisch auf den Pcores läuft bei Intel würde ich auch stark davon ausgehen, dass die Spiel.exe beim Shader Compilen ebenso nur diese nutzt. Also nutzen "Efficiency CoresTM" da auch nichts.

Der normale gamer weißt die Spiel.exe auch beim Compilen nicht mit Prozesslasso diese Zeit allen Cores zu, falls man den noch als Argument ran ziehen möchte.

Wirklich sehr höflicher Umgangston. Hattest bestimmt auch Schaum vorm Mund, während du deinen Hate Rant verfasst hast?mcsteph schrieb:So ein Schwachsinn. Mein System hat keine 15 Minuten gebraucht. Vor allem das mache ich genau ein mal!!!! Mit dem neusten Patch dauert es bei einem 5800x3d genau 10 Minuten!!!

Beitrag im Thema "The Last of Us Part I (PC) im Test: Grafisch Referenz, technisch (noch) nicht"

https://www.computerbase.de/forum/t...nz-technisch-noch-nicht.2137552/post-28197978

Also höre auf diese Unwahrheiten zu posten.

Ich sprach auch vom Launch bzw. die ersten Monate, und da war es nunmal so. Ich habs nach dem Patch 2 durchgespielt, und nicht wieder angefasst. Und man macht die Shader Kompilierung eben nicht einmal und gut ist, sondern bei jeden Treiberwechsel. Also hör du mal auf Unwahrheiten zu posten.

Und die meisten sind im GPU oder Gsync/Vsync Limit, da halbiert sich der eine Cent nochMalWiederIch schrieb:In dem Fall sind es nur 6% des Gesamtverbrauchs oder 0,0098€ pro Stunde im CPU Limit

DKK007

Lt. Commander

- Registriert

- Nov. 2015

- Beiträge

- 1.298

Samuelz schrieb:Ich sprach auch vom Launch bzw. die ersten Monate, und da war es nunmal so. Ich habs nach dem Patch 2 durchgespielt, und nicht wieder angefasst. Und man macht die Shader Kompilierung eben nicht einmal und gut ist, sondern bei jeden Treiberwechsel. Also hör du mal auf Unwahrheiten zu posten.

Die Frage ist, wie oft wechselt man den Treiber?

Die Performancevorteile halten sich in den meisten Fällen in Grenzen, wenn der Releasetreiber durch ist.

Wenn der aktuelle Treiber stabil läuft, würde ich da nicht wechseln.

Ähnliche Themen

- Antworten

- 59

- Aufrufe

- 6.854

- Antworten

- 101

- Aufrufe

- 10.502

- Antworten

- 165

- Aufrufe

- 20.220

- Antworten

- 434

- Aufrufe

- 46.331

- Antworten

- 381

- Aufrufe

- 43.700