Im Test vor 15 Jahren: SLI und CrossFire mit 2, 3 und 4 Grafikkarten

Nvidia SLI und ATi CrossFire ermöglichten mehreren Grafikkarten in einem Multi-GPU-Verbund Spiele zu rendern. Anfangs waren beide Technologien auf zwei Grafikkarten beschränkt. Doch im Test vor 15 Jahren mussten sich CrossFire und SLI von zwei bis vier GPUs behaupten – in der Praxis mit mäßigem Erfolg.

Das Multi-GPU-Versprechen

Sowohl AMD als auch Nvidia versprachen Anwendern mehr Leistung, wenn diese mehrere ihrer Grafikkarten kauften und koppelten – vorausgesetzt, die Serie bot das Feature und alle Modelle gehörten derselben Serie an.

Die grundlegende Idee war dabei, dass mehrere Grafikkarten die Arbeit aufteilen können, um somit insgesamt mehr Bilder pro Sekunde zu produzieren. In Spielen wurde dafür grundsätzlich auf Alternate Frame Rendering (AFR) gesetzt, bei dem die Grafikkarten sich der Reihe nach abwechselten beim Berechnen. Das alternative Split Frame Rendering (SFR), bei dem mehrere Grafikkarten zusammen ein Bild berechneten, konnte sich aufgrund niedrigerer Effizienz und hoher Komplexität nicht durchsetzen.

AFR war zwar effizienter als SFR, kam aber mit seinen eigenen Problemen. So lag die Skalierung von AFR ebenfalls weit weg von dem Idealfall, was in der Praxis bedeutete, dass Kunden für das doppelte Geld bei Weitem nicht die doppelte Leistung erhielten. Zudem bedingte AFR auch, dass jede Grafikkarte sämtliche Daten vorhalten musste – der Grafikspeicher war somit nicht additiv, sondern blieb effektiv bei dem einer einzelnen Grafikkarte bestehen. Das war ein limitierender Faktor, weil die Rohleistung (und der Stromverbrauch) durch mehrere GPUs massiv anstieg, diese aber nicht zwingend effektiv genutzt werden konnte, wenn der Grafikspeicher in hohen Einstellungen zu schnell voll lief.

Die wohl in der Praxis wichtigste Einschränkung waren allerdings „Mikroruckler“. Diese traten trotz hoher FPS in Spielen aufgrund schwankender Frametimes auf, wodurch es wirkte als würde das Spiel unruhig laufen.

Mehr als zwei GPUs war riskant

Im Test zeigte sich sowohl bei AMD als auch bei Nvidia, dass mehr als zwei Grafikkarten alles andere als ideal liefen. Bei dem Schritt von einer auf zwei Grafikkarten gab es noch zwischen 65 und 84 Prozent mehr Leistung, was angesichts der Mehrkosten von 100 Prozent zwar nicht perfekt war, sich aber in einem vertretbaren Rahmen befand. Deutlich schlechter sah es bei dem Schritt zu drei oder sogar vier GPUs aus. Gerade in niedrigeren Auflösungen kam hier wenig der Mehrleistung an – der sehr schnelle Intel Core 2 Extreme QX9770 limitierte.

Statt den theoretischen 50 Prozent Mehrleistung für drei statt zwei GPUs kamen in der Praxis in 1.680 × 1.050 Bildpunkten bei Nvidia nur 18 bis 22 Prozent und bei AMD 27 bis 37 Prozent an. In 2.560 × 1.600 fielen diese Zahlen etwas höher aus.

Der Schritt auf vier Grafikkarten lohnte sich dann in quasi keinem Szenario mit lediglich wenigen Prozent Mehrleistung.

Während die Messergebnisse selbst Dual-GPU-Konfigurationen in einem besseren Licht als Triple- und Quad-GPU-Systeme stehen ließen, kamen in der Praxis weitere Einschränkungen hinzu. Die Mikroruckler waren bei mehr als zwei GPUs so gravierend, dass Spiele quasi unspielbar wurden. Bei Nvidia waren die Mikroruckler generell weniger ausgeprägt als bei AMD, in beiden Fällen waren mehr als zwei GPUs aber kontraproduktiv. Zudem plagten Quad-GPU-Systeme Instabilitäten, die zu Abstürzen führten. Abgesehen davon stiegen Leistungsaufnahme, Lautstärke und Temperatur mit mehreren GPUs deutlich an.

Fazit

Am Ende des Tests konnte ComputerBase ein klares Fazit ziehen: Zwei Grafikkarten konnten sich in Ausnahmefällen lohnen, wenn es sich um High-End-Modelle handelte und es um maximale Leistung ging. Generell galt immer, dass eine High-End-Grafikkarte besser als zwei Mittelklasse- oder ältere Grafikkarten war. Mehr als zwei GPUs waren quasi keinem Nutzer zu empfehlen, vier GPUs waren quasi unbenutzbar und daher strikt schlechter als Konfigurationen mit weniger GPUs.

Diese Einschränkungen haben ultimativ dazu geführt, dass sowohl Nvidia als auch AMD von Multi-GPU im Endanwenderbereich abgeschworen haben. Die Nachteile überwogen die Vorteile bei weitem.

In der Kategorie „Im Test vor 15 Jahren“ wirft die Redaktion seit Juli 2017 jeden Samstag einen Blick in das Test-Archiv. Die letzten 20 Artikel, die in dieser Reihe erschienen sind, führen wir nachfolgend auf:

- HTCs G1 war das erste Smartphone mit Android

- AMD Phenom II auf Sockel AM3 mit DDR3 ohne Mehrwert

- Mit dem 790g-Megahalems direkt auf den ersten Platz

- Nvidias GeForce GTX 285 mit dem 55-nm-Boost

- Fünf Kühltürme für ein Halleluja

- Mit der Nvidia GeForce GTX 295 zurück zur Leistungskrone

- AMD mit dem Phenom II wie ein Phönix aus der Asche

- Dreimal Creative GigaWorks ohne Gigaklang

- Arctic Coolings Freezer Extreme mit schwachem Lüfter

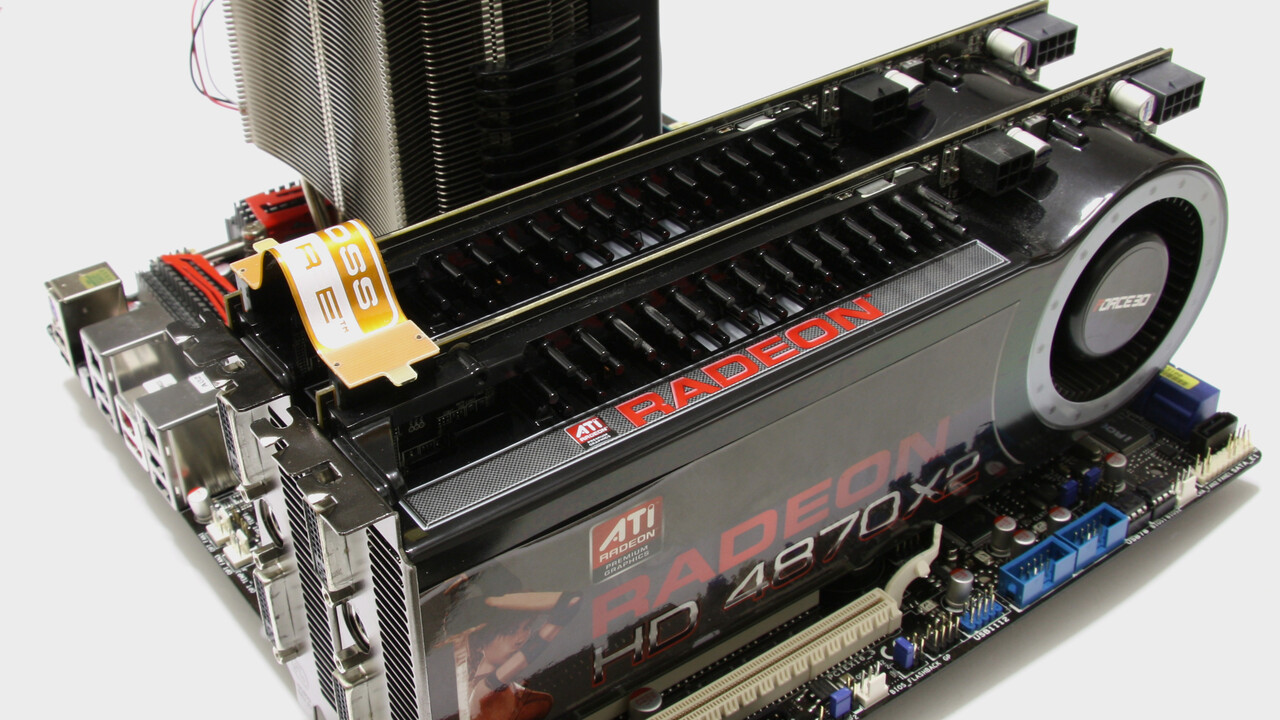

- Sapphires Radeon HD 4870 X2 mit Wasserkühlung

- Thermaltakes extravaganter Fächerkühler V14 Pro

- Die ungewöhnliche Ergonomie der Saitek Cyborg

- Wazabees 3D-Display ohne Brille glänzte mit Spielspaß

- Thermaltakes SpinQ als Hamsterrad-Luftkühler

- Der Asus Royal Knight war kein Ritter für Arme

- Der erste Intel Core i7 legte als echter Quad-Core vor

- ATis Radeon HD 4830 mit fehlerhaftem BIOS

- Teufels Motiv 5 verpasste eine Empfehlung haarscharf

- Intels Core 2 Duo E8600 im E0-Stepping

- Der Accelero TwinTurbo als kleine Schwester des S1

Noch mehr Inhalte dieser Art und viele weitere Berichte und Anekdoten finden sich in der Retro-Ecke im Forum von ComputerBase.