GeForce GTX 1080 im Test: Ein Paukenschlag in 16 nm mit 1,8 GHz und GDDR5X

3/13Erstmals Speicher vom Typ GDDR5X

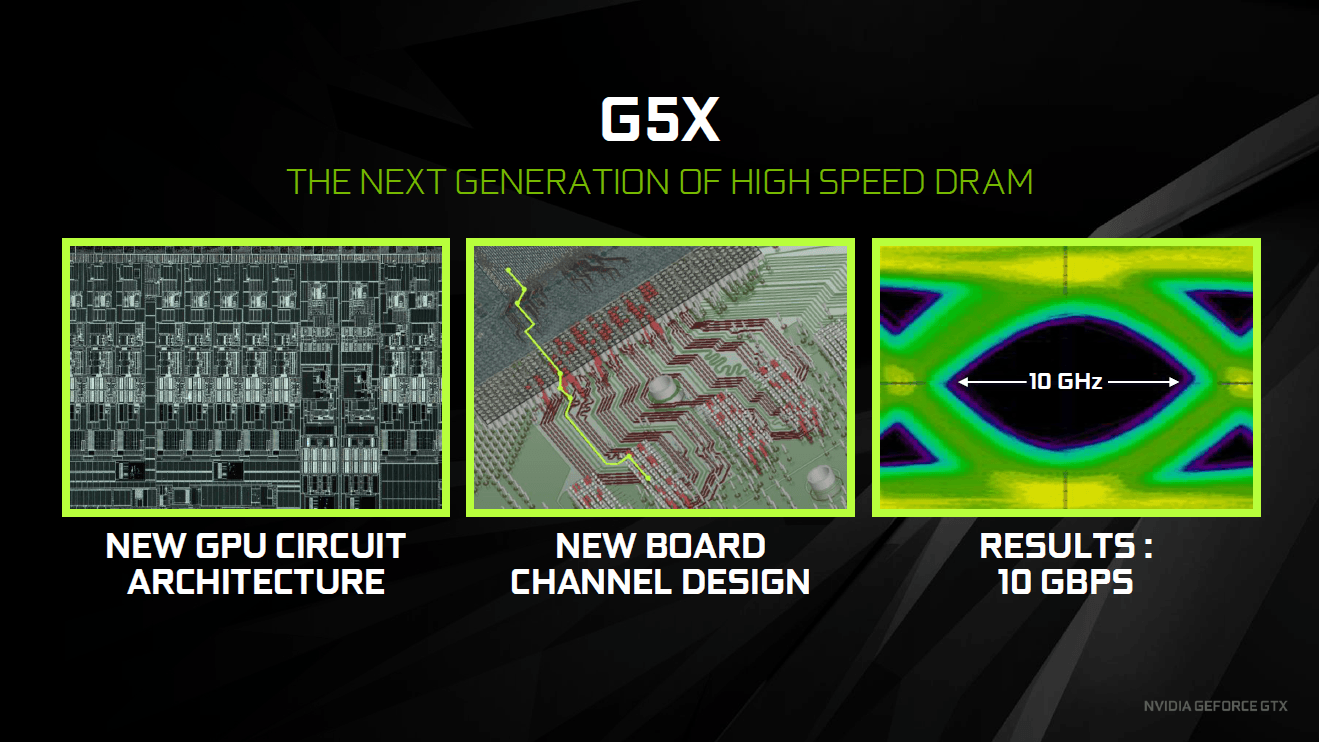

Auch wenn das Speicherinterface beim GP104 erneut 256 Bit breit ist, handelt es sich um einen neuen Memorycontroller: Die GeForce GTX 1080 setzt erstmals auf Speicher vom Typ GDDR5X. Er kommt mit einer doppelt so hohen Sample-Rate wie traditioneller GDDR5-Speicher daher und kann die Bandbreite beim gleichen Takt damit verdoppeln. Micron ist der erste und bisher einzige Speicherhersteller, der GDDR5X angekündigt hat und bereits in Serie fertigt. Die GeForce GTX 1080 nutzt die einzig aktuell verfügbare Version, die eine Bandbreite von 10 Gbps bietet – schnellere Varianten werden noch folgen. Aktuell kommt der schnellste auf Grafikkarten eingesetzte GDDR5-Speicher auf 7,5 Gbps.

GDDR5X soll aber nicht nur die Geschwindigkeit anheben, sondern zugleich die Energieeffizienz verbessern. So liegt die Spannung bei 1,35 Volt anstatt 1,5 Volt und auch sämtliche Signalleitungen im Controller wurden modifiziert. Durch diese Maßnahmen sollen 43 Prozent höhere Taktraten bei derselben Leistungsaufnahme möglich sein.

GDDR5X wird sich mit der Zeit auf 12 Gbps und 14 Gbps steigern

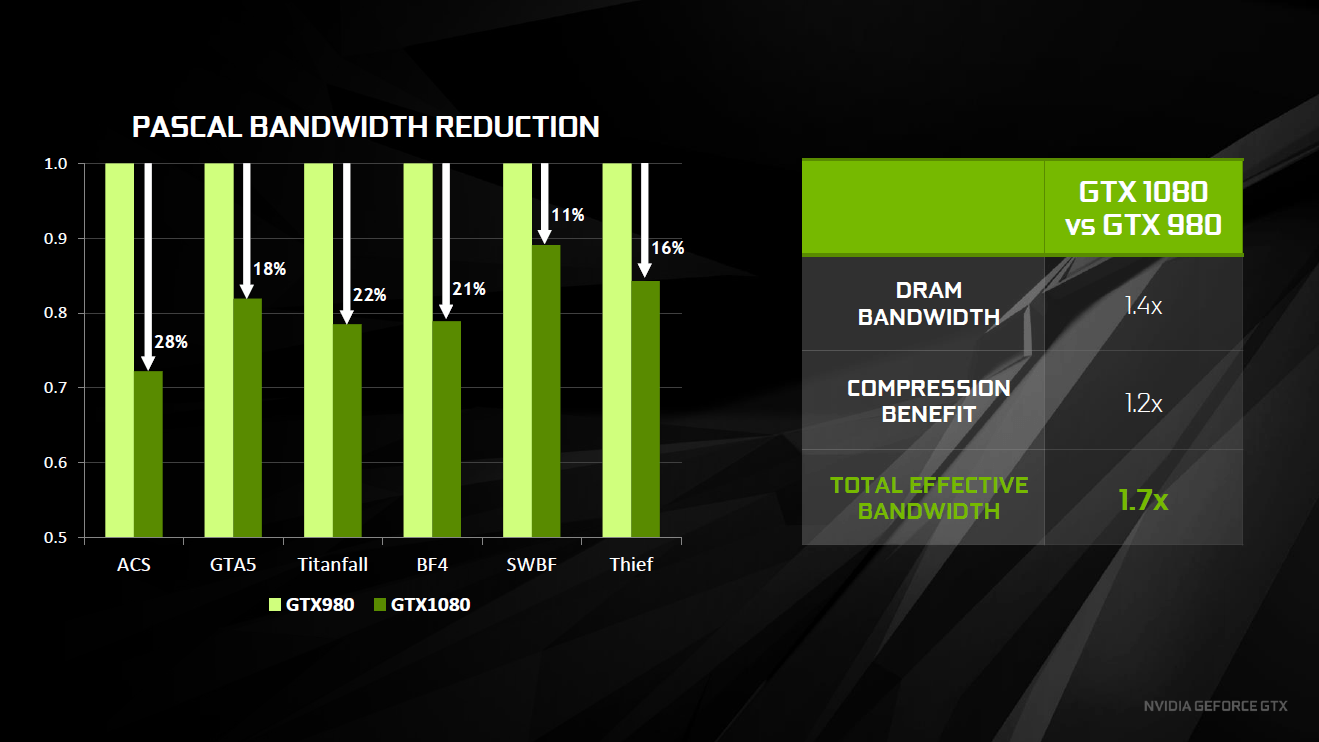

Nvidia hat bei Pascal auch erneut an der Speicherkompression geschraubt, die nun in der vierten Ausbaustufe vorliegt. Alte Kompressionstechnologien wurden verbessert und neue hinzu gefügt. So wurde die bekannte 2:1-Kompression bei der Delta Color Compression (Vergleich verschiedener Pixel mit zusammengefassten Delta-Werten) verbessert und zudem gibt es nun auch eine 4:1- sowie 8:1-Kompression. Laut Nvidia steigt die effektiv vorhandene Speicherbandbreite bei Pascal gegenüber Maxwell dadurch im Durchschnitt um 20 Prozent an.

Auch wenn Nvidia bei den Pascal-Diagrammen erstmals 32-Bit breite Speichercontroller einzeichnet, sollte dies nicht verwundern (8 × 32 = 256 Bit). Denn diese hatte Maxwell auch schon – wenn auch so nicht von Nvidia in den Diagrammen kommuniziert. Jeweils zwei 32-Bit-Controller sind in einem 64-Bit-Block untergebracht. Von diesen gibt es auf dem GP104 vier Stück.

Pascal und Asynchronous Compute

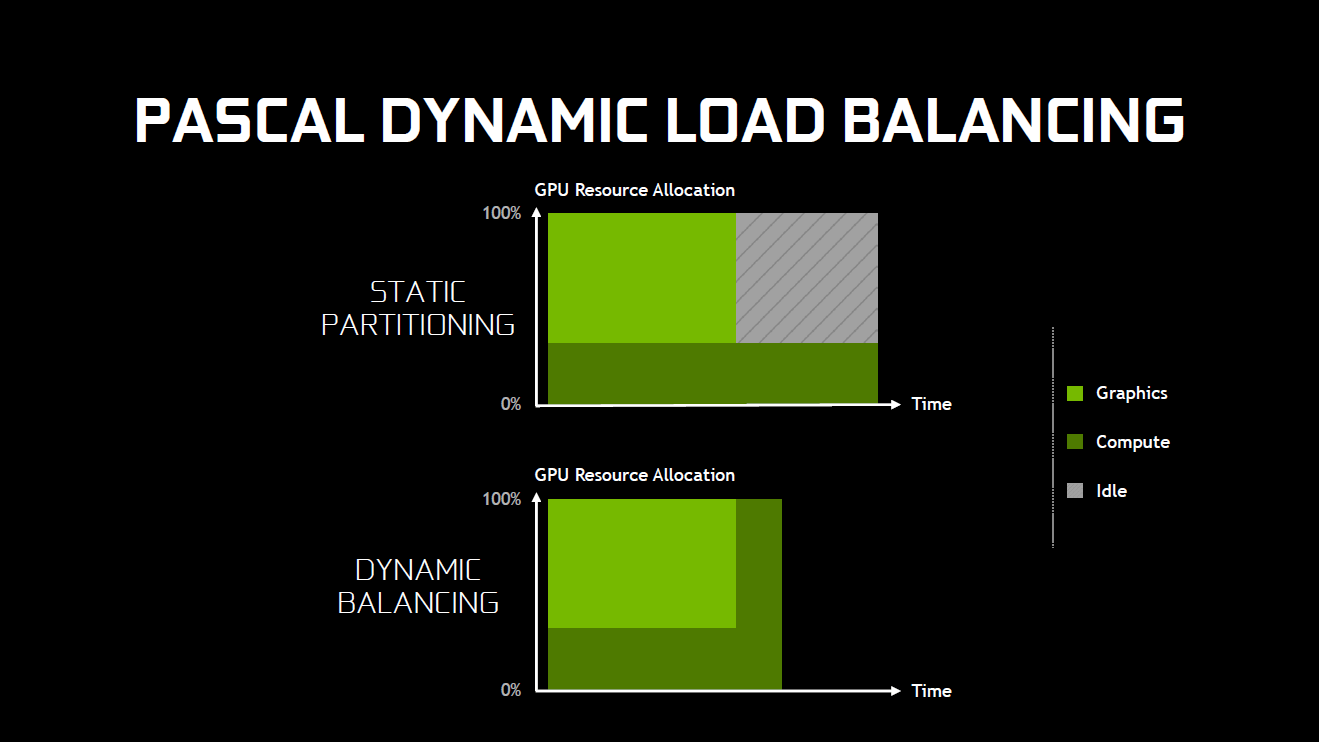

Das simultane Ausführen von Rendering- und Compute-Befehlen (Asynchronous Compute) wird mit Low-Level-APIs wie DirectX 12 oder Vulkan ein Thema. Maxwell konnte damit bisher nicht gut umgehen, während AMDs GCN-Archtiektur stark profitiert hat. Mit Pascal will Nvidia jetzt – allen Gerüchten zum Trotz – nachgeholfen haben. Damit bestätigt Nvidia allerdings auch die Probleme, die Maxwell in Hardware und nicht in Software hat.

Laut Nvidia beherrscht Pascal das dynamische Load Balancing jetzt deutlich besser als Maxwell. Rendering- oder Compute-Befehle können auf der neuen Architektur jetzt ohne Verzögerung und damit Blasen in der Pipeline eingeschoben werden.

Pascal nähert sich beim Async Compute AMDs GCN-Fähigkeiten an

Darüber hinaus ist es bei Pascal nun möglich, dass Berechnungen abgebrochen, die bis dahin fertigen Ergebnisse zwischengespeichert und die Berechnungen später beendet werden („Pre Emption“). Dies ist nötig, wenn plötzlich eine Rechenaufgaben dringend durchgeführt werden muss – zum Beispiel bei Asynchronous Timewarp.

Während Preemption für Compute grundsätzlich nichts Neues ist und so zum Bespiel auch von AMDs GCN-GPUs unterstützt wird, kann Pascal es auch für die Graphics-Pipeline durchführen (Pixel Level Preemption) – laut Nvidia als einzige GPU derzeit. Das Umschalten soll in weniger als 100 Mikrosekunden erfolgen können. Pixel Level Preemption ist bis jetzt noch nicht in DirectX 12 integriert, soll aber in einem Juli-Update folgen. Für Vulkan gibt es dagegen noch keinen Zeitpunkt. Wer CUDA nutzt, kann mit Pascal Preemption nun auch bis hinab zum Instruction Level nutzen.

Welche Vorteile Nvidia mit Pascal bei Anwendung von Async Compute erzielen kann, wird in den Sondertests am Ende dieses Artikels geklärt.

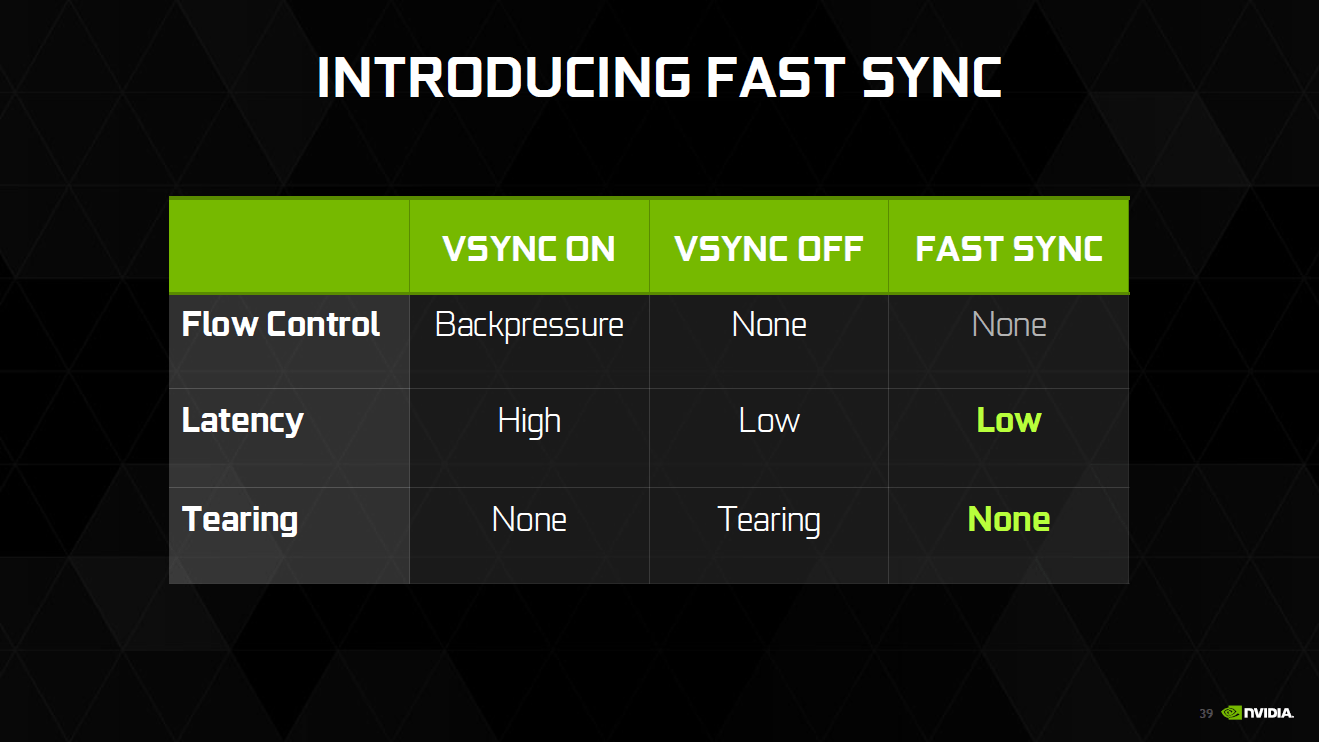

Fast Sync kombiniert VSync an und aus

Mit Pascal neu eingeführt wird die VSync-Technologie Fast Sync. Fast Sync richtet sich an Spieler, die gerne extrem hohe Frameraten nutzen, die über denen der Bildwiederholfrequenz des Monitors liegen. Fast Sync entkoppelt erstmals die Render- von der Display-Pipeline. Das hat zur Folge, dass das Spiel immer neue Frames anfordert und die GPU durchweg neue Frames rendert, im Gegensatz zu VSync aber trotzdem eine Synchronisation der beiden Komponenten stattfindet.

Fast Sync für viele FPS, G-Sync für wenig FPS

Mit Fast Sync können mehrere Bilder im Grafikkartenspeicher abgelegt werden. Hat der Monitor mit dem Refreshzyklus abgeschlossen, wird das letzte fertiggestellte Bild ausgegeben. Beträgt die Bildwiederholfrequenz 60 Hz, kann die GPU in der Sekunde 60 Bilder ausgeben. Fast Sync ist damit eine Kombination aus „V-Sync aus“ vor der Displayausgabe und „V-Sync“ an bei der Displayausgabe: Es gibt kein Tearing auf dem Monitor und die Eingabelatenz ist sehr gering – fast so gering wie mit abgeschaltetem V-Sync.

Während sich VRR-Techniken wie G-Sync und FreeSync für Spiele eignen, die weniger FPS liefern als die Bildwiederholfrequenz des Monitors ermöglichen würde, richtet sich Fast Sync an diejenigen Titel, die schneller laufen. Die beiden Techniken ergänzen sich.

Zum Start für Pascal, später auch für Maxwell

Fast Sync wird zunächst nur für Pascal freigeschaltet, wobei auch Maxwell zu einem späteren Zeitpunkt mit der neuen Sync-Technologie umgehen können soll.