domidragon

Fleet Admiral

- Registriert

- Juli 2008

- Beiträge

- 11.530

Danke für die Info. Sehr informativ!

Jetzt hast du mein Vertrauen in HD Tune zerstört

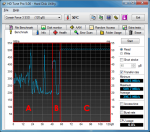

Nun, wenn ich mit diesem Tool teste, erreiche ich durchschnittlich 309mb/s.

Aber wieso ist das System dann so extreme langsam? Es dauert ohne witz teilweise 10 sekunden, bis der explorer offen ist! (in der VM, siehe unten, teilweise aber auch auf dem lokalen System)

Systeminfo:

Es sind 2 SSDs im Laptop verbaut.

Die Samsung 840er ist eine 1tb SSD, die nutzen wir für unsere VMs. (Die andere ist ebenfalls eine Samsung, aber mit 256gb und hat nen komischen Namen^^)

Bis vor ein paar Wochen konnte ich ohne Probleme 3 VMs gleichzeitig laufen lassen und damit arbeiten.

Seit dieser Zeit läuft alles enorm langsam. Ich habe mittlerweile ein Systemmonitoring Tool an, um die Werte zu sehen. Da kriegt die SSD auch selten mehr als 6mb/s raus, wenn ich was in der VM mache.

Beim Test zeigt es mir dann aber ebenfalls über 300mb/s an, also mit dem Tool oben.

Ich lasse über die Nacht mal die gesamte SSD benchen, dann sehe ich vlt. mehr.

Wenn das nichts ergibt, muss es softwareseitig sein, bzw. irgend ein Problem mit den VMs -.-

Jetzt hast du mein Vertrauen in HD Tune zerstört

Nun, wenn ich mit diesem Tool teste, erreiche ich durchschnittlich 309mb/s.

Aber wieso ist das System dann so extreme langsam? Es dauert ohne witz teilweise 10 sekunden, bis der explorer offen ist! (in der VM, siehe unten, teilweise aber auch auf dem lokalen System)

Systeminfo:

Es sind 2 SSDs im Laptop verbaut.

Die Samsung 840er ist eine 1tb SSD, die nutzen wir für unsere VMs. (Die andere ist ebenfalls eine Samsung, aber mit 256gb und hat nen komischen Namen^^)

Bis vor ein paar Wochen konnte ich ohne Probleme 3 VMs gleichzeitig laufen lassen und damit arbeiten.

Seit dieser Zeit läuft alles enorm langsam. Ich habe mittlerweile ein Systemmonitoring Tool an, um die Werte zu sehen. Da kriegt die SSD auch selten mehr als 6mb/s raus, wenn ich was in der VM mache.

Beim Test zeigt es mir dann aber ebenfalls über 300mb/s an, also mit dem Tool oben.

Ich lasse über die Nacht mal die gesamte SSD benchen, dann sehe ich vlt. mehr.

Wenn das nichts ergibt, muss es softwareseitig sein, bzw. irgend ein Problem mit den VMs -.-