Für die 10 Spiele die es derzeit gibt, wo man tatsächlich sagen kann RT bringt deutlich was, bezahlst du einen dicken Aufpreis. Kannst du ruhig machen, viele sehen das aber nicht ein.Ragnarök88 schrieb:In dem Spiel braucht man mit einer aktuellen AMD Karte nicht mal an RT denken. Und das ist auch der Grund warum Nvidia die Preise ansetzt wir sie sind.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Spider-Man: Miles Morales im Test: Noch spektakulärer und GPU-fressender als das Original

dampflokfreund

Lt. Junior Grade

- Registriert

- Okt. 2014

- Beiträge

- 436

Sehr guter Beitrag. Das ist richtig. Es ist sicherlich nicht schlecht, eine GPU mit mehr VRAM zu kaufen, da es noch viele Cross Gen Spiele gibt, die neue Streaming Methoden nicht nutzen. Aber der Trend geht ganz klar zu effizienteren Streaming Techniken. Plague Tale verbraucht irre wenig VRAM trotz sehr scharfer Texturen und hohem Detailgrad. Und das nutzt nicht mal SFS, es nutzt lediglich aus, dass Konsolen und PCs über SSDs verfügen.W0dan schrieb:Es gab schon vor 5 Jahren Spiele, die die 10 GB gesprengt haben und die Texturen waren trotzdem Mist.

Moderne Engines nutzen z.B. Virtual Texturing und können den Speicher damit sehr viel Effizienter nutzen und so trotz stark limitiertem VRAM Budget in der Nähe der Kamera immer die bestmöglichen Texturen anzeigen.

Spätestens mit Direct Storage und SFS soll das alles nochmal sehr viel effizienter werden.

Die Engine von Spider-Man scheint beides nicht zu nutzen, denn sobald man die Texturstufe wechselt, werden auch sofort die Texturen ausgetauscht.

Gut, zwischen Hoch und Sehr hoch ist nur an sehr wenigen Stellen ein größerer Unterschied sichtbar (gefühlt 95% der Texturen ändern sich nur auf Subpixel ebene) aber das unterscheidet sich halt deutlich von z.B. Doom Eternal welches stark auf Virtual Textures setzt und wo man eben erst mit den niedrigsten Einstellungen überhaupt eine Veränderung der Texturqualität sehen kann.

Auch allgemein scheint sich beim Memory Management viel optimieren zu lassen. Dying Light 2 hat den VRAM Bedarf mit Raytracing zuletzt auch nochmal deutlich reduzieren können...

Nvidia hat wohl darauf gesetzt, dass sich Virtual Textures und Direct Storage viel schneller duchsetzen.

So hat man eben fröhlich kostenoptimierung betrieben und sich gedacht "der VRAM wird in zukunft eh locker reichen" - non issue.

Aber man sieht ja was daraus geworden ist. Es gibt auch aufgrund der Situation in den letzten zwei Jahren immernoch überweigend CrossGen Spiele, die auf konventionelle Streaming Techniken setzen und so läuft halt der VRAM mit 8-10 GB hin und wieder mal über, wenn man versucht, ältere Engines nochmal mit verbesserter Grafik zu pushen.

Wie man das bewertet muss am Ende jeder selbst entscheiden. Ich bin mir ziemlich sicher, dass sich das Problem entspannen wird, je moderner die Engines werden. Bis dahin wird man aber auch immer wieder Spiele sehen, wo der Speicher nicht reicht. Wer also heute auf der sicheren Seite sein will, für den sind 8-10 GB aktuell einfach zu knapp und man muss den ein oder anderen Regler bedienen.

R

Ragnarök88

Gast

Das ist kein Problem, dafür gibt es die Werte in WQHD. Eine 4090 und 4080 die in 4K DLSS Quality immernoch im partiellen CPU Limit liegt nicht voll auszufahren, ist schon harter Tobak für einen GPU Test.Wolfgang schrieb:Das Problem in Spider-Man ist, dass bei aggressiveren RT-Einstellungen alles außer RTX 4090 in UHD zu langsam wird.

Ne so schlimm ist es nicht. Gerade mit Raytracing sind die Unterschiede hier doch eher im erwartbaren Rahmen. Dass AMD ohne Raytracing so sehr das Nachsehen hat, ist aber absolut ungewöhnlich.Ragnarök88 schrieb:In dem Spiel braucht man mit einer aktuellen AMD Karte nicht mal an RT denken. Und das ist auch der Grund warum Nvidia die Preise ansetzt wir sie sind.

In 4k mit Raytracing fehlen der 6900 30% zur 3090. Aus eigener Erfahrung kann ich sagen, dass mit dieser 4k mit DLSS/FSR Performance maxed out gut spielbar ist. Mit etwas optimierten Settings auch DLSS/FSR Quality.

Klar die fehlenden 30% wären sicher spürbar, aber RT Schatten auf "Mittel" und Reflexionen auf "Hoch" laufen mit FSR Performance sicher auch auf ner 6900 XT noch anständig. Und wenn man RT Schatten deaktiviert erstrecht.

Können wir diese ganzen grün-roten Diskussionen nicht mal (außen vor) lassen?

Edit: Okay nochmal zum Spiel ansich:

Der Port wirkt sehr rund und ist optisch nochmal ein klein bisschen über dem Vorgänger angesiedelt.

Die Aussagen aus dem Test zu DLSS und FSR würde ich so aber nicht komplett unterschreiben. Beide Verfahren funktionieren für mich genauso gut wie im Vorgänger. Und wenn XeSS nicht so zum Flackern neigen würde, wäre es eine tolle Alternative zu FSR. Rein bzgl. der Rekonstruktion feiner Details ist es FSR nämlich sichtlich überlegen.

Zuletzt bearbeitet:

Das glaub ich nicht. Die "kostenlose Marktstudie" zu Corona Zeiten hat Nvidia klar gezeigt was die Leute bereit sind zu bezahlen. Und man wäre doch schlecht beraten wenn man nicht das Maximum an Gewinn anstrebt.Ragnarök88 schrieb:In dem Spiel braucht man mit einer aktuellen AMD Karte nicht mal an RT denken. Und das ist auch der Grund warum Nvidia die Preise ansetzt wir sie sind.

AMD wird auch auf den gleichen Zug aufspringen, die habe ja auch nichts zu verschenken.

Tenchi Muyo

Captain

- Registriert

- Apr. 2006

- Beiträge

- 3.414

Bestätigt meinen Eindruck, dass der neue Teil insgesamt besser performt als der Vorgänger:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Gesualdo

Lt. Junior Grade

- Registriert

- Nov. 2020

- Beiträge

- 501

Das weiss ich. Dennoch danke.KingZero schrieb:Das Spiel kriegst du auf cdkeys.com für 34€.

Mir ging es um den Preis generell. Für ein Addon von 6-12h ist das viel. 35 € als regulären Preis fände ich angemessen.

@juwa

Da hast du durchaus recht.

Aber auf manche Spiele freue ich mich so sehr, dass ich sie dann gleich spielen möchte. 😊

Ich muss mich echt zusammenreißen um Hogwarts Legacy nicht vorzubestllen. 🙈

Nick.Bo

Lieutenant

- Registriert

- Apr. 2017

- Beiträge

- 609

Ich finde es wirklich sehr bemerkenswert wie seit knapp 2 Wochen immer mehr Meldungen erscheinen die 10GB RAM der 3080 wären nicht genug.

Ich hab nicht ein Spiel in 3440x1440 mit dem ich bisher Probleme hatte oder habe.

Das gleiche mit Darktide, die Spiele die gerade erscheinen sind ne reine DLSS 3 Werbung. Man nutzt steinalte Engines oder miese Konsolenports um hier Ängste zu schüren, zumindest scheint das mir so der Fall zu sein.

Aber ich verstehe in diesem Fall hier die Diskussion generell nicht, wir reden von Hardware die 2 Jahre alt ist. Man sollte nicht mehr erwarten alles in Ultra spielen zu können. Aber das Entwickler jetzt vermehrt Murks abliefern weil man ja DLSS 3 usw hat ist auch ein Armutszeugnis.

Ich hab nicht ein Spiel in 3440x1440 mit dem ich bisher Probleme hatte oder habe.

Das gleiche mit Darktide, die Spiele die gerade erscheinen sind ne reine DLSS 3 Werbung. Man nutzt steinalte Engines oder miese Konsolenports um hier Ängste zu schüren, zumindest scheint das mir so der Fall zu sein.

Aber ich verstehe in diesem Fall hier die Diskussion generell nicht, wir reden von Hardware die 2 Jahre alt ist. Man sollte nicht mehr erwarten alles in Ultra spielen zu können. Aber das Entwickler jetzt vermehrt Murks abliefern weil man ja DLSS 3 usw hat ist auch ein Armutszeugnis.

Kryss

Commander

- Registriert

- Sep. 2018

- Beiträge

- 2.598

Also, habs mir gestern gegönnt, allerdings bei nem Key Reseller für 33 Euro, weil mir Vollpreis für ein 7-9 Stunden Spiel als unverschämt erscheint, sorry. (Und bevor sich wieder jemand darüber echauffiert... ich hab den Vorgänger schon zu Konsolen Vollpreis auf der PS4 Pro gespielt und imo Sony genügend Geld an exclusives in den Rachen geschmissen...!)

Eben fertig installiert und mal kurz angespielt so 15 Minuten...

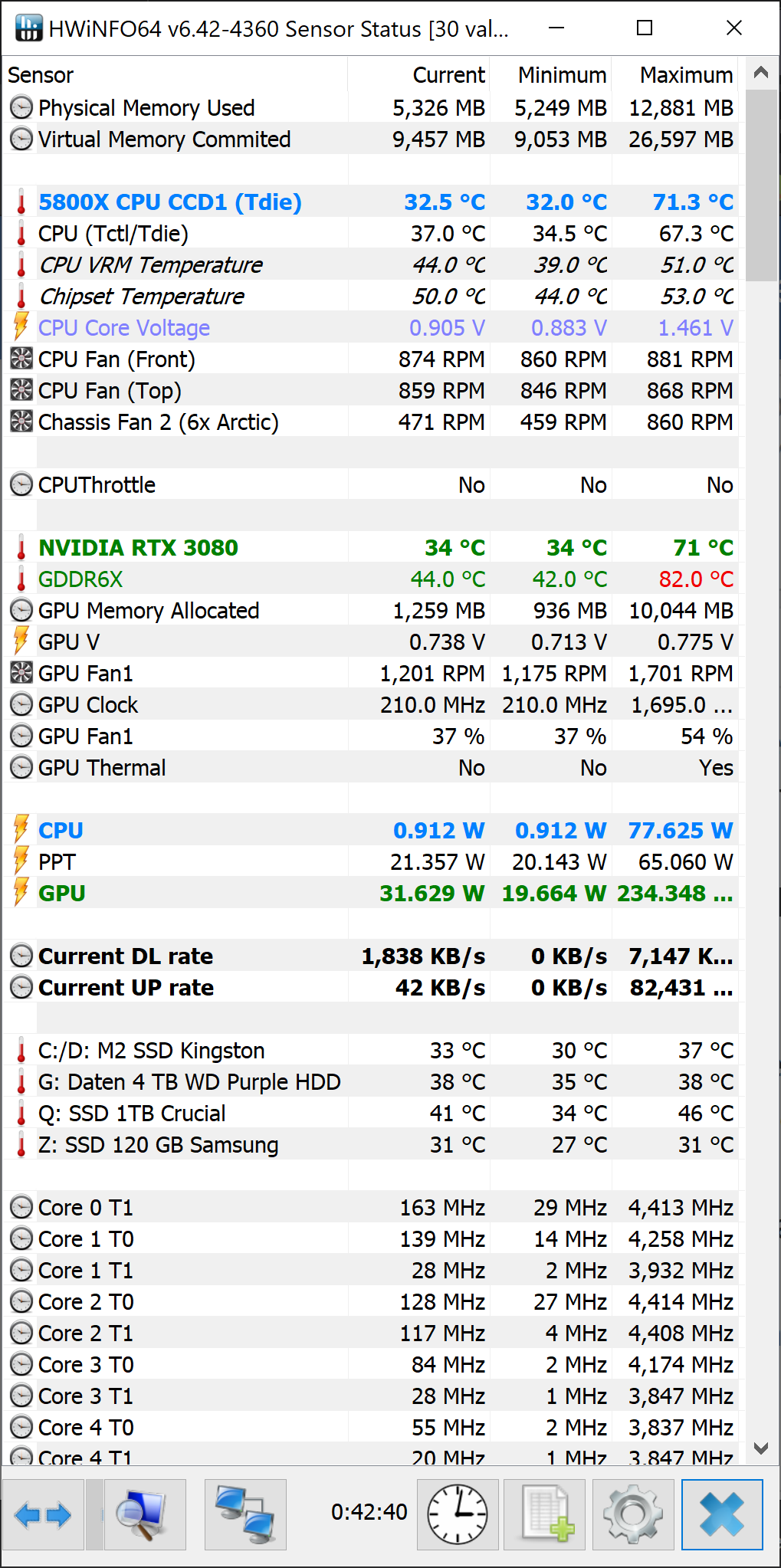

Performance mit nem 5800x (65 Watt) und ner 3080 10GB (stark undervolted) mit 32 GB Ram super. 4K, Hoch, DLSS Performance und Raytracing hoch (darunter gibts ja gar nix?!) und wirklich sehr smooth zu spielen, fast immer 60 FPS. Grafik ist Hammer. DLSS merke ich in keiner Sekunde, alles wirkt sehr "crisp". Bei Treppen merkt man paar Artefakte, aber gefühlt war das ja schon sehr oft problematisch, auch in anderen Spielen / Engines.

Kampsystem wirkt sehr spassig, pew pew pew *G

Nur mal meine paar Cent dazu.

Freu mich auf ein entspanntes WE zum zocken.

Edit: Der Vollständigkeit halber, also die 10 GB VRam nutzt das Spiel schon gut. Mal schauen wie es in längeren Sessions wird. Zur Not mal Neustart, auch nix schlimmes für mich.

vg Chris

Eben fertig installiert und mal kurz angespielt so 15 Minuten...

Performance mit nem 5800x (65 Watt) und ner 3080 10GB (stark undervolted) mit 32 GB Ram super. 4K, Hoch, DLSS Performance und Raytracing hoch (darunter gibts ja gar nix?!) und wirklich sehr smooth zu spielen, fast immer 60 FPS. Grafik ist Hammer. DLSS merke ich in keiner Sekunde, alles wirkt sehr "crisp". Bei Treppen merkt man paar Artefakte, aber gefühlt war das ja schon sehr oft problematisch, auch in anderen Spielen / Engines.

Kampsystem wirkt sehr spassig, pew pew pew *G

Nur mal meine paar Cent dazu.

Freu mich auf ein entspanntes WE zum zocken.

Edit: Der Vollständigkeit halber, also die 10 GB VRam nutzt das Spiel schon gut. Mal schauen wie es in längeren Sessions wird. Zur Not mal Neustart, auch nix schlimmes für mich.

vg Chris

Zuletzt bearbeitet:

Danke für den Test, aber könnt ihr euch erklären wieso THG mit der gleichen CPU keinen so krassen Unterschied zwischenWolfgang schrieb:

den RX und den RTX sieht? Da sind die AMD-Karten entweder gleichauf, kurz dahinter und hier und da sogar vor ihren

"Pendants", also 6800XT vs 3080 zB. Auf CB gibt es aber 20-30% Unterschied? Und gemeint ist hier nichtmal mit RT on.

Kenne ich nur zu gut, bin da genauso drauf... gewesen.Gesualdo schrieb:Da hast du durchaus recht.

Aber auf manche Spiele freue ich mich so sehr, dass ich sie dann gleich spielen möchte. 😊

Ich muss mich echt zusammenreißen um Hogwarts Legacy nicht vorzubestllen. 🙈

Tief durchatmen und an andere Dinge denken, die haben mich von dieser Zero-Day-Kaufmanie befreit. Auch das ein oder andere Katzenvideo auf TikTok hat uns bei unserer Selbsthilfegruppe geholfen [/ironie].

handy.dealer

Lt. Junior Grade

- Registriert

- Jan. 2006

- Beiträge

- 320

Ich bin 50+ und schwinge mich noch durch die Stadt....einfach weil ich es kann😄Lan_Party94 schrieb:Was hat das Spiel mit dem Alter zu tun? Animal Crossing ist kein FSK16/18 Titel und wird von vielen erwachsenen gespielt. Ich will gar nicht erst mit Pokemon anfangen!

Die Spiderman spiele sind super, dafür muss man keine 12 sein, man kann sogar mit 40+(bin ich zum Glück noch etwas von entfernt) Spaß dran haben - stell dir vor!

Legalev schrieb:und stört mich mit meiner 6800xt überhaupt nicht.

Demnächst ne 7900XTX

Darf ruhig langsamer sein und RT ist mir eh egal

Mir persönlich ist Raytracing auch völlig egal, sicher, daß Auge spielt mit, aber vor Allem geht es doch um Spielspaß, oder?

Und wenn ich spiele, dann stehe ich auch manchmal in der Gegend rum und schaue mir die schöne Umwelt an, wie zB. in Shadow of the Tomb Raider, aber ich suche nicht explizit nach flimmernden Ecken und Kanten, dafür sind meine Augen eh nicht mehr gut genug.

Mag jetzt sein, daß Nvidia mal wieder besser abschneidet als AMD, ja und, dann ist dem halt so.

Ich kaufe mir wenn eine Grafikkarte, die zu meinem Paket paaßt, und nicht nur für ein Spiel.

Und zur Zeit wären für mich die AMD- Karten die Wahl, wenn ich eine neue GPU bräuchte.

Aber Essig, brauch ich eben nicht, so werkelt weiterhin meine olle 1070ti weiter, bis zu ihrem Ableben.

Und es wäre mal wieder bewiesen: mit allen möglichen Reglern auf mehr als voll Rechts bekommt man jede Grafikkarte klein.

Das ist doch im Endeffekt egal. Die meisten kaufen die Spiele sowieso nicht zum Release. Schau lieber die Performance nach 1 - 3 Jahren mal an.ben12345 schrieb:Optisch gefällt mir AMD treibermäßig auch besser also was das Overlay der Software angeht. Da ist Nvidia ne Katastrophe. Aber das ist eher unwichtig, was den Treibersupport der Spiele angeht wischt Nvidia leider immer noch den Boden mit AMD.

Ich habe leider zu oft schon gesehen das die Nvidia Karten Anfangs sehr Stark sind, aber dann Fallen sie gegenüber AMD zu sehr ab. Gibt genug Beispiele.

Ansonsten wer mit Raytracings zocken will sollte zu Nvidia greifen. Aber der nötige Vram sollte auch vorhanden sein. Unter einer RTX 3080 10 - 12 GB lohnt es sich einfach nicht.

Ansonsten sind die Hardware Anforderungen echt hoch.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.625

Tun sie ja nicht alle. Gibt ja welche, die das vorbildlich integriert haben und weiter dabei sind das zu optimieren.Nick.Bo schrieb:Aber das Entwickler jetzt vermehrt Murks abliefern weil man ja DLSS 3 usw hat ist auch ein Armutszeugnis

Bright Memory Infinite- Update vom 16.11.

Somit wird die beste Integration von DLSS3+FG bisher also noch besser. Wir sehen also- Es geht, wenn man will.Hello everyone! We've released a new update just in time for the release of the NVIDIA RTX4080.

The input lag after turning on DLSS3 has been reduced from 38ms to 27ms.

Und das für einen kleinen Mini- Entwickler.

https://www.keyfuchs.de/firma/fyqd-studio

Nicht alle treiben Schindluder mit den neuen Techniken.

MagicPumpkin

Banned

- Registriert

- Juni 2022

- Beiträge

- 29

AMDKollo schrieb:"Davon abgesehen ist noch die generell schlechte Performance von AMD-Grafikkarten zu erwähnen".

Ist daran AMD schuld oder der Spiele-Entwickler?

- Registriert

- Nov. 2002

- Beiträge

- 8.691

Albern und Schwachsinn wäre es, bei einem Spiele-Test in Einstellungen zu testen, wo einzig und alleine die RTX 4090 gerade einmal so (und wirklich nur ganz knapp) 60 FPS erreicht und selbst die RTX 4080 bei 4x FPS rumkrebst. Das wäre schwach und albern. Das Miles Morales echt schnell in ein CPU-Limit gerät, wenn man die GPU-Last leicht reduziert, ist nicht unser fehler.Ragnarök88 schrieb:Wo sind die 4K RT Benchmarks???

Absolut mäßiger Test, die 4090 kann sich ja gar nicht von der 4080 absetzen, da CPU Limit!

Schwach und albern!

Wieso testet ihr mit DLSS in 4K???

Die Benchmark-Ergebnisse zwischen uns und THG sind sogar ziemlich ähnlich, wenn du mal genau hinschaust (ist nicht ganz einfach das richtige Diagramm zu finden).daivdon schrieb:Danke für den Test, aber könnt ihr euch erklären wieso THG mit der gleichen CPU keinen so krassen Unterschied zwischen

den RX und den RTX sieht? Da sind die AMD-Karten entweder gleichauf, kurz dahinter und hier und da sogar vor ihren

"Pendants", also 6800XT vs 3080 zB. Auf CB gibt es aber 20-30% Unterschied? Und gemeint ist hier nichtmal mit RT on.

THG hat in Ultra HD Nativ ohne RT die RX 6950 XT auf dem Niveau der RX 6800 XT. Bei uns ist die RTX 3080 8 Prozent schneller als die RX 6900 XT. Jetzt ist die RX 6950 XT etwa 6 Prozent schneller als die RX 6900 XT - und schon haben THG und wir quasi dieselben Ergebnisse.

DJKno

Admiral

- Registriert

- Okt. 2005

- Beiträge

- 8.469

Das ist leider nicht mehr aktuell.anappleaday schrieb:1. Treiber sind besser.

Auch nVidia hat sich in letzter Zeit einige Böcke im Treiber geleistet. Dazu kommt noch immer diese Zweigleisigkeit zwischen GeForce Experience und der eigentlichen Treibersoftware, die dann auch noch aussieht wie aus XP Zeiten.

Da ist AMD mit der Software deutlich weiter. Taktrate und Spannungen kann AMD direkt im Treiber. Nv braucht dafür Drittanbieter.

Ähnliche Themen

- Antworten

- 81

- Aufrufe

- 9.481

- Antworten

- 19

- Aufrufe

- 2.566

- Antworten

- 411

- Aufrufe

- 63.481

- Antworten

- 21

- Aufrufe

- 4.856

Leserartikel

Kühler- gegen Steckergate: DevPandis Hin und Her

- Antworten

- 72

- Aufrufe

- 16.674