ATi Radeon X1950 XTX und X1950 CrossFire im Test: Der letzte Direct3D-9-Nachbrenner

3/43Technik im Detail

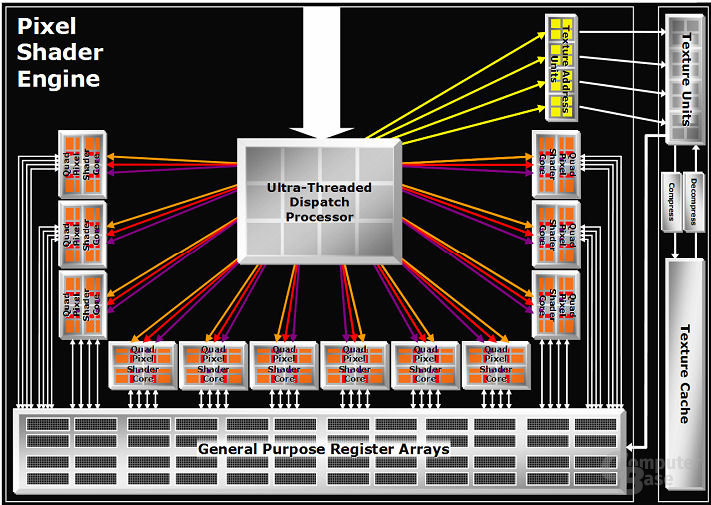

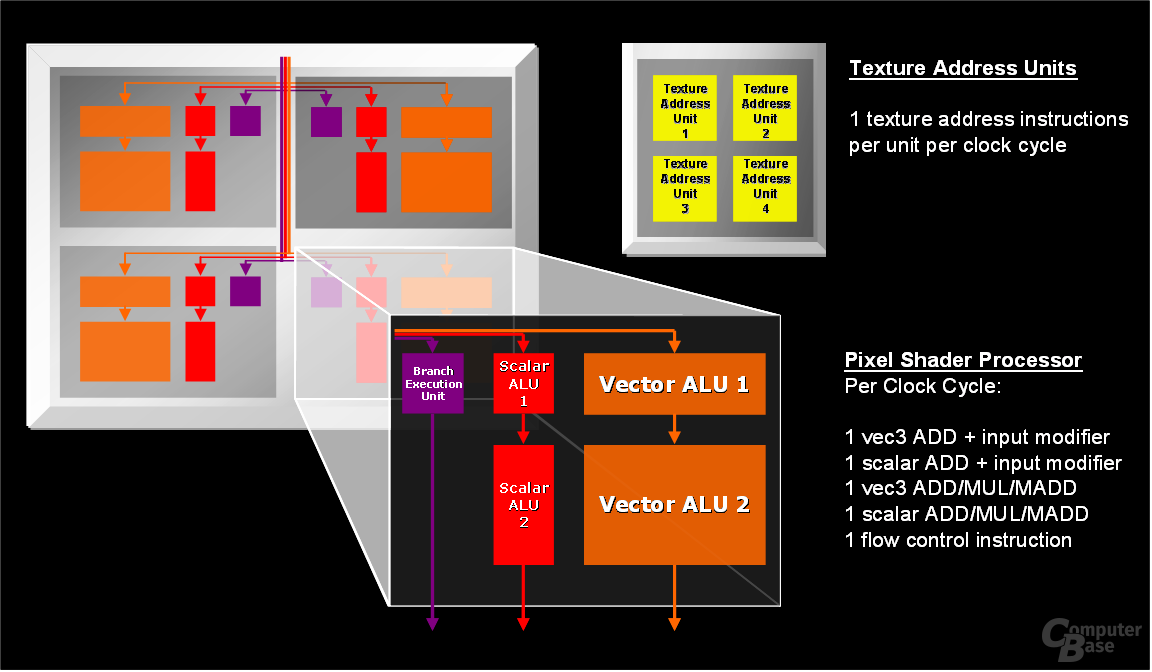

Technologisch gesehen vereint die ATi Radeon X1950 XTX Langeweile mit einigen interessanten Details. Die GPU ist ein alter Bekannter, der – bis auf kleine Modifikationen – in dieser Form bereits auf der Radeon-X1900-Serie eingesetzt wird. Dementsprechend fällt die Namensänderung von „R580“ zu „R580+“ auch nur marginal aus. Es gibt zwei Änderungen am R580+, wobei eine eher kosmetischer Natur ist. So wurde der Chip überarbeitet, um die Yield-Rate zu verbessern, und der Memory-Controller wurde modifiziert – doch dazu später mehr. Die GPU wird entgegen mancher Gerüchten erneut im 90-nm-Verfahren bei TSMC gefertigt und benötigt satte 384 Millionen Transistoren. Der R580+ besteht aus 16 Pixel-Pipelines mit jeweils drei komplett gleichen Shader-Einheiten.

Eine Shader-Einheit kann dabei eine MADD- (Multiply-Add; Multiplikation und Addition) sowie ADD-Berechnung (Addition) durchführen. Im Gegensatz zu den ALUs auf einer G7x-GPU sind die Shader-Einheiten im ATi-Chip parallel angeordnet. Dies hat unter anderem den Vorteil, dass bei einem Texturzugriff keine Arithmetic Logical Unit blockiert wird, wobei aber unklar ist, wann genau ein Texturzugriff die Shader-Einheiten auf einer aktuellen nVidia-Karte blockiert.

Der R580+ beinhaltet 16 Texture Mapping Units sowie 16 Raster Operation Processors und acht Vertex-Shader – diesbezüglich ist alles beim Alten geblieben. Der Chiptakt ist mit 650 MHz ebenfalls identisch zu dem auf einer Radeon X1900 XTX. Im Vergleich zur GeForce 7900 GTX kann die Radeon X1950 XTX somit mit 374 GFLOPS (Floating Point Operations Per Second) deutlich mehr Gleitkommazahl-Operationen ausführen, allerdings hinken die Kanadier in der immer noch wichtigen Texelfüllrate weit hinterher. Gleiches gilt für die GeForce 7950 GX2, wobei diese zumindest in der Theorie bei der maximalen Effizienz den Vorsprung weiter ausbauen kann. Auf der Radeon X1950 XTX wird ein HDCP-Key-ROM verbaut, sodass HDCP-geschützte HD-Videos problemlos auf der Grafikkarte abgespielt werden können.

Der 512 MB große VRAM, welcher von Samsung mit einer Zugriffszeit von 0,9 ns produziert wird, ist mit einem klassischen 256 Bit breiten Speicherinterface verbunden. ATi kann in diesem Punkt den Vorteil verbuchen, dass der Memory-Controller auf dem R5x0 aus acht 32 Bit großen Kanälen besteht, während der G7x von nVidia auf ineffizientere vier 64-Bit-Kanäle zurückgreifen muss. Der viel umworbene „Ringbus-Controller“ ist dagegen eher ein mächtiges Marketinginstrument, denn eine klassische „Crossbar“ stellt immer noch die beste Lösung dar. Durch den Ringbus-Controller war es ATi möglich, Transistoren einzusparen.

Kommen wir nun noch einmal zurück auf die Modifizierungen des Memory-Controllers: Um trotz identischer GPU einen Performancezuwachs zu erzielen, verbaut ATi auf dem neuen Flaggschiff erstmals auf einer Grafikkarte für den Heimanwender GDDR4-Speicher. Dieser taktet mit sehr hohen 1000 MHz, was einer Speicherbandbreite von satten 64 GB pro Sekunde entspricht. Die GeForce 7900 GTX muss sich dagegen mit etwa 51 GB begnügen, was vor allem bei der Verwendung von Anti-Aliasing in hohen Auflösungen ein Nachteil ist.

Der aufmerksame Leser wird sich sicherlich fragen, warum ATi den Speichercontroller für den Einsatz von GDDR4-Speicher modifizieren musste, denn immerhin warb man bereits beim R520 mit einer theoretischen Unterstützung von GDDR4-Speicher. Dies ist so auch richtig, wie Joe Macri, Mitarbeiter bei ATi und Mitglied der JEDEC-Kommission, uns gegenüber in einem Gespräch erwähnte. Jedoch war es nötig, Optimierungen am Speichercontroller des R580+ vorzunehmen, damit dieser fehlerfrei und mit der maximal möglichen Performance arbeiten kann.

Beschäftigen wir uns nun etwas genauer mit dem GDDR4-Speicher. Das Ziel der JEDEC war es, die Taktrate zu erhöhen, gleichzeitig allerdings den Stromverbrauch senken zu können, damit der Stromverbrauch bei noch höheren Taktraten nicht ins Unendliche steigt. Dies konnte man mit einer Modifizierung des GDDR3-Speichers erreichen. GDDR4 ist keine komplette Neuentwicklung und grundsätzlich abwärtskompatibel zu GDDR3-VRAM.

Ein Blick in die Innereien des GDDR4-Speichers verrät, dass die Spezifikationen für die Spannungsversorgung auf 1,5 Volt gesenkt worden sind. GDDR3-Speicher arbeitet dagegen mit 1,8 Volt. Um höhere Taktraten möglich zu machen, ist eine maximale Spannung von 1,8 Volt möglich, was immer noch unter dem Maximalwert für hochwertigen GDDR3-VRAM liegt, der bei 2,0 Volt angegeben ist. Da die elektrische Spannung sich im Verhältnis zur Leistung nicht linear sondern quadratisch verhält, ist die Einsparung höher als man auf dem ersten Blick vermuten könnte (etwa 30 Prozent).

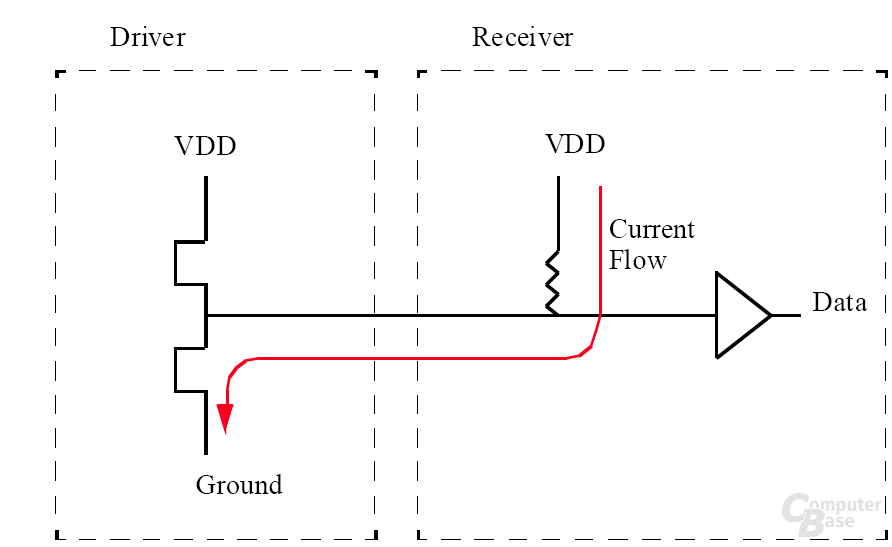

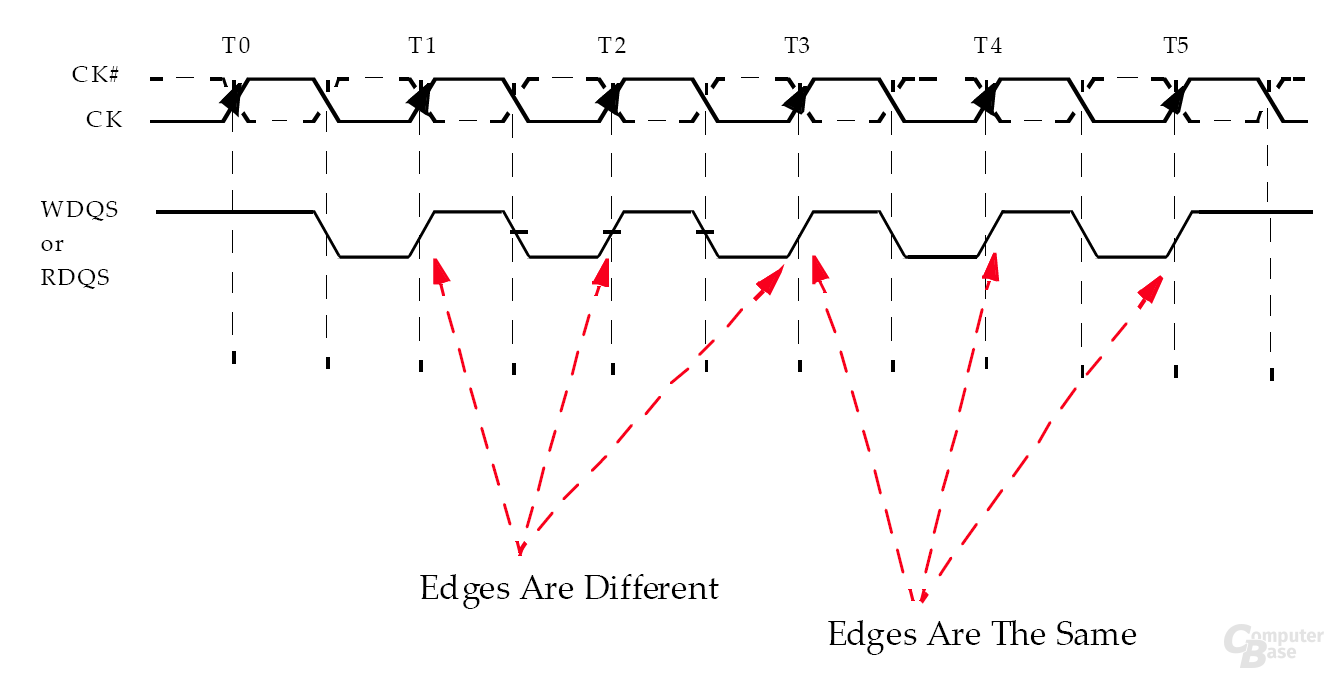

Zudem wurde unter anderem das Problem des „VDD-Noise“ (Störungen bei der positiven Versorgungsspannung) vermindert, wodurch höhere Frequenzen möglich werden. Erreicht wurde dies durch eine „Data Bus Inversion“ (DBI). Bekanntlicherweise arbeitet in der Welt der Computer jede Software sowie Hardware mit der Zahl „1“ und „0“. Beim Speicher benötigt einzig der Datenzustand einer logischen „0“ Strom, weswegen optimalerweise nur der Wert „1“ vorhanden sein sollte.

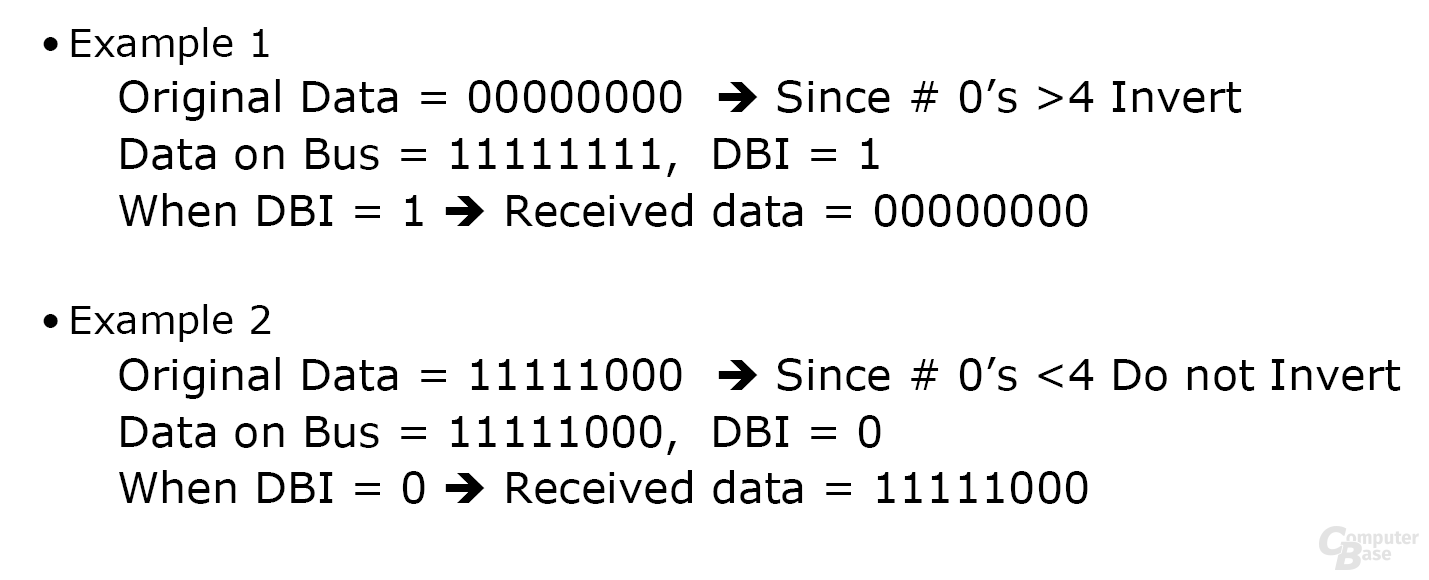

Falls bei GDDR4-Speicher mehr als vier „Nullen“ vorhanden sind, werden die Daten invertiert, indem das DBI-Bit gesetzt wird. Aus dem Wert „00000000“ wird beispielsweise durch das Invertieren und Setzen des DBI-Bits „11111111“. Auf dem Datenbus wird später erkannt, dass das DBI-Bit gesetzt ist und die Invertierung wird wieder rückgängig gemacht, womit man den originalen Datenzustand („00000000“) erhält.

Ebenso wurde die „Jitter-Problematik“ (Veränderungen der Daten durch Schwankungen der Genauigkeit) verbessert und die benötigte Anzahl der Pins zur Adressierung halbiert. Die dadurch freigewordenen Pins sind nun mit Masse oder dem eigentlichen Strom belegt.