Liebe Freunde der Sonne und der Nacht, ich habe Euch etwas mitgebracht.

Wie der Zufall es so möchte, baue ich mir ein zweites System auf. Nun stellt sich die Frage nach der GPU...und tadaaaa...die 1060 steht vor der Tür, aber ich brauche Abwechslung.

Somit eröffne ich hier wieder und wollte bereits ankündigen, dass eine RX480 mit 8GB im Landeanflug ist. Ich habe mich für das derzeitige Topmodell von XFX entschieden. Die Black Edition mit Custom Backplate. Die Karte ist ab Werk schon ordentlich übertaktet.

http://www.xfxforce.com/de/products/amd-radeon-rx-400-series/rx480be-rx-480m8bba6

Ich nehme die Referenzversion da ich mir (extra für HisN) die Option für Crossfire offenhalten möchte. Macht mit Midrange Karten nicht wirklich Sinn, aber ich habe Spaß dran.

Die beiden 970er sind mittlerweile einer 1080 gewichen.

Ich werde die 480 natürlich im Hauptrechner testen, sonst wäre das unfair.

Kurz zur 1080, ein Traum...wirklich. Der Preis ist zwar recht brutal, dafür ist die Performance und Effizienz ebenso brutal.

Obgleich ich sagen muß, dass ich relativ viel Overwatch spiele und die beiden 970er dort die 1080 wirklich alt aussehen lassen.

Ich habe noch nie so gutes Multi-GPU Scaling wie bei Overwatch gesehen.

Vielleicht wird mich die 1080 aber auch zeitnah wieder verlassen, da die Titan P vor der Tür steht und ich einen Freund habe, der mir meine Karte zum Neupreis abkaufen würde. Da käme mir die 480 gerade recht.

Abschließende Bemerkung zu meinem Ziel...Battlefield 4 1080P mit 144FPS durchgehend auf Ultra Settings.

Kurzum, unmöglich ^^. Vielleicht mit einem 6700K und 5,8Ghz, sonst eher nicht. Egal welche GPU man einsetzt, die CPU wird der Flaschenhals sein. Mittlerweile spiele ich competitive und daher eh auf 720P Medium Settings. Selbst da bricht die CPU manchmal von 200FPS auf 120 ein und das merkt man deutlich.

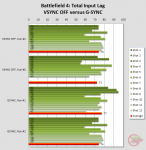

Bestes Spielerlebnis in BF4 Ultra 144Hz in 1440P war die Benutzung von Gsync. Damit läuft es wirklich flüssig. Aber, es kommt zu massivem Inputlag. Auch die Hitreg wird grausam mit Gsync (reproduzierbar). Daher kann ich bei Shootern nur von Gsync abraten.

Sollte Battlefield 1 die Battlefront Engine geerbt haben, wird man deutlich mehr FPS bekommen als bei BF4, das wird sich noch zeigen. Ziel, Battlefield 1 und Ovewatch mit 1440P und 144FPS konstant spielen zu können in Max Settings.

Los gehts