J

jtsn

Gast

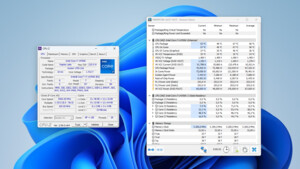

Spiele-Engines laufen auf Gleitkomma-Prozessoren (FPU). Ein AMD "6-Kerner" hat davon 3 Stück, ein "8-Kerner" 4 Stück. Intel 4-Kerner haben davon ebenfalls 4 Stück, welche auch noch wesentlich performanter sind.Bärenmarke schrieb:Selten so einen Unfug gelesen!

Lastet eine SW alle vorhanden Kerne aus, sind intel 4 kerner meilenweit davon entfernt auch nur ansatzweise schneller zu sein

Wenn du dich auf die IPC und Singlecoreleistung beziehst, kennzeichne es entsprechend!

AMD kann weiter oben einfach nicht mehr mitreden, deswegen kommen auch keine neuen Chipsätze für AMDs Performance-Plattform mehr.

Zuletzt bearbeitet: