cm87

Mr. RAM OC

- Registriert

- Apr. 2018

- Beiträge

- 8.920

Spät aber doch:

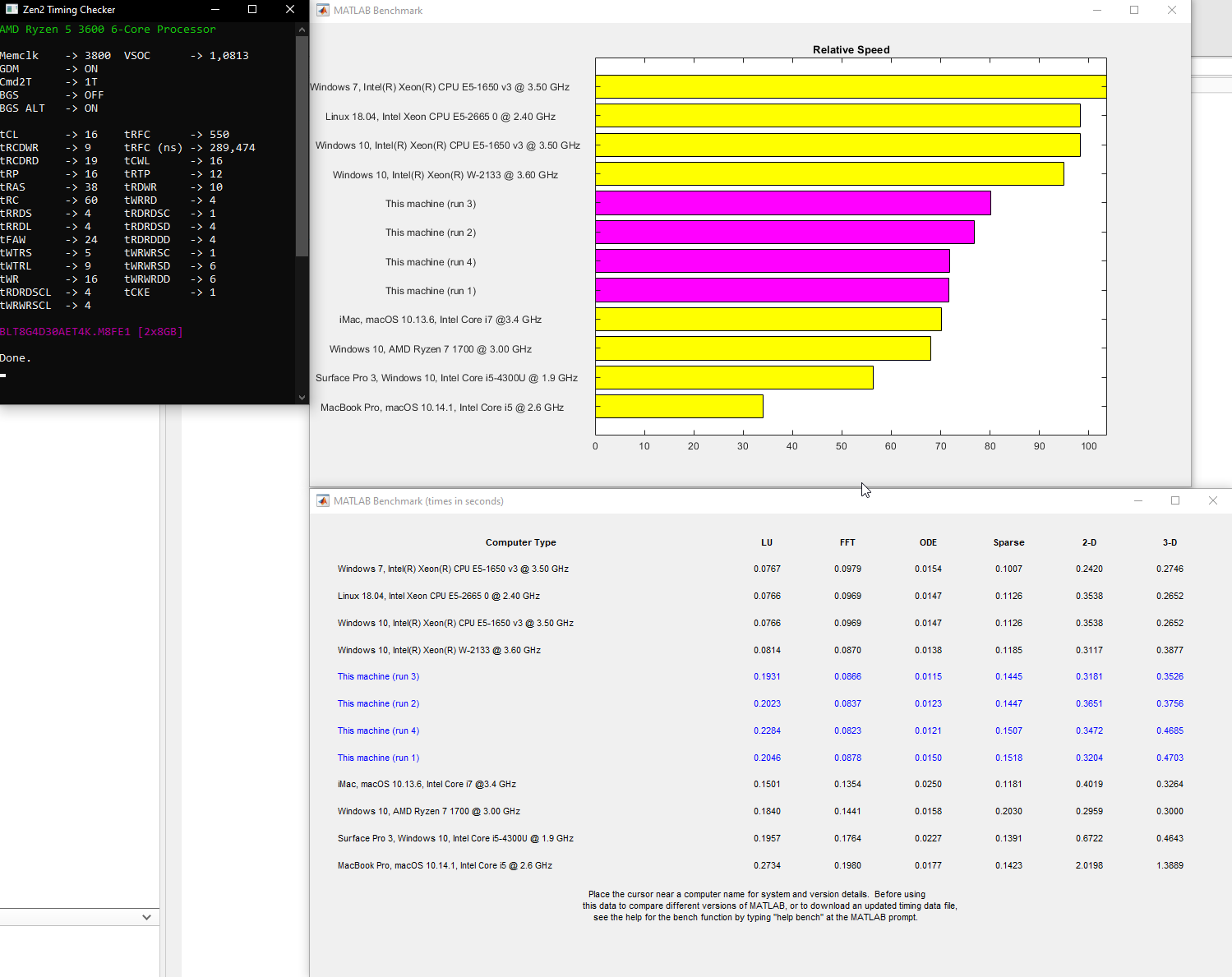

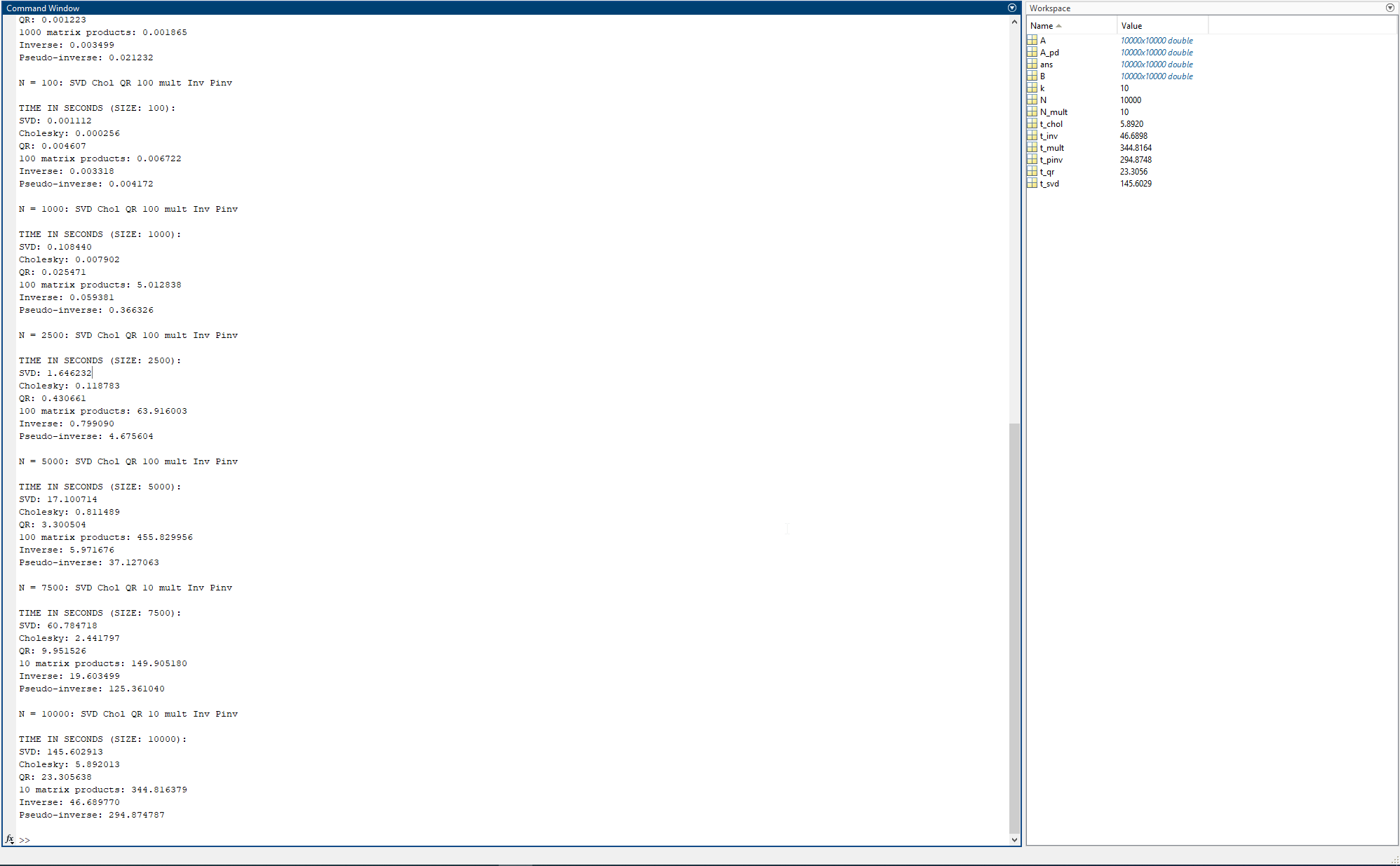

N = 10: SVD Chol QR 1000 mult Inv Pinv

TIME IN SECONDS (SIZE: 10):

SVD: 0.050341

Cholesky: 0.001806

QR: 0.001223

1000 matrix products: 0.001865

Inverse: 0.003499

Pseudo-inverse: 0.021232

N = 100: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 100):

SVD: 0.001112

Cholesky: 0.000256

QR: 0.004607

100 matrix products: 0.006722

Inverse: 0.003318

Pseudo-inverse: 0.004172

N = 1000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 1000):

SVD: 0.108440

Cholesky: 0.007902

QR: 0.025471

100 matrix products: 5.012838

Inverse: 0.059381

Pseudo-inverse: 0.366326

N = 2500: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 2500):

SVD: 1.646232

Cholesky: 0.118783

QR: 0.430661

100 matrix products: 63.916003

Inverse: 0.799090

Pseudo-inverse: 4.675604

N = 5000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 5000):

SVD: 17.100714

Cholesky: 0.811489

QR: 3.300504

100 matrix products: 455.829956

Inverse: 5.971676

Pseudo-inverse: 37.127063

N = 7500: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 7500):

SVD: 60.784718

Cholesky: 2.441797

QR: 9.951526

10 matrix products: 149.905180

Inverse: 19.603499

Pseudo-inverse: 125.361040

N = 10000: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 10000):

SVD: 145.602913

Cholesky: 5.892013

QR: 23.305638

10 matrix products: 344.816379

Inverse: 46.689770

Pseudo-inverse: 294.874787

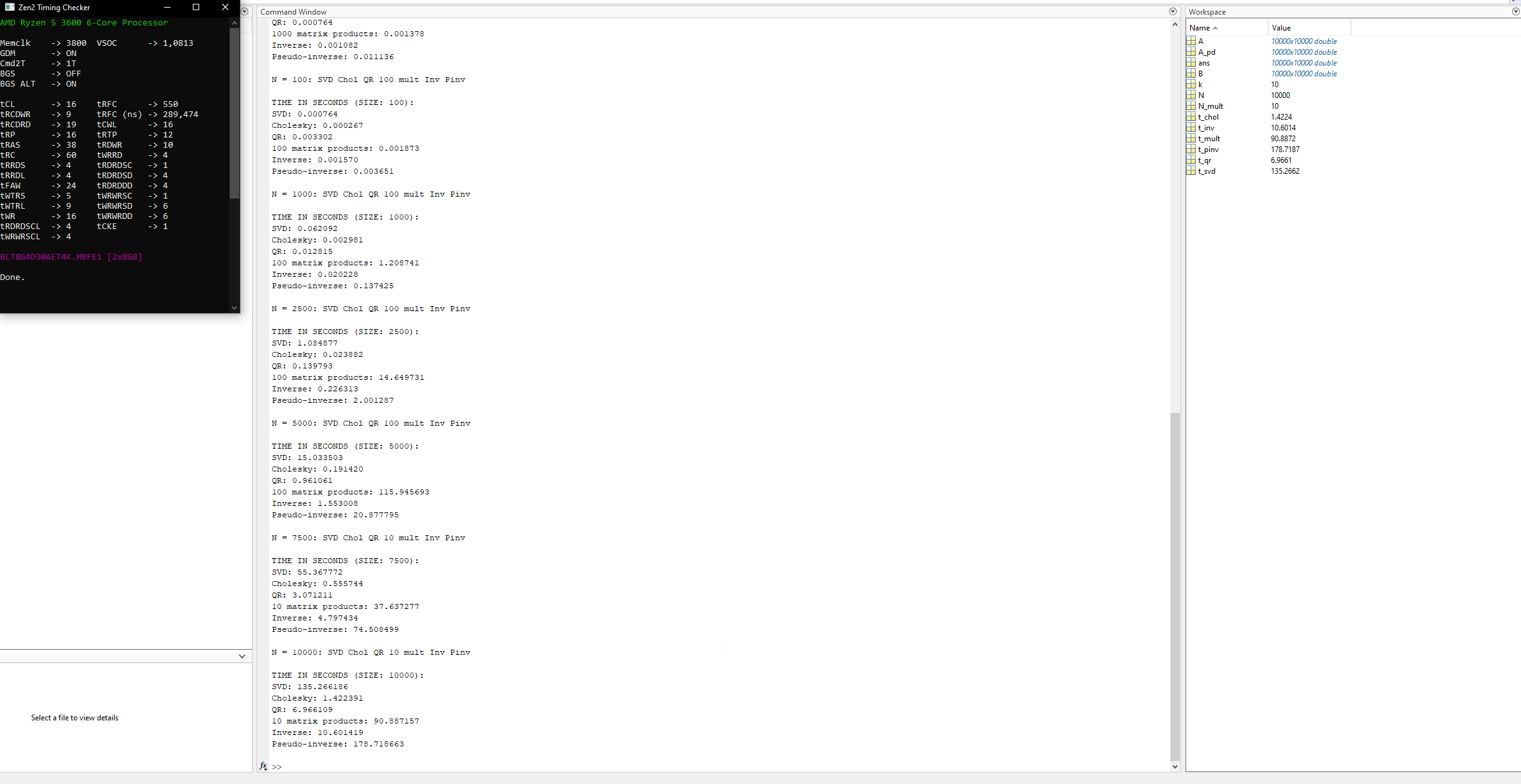

N = 10: SVD Chol QR 1000 mult Inv Pinv

TIME IN SECONDS (SIZE: 10):

SVD: 0.002686

Cholesky: 0.000313

QR: 0.000764

1000 matrix products: 0.001378

Inverse: 0.001082

Pseudo-inverse: 0.011136

N = 100: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 100):

SVD: 0.000764

Cholesky: 0.000267

QR: 0.003302

100 matrix products: 0.001873

Inverse: 0.001570

Pseudo-inverse: 0.003651

N = 1000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 1000):

SVD: 0.062092

Cholesky: 0.002981

QR: 0.012815

100 matrix products: 1.208741

Inverse: 0.020228

Pseudo-inverse: 0.137425

N = 2500: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 2500):

SVD: 1.084877

Cholesky: 0.023882

QR: 0.139793

100 matrix products: 14.649731

Inverse: 0.226313

Pseudo-inverse: 2.001287

N = 5000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 5000):

SVD: 15.033503

Cholesky: 0.191420

QR: 0.961061

100 matrix products: 115.945693

Inverse: 1.553008

Pseudo-inverse: 20.877795

N = 7500: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 7500):

SVD: 55.367772

Cholesky: 0.555744

QR: 3.071211

10 matrix products: 37.637277

Inverse: 4.797434

Pseudo-inverse: 74.508499

N = 10000: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 10000):

SVD: 135.266186

Cholesky: 1.422391

QR: 6.966109

10 matrix products: 90.887157

Inverse: 10.601419

Pseudo-inverse: 178.718663

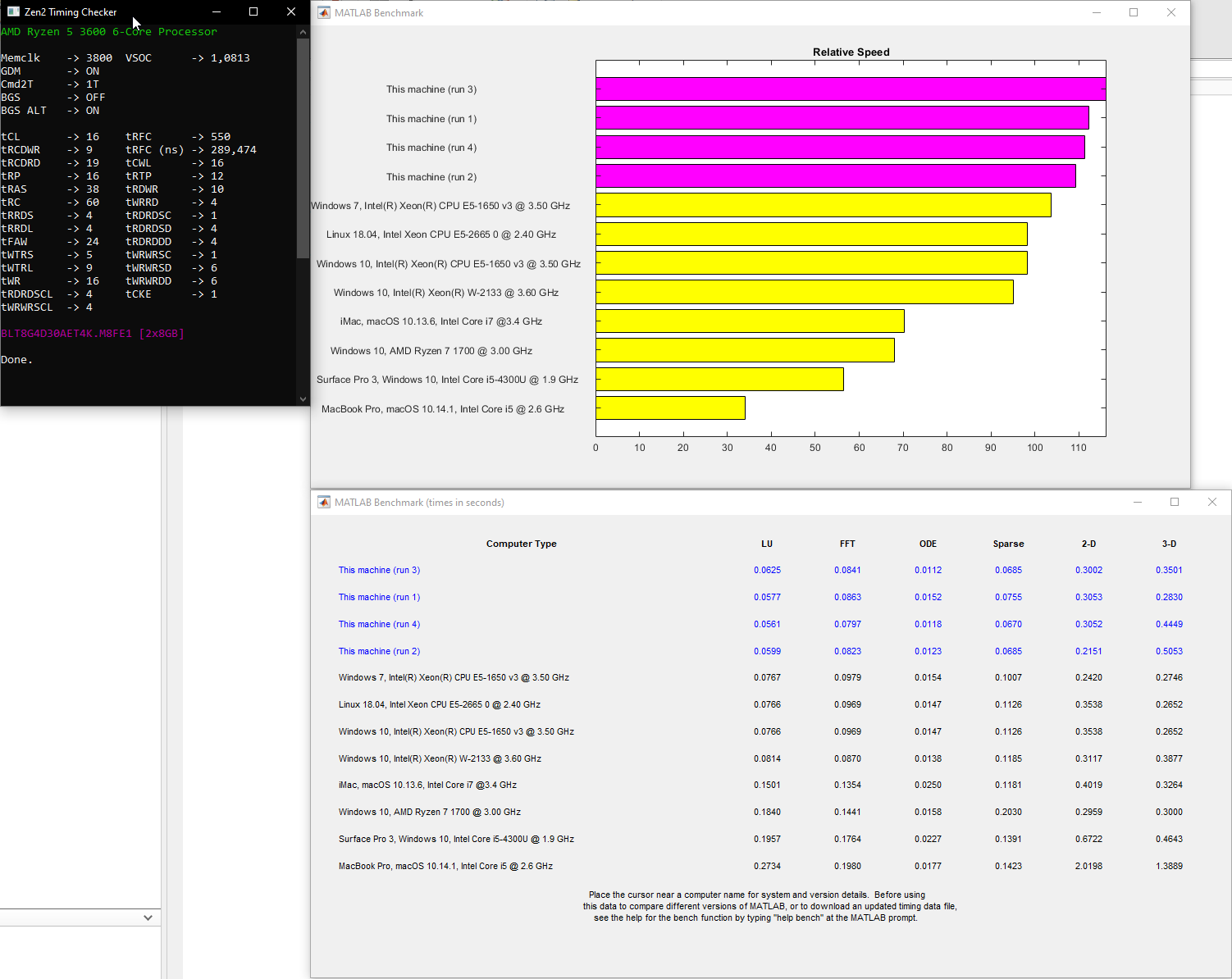

N = 10: SVD Chol QR 1000 mult Inv Pinv

TIME IN SECONDS (SIZE: 10):

SVD: 0.050341

Cholesky: 0.001806

QR: 0.001223

1000 matrix products: 0.001865

Inverse: 0.003499

Pseudo-inverse: 0.021232

N = 100: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 100):

SVD: 0.001112

Cholesky: 0.000256

QR: 0.004607

100 matrix products: 0.006722

Inverse: 0.003318

Pseudo-inverse: 0.004172

N = 1000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 1000):

SVD: 0.108440

Cholesky: 0.007902

QR: 0.025471

100 matrix products: 5.012838

Inverse: 0.059381

Pseudo-inverse: 0.366326

N = 2500: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 2500):

SVD: 1.646232

Cholesky: 0.118783

QR: 0.430661

100 matrix products: 63.916003

Inverse: 0.799090

Pseudo-inverse: 4.675604

N = 5000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 5000):

SVD: 17.100714

Cholesky: 0.811489

QR: 3.300504

100 matrix products: 455.829956

Inverse: 5.971676

Pseudo-inverse: 37.127063

N = 7500: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 7500):

SVD: 60.784718

Cholesky: 2.441797

QR: 9.951526

10 matrix products: 149.905180

Inverse: 19.603499

Pseudo-inverse: 125.361040

N = 10000: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 10000):

SVD: 145.602913

Cholesky: 5.892013

QR: 23.305638

10 matrix products: 344.816379

Inverse: 46.689770

Pseudo-inverse: 294.874787

N = 10: SVD Chol QR 1000 mult Inv Pinv

TIME IN SECONDS (SIZE: 10):

SVD: 0.002686

Cholesky: 0.000313

QR: 0.000764

1000 matrix products: 0.001378

Inverse: 0.001082

Pseudo-inverse: 0.011136

N = 100: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 100):

SVD: 0.000764

Cholesky: 0.000267

QR: 0.003302

100 matrix products: 0.001873

Inverse: 0.001570

Pseudo-inverse: 0.003651

N = 1000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 1000):

SVD: 0.062092

Cholesky: 0.002981

QR: 0.012815

100 matrix products: 1.208741

Inverse: 0.020228

Pseudo-inverse: 0.137425

N = 2500: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 2500):

SVD: 1.084877

Cholesky: 0.023882

QR: 0.139793

100 matrix products: 14.649731

Inverse: 0.226313

Pseudo-inverse: 2.001287

N = 5000: SVD Chol QR 100 mult Inv Pinv

TIME IN SECONDS (SIZE: 5000):

SVD: 15.033503

Cholesky: 0.191420

QR: 0.961061

100 matrix products: 115.945693

Inverse: 1.553008

Pseudo-inverse: 20.877795

N = 7500: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 7500):

SVD: 55.367772

Cholesky: 0.555744

QR: 3.071211

10 matrix products: 37.637277

Inverse: 4.797434

Pseudo-inverse: 74.508499

N = 10000: SVD Chol QR 10 mult Inv Pinv

TIME IN SECONDS (SIZE: 10000):

SVD: 135.266186

Cholesky: 1.422391

QR: 6.966109

10 matrix products: 90.887157

Inverse: 10.601419

Pseudo-inverse: 178.718663