TurboCache und HyperMemory im Test: Sinnvoll oder TurboHype?

4/23nVidias GeForce 6200 supporting 256 MB mit TurboCache

Im Gegensatz zu ATi behauptet Nvidia, die Rendereinheiten des der GeForce 6200 zu Grunde liegenden NV44-Chips seien zusätzlich und über den Level einer reinen Softwarelösung hinaus, um einen so genannten „Turbo Cache Manager“ und die Fähigkeit, direkt in den Hautspeicher zu rendern, erweitert worden. Ob das der Wahrheit entspricht, können wir nicht überprüfen, wohl aber, ob es sich zum Vorteil des Kunden auswirkt.

Ansonsten ist der Chip zumeist passiv gekühlt erhältlich und mit drei Vertexprozessoren und einem Pixelprozessor, bestehend aus vier Renderingpipelines mit 4:1- und 2:2-Split (eine Vector4-, eine Vector3- plus Skalar-, oder zwei Vector2-Operationen parallel), zwei ALUs und einer Textur-ALU, an die erste ALU gekoppelt, die allesamt mit 32 Bit Präzision pro Kanal rechnen können und die Voraussetzungen für eine Klassifizierung „Shader Model 3“ erfüllen, ausgestattet. Er verfügt über ein Speicherinterface, das nach dem DDR-Prinzip arbeitet und 64 Bit breit ist. Ferner sind zwei ROPs verbaut, die zeitgleich ein Farb- und ein Z-Sample berechnen können. Es fehlen aber augenscheinlich die Fähigkeiten der mächtigeren Vertreter der Geforce6/7-Familie, pro Durchgang zwei Z-Samples zu berechnen (Teil des als „Ultra-Shadow II“ beworbenen Paketes, die im Umlauf befindlichen Präsentationen suggerieren ein Vorhandensein dieses Features, erwähnen zumindestens jedoch nicht dessen Fehlen), Floating-Point-Texturfilterung mit 16 Bit Genauigkeit pro RGBA-Kanal (gesamt 64 Bit) in den TMUs und FP16-Alpha-Blending in den ROPs durchzuführen (GF6200 Modelle explizit als Ausnahmen erwähnt), sowie sämtliche Kompressionsfunktionen für Z-, MSAA- und Framebuffer (Teil des als „IntelliSample“ beworbenen Paketes, GF6200-Modell explizit als Ausnahmen erwähnt).

Fähig ist die Geforce 6200 TC dagegen zu Einsparungen in den verwendeten Samples bei iso- und anisotroper Texturfilterung. Diese kann bis zu 16:1 anisotrop durchgeführt werden. Es stehen 2x und 4x Rotated Grid-Multisampling Anti-Aliasing und ein als „Quincunx“ bezeichneter Blurmodus zur Verfügung. Auf die von den restlichen Geforce6- und -FX-Karten bekannten Mischungen aus Multi- und Supersampling-FSAA muss hier offiziell verzichtet werden. Inoffiziell sind sie über externe Programme (wie nHancer, Riva- oder a-Tuner) weiterhin verfügbar. Ein bereits in der Geforce 6800 angekündigter, dort jedoch nur teilweise funktionsfähiger, dedizierter Videoprozessor soll die CPU bei der Dekodierung einer Vielzahl, insbesondere hoch aufgelöster Videoformate unterstützen.

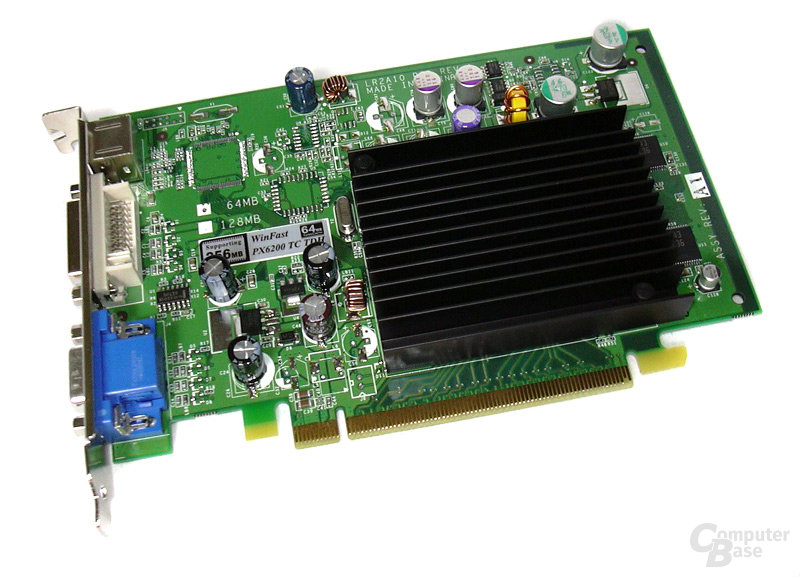

Es existieren Modelle mit 16, 32 und 64 MByte lokalem Framebuffer, die irreführender Weise jeweils die vierfache Menge an Speicher in der Namensbezeichnung tragen. Wir testen das Top-Modell, repräsentiert durch ein Serienexemplar von Leadtek, welches aktuell für etwa 54 Euro den Besitzer wechselt.

Die Geforce 6200 Turbocache, die über 64 MByte lokalen, mit 275 MHz und damit entsprechend der verbauten 3,6ns-Speichermodule getakteten TSOP-II-Speicher verfügt, kommt mit einer GPU-Frequenz daher, die stattliche 350 MHz beträgt. Der Chip selbst wird von TSMC in einem 0,11µ-Prozess gezüchtet und misst 10 x 10,5 mm (105 mm²). Wie die ATi-Modelle und natürlich die integrierten Grafikeinheiten präsentiert sich der Nvidia-Vertreter, vertreten durch eine Serienkarte von Leadtek, passiv und damit geräuschlos gekühlt. In diesem Punkt gibt es in unserem hiermit abgeschlossenen Testfeld also einen Gleichstand zu vermelden. Der Vorteil für die integrierte Grafik, ein ergonomischeres, weil geräuschloses Arbeitsumfeld zu produzieren, fällt hier also weg.

Auch ansonsten gibt es an der Ausstattung nichts zu bemängeln, bis auf den fehlenden Video-Eingang – den allerdings keine Lösung unseres Tesfeldes bietet – sind alle üblichen und notwendigen Anschlüsse, wie DSub-, DVI- und TV-Ausgang vorhanden. Die Signalqualität erschien minimal schlechter, als die des ATi-Referenzmodells, aber wiederum leicht besser, als die der connect3D-Karte. Dazu sei gesagt, dass keiner der Probanden ein Problem mit der 1280er Auflösung hatte; erst in 1600x1200 Bildpunkten trennte sich die Spreu vom Weizen.