Nvidia Tesla P100: GP100 als großer Pascal soll „All In“ für HPC-Markt gehen

Nvidia-CEO Jen-Hsun Huang hat nach rund anderthalb Stunden der Eröffnungskeynote zur Hausmesse GTC 2016 erste Details zur neuen Pascal-Architektur und damit dem Maxwell-Nachfolger bekannt gegeben. Der größte Chip mit dem Codenamen GP100 soll „All in“ im professionellen HPC-Segment (High Performance Computing) gehen.

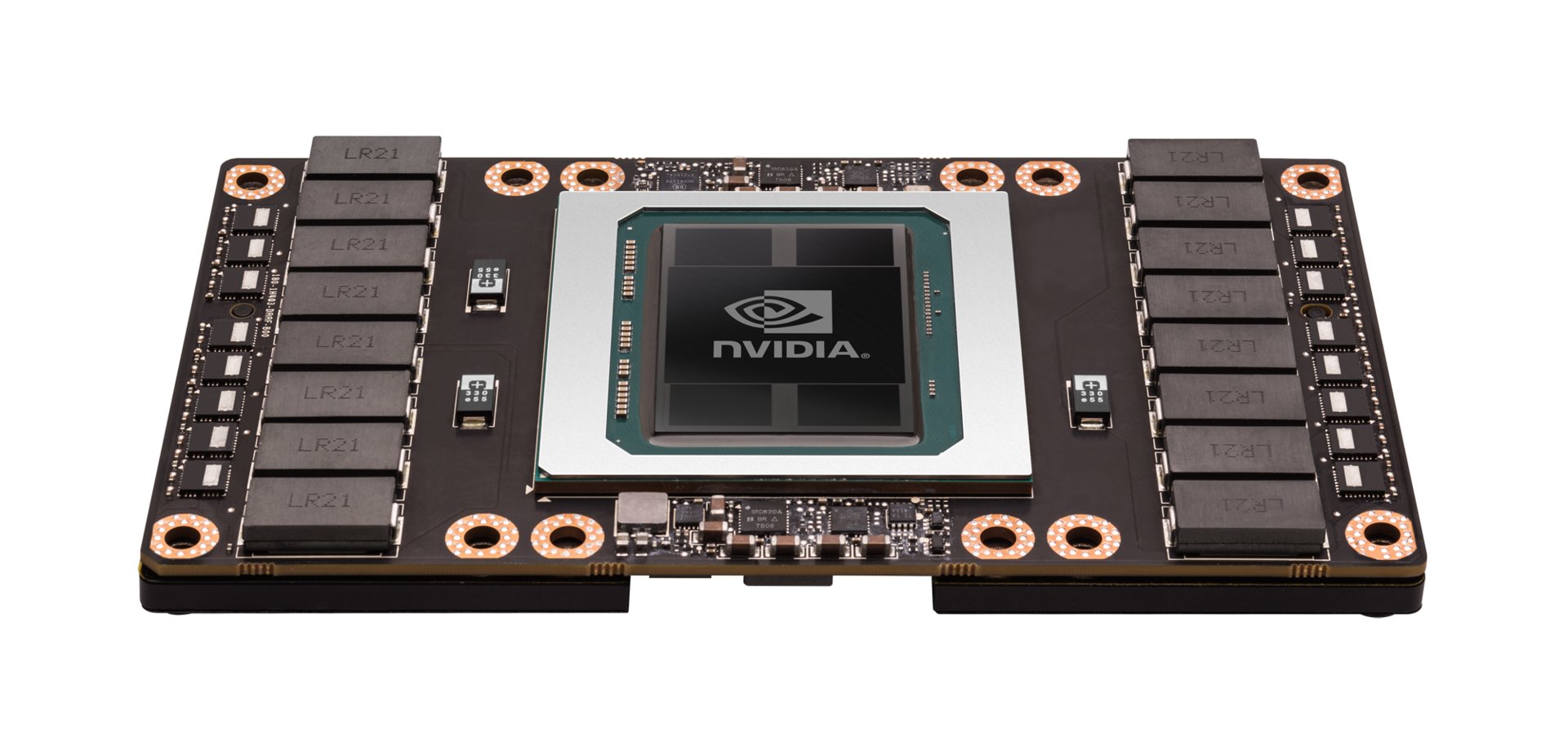

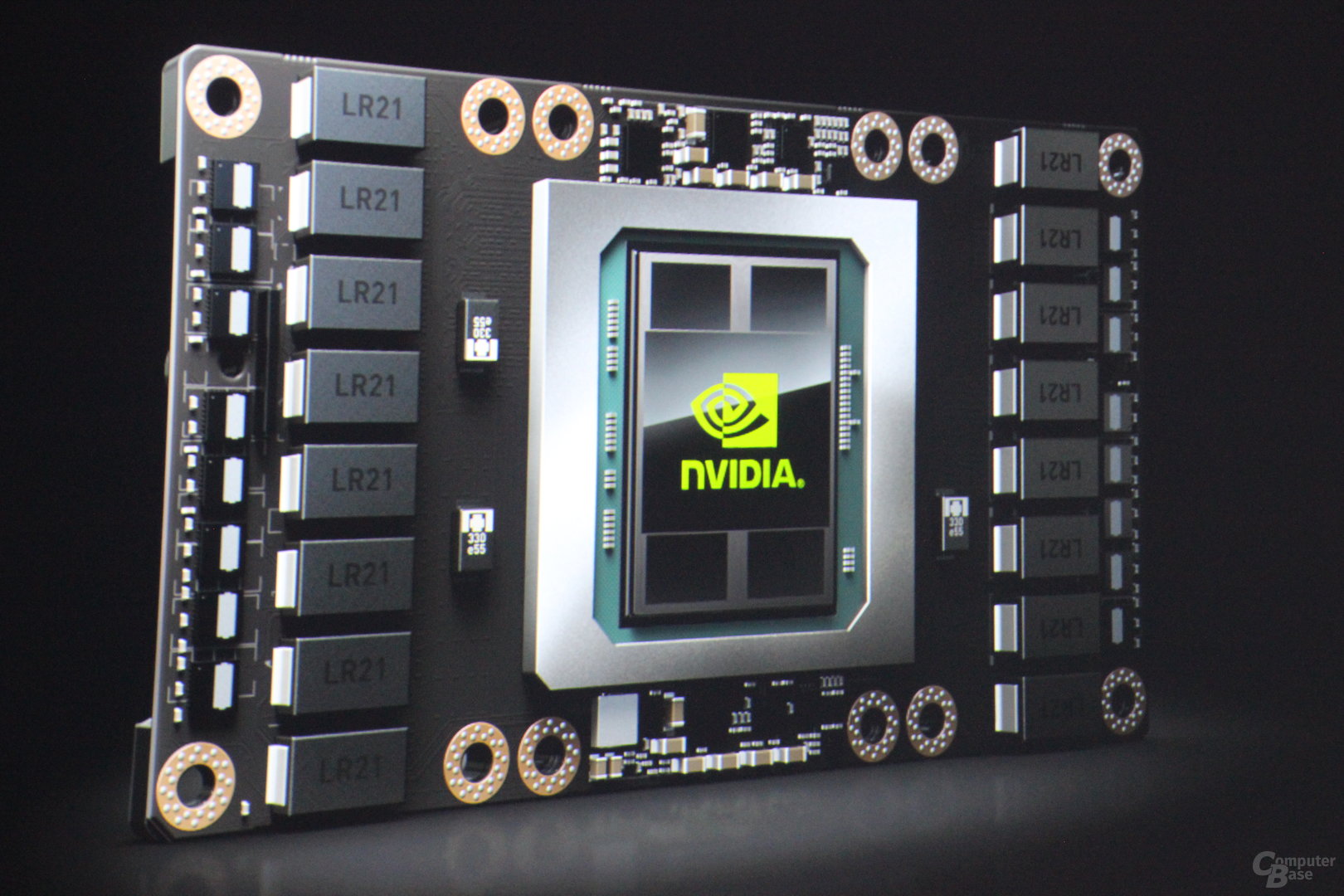

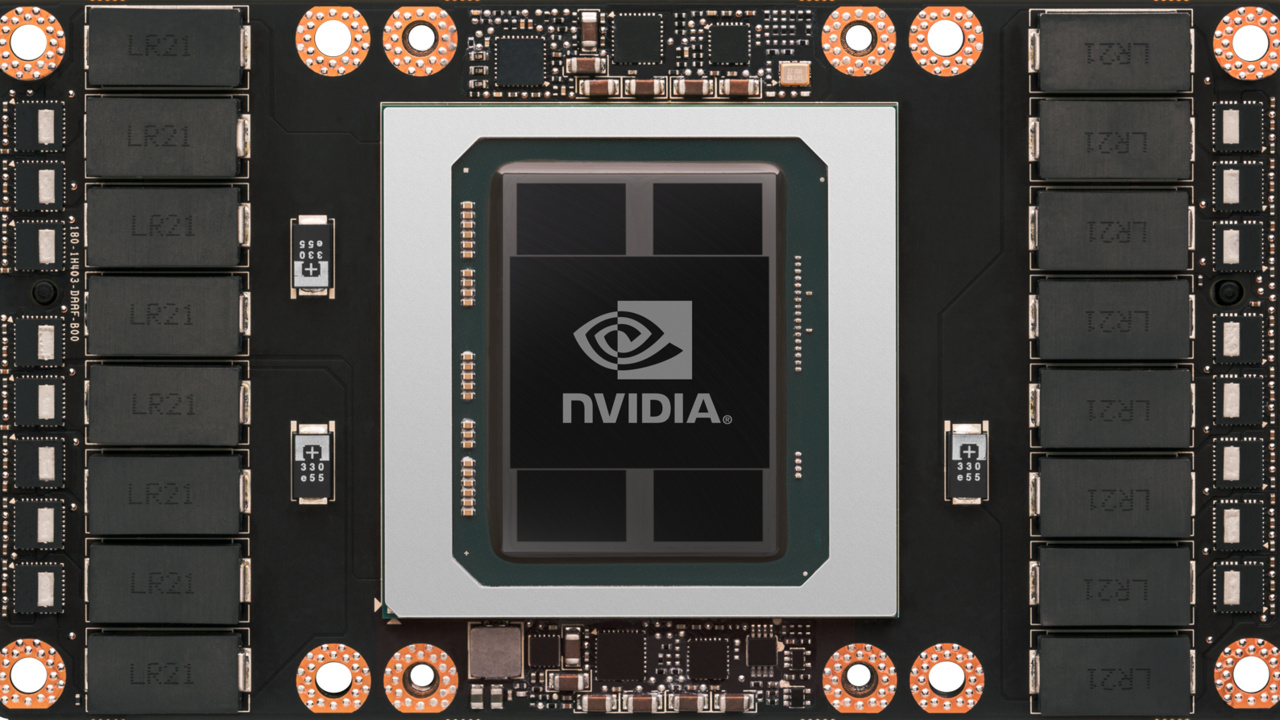

Das erste Produkt mit dem GP100 ist der Tesla P100, dessen erste Spezifikationen schlicht beeindruckend sind. Die GPU wird, wie bereits vermutet, im 16-nm-FinFET-Prozess bei TSMC gefertigt und besteht aus 15,3 Milliarden Transistoren (GM200: 8,0 Milliarden). Erstaunlich ist die schier riesige Größe des Chips, die bei 610 mm² liegt. Bei der älteren 28-nm-Fertigung würden solche Abmessungen nicht verwundern, bei der neuen und komplexen FinFET-Fertigung allerdings schon.

Pascal geht „All In“ mit 3.840 ALUs, hohem Takt und verbesserter Effizienz

Erste Angaben bezüglich der Leistung gibt es auch. Die theoretische FP32-Leistung des Tesla P100 beträgt 10,6 TFLOPS (Titan X: 7,1 TFLOPS, Tesla M40: 7,0 TFLOPS, Tesla K40: 4,29 TFLOPS), während der FP64-Durchsatz mit der doppelten Genauigkeit bei 5,3 TFLOPS liegt. Damit bietet der GP100 ein SP/DP-Verhältnis von 2:1, wie noch keine Nvidia-GPU zuvor – einzig AMDs Hawaii-Chips sind dazu ebenfalls in der Lage. Die Tesla K40 als Nvidias bisheriges DP-Flaggschiff kommt auf 1,43 TFLOPS.

Darüber hinaus kann Pascal auch mit reduzierter Genauigkeit (FP16) arbeiten, die bei einigen professionellen Berechnungen die Leistung noch einmal deutlich nach oben schrauben kann. Dann beträgt die Rechenleistung 21,2 TFLOPS. Die Pascal-ALUs auf dem Tesla P100 bieten also ein 1:2:4-Verhältnis (FP64:FP32:FP16), auch das ist ein Novum für eine GPU. Unbekannt ist jedoch weiterhin, inwieweit die Architektur bei derselben theoretischen Leistung schneller geworden ist.

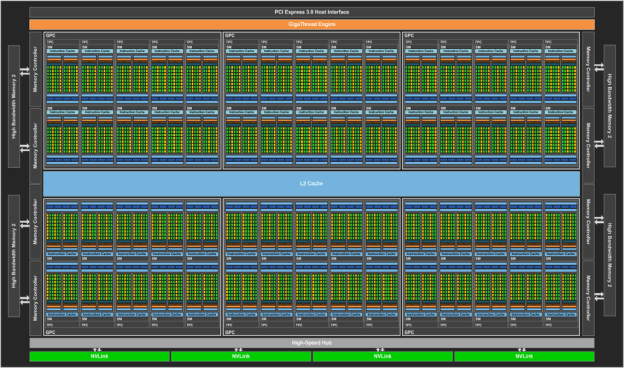

Eine mittlerweile erschienene Pressemitteilung bringt weiter Licht ins Dunkel. Demnach verfügt die GPU über sechs Graphics Processor Cluster (GPC) mit jeweils zehn Streaming Multiprocessors (SMs). Diese wiederum verfügen über je 64 Shadereinheiten, sodass der GP100 auf 3.840 Shadereinheiten kommt. Maxwell kann auf 3.072 zurückgreifen, allerdings spricht Nvidia von einer verbesserten Effizienz der einzelnen ALUs.

Auffällig ist, dass jeder Streaming Multiprocessor damit nur noch über halb so viele Shadereinheiten wie bei Maxwell verfügt – und mit 64 auf dieselbe Anzahl wie AMDs GCN-Architektur setzt. Pascal setzt wie auch Kepler auf separate ALUs für eine doppelte Genauigkeit. Exakt halb so viele FP64-Einheiten wie FP32-ALUs gibt es pro Streaming Multiprocessor. Die FP16-Berechnungen werden dagegen auf den FP32-Einheiten durchgeführt (zwei FP16-Befehle passen auf eine FP32-Einheit). Die Menge der Textureinheiten liegt insgesamt bei 240 TMUs.

Die Tesla P100 setzt interessanterweise anscheinend nicht auf den Vollausbau des Pascal-Flaggschiffes. Nvidia spricht nämlich von 56 Streaming Multiprocessors, wobei physikalisch 60 vorhanden sind. Entsprechend wären „nur“ 3.584 statt 3.840 ALUs sowie 224 statt 240 Textureinheiten aktiviert. Der Vollausbau kommt womöglich erst dann zum Einsatz, wenn die Fertigung verbessert worden ist. Der Basistakt der Tesla P100 liegt bei hohen 1.328 MHz, der Turbo-Takt gar bei sehr hohen 1.480 MHz. Die TDP ist mit 300 Watt angegeben.

| Tesla K40 | Tesla M40 | Tesla P100 | |

|---|---|---|---|

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) |

| SMs | 15 | 24 | 56 |

| FP32 CUDA Cores / SM | 192 | 128 | 64 |

| FP32 CUDA Cores / GPU | 2880 | 3072 | 3584 |

| FP64 CUDA Cores / SM | 64 | 4 | 32 |

| FP64 CUDA Cores / GPU | 960 | 96 | 1792 |

| Base Clock | 745 MHz | 948 MHz | 1328 MHz |

| GPU Boost Clock | 810/875 MHz | 1114 MHz | 1480 MHz |

| FP64 GFLOPS | 1680 | 213 | 5304 |

| Texture Units | 240 | 192 | 224 |

| Memory Interface | 384-Bit GDDR5 | 384-Bit GDDR5 | 4096-Bit HBM2 |

| Memory Size | Up to 12 GB | Up to 24 GB | 16 GB |

| L2 Cache Size | 1536 KB | 3072 KB | 4096 KB |

| Register File Size / SM | 256 KB | 256 KB | 256 KB |

| Register File Size / GPU | 3840 KB | 6144 KB | 14336 KB |

| TDP | 235 Watts | 250 Watts | 300 Watts |

| Transistors | 7,1 Milliarden | 8 Milliarden | 15,3 Milliarden |

| GPU Die Size | 551 mm² | 601 mm² | 610 mm² |

| Manufacturing Process | 28 nm | 28 nm | 16 nm |

16 GB HBM2, 4 MB L2-Cache, 160 GB/s NV-Link – viel Bandbreite auf GP100

Der GP100 setzt wenig verwunderlich auf HBM2-Speicher, der von Samsung gefertigt wird. Der Tesla P100 wird davon 16 GByte tragen, die mit einem 4.096 Bit breiten Speicherinterface angebunden sind. Die Speicherbandbreite liegt aber nur bei 720 GByte pro Sekunde und damit nicht beim maximal möglichen der HBM2-Spezifikation. Tesla P100 setzt auf „Unified Memory“, sodass die CPU auf den GPU-Speicher zugreifen kann und auch anders herum.

Nvidia hat zudem auf dem GP100 den L2-Cache von den zwei MByte des GM200 auf vier MByte aufgebohrt. Der Tesla P100 bietet ein 14 MByte großes Register File. NVLink als Nvidias selbst entwickelte Datenleitung ist mit einem Durchsatz von insgesamt 160 GByte/s ebenso mit an Bord und dient beim Einsatz von mehreren GPUs als direkte Verbindungsleitung. Das Gesamtpaket des Tesla GP100 soll aus insgesamt 150 Milliarden Transistoren bestehen. Wer noch mehr technische Details zu Tesla P100 und GP100 erfahren möchte, kann diese in einem Entwickler-Blog von Nvidia einsehen.

Laut Jen-Hsun Huang befindet sich die Tesla P100 mittlerweile in der Massenproduktion und soll „bald“ an die ersten Kunden verschickt werden. Zuallererst sollen Cloud-Dienste Zugriff auf die neue Pascal-Hardware erhalten, während OEM-Kunden im Laufe des ersten Quartals 2017 folgen sollen.

GeForce-Karten gibt es zunächst wohl „nur“ mit der kleineren GP104-GPU

Anhand der technischen Spezifikationen wird deutlich, dass es sich bei dem GP100 vermutlich um eine rein für den professionellen Einsatz ausgelegte GPU handelt, die im HPC-Segment benötigt wird. Dies würde zu dem spekulierten GP102 passen, der die Desktop-Variante des Pascal-Flaggschiffes sein könnte und zum Beispiel ohne NVLink und den großen Register-File-Speicher auskommt. Wann „Big Pascal“ als GeForce-Karte im Handel erscheinen wird, ist noch völlig fraglich. Es erscheint nicht unwahrscheinlich, dass dies erst Anfang des nächsten Jahres der Fall sein wird. Der kleinere GP104 als Nachfolger des GM204 und Ablösung der GeForce GTX 980 sowie GeForce GTX 980 Ti wird gegen Mitte des Jahres erwartet.

- Nvidia Xavier: SoC mit Volta und HDR für autonome Autos

- GTC 2016: „Mobile Geräte sind für VR der größte Markt“

- Nvidia Drive PX 2: Kleine Pascal-GPUs mit 128 Bit und 4 GB GDDR5

- +10 weitere News