MLPerf Benchmark für AI: Intel ist ein Gewinner, aber Nvidia gewinnt noch viel mehr

In neuen MLCommons-Performance-Benchmarks sieht sich Intel mit den eigenen AI-Bemühungen als Gewinner. Doch Nvidia gewinnt eigentlich noch viel mehr. Dass jeder ein Gewinner ist, freut die Unternehmen, zeigt aber auch die Schwierigkeiten dieser Testserien auf, von mangelnder Unterstützung einiger Unternehmen ganz zu schweigen.

Die Teilnahme ist mit Aufwand verbunden

Denn wenn sich Intel mit den Xeons als Sieger im Prozessorbereich präsentiert, dann liegt es schlichtweg doch daran, dass kein anderer Systeme eingereicht hat. Immerhin geht Intel mit dieser Angelegenheit auch offen um und erklärt das transparent. Und gleichzeitig kommt die Frage auf, warum AMD es nicht schafft, in diesem Benchmark aufzutrumpfen. In diese Wunde legt auch Nvidia den Finger. Ein Fingerzeig liefert MLCommons Chef:

Submitting to MLPerf is not trivial. It’s a significant accomplishment, as this is not a simple point and click benchmark. It requires real engineering work and is a testament to our submitters' commitment to AI, to their customers, and to ML.

David Kanter, Executive Director of MLCommons

Man muss also einiges an Arbeit in diese Sachen stecken und die Software auf den Stand bringen, den die Hardware auch ab einer gewissen Skalierung liefern soll.

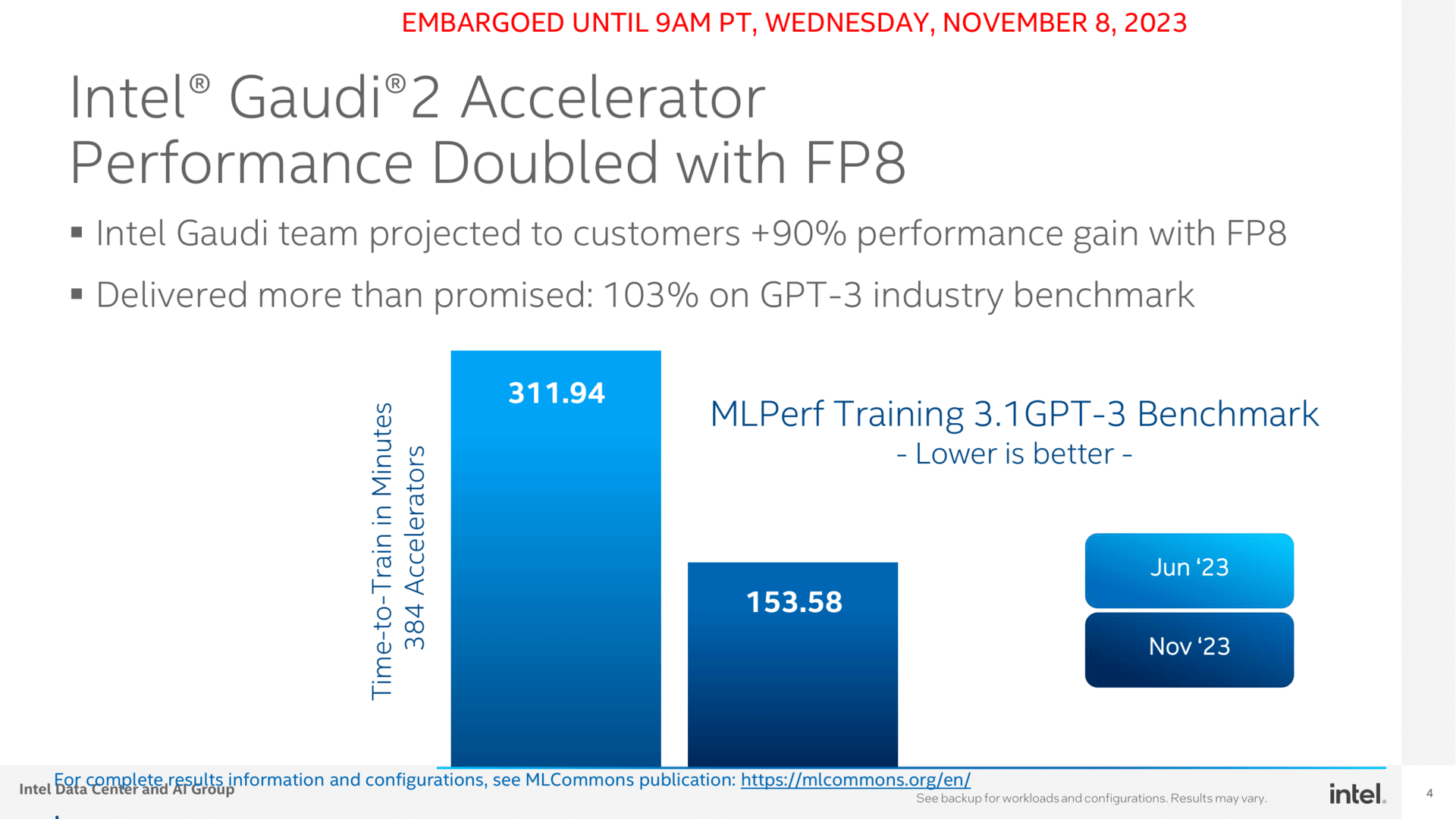

In diese Kerbe schlägt Intel, und liefert sogar etwas mehr, als man im Juni dieses Jahres nach dem letzten Update in Aussicht gestellt hat. Gaudi2 legt so im MLPerf Training 3.1 GPT-3 Benchmark um 103 Prozent statt der anvisierten 90 Prozent zu.

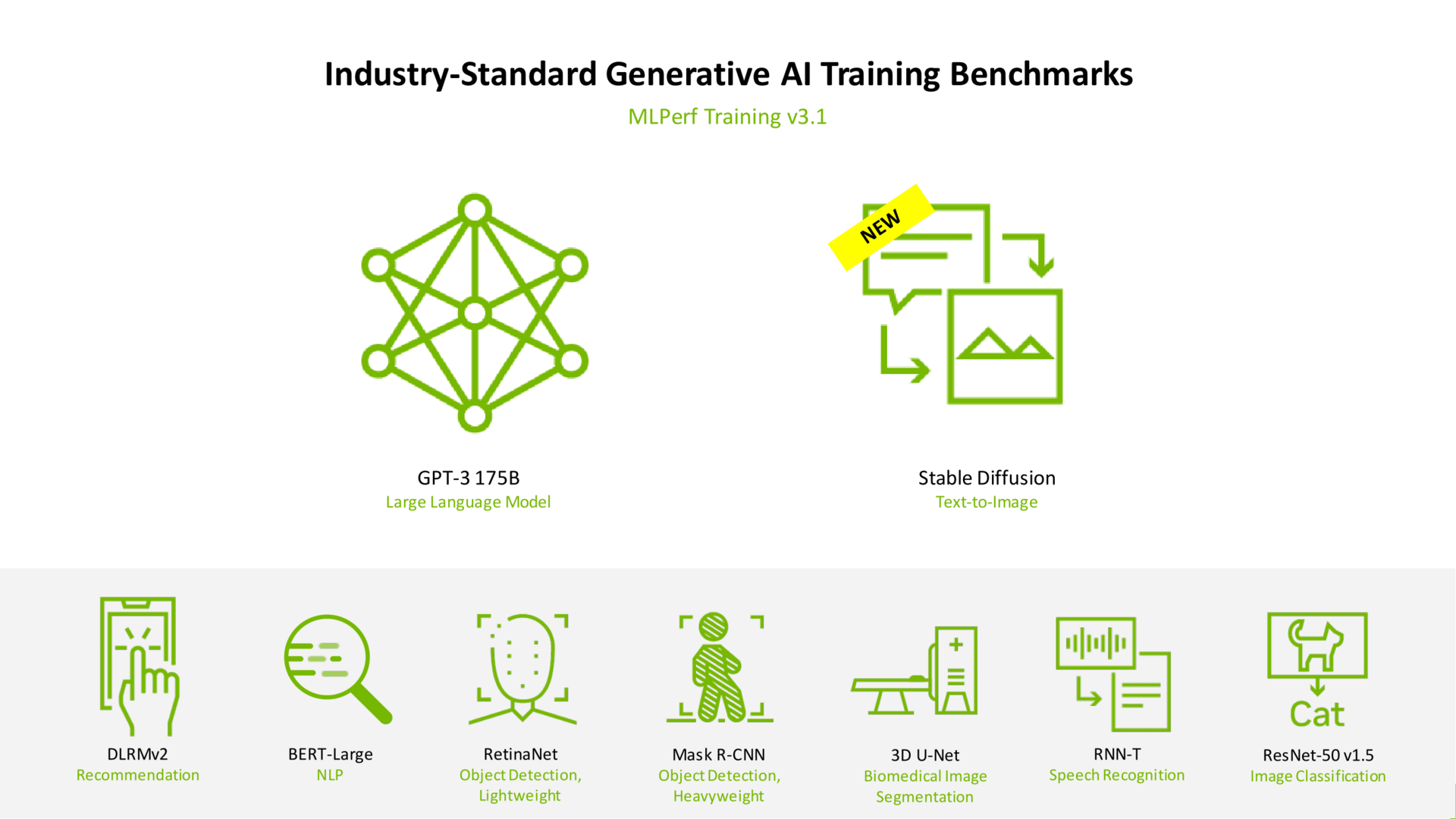

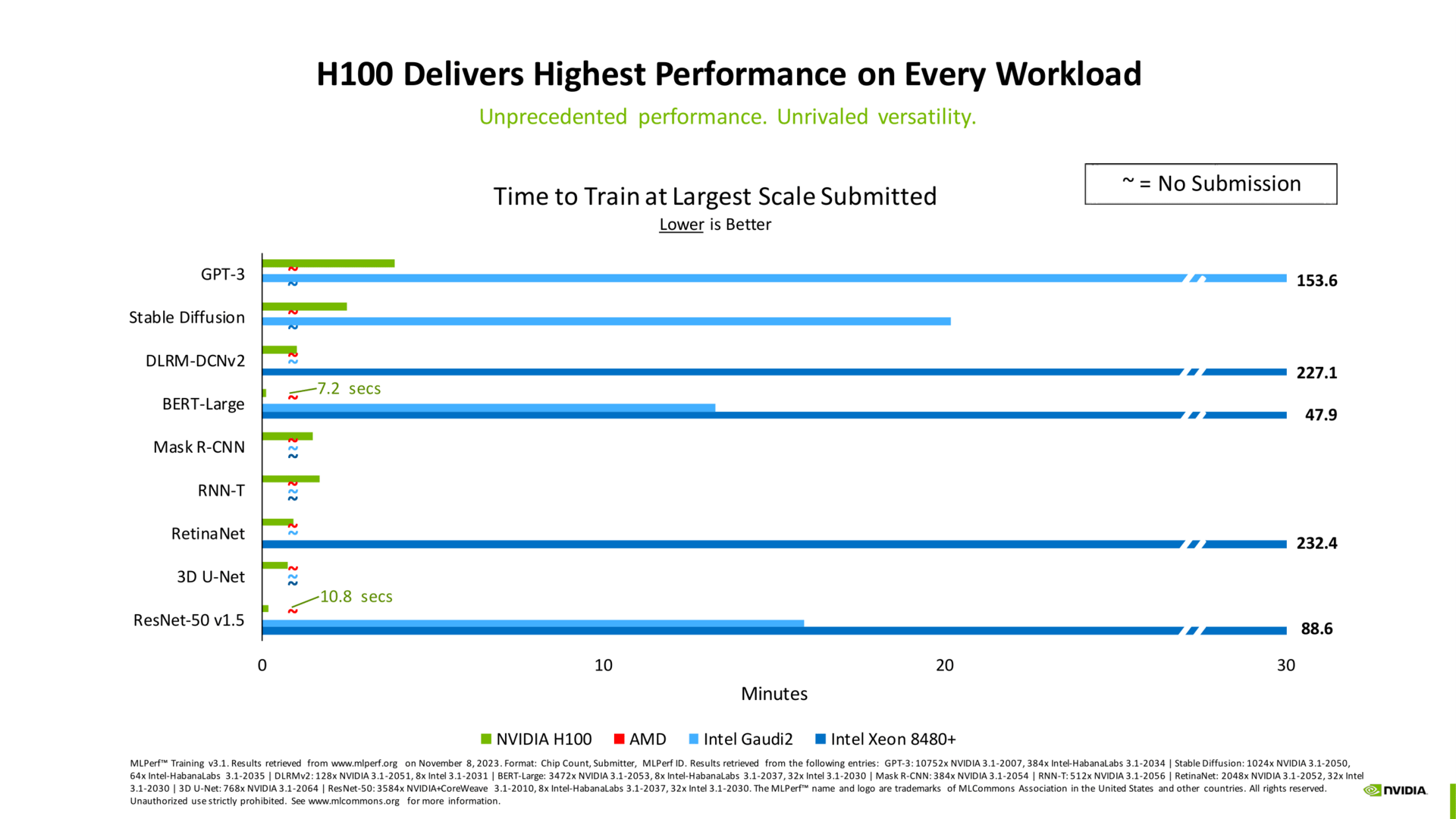

Intel bleibt aber selektiv, was die Tests angeht, ein Punkt, den natürlich Nvidia ankreidet – sie machen als einziges alle Tests, erklärte das Unternehmen in einem Pressegespräch vorab. Das ist aber auch naheliegend, schließlich hat Nvidia den besten AI-Beschleuniger zu bieten. Indirekt erkennen sie aber die Leistung auch von Gaudi2 an, wenngleich eben nur in gewissen Szenarien wie Stable Diffusion. In anderen ist die Sache wiederum glasklar und Nvidia meilenweit voraus. Intel pickt sich derweil einige weitere Rosinen heraus, die eben vor allem die Weiterentwicklung zeigen sollen. Schließlich soll im kommenden Jahr auf Gaudi2 dann Gaudi3 folgen.

Intel will die Preiskarte spielen – ohne Preis

Intel wiederum will genau über ausgewählte Tests nun die Preis-Performance-Karte spielen. Sie erklären zwar ganz klar, dass Nvidia doppelt so schnell ist bei gleicher Anzahl an GPUs – die Werte bestätigt auch Nvidia parallel dazu – Intel will das aber zu „signifikant geringeren Serverkosten“ bieten. Auf die Nachfrage von ComputerBase, was denn diese Aussage bedeutet, schweigt das Unternehmen, wollte selbst auf wiederholten Nachdruck nicht näher eingrenzen, wie groß „signifikant“ denn letztlich ist. Der ständig erwähnte Vorteil durch Intel ist aktuell also nicht zu beziffern und bleibt so im Dunkeln.

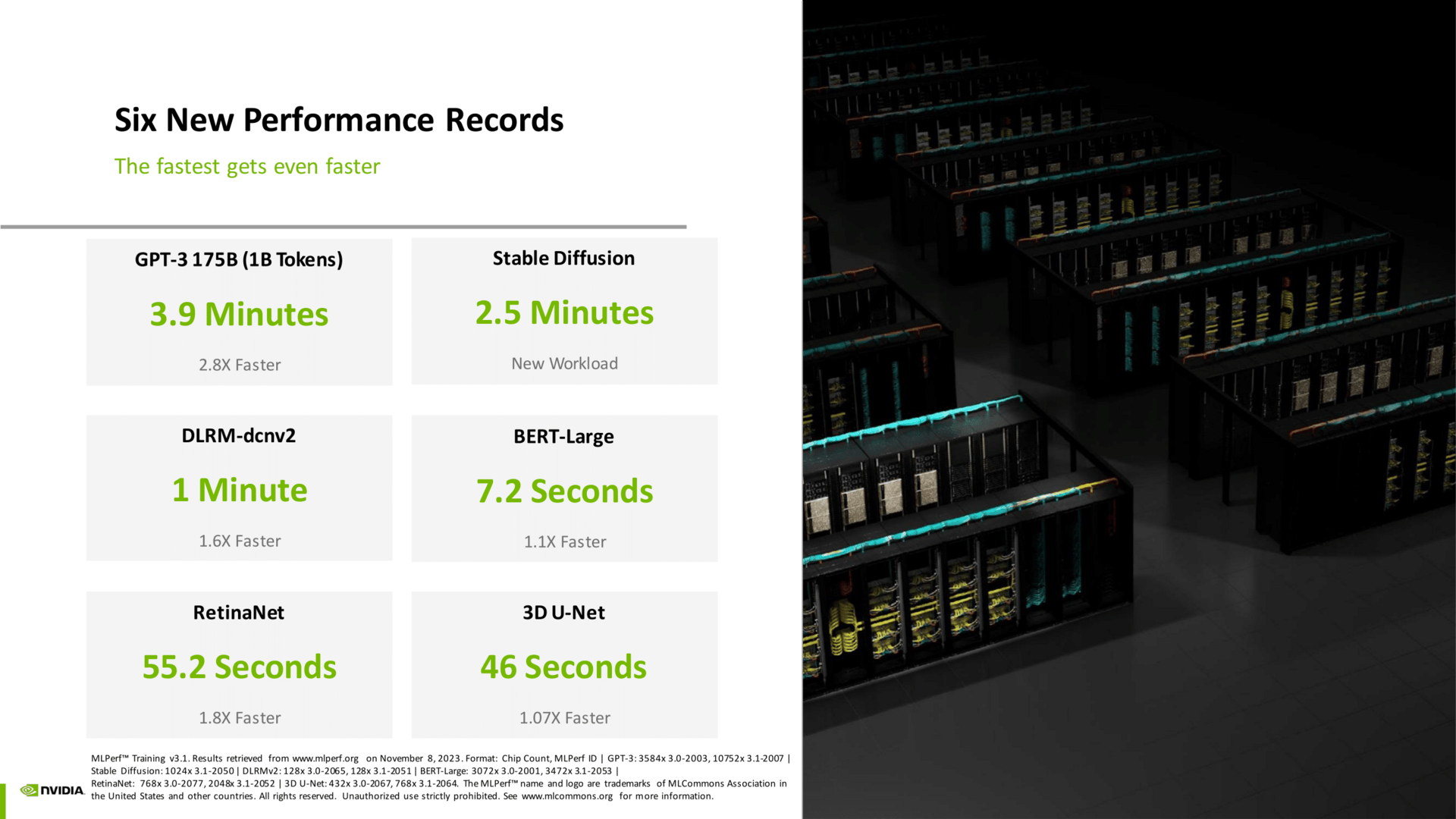

Nvidia zerschmettert alte Rekorde

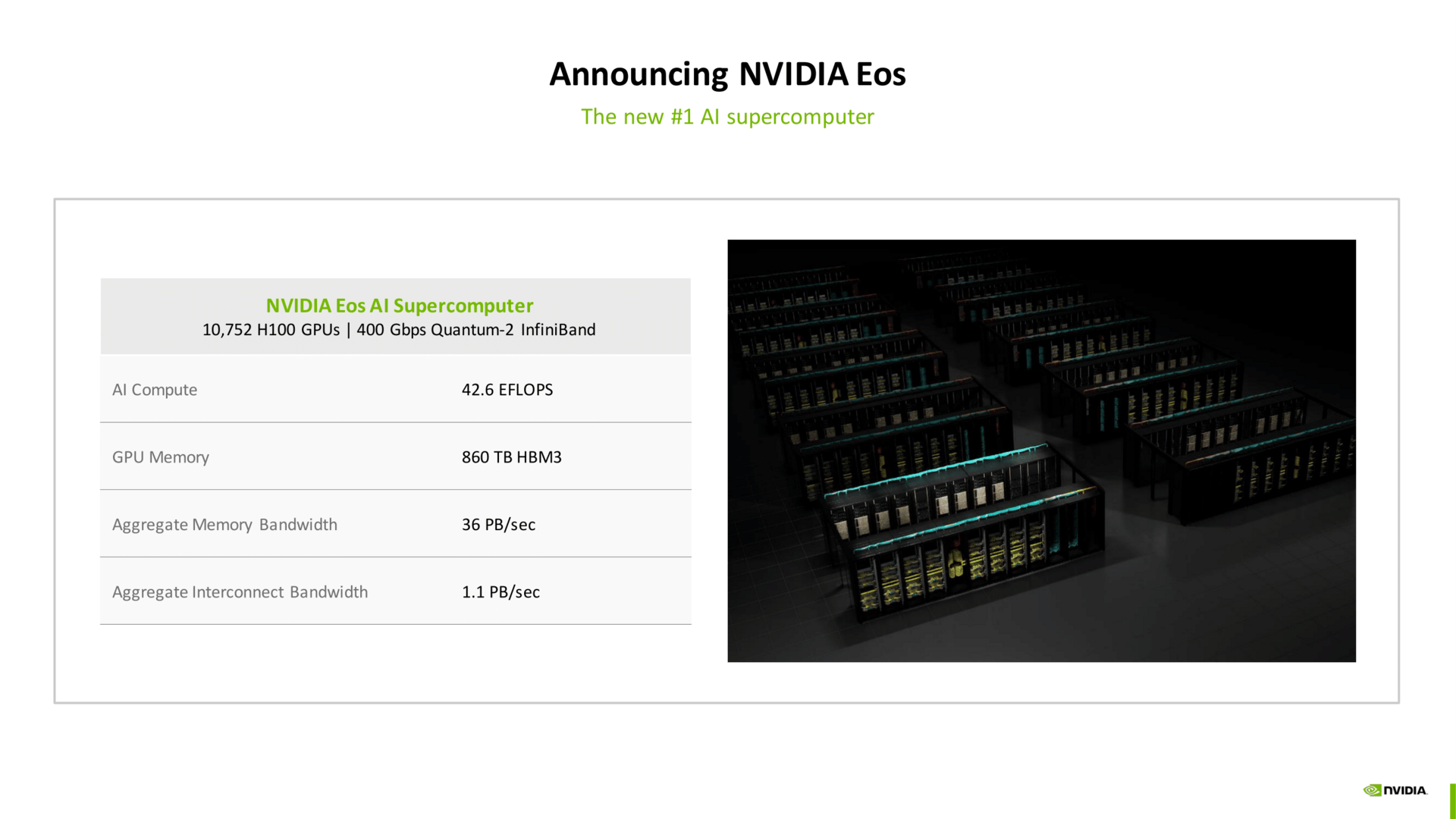

Für Nvidia ist die Sache glasklar: Sie nennen es Industrie-Standard-Benchmark in dem Bereich, was sie mit eindrucksvollen Zahlen und Rekorden beweisen wollen. Aber sie sind nicht allein in ihren Laboren damit beschäftigt, erklären sichtlich stolz, dass auch elf Partner mit Nvidia-Hardware Ergebnisse eingereicht haben.

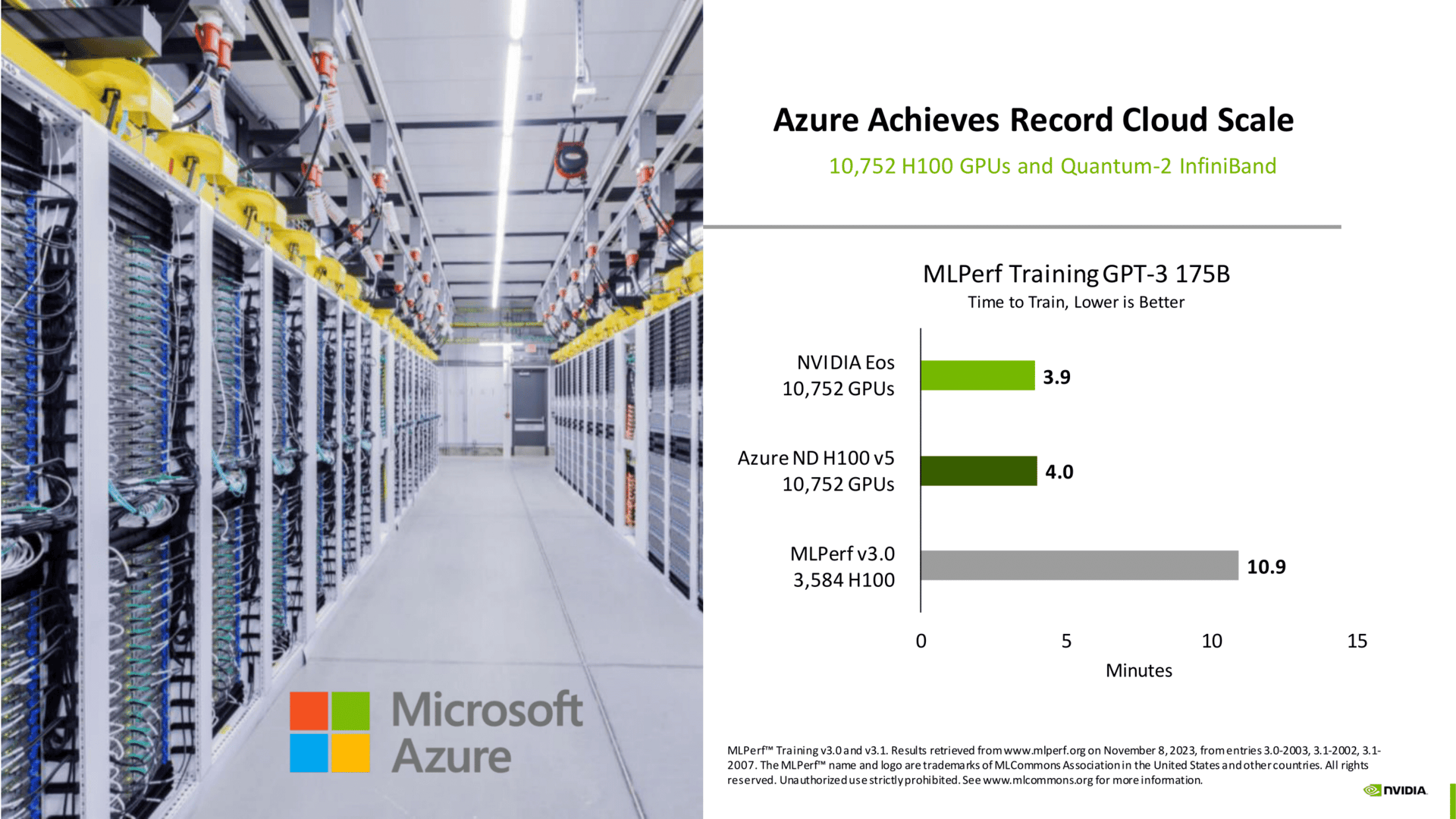

Besonders geht der Verweis dazu in Richtung Microsoft und Azure, die mit einem nahezu identischen System wie ihr aufgewerteter Supercomputer Eos auch quasi die gleiche Leistung ermittelt haben. Der Unterschied: Nvidias Supercomputer ist nur für eigene Zwecke und in einer Laborumgebung im Einsatz, Azures steht kommerziell „für Jeden“ zur Verfügung.

Damit will Nvidia jedoch zeigen, wie gut die Software und Hardware zusammenarbeitet, nicht nur im Labor sondern auch in der Praxis im Einsatz. Der Punkt führt letztlich zurück zum Anfang, dass die Software der Schlüssel zum Erfolg ist, dies aber viel Personal erfordert und eben Zeit in Anspruch nimmt. Dass es letztlich AMD nicht einmal schafft in einem Teilbereich ein Ergebnis zu liefern, lässt Nvidia letztlich genüsslich über die Präsentation anmerken. Die Nachfrage von ComputerBase bei AMD bezüglich Vorab-Briefings zu möglichen Benchmarks wurde mit der Antwort „aktuell gibt es von uns keine Pläne diesbezüglich“ abgeschmettert. Eventuell schaffen es ja im kommenden Jahr einige AMD-Partner, dies zumindest in einigen Teilen umzusetzen, wenn AMD selbst es nicht will.

MLCommons und die verschiedenen Tests stehen letztlich noch genau so am Anfang wie die teilnehmenden Parteien und das große Thema AI, Machine Learning & Co. Dies wird eindrucksvoll sichtbar in den Verbesserungen binnen kurzer Zeit, aber auch zusätzlichen Verfahren zur Bestimmung der Leistung, die stets und ständig angepasst werden. Genau hier müssen die Hardwarehersteller deshalb auch stets am Ball bleiben, nur Hardware auf die Probleme zu werfen hilft aber nicht, wenn die Software nicht bereit ist.

ComputerBase hat Informationen zu diesem Artikel von Intel und Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.