TensorRT for RTX: Optimiert Inference-AI für jede Nvidia-GPU automatisch

In Spielen ist es einfach: Durch die 3D-APIs wie DirectX oder Vulkan wird neue Hardware direkt unterstützt und läuft für gewöhnlich ohne weitere Anpassungen schneller. Bei AI-Software ist dies dagegen nicht der Fall, wie Tests mit Consumer-AI-Software auf ComputerBase bei den Blackwell-Grafikkarten von Nvidia gezeigt haben.

Ohne separate Optimierung gibt es aktuell Probleme

Die überall lauffähige DirectML-API scheint nicht so sehr von diesem Problem betroffen zu sein, das spezialisierte und auf GeForce-Karten optimierte TensorRT von Nvidia aber dafür umso mehr. Ohne einzelne Anpassung, wohl gemerkt im besten Fall für jede einzelne GPU, steigt die Performance mit neuer Hardware nicht an – und gar nicht so selten läuft das Programm noch nicht einmal.

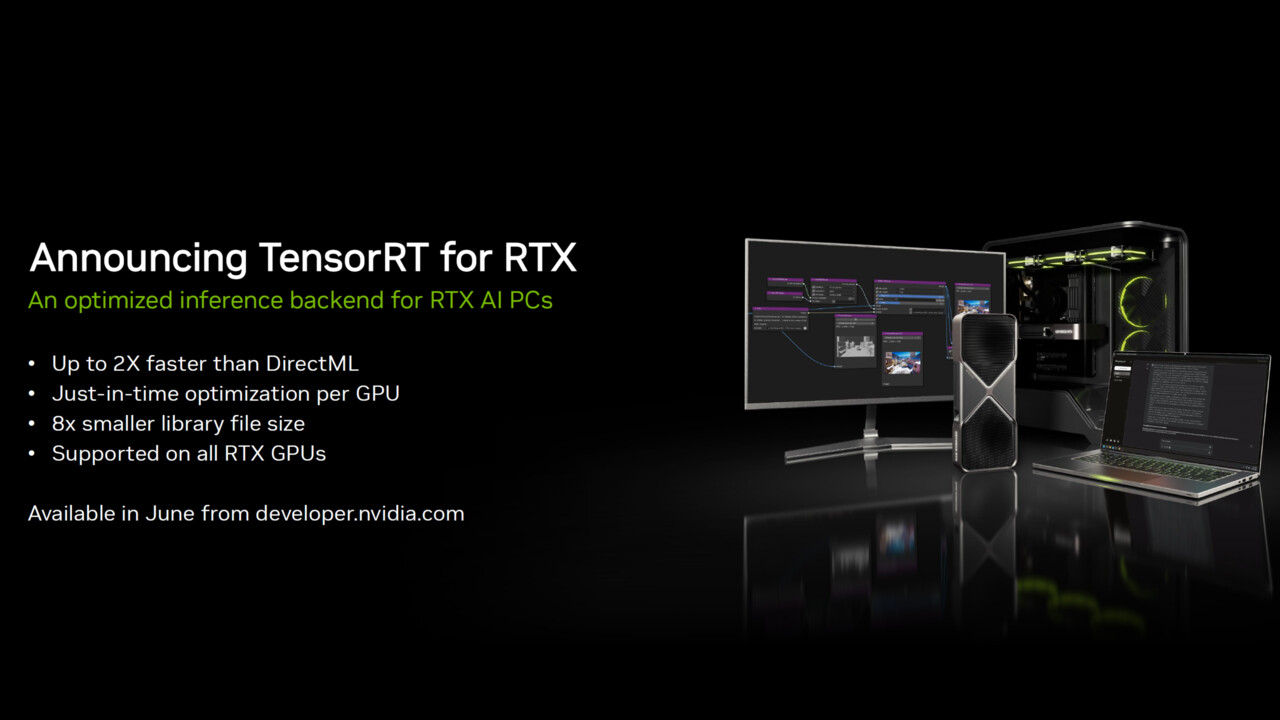

Das soll sich nun ändern, wie Nvidia auf der Entwickler-Veranstaltung Build von Microsoft bekannt gegeben hat. Unter der Bezeichnung „TensorRT for RTX“ stellt Nvidia eine überarbeitete Fassung der eigenen Software-Tools bereit, mit der es in Zukunft nicht mehr nötig sein wird, dass Entwickler ihr Programm für jede einzelne GPU, teils auch jedes einzelne Grafikkarten-Modell optimieren müssen.

TensorRT wird automatisch für die eigene GPU optimiert

Das wird in Zukunft automatisch durch TensorRT for RTX geschehen. Die TensorRT-Optimierung findet in Zukunft in Echtzeit auf dem eigenen PC statt und soll einmalig einige Sekunden andauern. Ist der Vorgang abgeschlossen, soll die TensorRT-Leistung identisch sein als wenn der Entwickler das Programm für die eigene Grafikkarte händisch optimiert hätte. Oben drauf kommt noch, dass die neue Version von TensorRT nur noch ein Achtel so groß sein soll wie die alte – vermutlich, da in dieser eben nicht mehr die Optimierungen für sämtliche GPUs enthalten sein müssen.

Die neue Version von TensorRT wird wie die alten Varianten auf sämtlichen GeForce-RTX-Grafikkarten lauffähig sein.

TensorRT for RTX wird im Laufe des Junis von Nvidias Entwicklerseite herunterladbar sein und kann ab da an in die eigene Software integriert werden. Einige Entwickler haben zudem Vorabzugriff auf das Feature, Nvidia erwartet hier erste Programmversionen noch im Laufe des Junis.

ComputerBase hat die Informationen vorab von Nvidia erhalten. Diese wurden unter NDA zur Verfügung gestellt. Die einzige Vorgabe war der frühstmögliche Veröffentlichungszeitpunkt. Eine Einflussnahme des Herstellers auf die Meldung fand nicht statt, eine Verpflichtung zur Veröffentlichung bestand nicht.

- Microsoft Insider Preview: Datei-Explorer für Windows 11 erhält KI-Aktionen

- Microsoft Build 2025: KI-Agenten für jedes Unternehmen – und für alle Webseiten

- TensorRT for RTX: Optimiert Inference-AI für jede Nvidia-GPU automatisch