nukular8400 schrieb:

Laut

dieser Tabelle kann man bei einem 125W-Prozessor von AMD mit einem etwa 100W höheren verbrauch rechnen (gegen 3570k, unser Szenario sollen ja Spiele sein). Da wir mal nicht so sind, rechnen wir eher mit 80W Mehrverbrauch.

Und genau hier liegt ein riesen Problem!

Diese 110W mehr bei Prime95, sagen Nullkommanix über die Leistungsaufnahme beim spielen aus!

Spiele lasten die CPU nie zu 100% aus und es werden auch bei weiten nicht alle Kerne genutzt.

Nun folgt ein Beispiel, was der Unterschied ist zwischen Volllast und Teillast ausmacht.

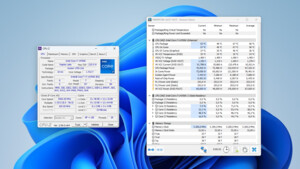

Leistungsaufnahme (Komplettsystem mit Radeon 6870)

Cinebench multi-thread:

FX-8350: 263,12W (6,93 Punkte -> 38W pro Punkt)

i5 3750K: 99,9 W (5,98 Punkte -> 17W pro Punkt)

Der AMD braucht 163W mehr.

Gemessen an Verbrauch/Punkt ist der i5 um 123% effizienter wenn die CPU voll ausgelastet wird.

Cinebench single-thread:

FX-8350: 96,11W (1,11 Punkte -> 87 W pro Punkt)

i5 3750K: 87,52W (1,59 Punkte -> 55 W pro Punkt)

Der AMD braucht nur noch 9W mehr.

Gemessen an Verbrauch/Punkt ist der i5 "nur" noch 58% effizienter wenn nur Teillast anliegt.

Diese dämlichen Volllast-Tests sind von der Realität doch meilenweit entfernt.

---

Der FX-6350 wird unter Prime sicherlich ~120W brauchen, beim spielen wird es aber deutlich weniger sein. Nur leider wird sowas ja nicht getestet. Warum eigentlich?