8 Kerne sinnvoll?

Und was hat der Laptop sonst noch zu bieten?

Nach reiflicher Überlegung war es mal wieder Zeit für einen neueren Laptop. In immer mehr Spielen gerät der hp mit Ryzen 5 3500U immer mehr ins Hintertreffen. Da hilft es auch nicht, dass ich hauptsächlich ältere Spiele zocke, mit der die Vega 8 noch gut zu Rande kam.

Also habe ich schon mal langsam meine Fühler Richtung neuen Laptop ausgestreckt, immer mit der Tatsache im Hinterkopf, das Weihnachten vollkommen ausreicht.

Da wäre der Ryzen 5 drei Jahre alt, was bei meinem Einsatzszenario ein gutes Alter ist.

Es kam dann doch anders. Denn ich hatte ein Lenovo Gerät mit guten Spezifikationen zu einem guten Kurs gefunden. Also habe ich die Chance genutzt und das Gerät bestellt.

Inhaltsangabe

Beim ersten, eigenen Laptop nach mehreren Jahren wurde es noch ein Pentium N3710, mit 17“, HDD und 4 Threads. (Ein Pentium N in 2021 – Sinnvoll oder nicht?) Nach einem Update von 4 auf 8 GB und einer Crucial SSD stand so langsam ein Update ins Haus, welches hp und der Media Markt prompt erfüllten.

Dank hellen 17“ Display war der Asus Laptop kein schlechter Begleiter, doch der neue Ryzen war natürlich ein gravierender Geschwindigkeitsboost.

An das nun kleinere Display mit 15“ musste ich mich gewöhnen, auch das es nicht gerade die hellste Kerze auf der Torte war.

Doch der Ryzen 5 3500U (Lesertest) hat für vieles entschuldigt. Dazu kam, das hp eine schnelle Samsung SSD mit 512 GB verbaute.

Nach zwei Aufrüstungen des RAMs arbeitet das Gerät jetzt mit 32 GB und ist auch dank der noch immer guten vier Kerne kein langsamer Begleiter.

Im Gegenteil, ein Kern wurde über Windows und die msconfig deaktiviert und gewann dadurch einen höheren TDP-Spielraum bei der Vega 8. Denn diese ist das Steckenpferd der Ryzen APU.

Nicht falsch verstehen, Vega ist wahnsinnig gut, im Vergleich zur Konkurrenz und wenn man das Alter im Hinterkopf behält.

Aber, sie braucht Bandbreite und eine Möglichkeit, ihren Takt auszufahren.

Ersteres lässt sich dank maximalen 2.400 MHz auf dem RAM nicht wirklich aufbessern, zweiteres schon, durch die Deaktivierung des vierten Kernes. Nur, selbst mit dem Ryzen Controller (Lesertest) waren GPU-Taktraten jenseits der 900 MHz eher die Ausnahme, als die Regel und bei erzwungenen 1,2 GHz kam es gar zu Abstürzen.

Die Nachfolger APU Ryzen 5 4500U vom User @Karre dreht dann dank des LPDDR4-4.133 Kreise um meine Vega. Der Fertigungsprozess von 7nm hat hier halt auch gewisse Vorteile.

Durch Zufall habe ich an einem Samstag dann den besagten Lenovo Laptop bei Geizhals gefunden.

Das Gerät kommt mit einem 16“ Display in 16:10, 350 Candela und 100% sRGB-Abdeckung daher.

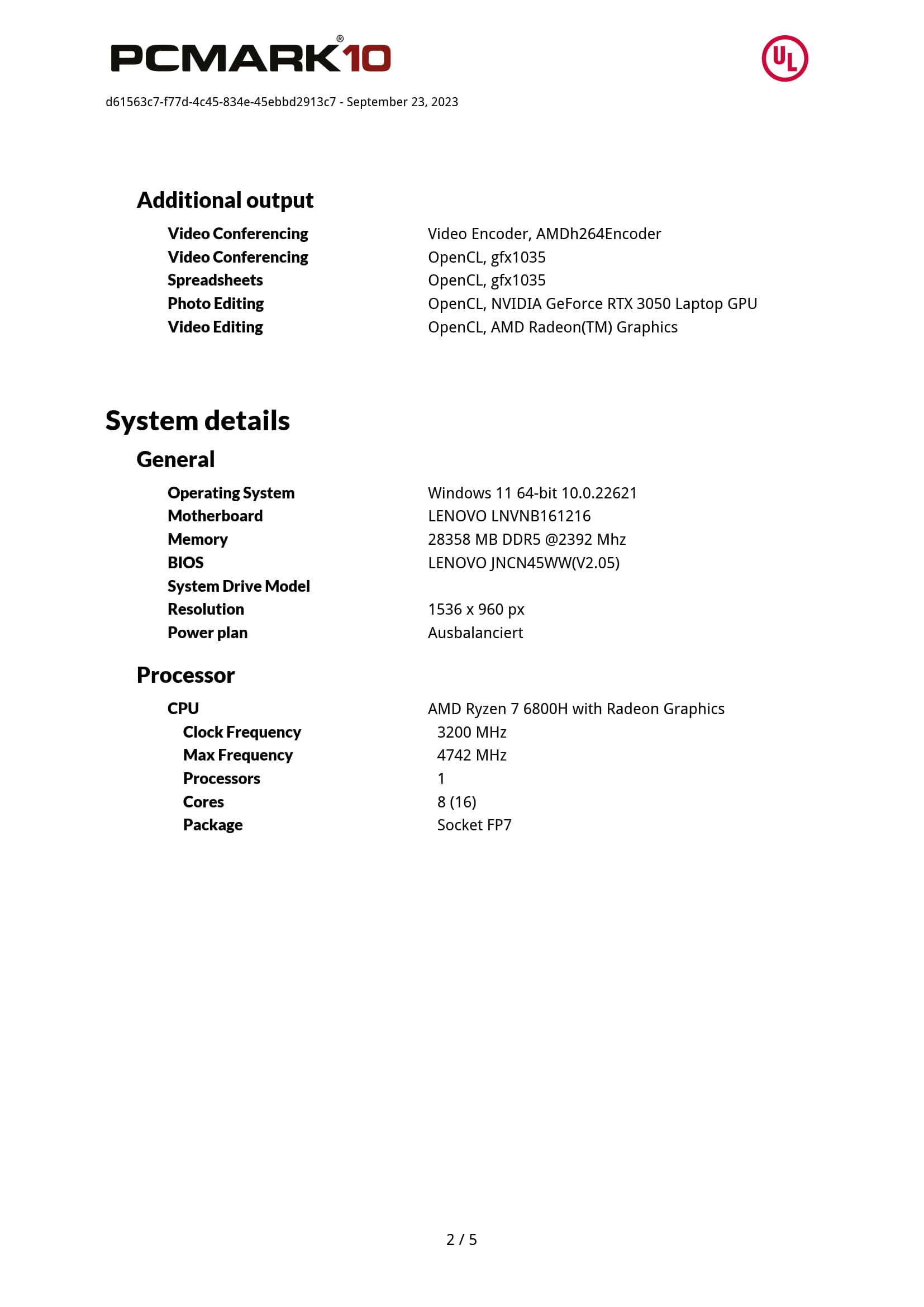

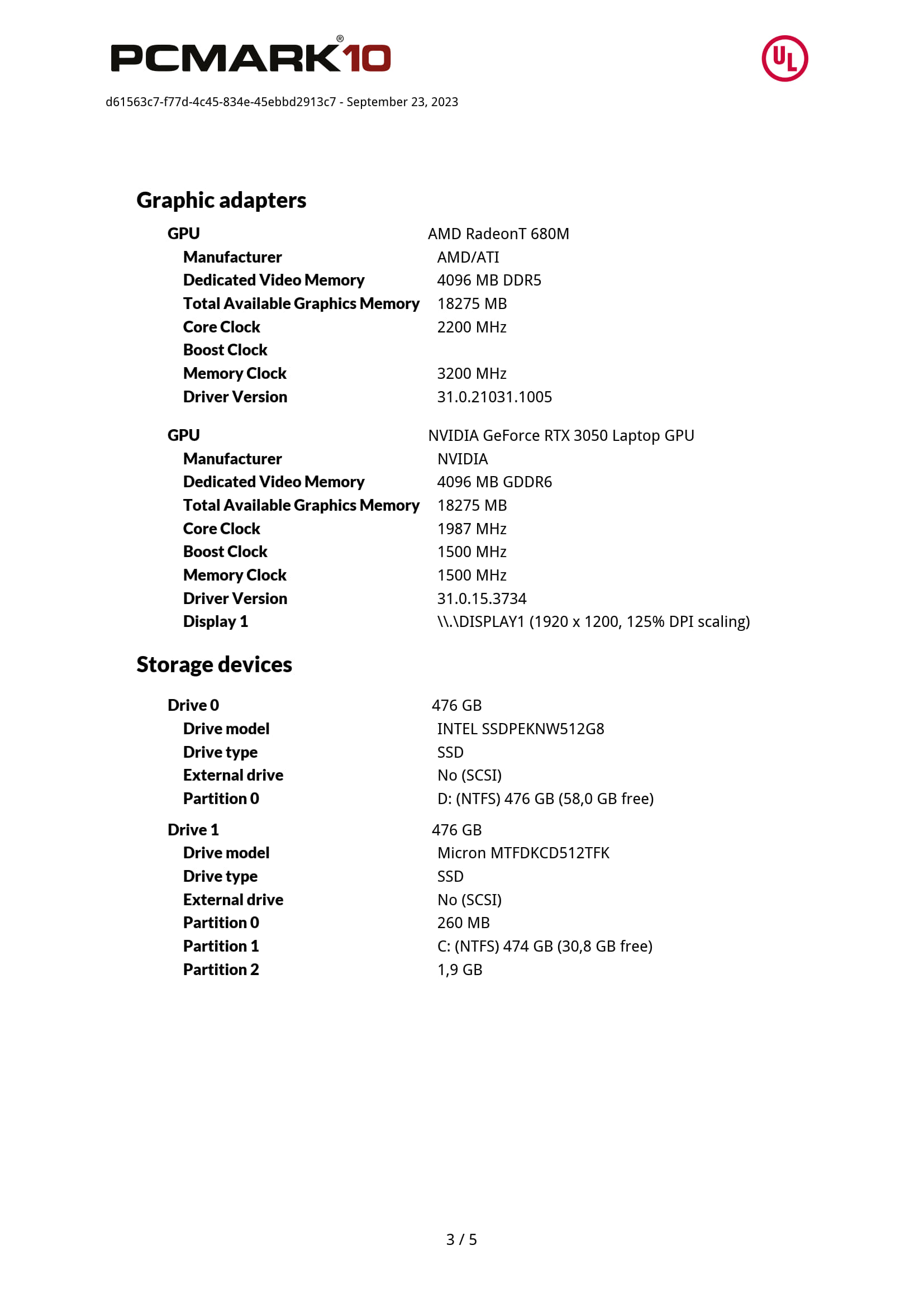

Sowie einem Ryzen 7 6800H, der GeForce RTX 3050m, 1x 16GB DDR5-4800 von Samsung und einer Micron SSD mit 512 GB und PCIe 4.0. Preislich lag dieses Angebot, inklusive zweiten 16 GB RAM Riegel, bei 800€.

Gegenüber dem hp Laptop wurde zwar die Kernanzahl, und damit auch die Threads wieder verdoppelt. Aber, in meinem Anwendungsbereich ist das der absolute Overkill.

Windows fühlt sich nicht viel schneller an und Gimp, was bei einigen Berechnungen von 16 Threads profitieren könnte, muss erst noch zeigen, ob das nicht zu viel des Guten ist.

Es handelt sich um ein Lenovo IdeaPad Gaming 3 16ARH7.

Der Ryzen 7 6800H verfügt über 8 Zen 3+ Kerne, inklusive Hyperthreading.

Angesiedelt ist die APU in der 45W Klasse bei AMD.

Ferner ist die Radeon 680M auf Basis der RDNA2 Architektur mit 12 CUs integriert, was dem Vollausbau in dieser Ryzen Generation entspricht.

Als Arbeitsspeicher kommt ein einzelnes Samsung Modul mit 16GB und einer Geschwindigkeit von 4.800 MHz zum Einsatz.

Für einen direkten Test zwischen Vega 8 und 680M ist das optimal, da beide Geräte so über die gleiche Bandbreite von 38 GB/s verfügen.

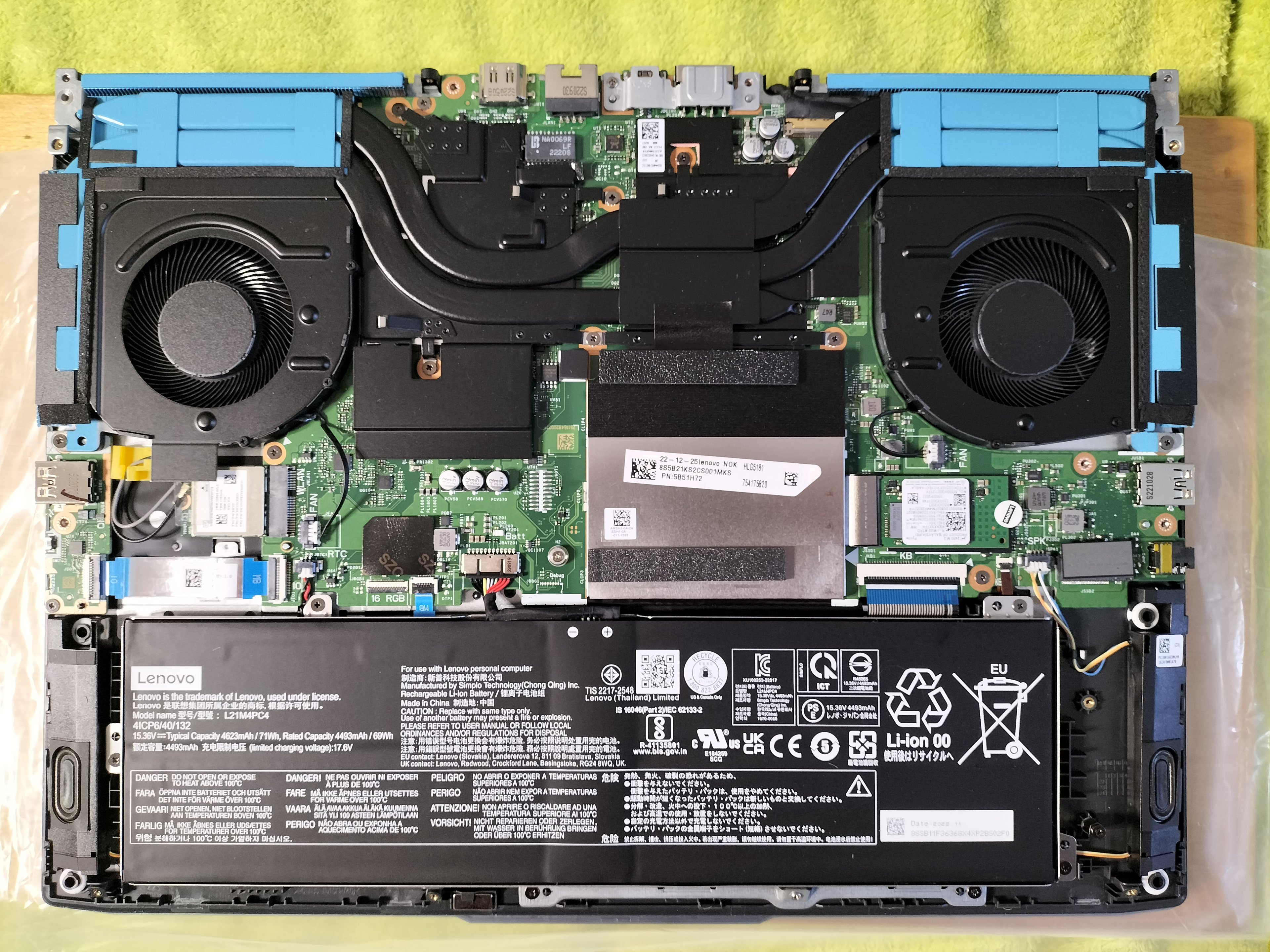

Da auch noch ein zweiter, leerer Steckplatz vorhanden ist, erhält der Arbeitsspeicher nach den ersten Tests ein Upgrade auf 32 GB, wobei das zweite Modul von Crucial stammt.

So kann man dann die Radeon und die GeForce besser vergleichen.

Denn, neben der iGPU gibt es noch die kleine RTX 3050 mobile mit 4 GB und max. 65 W TDP.

Als Datengrab kommt eine Micron SSD mit 512 GB und PCIe 4.0 @4x Anbindung zum Einsatz, erweitert durch eine Intel 660p mit ebenfalls 512 GB, aber QLC-Technik. Beide nutzen einen SLC-Cache, verfügen aber über keinen DRAM für die Mappingtabelle (ähnlich einer Inhaltsangabe).

Als Display kommt ein IPS-Panel mit max. 350 cd/m² (laut Hersteller), 16“ im 16:10 Format und einer Auflösung von 1920x1200 Pixeln. Während der unten aufgeführte Ryzen 5 ein 15,6“ Display mit Full HD nutzt, trumpft das neue Panel in der Höhe auf, denn da finden sich 20 mm zusätzlich ein.

*Aufgrund des Infinity Cache liegt die praktische Bandbreite höher, genauere Daten liefert AMD aber nicht. Wenn man sich die Daten der RX 6500 XT (AMD Radeon™ RX 6500 XT Grafikkarte | AMD) anschaut, könnte die effektive Bandbreite bei ca. 200 GB/s liegen.

Rein von den Daten her, ist der Sprung also nicht gerade klein, auch wenn man in alltäglichen Aufgaben nicht viel davon mitbekommt.

Was aber sofort positiv ins Auge fällt, okay, eher ins Gehör ist die angenehmere Geräuschkulisse. Selbst wenn Prime95, Furmark (GeForce) und der 3DMark (iGPU) laufen, wird das System zwar lauter, driftet aber nicht ins hochfrequente ab, wie es noch beim hp Laptop ist.

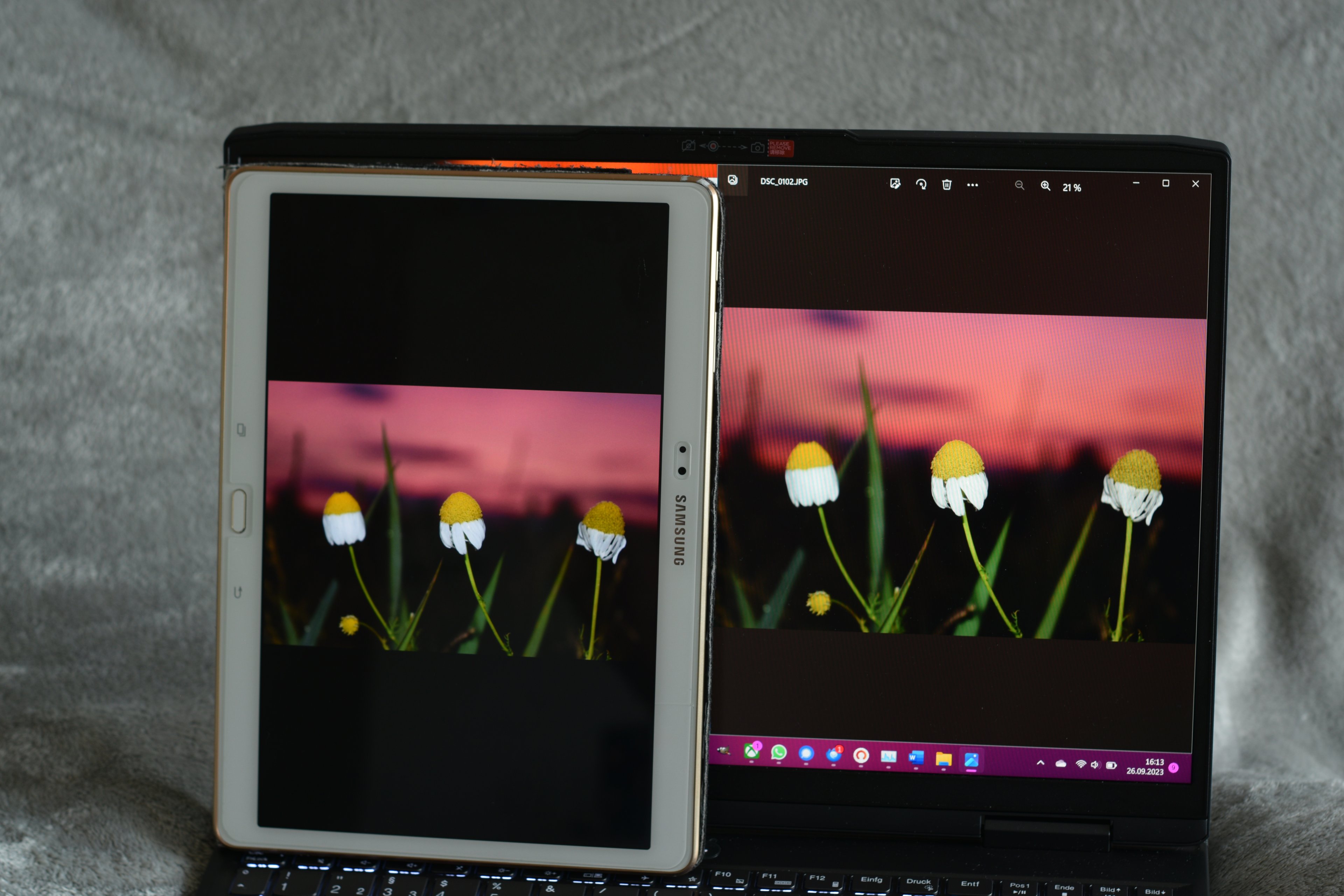

Auch ist das verbaute IPS eine Augenweide, gegenüber dem alten TN-Panel und es schlägt sich im Vergleich mit einem Super-AMOLED von Samsung auch ganz gut. Letzteres deckt zum sRGB-Farbraum noch den Adobe-RGB-Farbraum komplett ab. Bei der manuellen Helligkeit liegen Lenovo und Samsung gleich auf, mit einem kleinen Vorteil für das Tablet.

Die wesentlich höhere Auflösung des Tablets dagegen vermisse ich persönlich nicht.

Hinweis: durch den Moiré Effekt ist eventuell das Raster der Displays leichter zu erkennen

Bei unterschiedlicher Kamerabelichtung

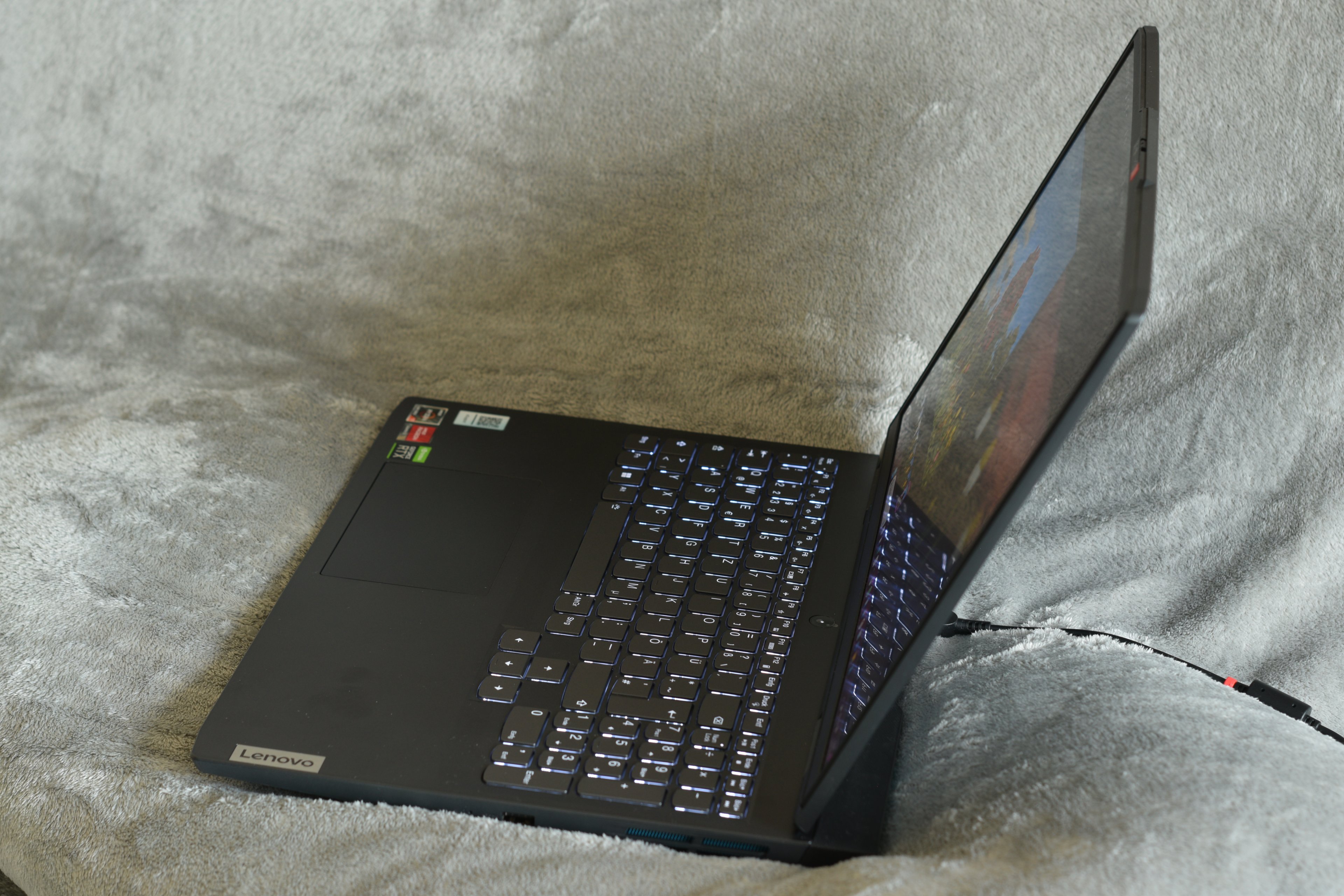

Die Tastatur ist die bei uns übliche QWERTZ-Ausführung mit zusätzlichen Ziffernblock und abgesetzten Pfeiltasten. Eine rein bläuliche LED-Beleuchtung lässt sich in zwei Stufen regeln.

Dazu kommt ein angenehmer Druckpunkt und auch akustisch macht diese einen guten Eindruck.

Unterhalb dieser ist ein großes, abschaltbares Touchpad, welches sich angenehm nutzen lässt. Das hp Touchpad fühlt sich beim Gleiten über dieses aber etwas angenehmer an, was aber reine Geschmacks- und Gewohnheitssache ist.

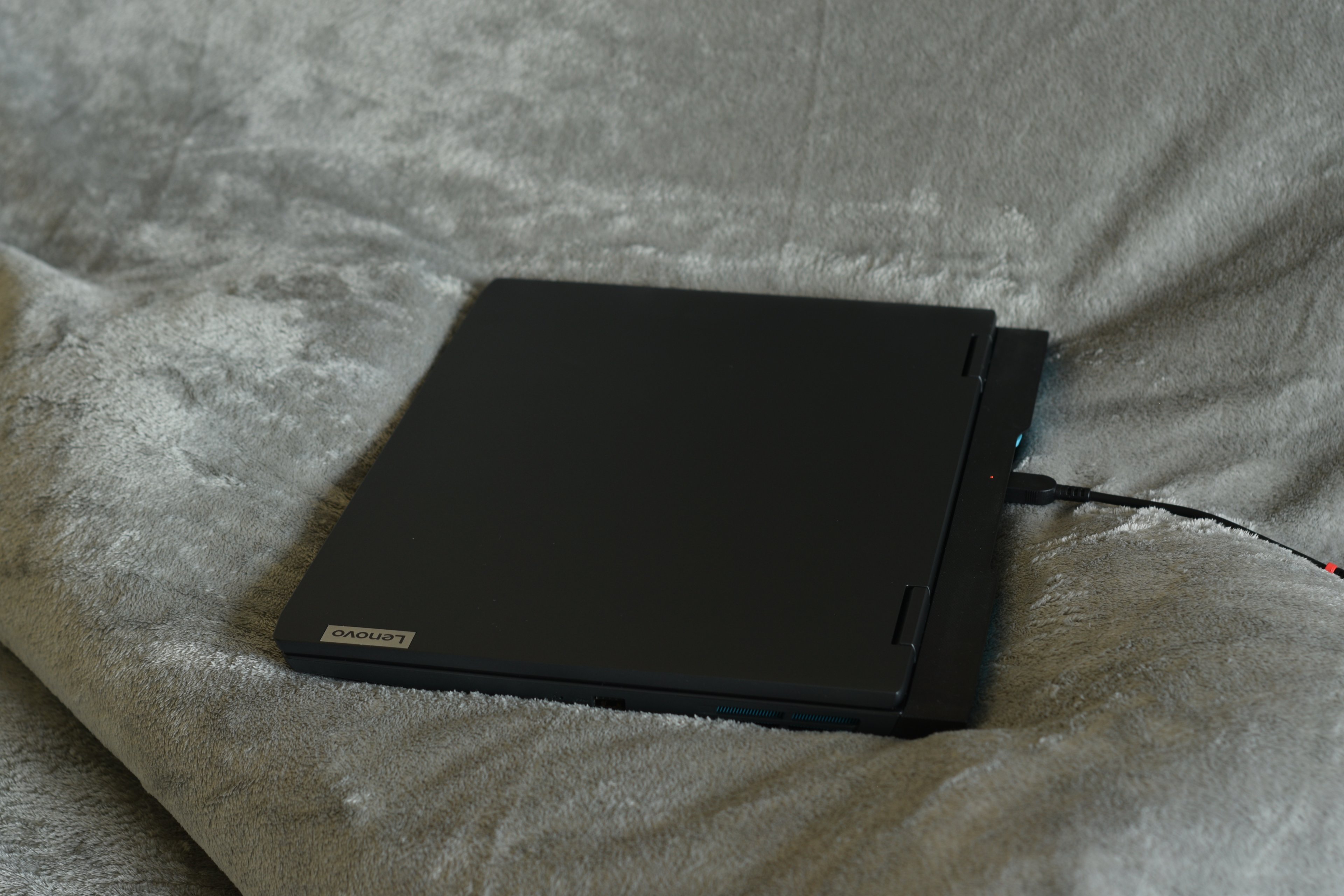

Kommen wir zu den Anschlüssen, diese befinden sich ungünstiger weise hauptsächlich auf der Rückseite. Da wäre der Stromanschluss, ein USB-C, ein RJ-45 für LAN-Kabel sowie ein HDMI-Anschluss. Links und rechts ist jeweils nur ein einzelner USB-A Port verbaut. Einen (Micro)SD-Karten-Leser hat sich Lenovo gespart, ärgerlich, sofern ich nicht die langsame USB 2.0 Geschwindigkeit der Kamera nutzen möchte.

HDMI -> LAN -> USB-C -> Power Anschluss

Der Powerknopf ist in der Mitte positioniert, genau zwischen Display und Tastatur. Die LED für das Netzteilkabel dagegen befindet sich hinter dem Display. Eine LED, jeweils Rot und Weiß gibt den Betriebspunkt an: laden/Ladung halten oder geladen.

Da Lenovo eine Schonung des Akkus zulässt, kann die Ladung bei 80% gehalten werden. Um diesen wieder schneller zu befüllen, existiert noch die Funktion Express-Laden.

Die beiden Lüfter sind unter Last, wie bereits erwähnt immer noch ganz angenehm. Und, über die Tastenkombination FN + Q lassen sich drei verschiedene Einstellungen wählen, Flüster-, Auto- und max. Betrieb. Letzterer lässt diese aber nicht dauerhaft mit hohen Drehzahlen arbeiten, sondern setzt auch hier wesentlich tiefer an. Das hat aber den Vorteil, dass die beiden Quirle nicht immer wieder aufdrehen, um gleich darauf abzuschalten (bei hp wäre das z.B. die UEFI-Einstellung „Fan Always on“). Je nach Betriebsart leuchtet der Powerknopf Blau, Weiß oder Rot.

Zum Thema Sicherheit muss man hier hervorheben, dass die Micron SSD bereits verschlüsselt ist. Wobei ich mich wieder frage, wo zum Henker der Sicherheitsschlüssel hinterlegt ist, in OneDrive sollte es nicht sein.

Naja, beim zweiten Versuch, den Windows Offline Defender zu nutzen lief dieser auch durch, ohne die Bitlocker Schlüssel zu verlangen.

Hinweis: mittlerweile bietet Windows 11 Home eine automatische Bitlocker Verschlüsselung an, dafür ist die Pro Version nicht mehr nötig. Nur kann man in der Home Variante diese nicht ohne weiteres abschalten und beim Einbau einer bereits verschlüsselten SSD/HDD wird diese nicht automatisch entsperrt. Dies geschieht nur bei einer Neuinstallation, nach der alle Laufwerke automatisch freigegeben werden.

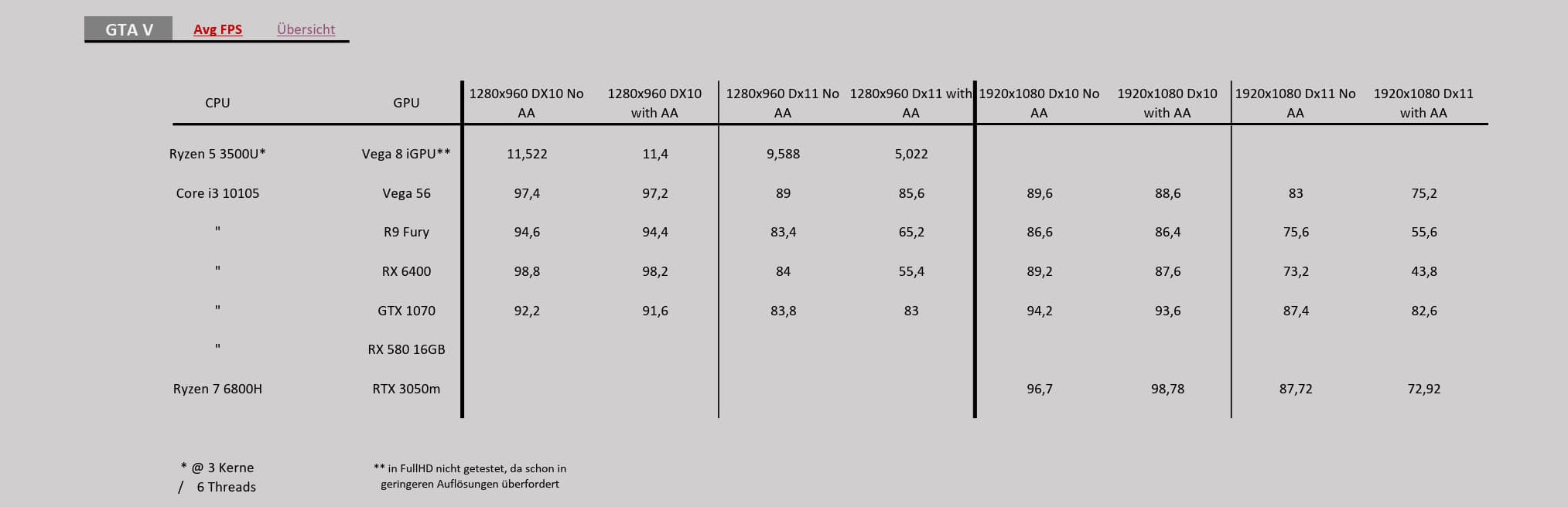

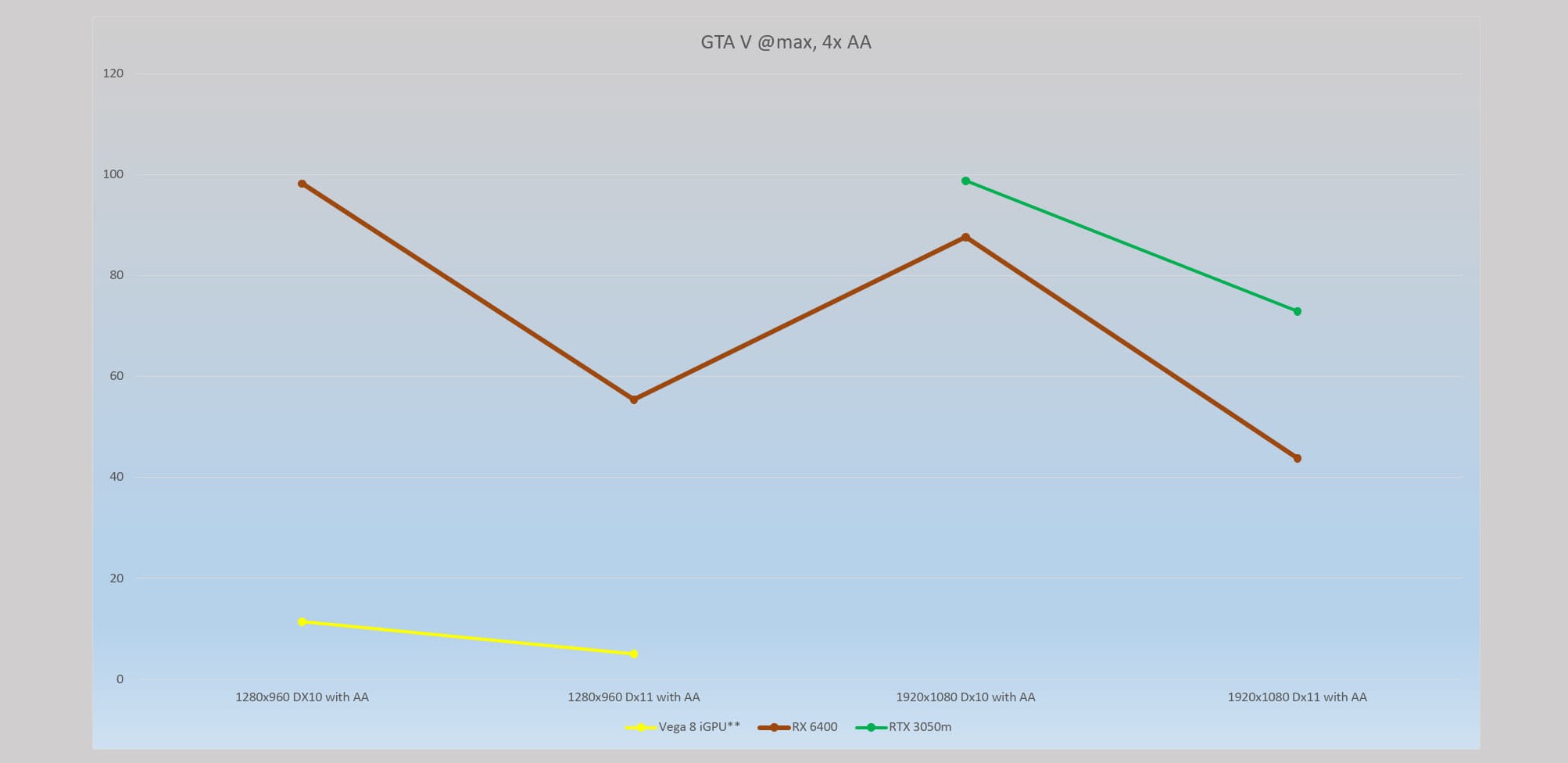

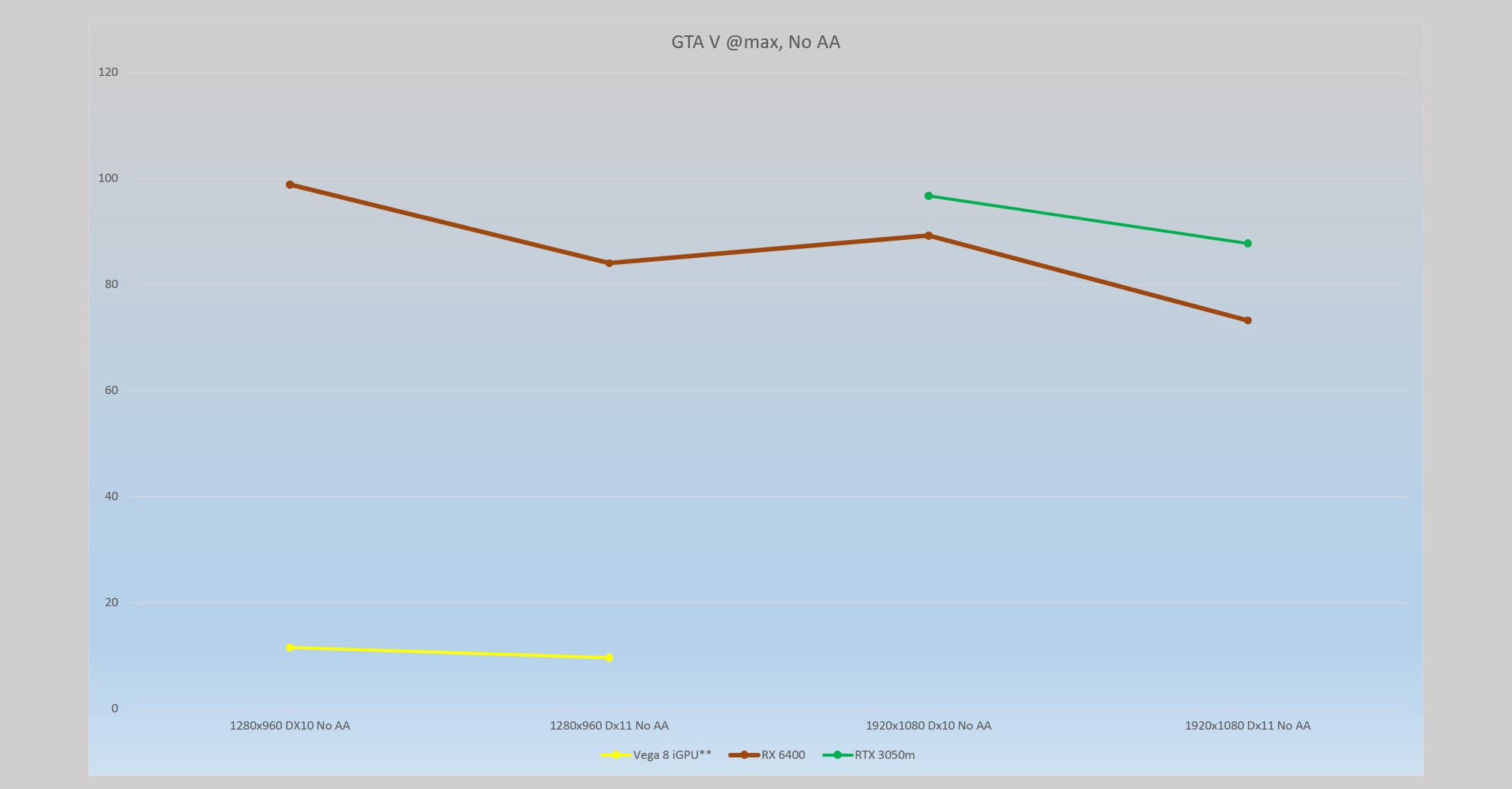

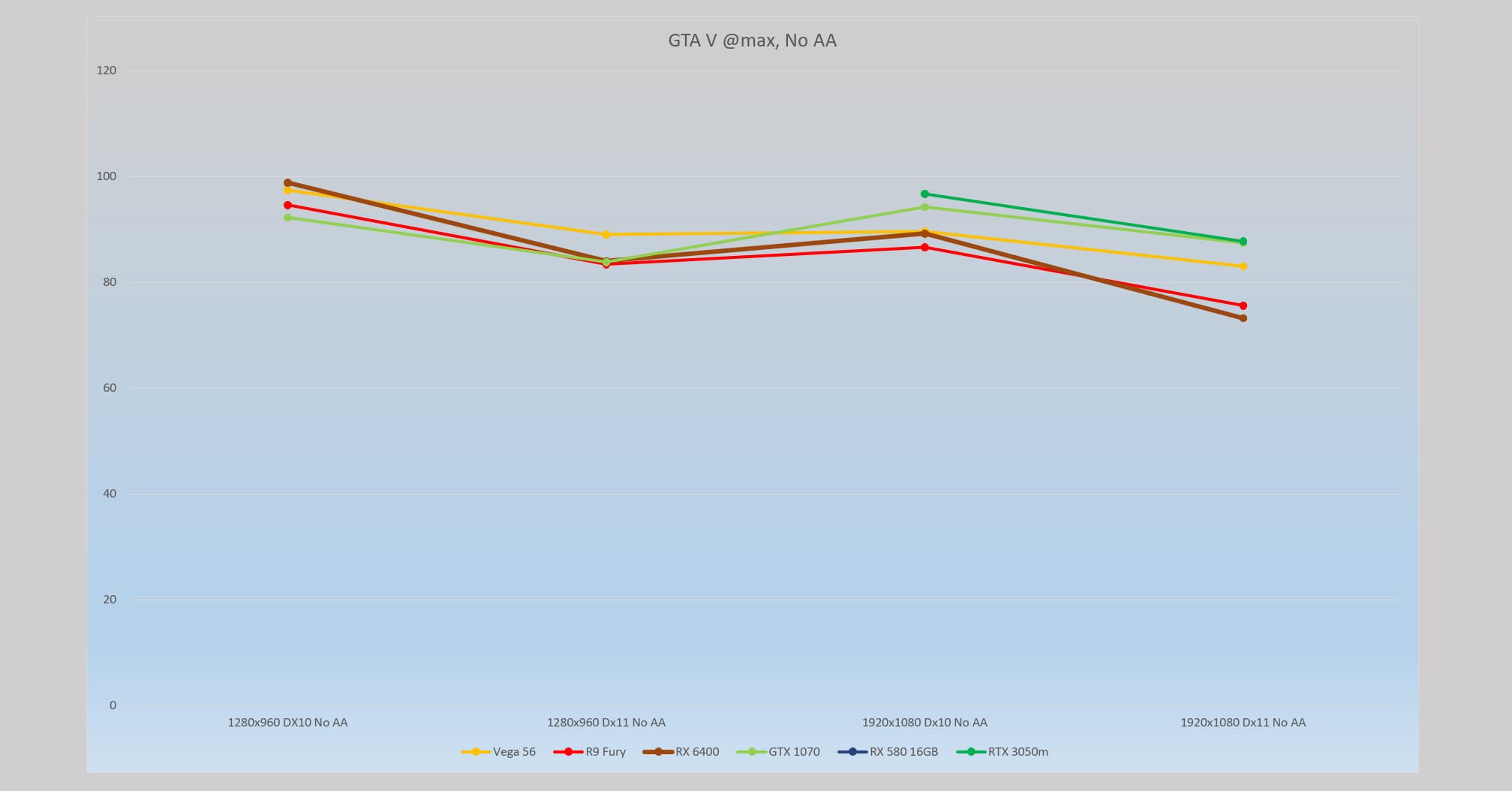

Die verwendete Software stützt sich teils auf synthetische und teils auf echte Games oder Anwendungen. Aufgrund von Zeitmangel fällt der Umfang etwas geringer aus.

In den Diagrammen sind teilweise nur die Hauptkonkurrenten RX 6400 und RTX 3050m aufgeführt.

*Werte sind für einen 100 MHz höheren Turbotakt

Blender Benchmark

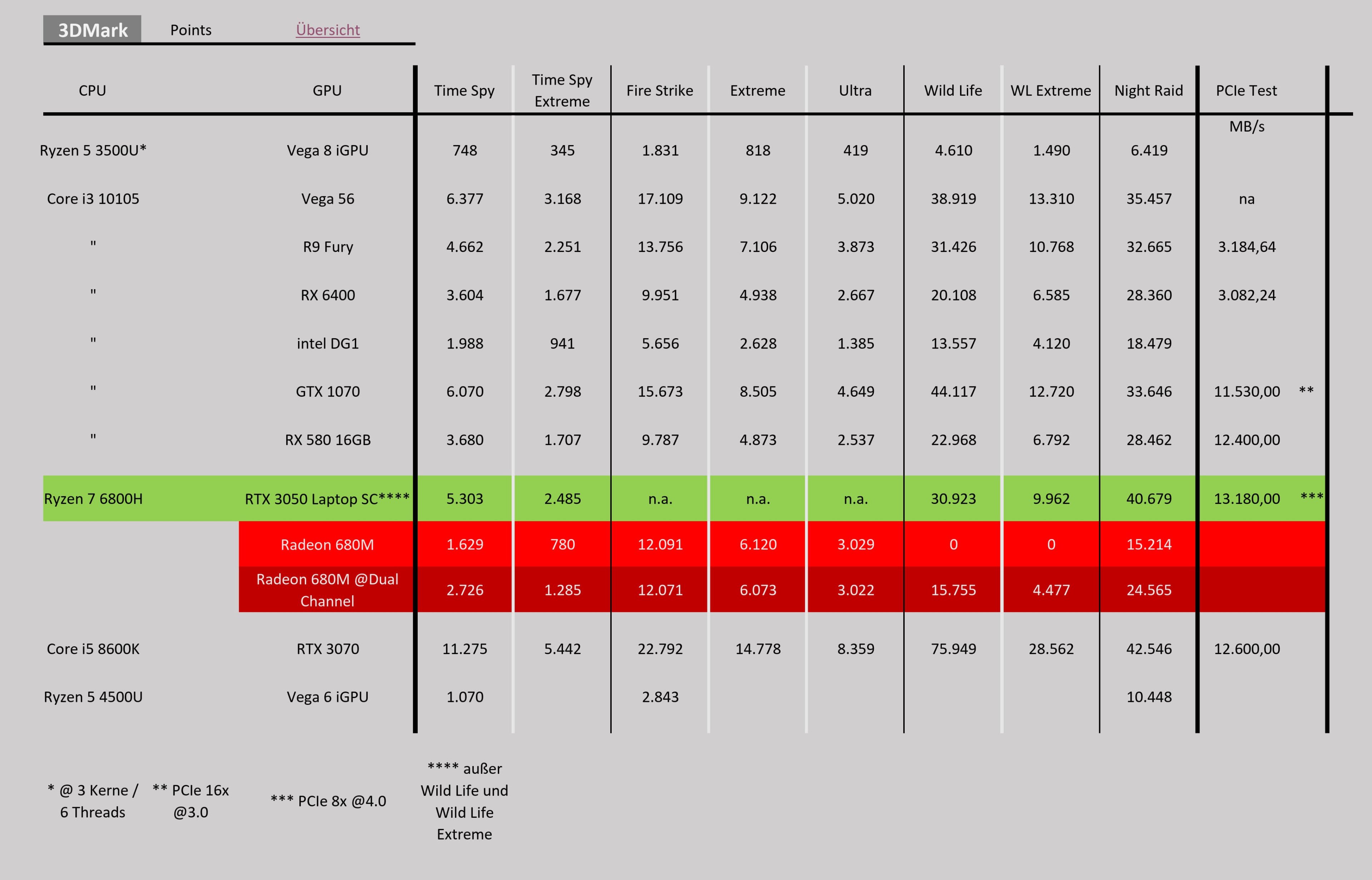

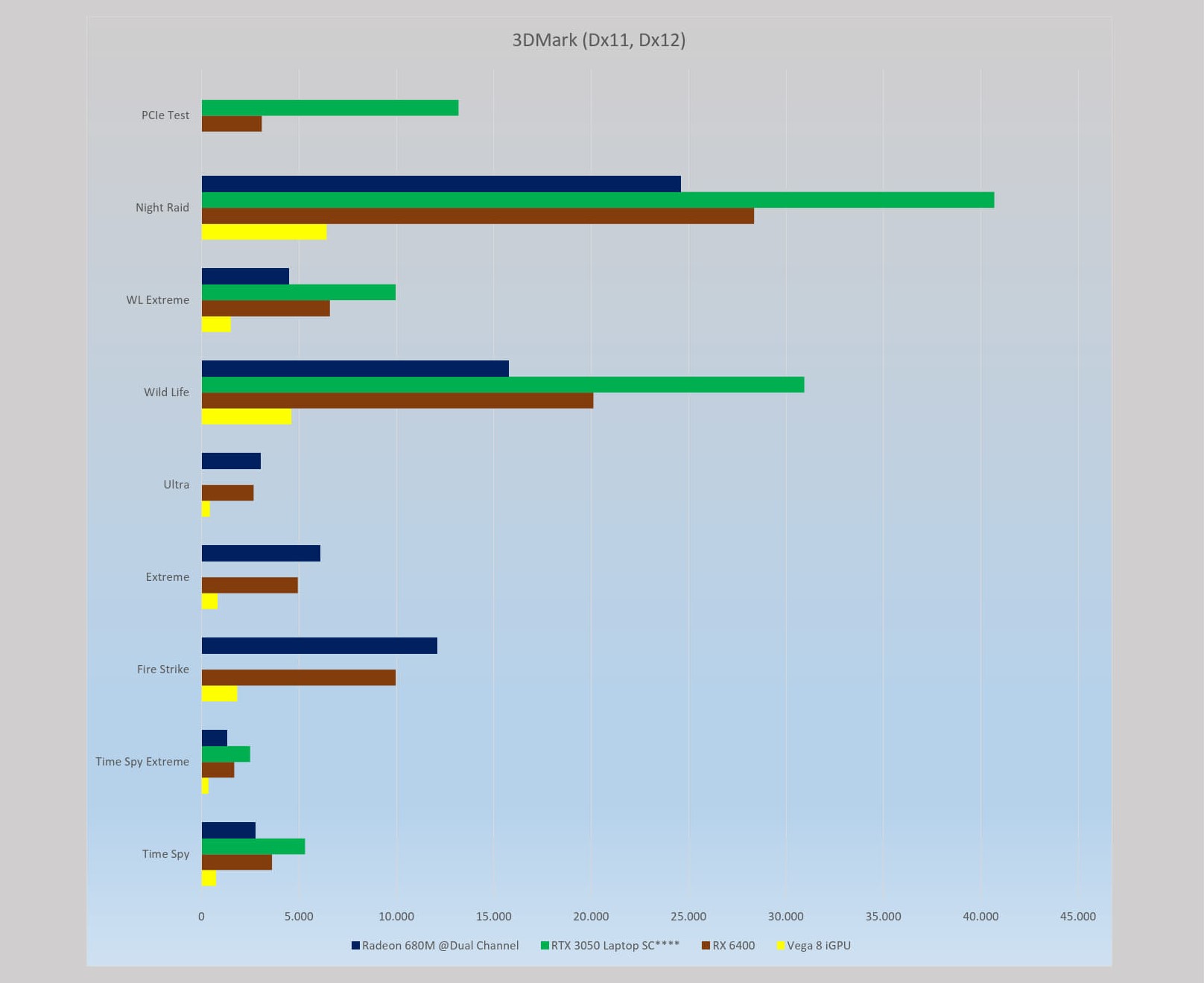

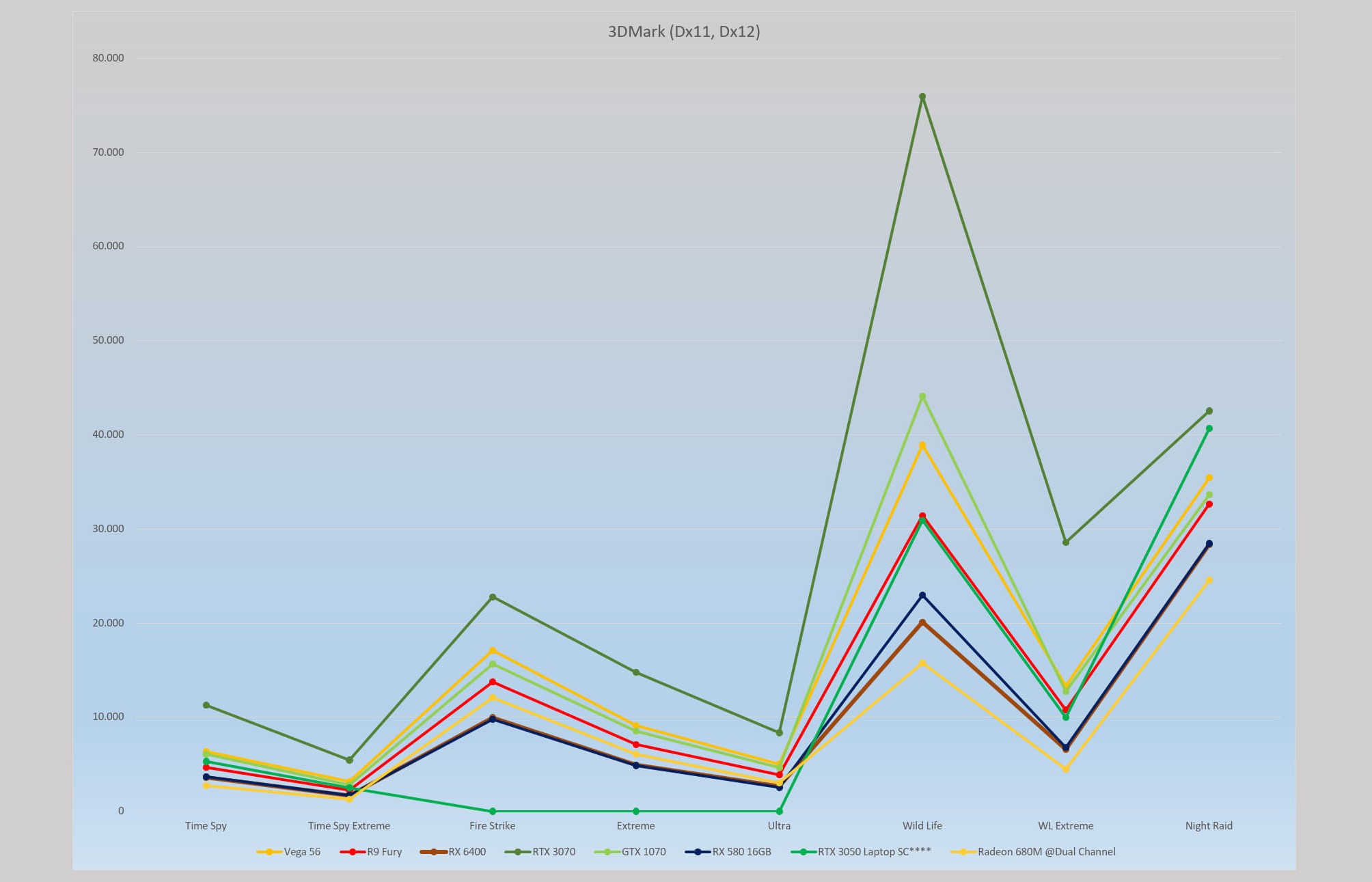

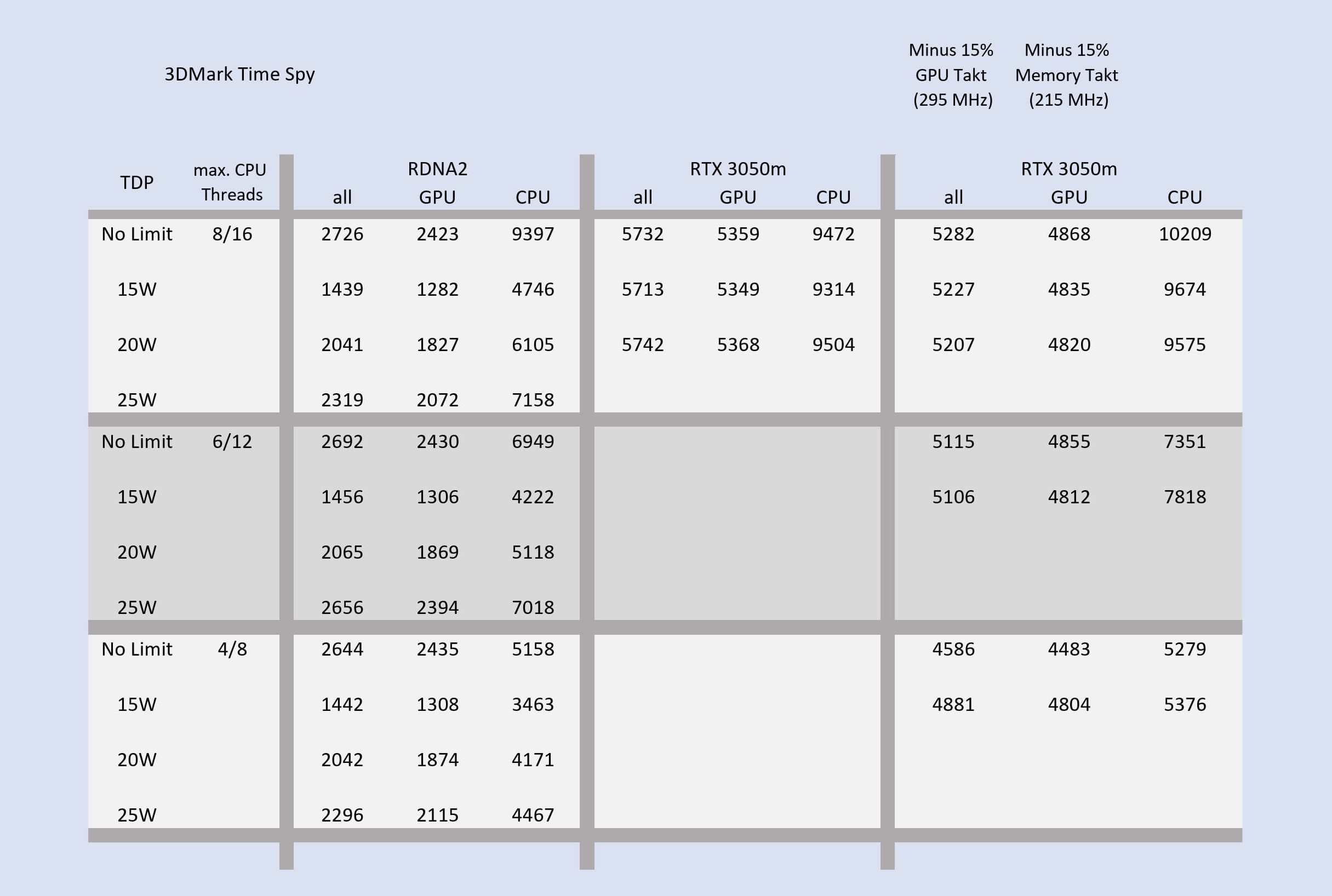

3DMark

RX 6400 nicht aufgeführt

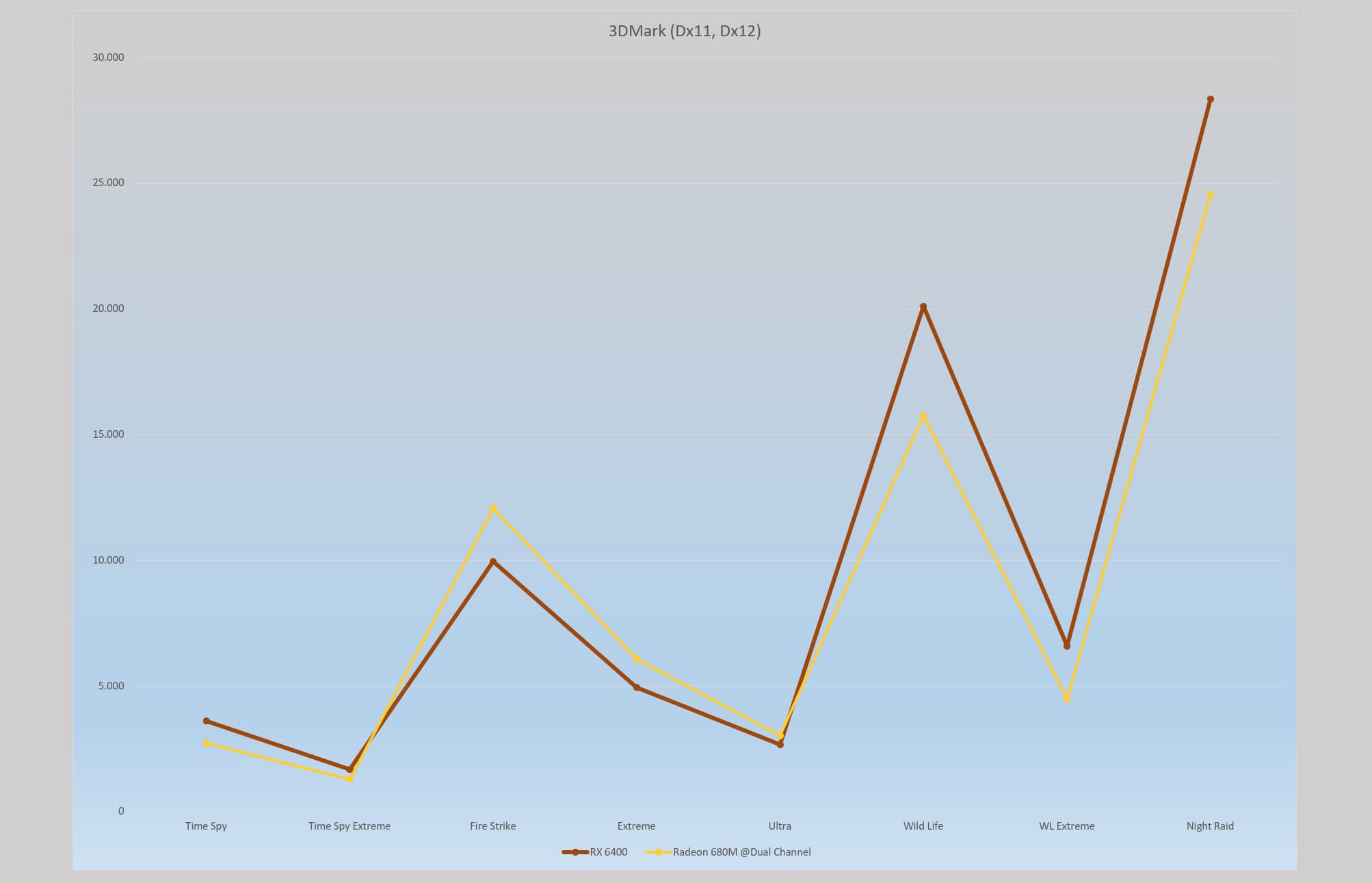

Kurioserweise ist die iGPU Radeon 680M teilweise schneller, als die RX 6400. Denn die 680M verfügt nur über 77 GB/s Bandbreite, die noch mit der CPU geteilt wird, während die RX 6400 über 128 GB/s verfügt, inklusive dem 16 MB großen Infinity Cache.

Sobald der Test der RX 580 16GB abgeschlossen ist, werde ich die 6400 noch einmal durch den Test Parcours jagen.

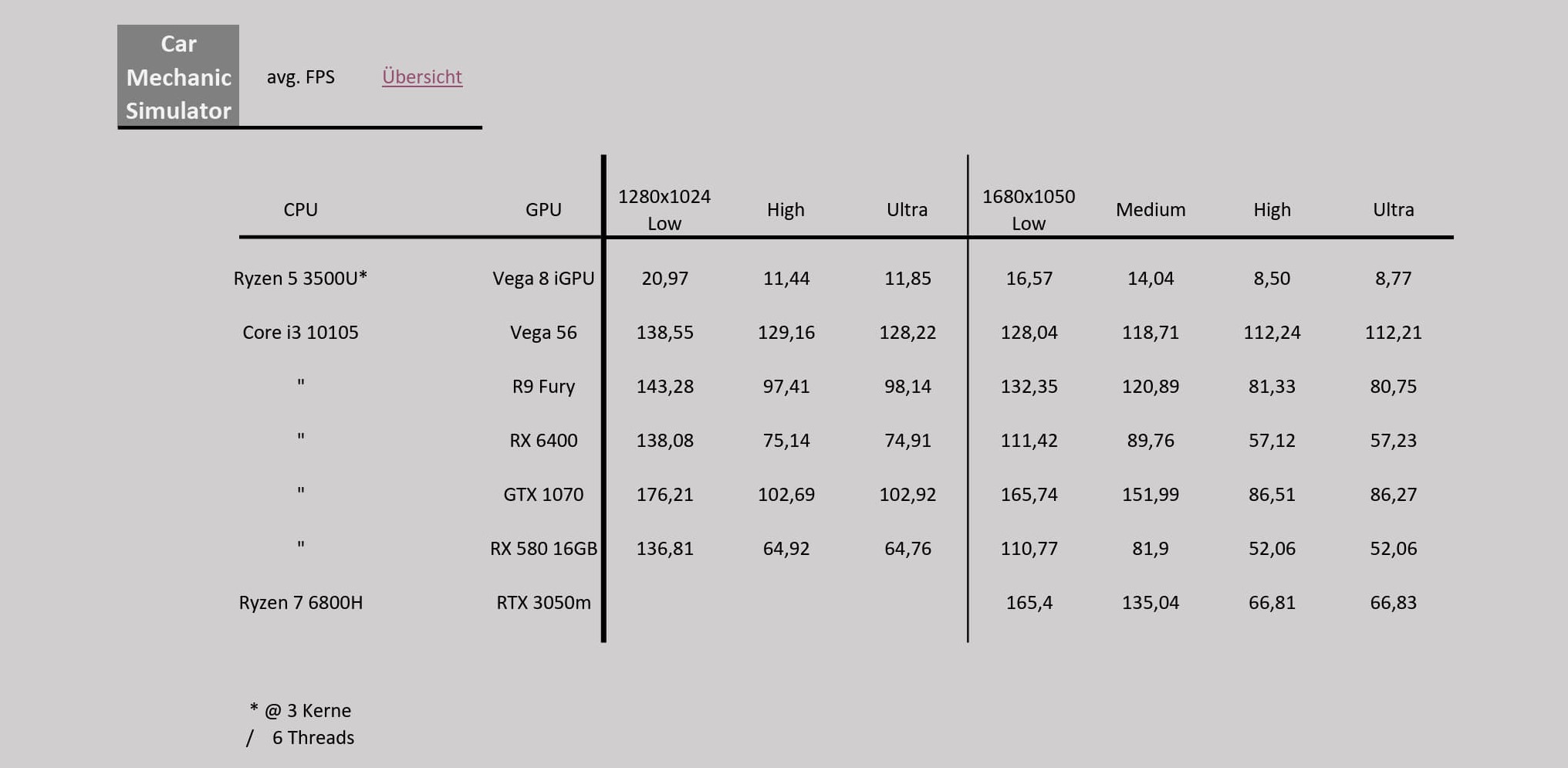

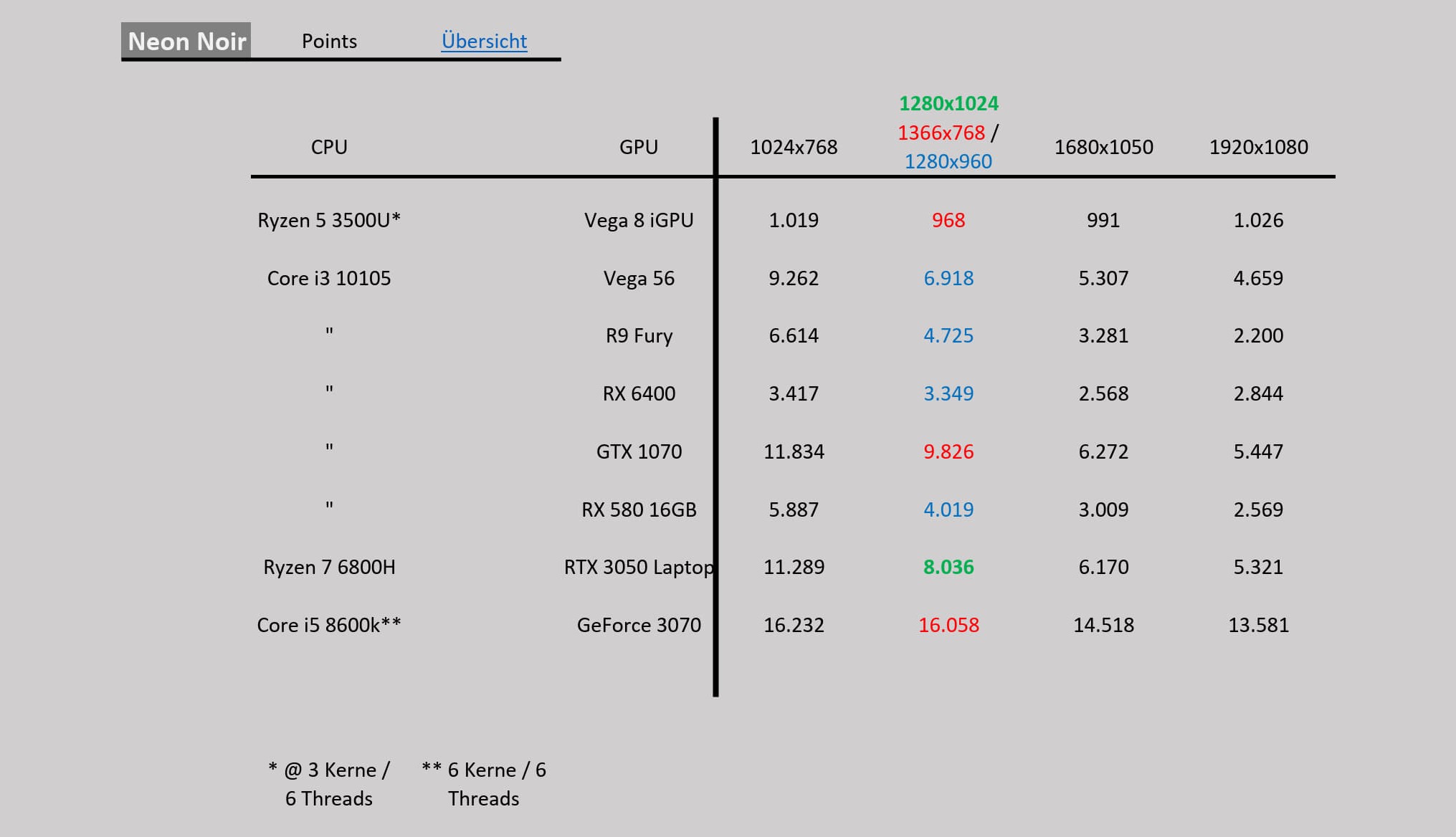

Car Mechanic Simulator

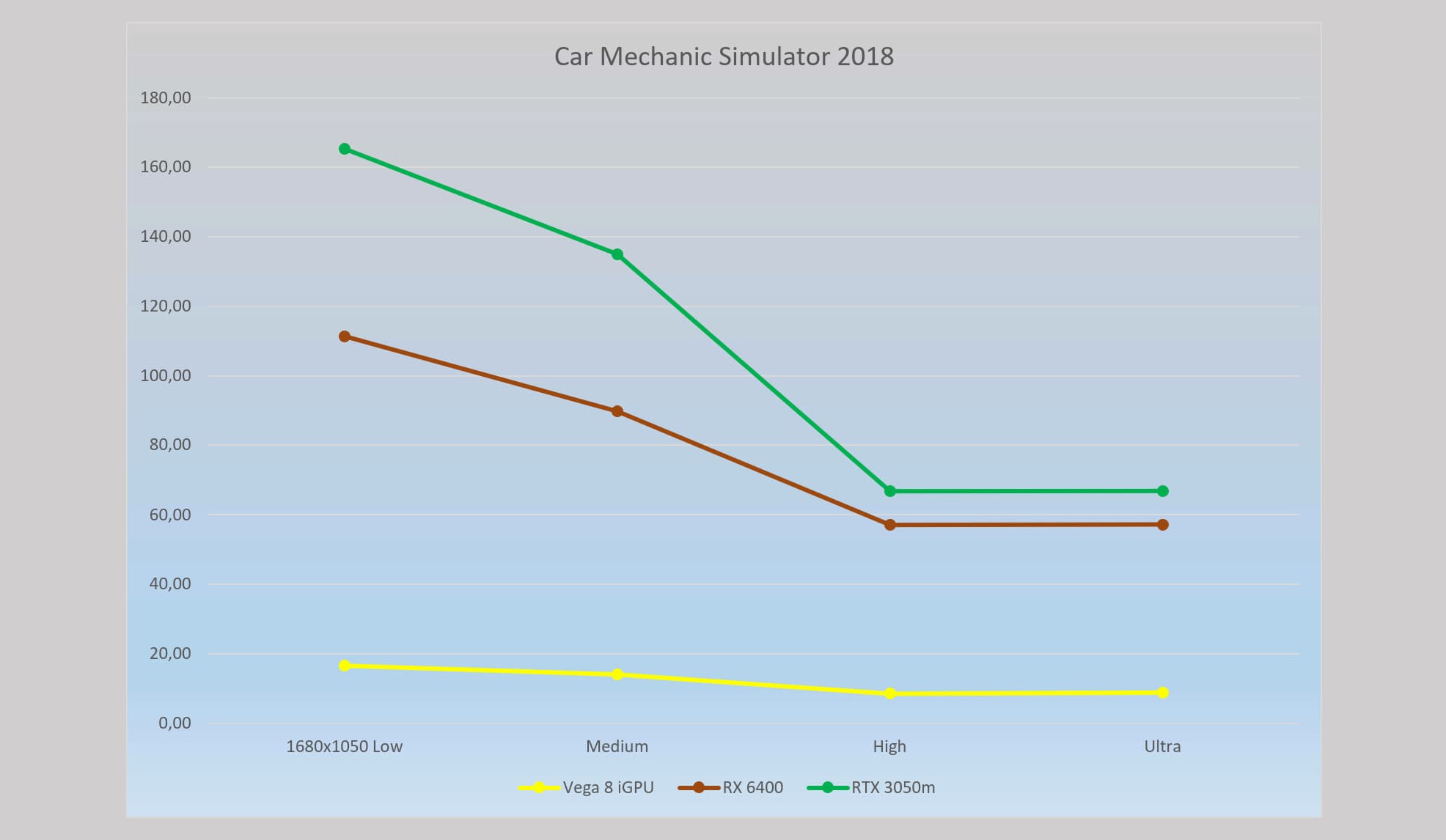

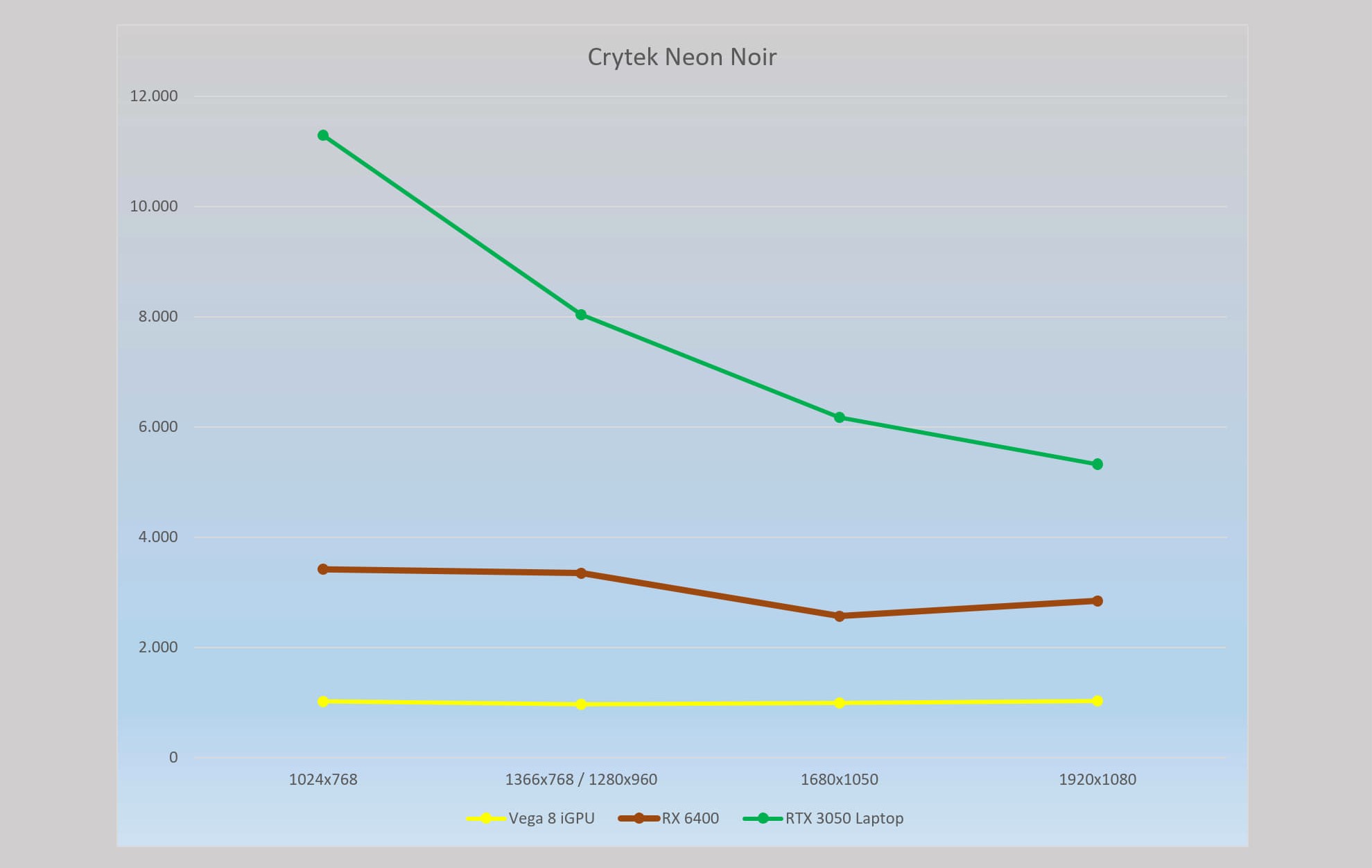

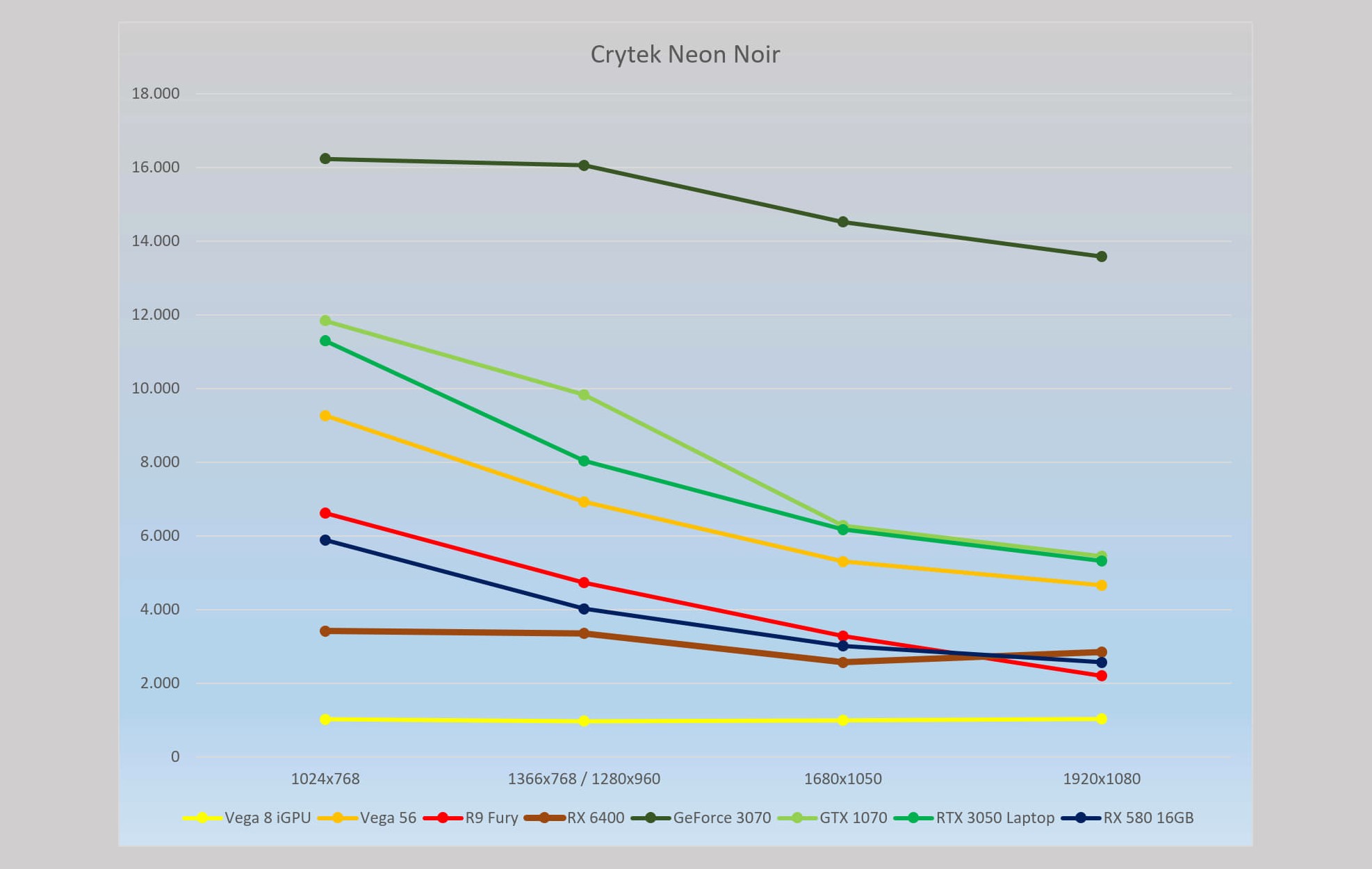

Crytek Neon Noir

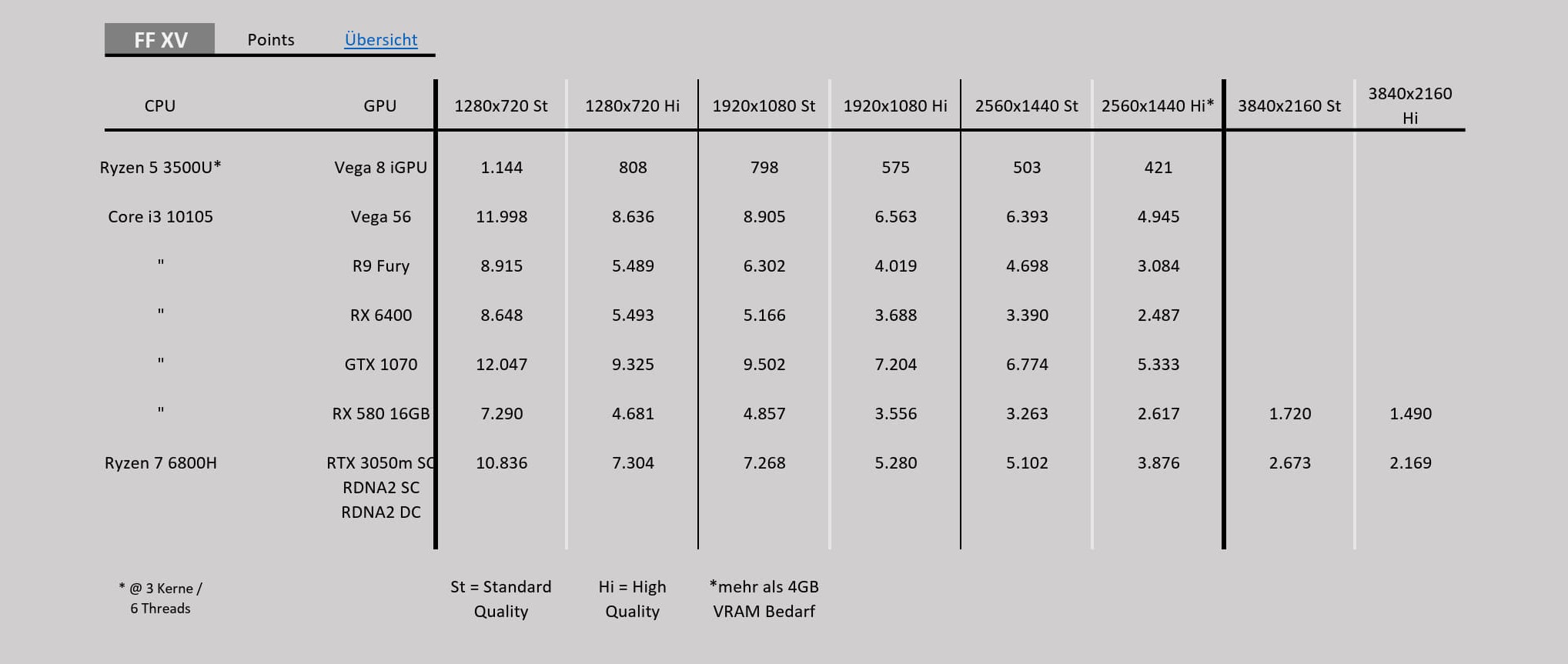

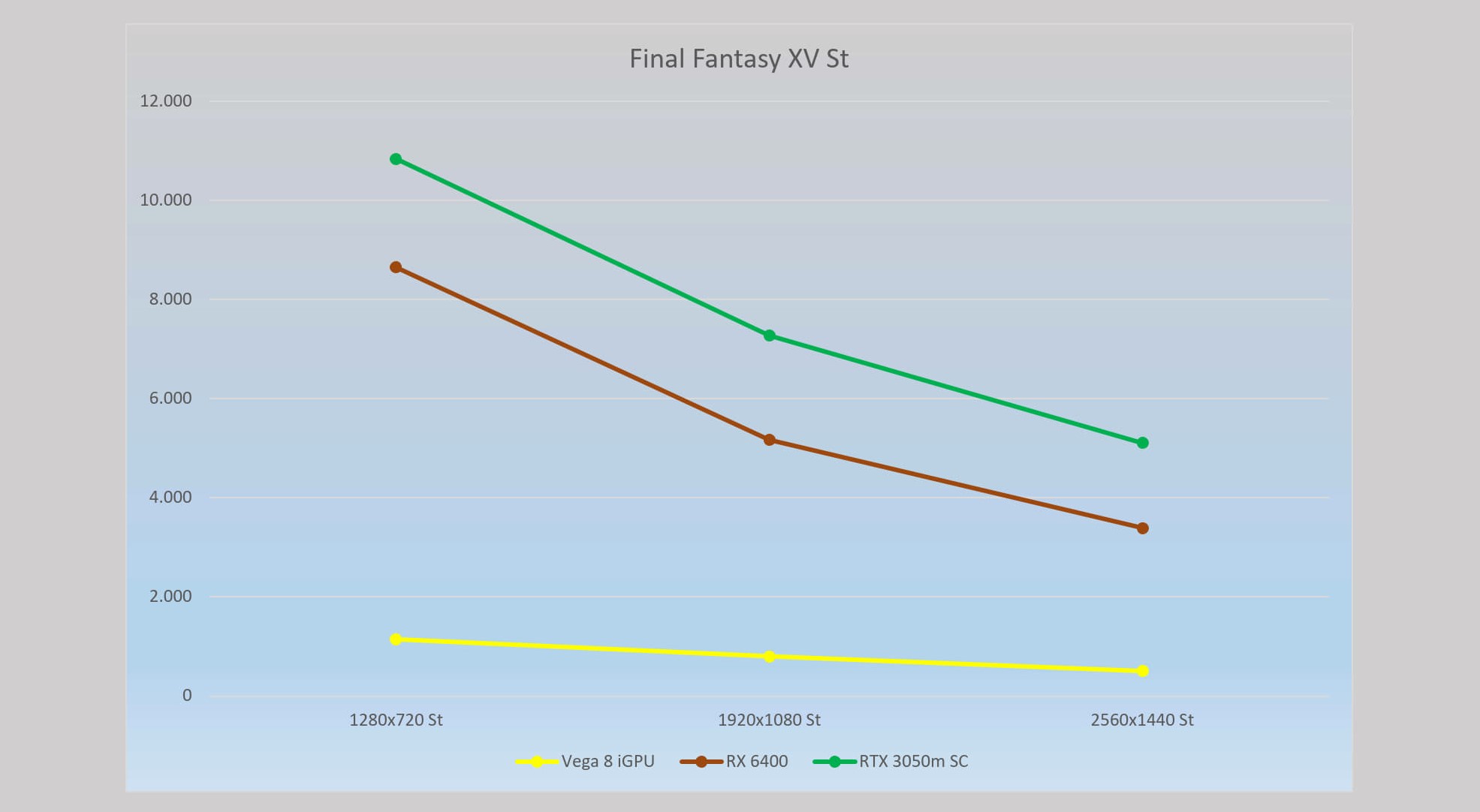

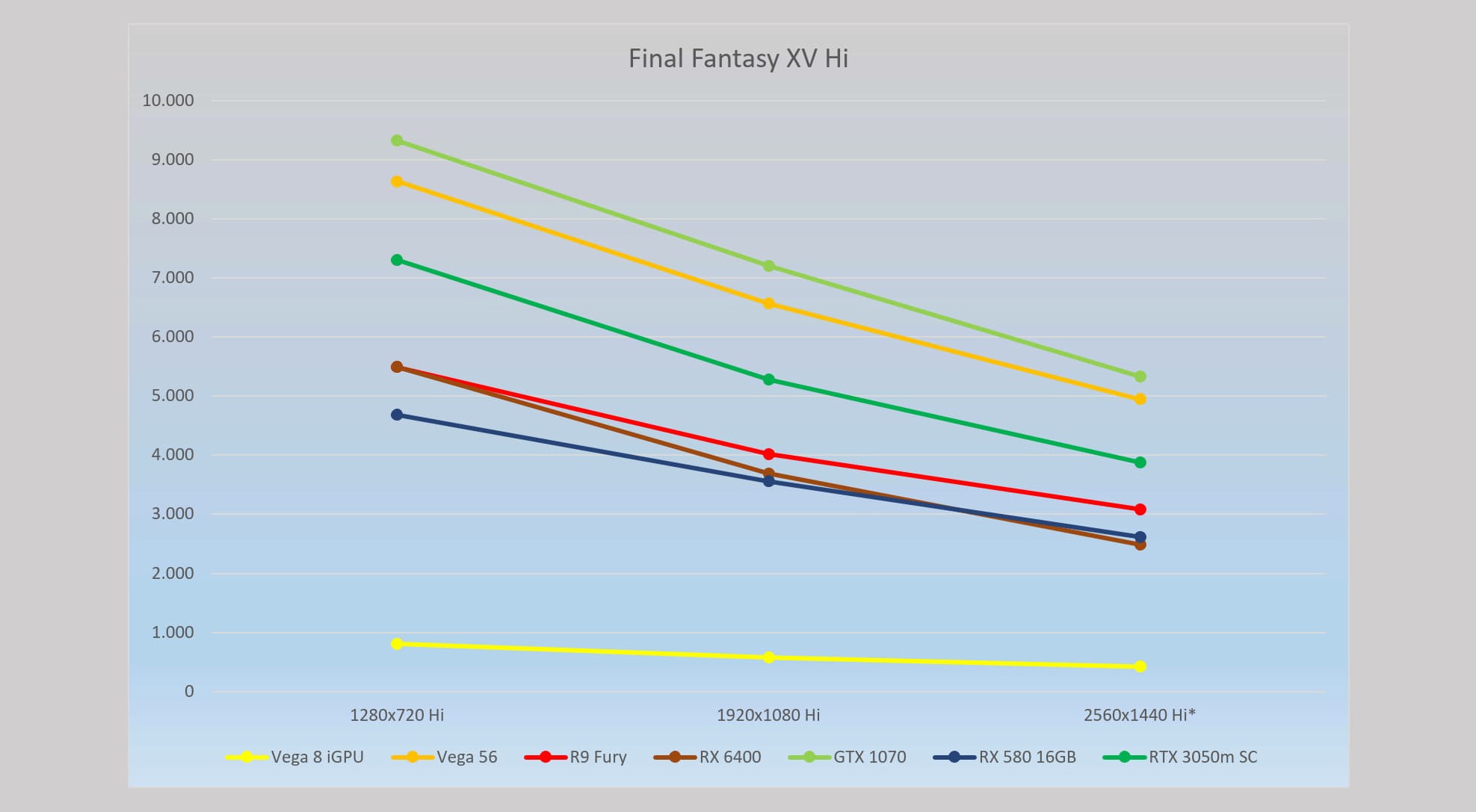

Final Fantasy XV

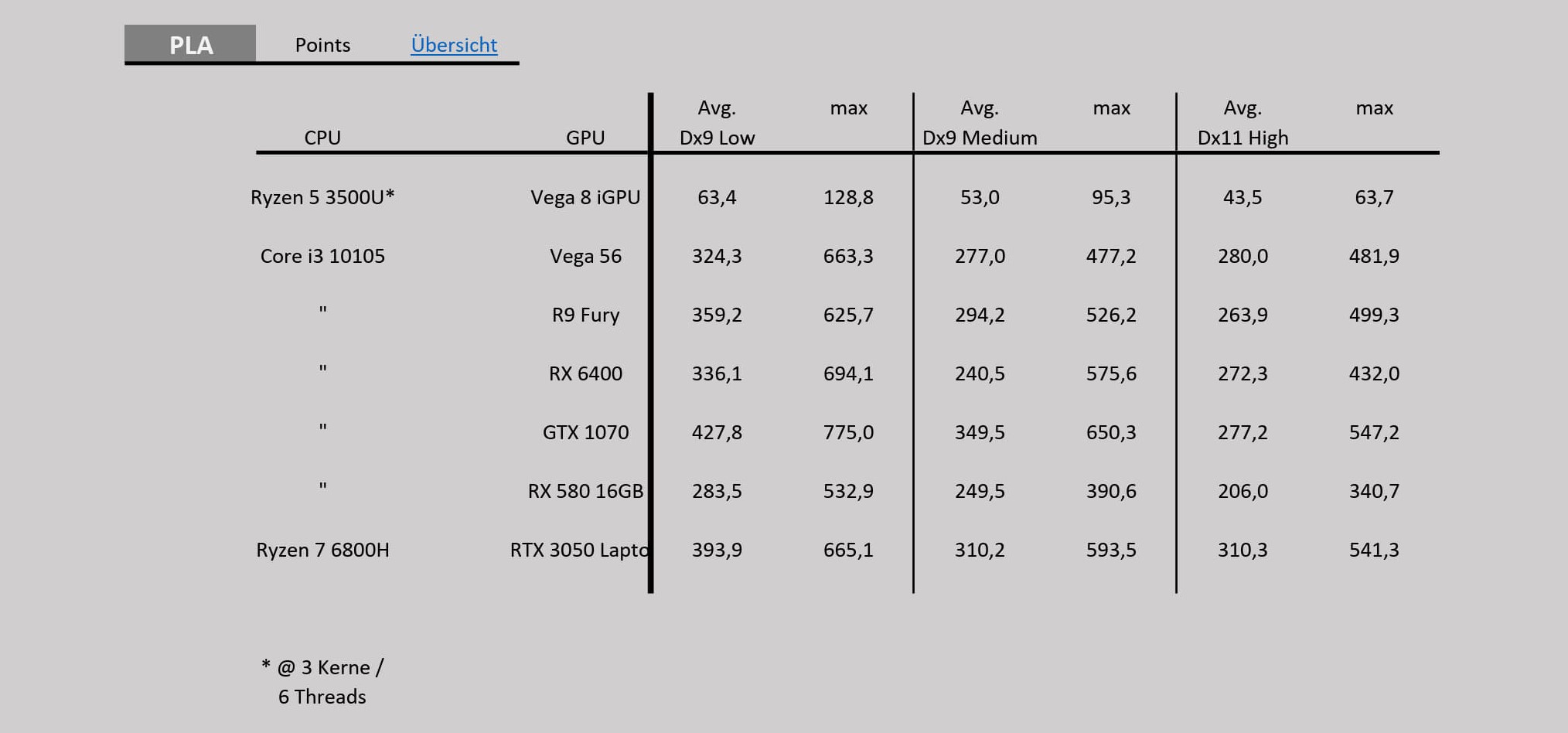

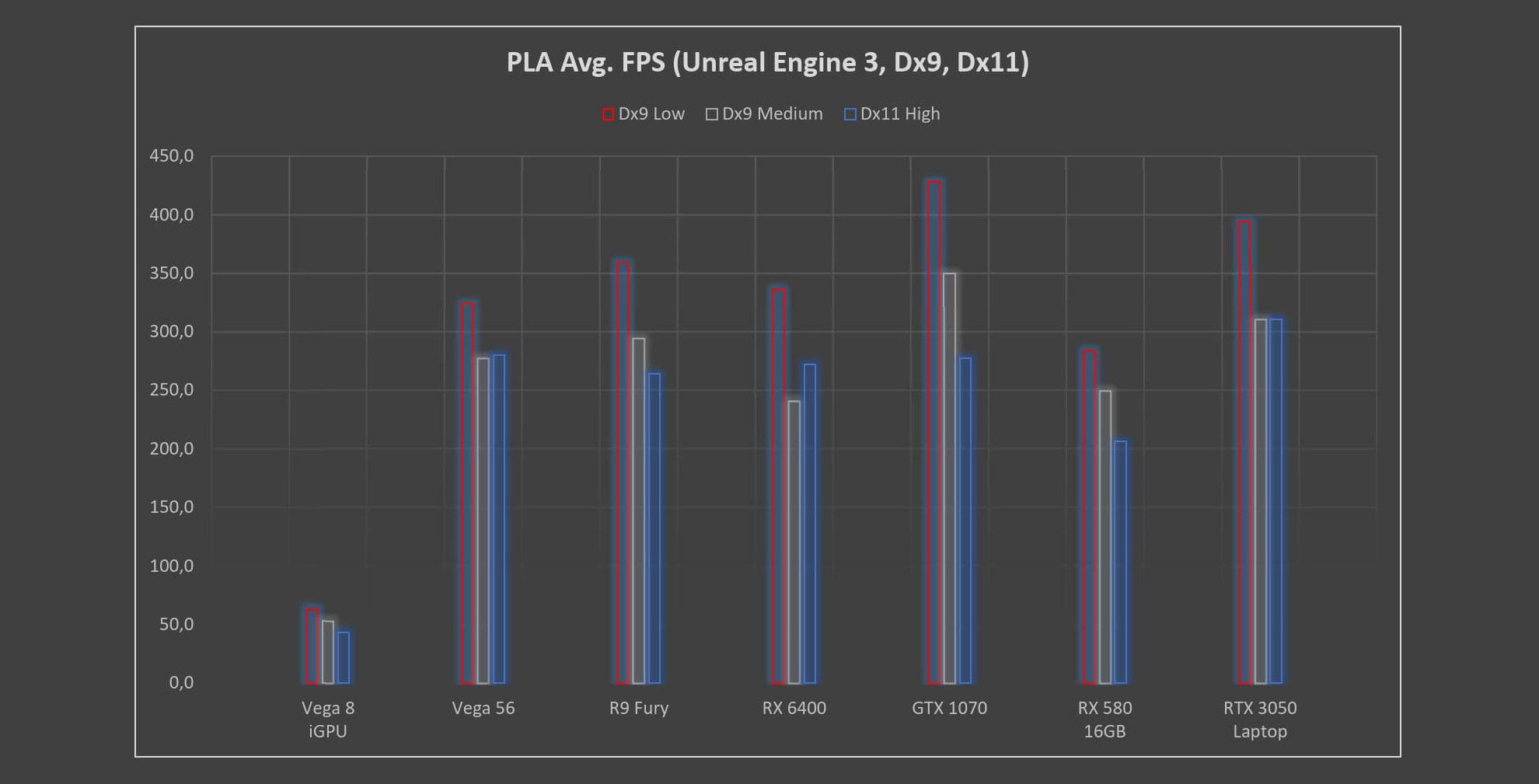

PLA Benchmark

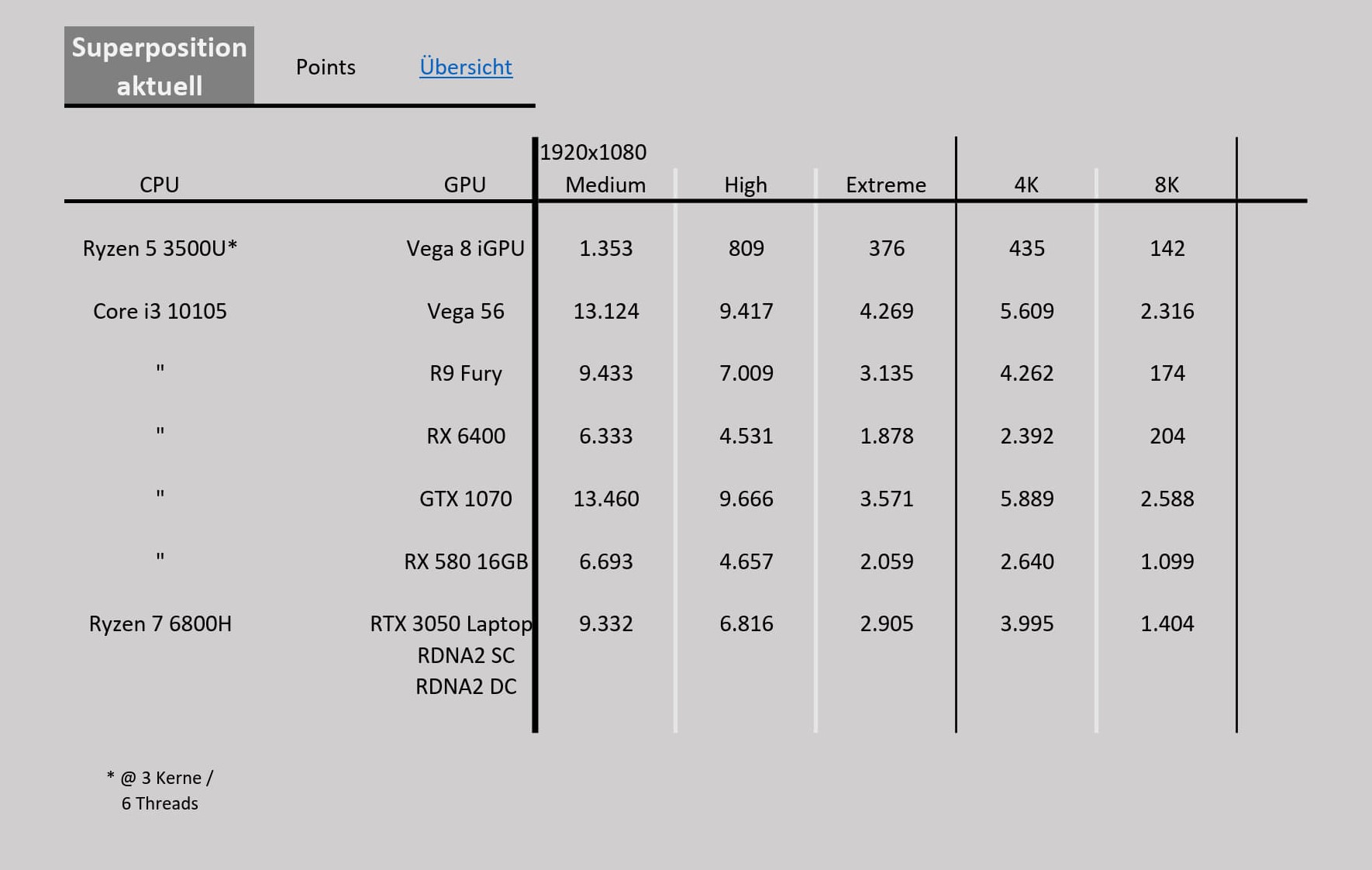

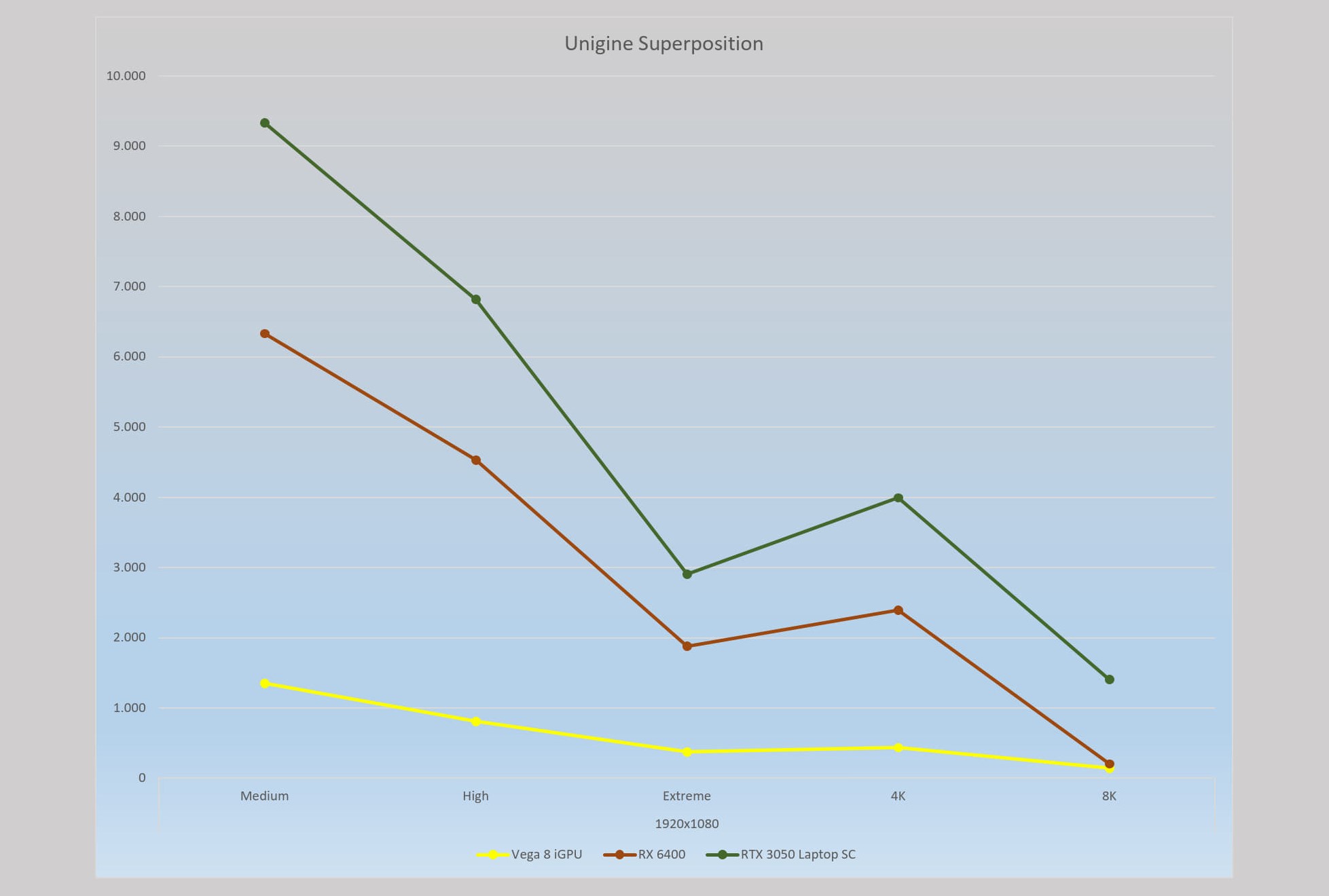

Superposition

Die kleine RTX 3050m schlägt sich doch ganz wacker, gegen die Konkurrenz, wenn man bedenkt, das es sich um eine reine Notebook GPU mit nur 4 GB RAM handelt.

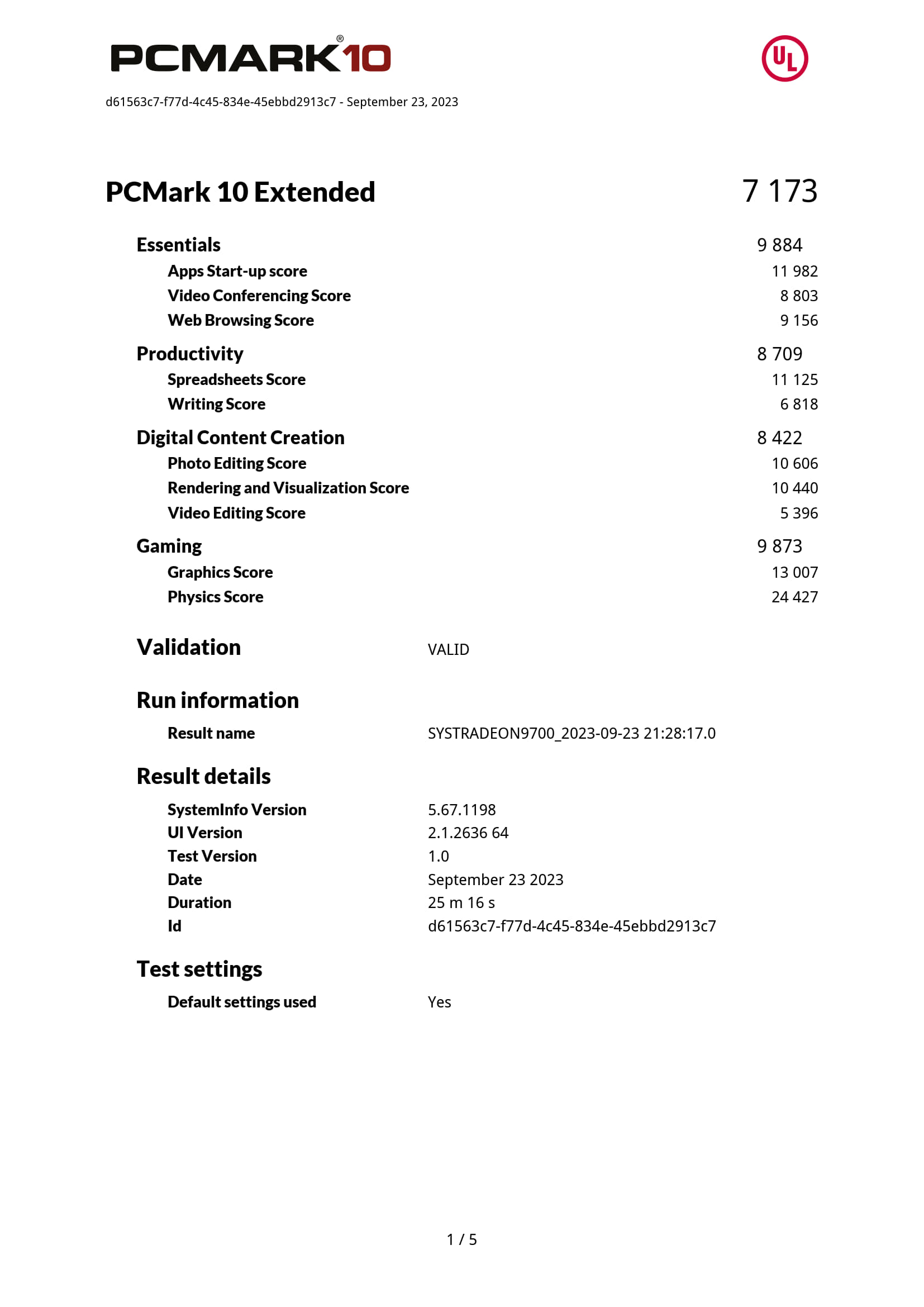

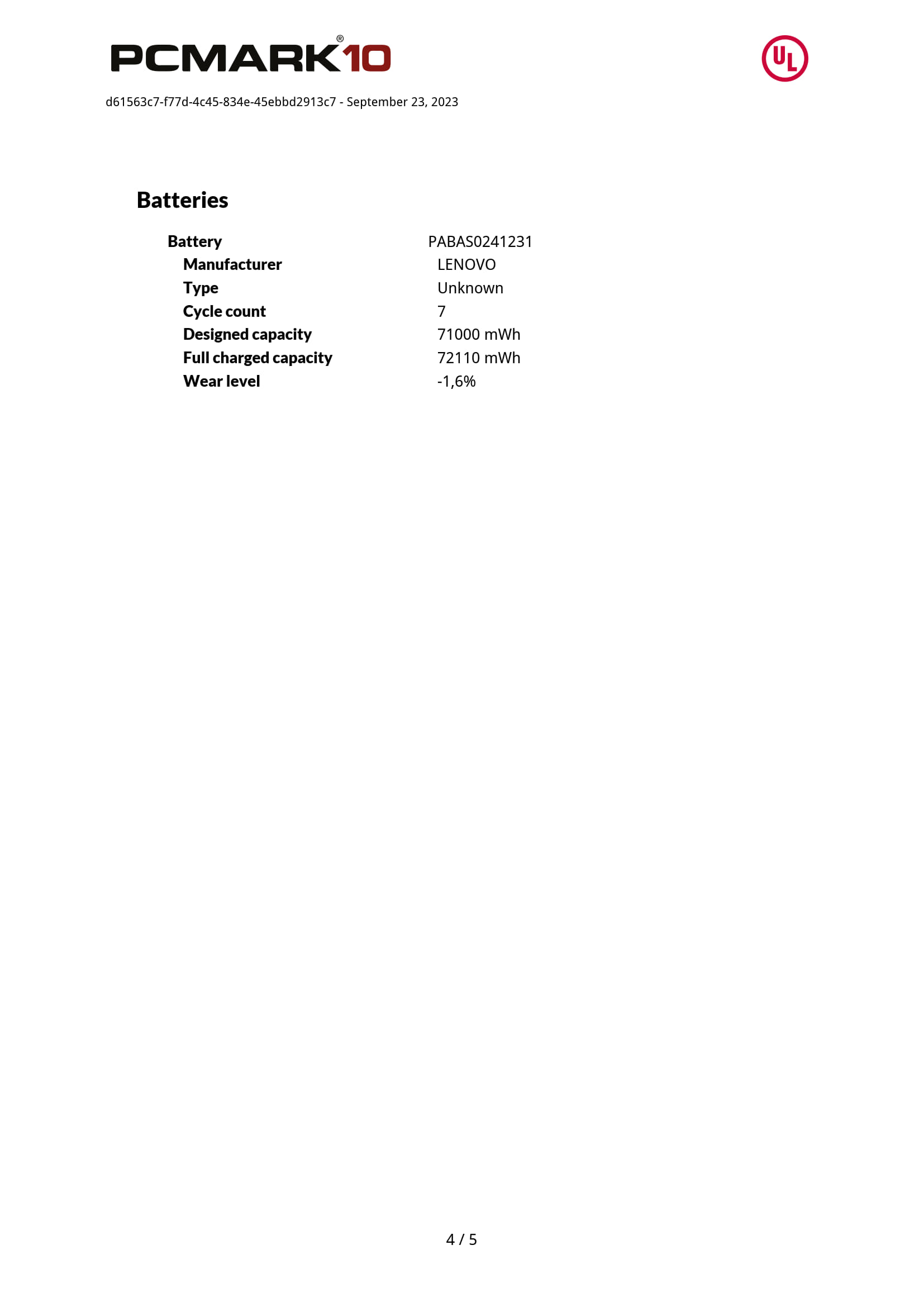

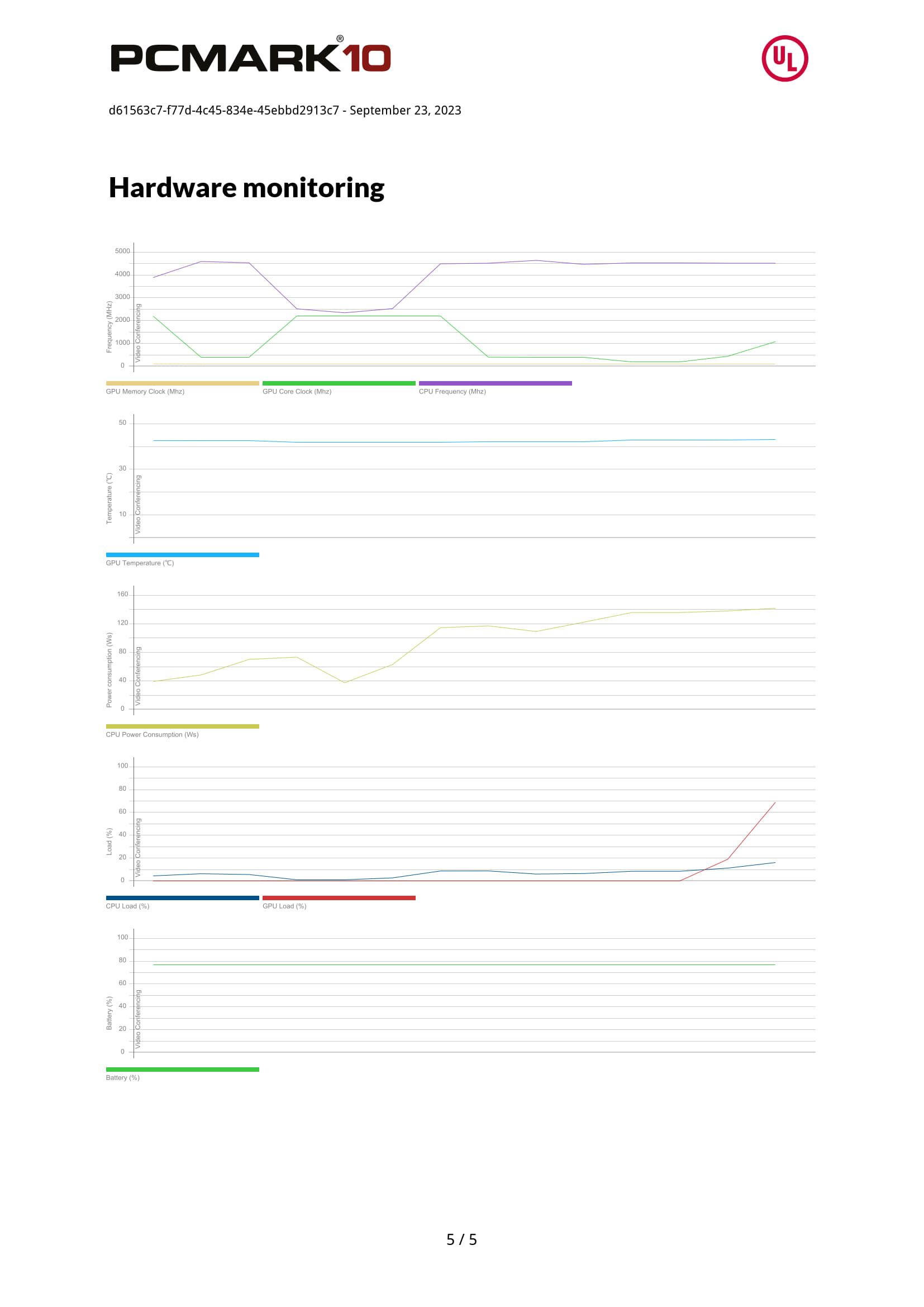

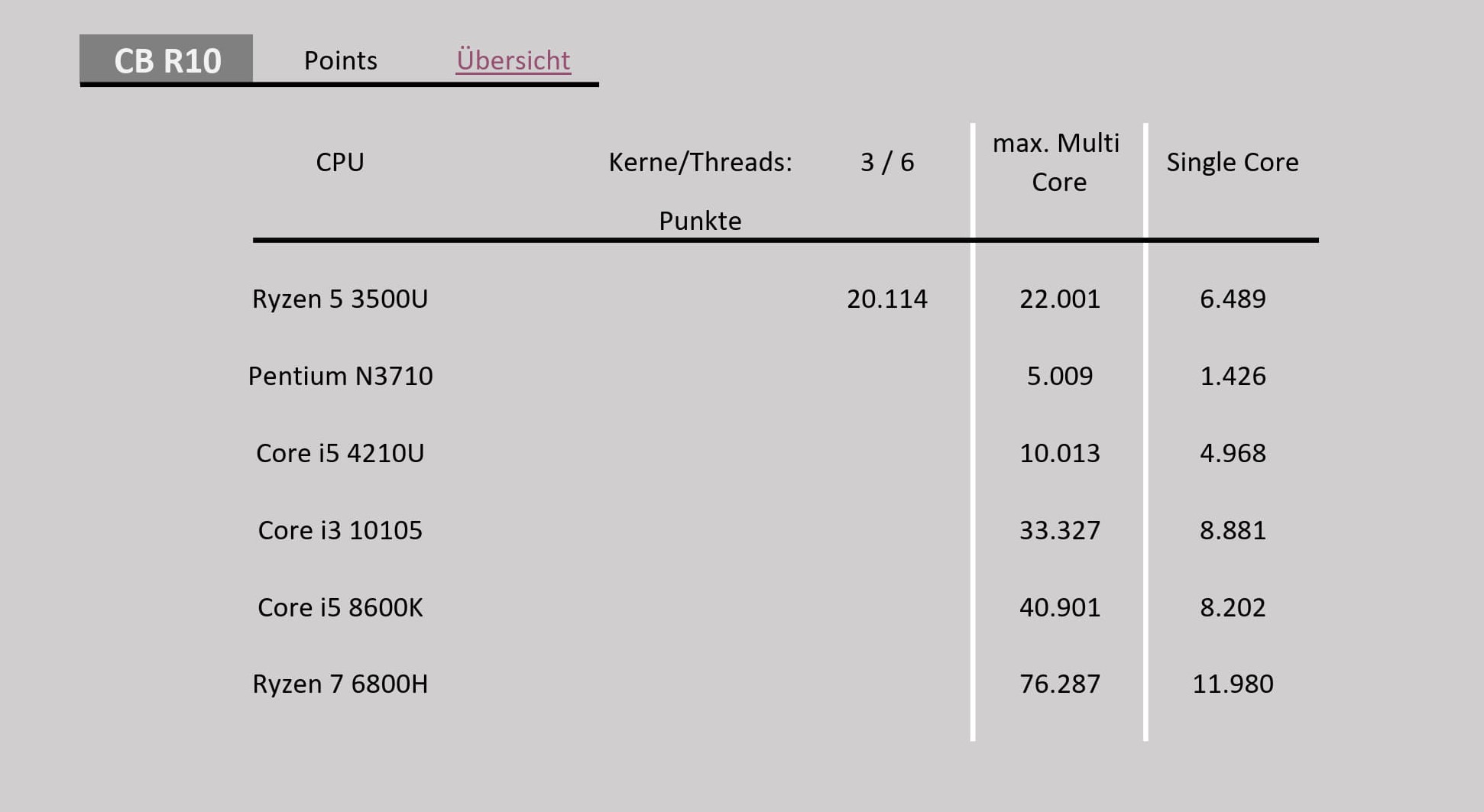

Getestet habe ich im Cinebench R10, R23 und 2024, sowie dem UL PCMark (siehe oberhalb).

Cinebench 2024

*nur 16 GB RAM im Single Channel

Weitere Cinebench Ergebnisse: Computerbase

Cinebench R23

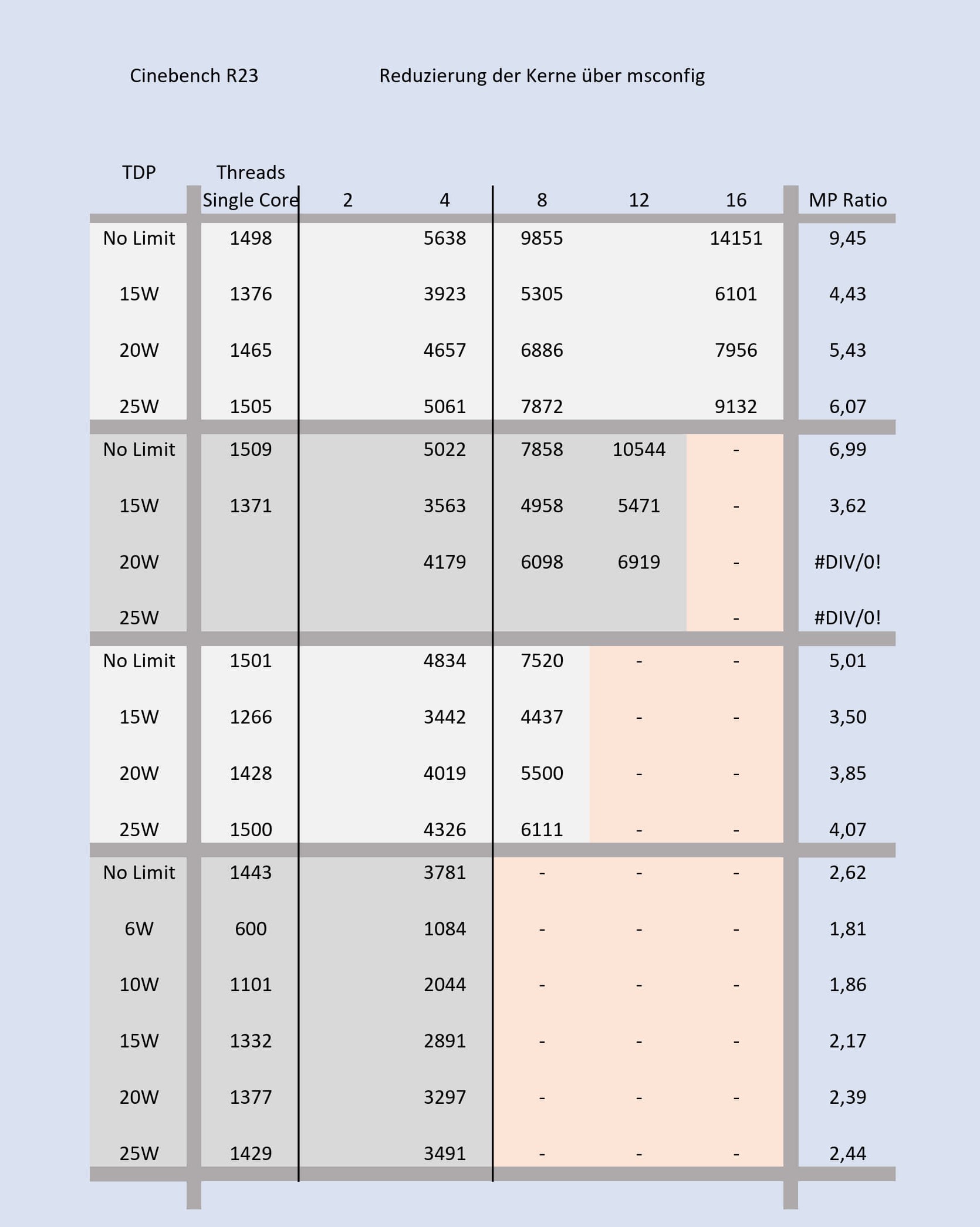

Im R23 habe ich zusätzlich Kerne nach und nach deaktiviert, um zu schauen, wie sich das Power Budget auswirkt. Also können z.B. vier Kerne einenhöheren Takt ausfahren, wenn die restlichen vier Kerne über msconfig deaktiviert sind.

Hier hat sich gezeigt, das es absolut Kontraproduktiv ist, was die reine CPU Leistung betrifft.

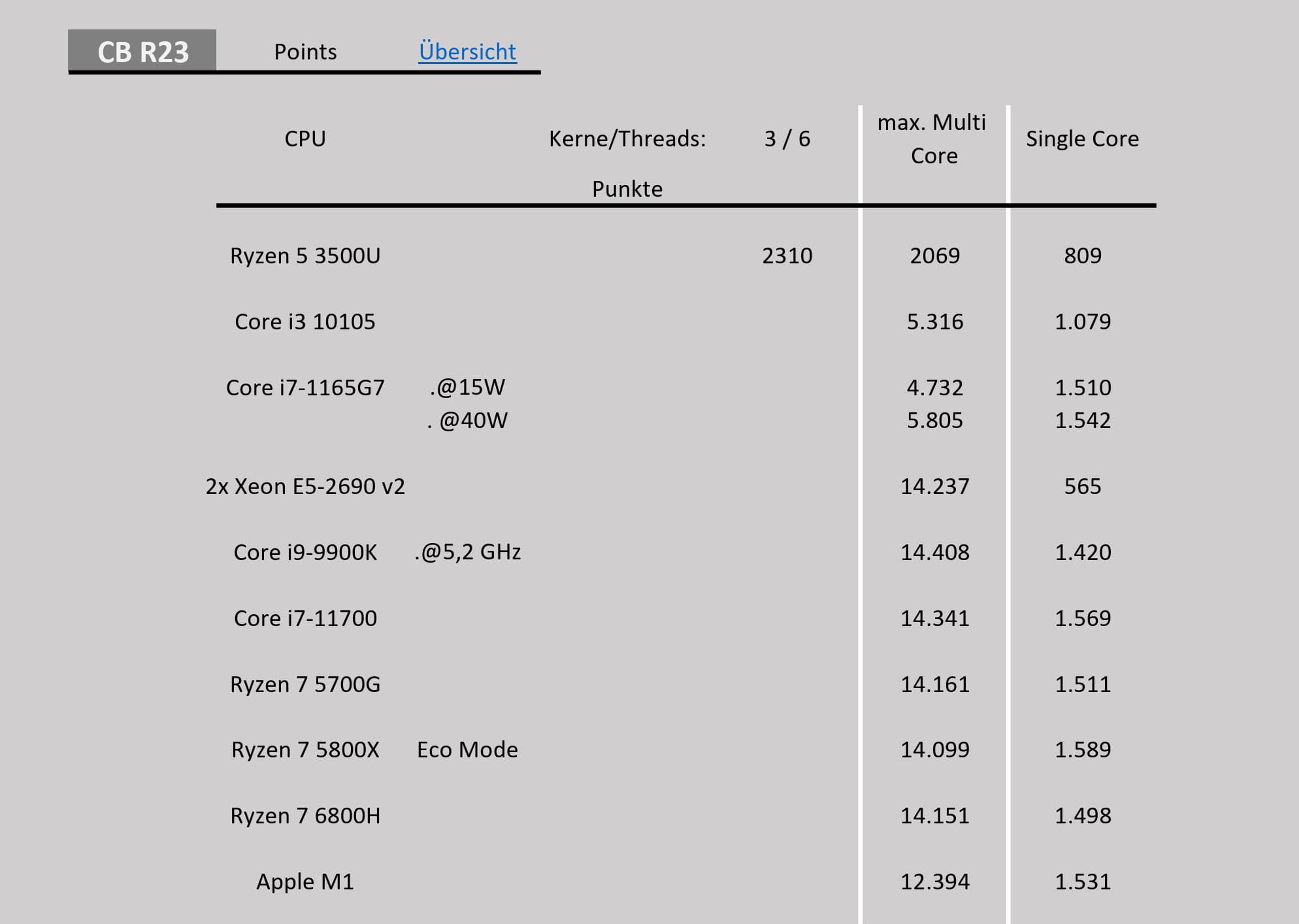

Mit seinen 14.151 Punkten im Multi-Core liegt die CPU gleichauf mit dem älteren Ryzen 7 5700G, dem 7 5800X im Eco Modus und in Schlagdistanz zu einem Core i7-11700. Auch ein Core i9-9900K mit 5,2 GHz ist nicht all zu weit entfernt.

Diesen fünf CPUs ist gemein, das alle über acht Kerne und sechzehn Threads verfügen.

Ein CB User hat noch zwei Xeon E5-2690 v2 getestet, dies ist eine alte Ivy Bridge CPU im 22nm Verfahren und zehn Kernen mit HT. Diese alte Architektur ist kaum schneller, als der hier getestete Ryzen 7 6800H, trotz zwanzig Kernen.

Im Single Core liegt man in der Nähe des Ryzen 7 5800X und des Apple M1 (notebookcheck).

Der Core i9-9900K wiederum liegt 100 Punkte zurück. Ganz gut schlägt sich hier die Notebook CPU Core i7-1165G7 @15W, welche aber nur über vier Kerne verfügt.

Mein Core i3-10105 (4Kerne/8Threads) hat im Cinebench R23 5.343 und 1.140 Punkte. Der Pentium N3710 (6W CPU, 4Kerne) hat 632 sowie 192 Punkte.

Mein Ryzen 5 3500U (notebookcheck) erreicht dagegen 2.069 und 801 Punkte. Was ich mit der Kern Deaktvierung erreichen wollte, zeigt sich bei dieser CPU sehr deutlich: 2.310 Punkte im Multi-Core mit drei Kernen und sches Threads liegt doch deutlich über der Leistung bei vollen vier Kernen.

Weitere Ergebnisse zum Cinebench R23: Computerbase Test

Cinebench R10

Der i5-4210U ist eine Dual-Core Notebook CPU

Update 26.02.2024: ich dachte erst, das eine Kunststoffnase beim Zusammenbau abgebrochen war, leider ist dies nicht der Fall gewesen, sondern eine lose Schraube hatte zu Bluescreens oder schwarzen Bildschirm geführt. Na hoffentlich sind keine Schäden entstanden.

Vor allem die Energiesparmaßnahmen sind grottig umgesetzt. So verhindern Programme sehr schnell, dass das Gerät in den Energiesparmodus gelegt wird, hier funktioniert teilweise weder die automatische Abschaltung nach x-Minuten noch das manuelle Eingreifen.

Auch der Ruhezustand ist ein zweischneidiges Schwert, denn sobald der aktiviert wurde und das Gerät runterfährt, darf man das Stromkabel nicht entfernen. Denn dies führt zu einem Restart des Laptops. Warum nur, Lenovo? Denn so hat das Gerät schon mal fröhlich vor sich hin geidlet, während es im Rucksack steckte. Und ja, es lässt sich im UEFI (BIOS) deaktivieren, aber welcher normale User, außerhalb unserer Bubble stellt das um?

Auch ist der zweite NVMe Steckplatz sinnvoll, aber auf Kontaktseite sitzt die SSD lose, so dass Windows die erst nach einem öffnen des Gerätes und unterlegen von Papier wieder erkannt hat.

Positiv ist dagegen die Laufzeit des 71 Wh Akkus. Denn selbst bei voller Beleuchtung hält dieser gut durch. Ja, eine genaue Angabe fehlt zum Zeitpunkt des Schreibens noch.

Das Fazit fällt trotz der Kritikpunkte positiv aus. Gerade aus P/L Sicht stechen das einzelne 16 GB DDR5 Modul hervor, so wie der Bildschirm. Beides ist keine Selbstverständlichkeit und ersteres erleichtert das Aufrüsten, da man den vorhandenen RAM nicht „wegschmeißt“, sondern erweitert. Und dank 4.800 MHz stehen der CPU trotzdem 38 GB/s an Bandbreite im Single Channel Betrieb zu.

Da für gewöhnlich die GeForce am Werkeln ist, stört die Bandbreitenlimitierung auch nicht so stark, wie gegenüber einer Single Chip Lösung. Bisher ist mir nur Wolfenstein: The New Order bekannt, dass immer die Radeon nutzt, was bei dem Alter des Spiels aber kein Beinbruch ist. Das hat selbst die Vega 8 gut gestemmt.

Zu der Eingangsfrage, ob die acht Kerne sinnvoll sind, kann ich nur eines sagen: ja. So gut Windows doch manchmal läuft, schiebe ich einen Großteil davon auf die wesentlich höhere Leistung pro Kern, also den IPC (Instruction per Cycle) Gewinn gegenüber der Zen 1 Architektur. Ich wäre mit sechs Kernen auch ans Ziel gekommen, teilweise gar mit vier. Wesentlich wichtiger ist dabei die neu gewonnen Grafikleistung in Form der GeForce RTX 3050m.

Bezahlt habe ich für Laptop und den zweiten 16 GB RAM Riegel 800€, was im Angesicht des hellen und farbtreuen Bildschirms, der starken CPU und der Verwendung von DDR5 als Arbeitsspeicher durchaus ein guter Preis ist. Die Konkurrenz hat, rein vom Datenblatt her, teilweise wesentlich weniger geliefert.

Was ich mir wünsche

Dass was sich auch viele andere wünschen: einen Infinity Cache für die Radeon. Ob 16 MB, oder gar nur 8 MB wie bei der nie veröffentlichten RX 6300, wirklich einen Ausschlag geben? Kurioserweise liegt die Radeon 680M teilweise sogar vor der RX 6400. Ob dies mit besseren Treibern zu tun hat, kann ich erst nach Tests mit der RX 580 16GB sagen, da diese gerade im Desktop verbaut ist.

In reinen Office Maschinen, mit der Möglichkeit ab und zu ein aktuelleres Spiel zu spielen, hat durch die integrierte RDNA2 GPU jedenfalls wieder einen guten Schritt voran gebracht.

bereits verlinkt

Kommt gut in den Sonntag und viel Spaß beim lesen

Und was hat der Laptop sonst noch zu bieten?

Nach reiflicher Überlegung war es mal wieder Zeit für einen neueren Laptop. In immer mehr Spielen gerät der hp mit Ryzen 5 3500U immer mehr ins Hintertreffen. Da hilft es auch nicht, dass ich hauptsächlich ältere Spiele zocke, mit der die Vega 8 noch gut zu Rande kam.

Also habe ich schon mal langsam meine Fühler Richtung neuen Laptop ausgestreckt, immer mit der Tatsache im Hinterkopf, das Weihnachten vollkommen ausreicht.

Da wäre der Ryzen 5 drei Jahre alt, was bei meinem Einsatzszenario ein gutes Alter ist.

Es kam dann doch anders. Denn ich hatte ein Lenovo Gerät mit guten Spezifikationen zu einem guten Kurs gefunden. Also habe ich die Chance genutzt und das Gerät bestellt.

Inhaltsangabe

- Vorgeschichte

- Der Zufall half

- techn. Details

- Details

- Thema Sicherheit und Bitlocker Update 17.10.2023

- verwendete Benchmarks

- Benchmark Ergebnisse

- Kritikpunkte (Update 26.02.2024)

- Fazit

- weitere Tests

Zu meiner Vorgeschichte

Beim ersten, eigenen Laptop nach mehreren Jahren wurde es noch ein Pentium N3710, mit 17“, HDD und 4 Threads. (Ein Pentium N in 2021 – Sinnvoll oder nicht?) Nach einem Update von 4 auf 8 GB und einer Crucial SSD stand so langsam ein Update ins Haus, welches hp und der Media Markt prompt erfüllten.

Dank hellen 17“ Display war der Asus Laptop kein schlechter Begleiter, doch der neue Ryzen war natürlich ein gravierender Geschwindigkeitsboost.

An das nun kleinere Display mit 15“ musste ich mich gewöhnen, auch das es nicht gerade die hellste Kerze auf der Torte war.

Doch der Ryzen 5 3500U (Lesertest) hat für vieles entschuldigt. Dazu kam, das hp eine schnelle Samsung SSD mit 512 GB verbaute.

Nach zwei Aufrüstungen des RAMs arbeitet das Gerät jetzt mit 32 GB und ist auch dank der noch immer guten vier Kerne kein langsamer Begleiter.

Im Gegenteil, ein Kern wurde über Windows und die msconfig deaktiviert und gewann dadurch einen höheren TDP-Spielraum bei der Vega 8. Denn diese ist das Steckenpferd der Ryzen APU.

Nicht falsch verstehen, Vega ist wahnsinnig gut, im Vergleich zur Konkurrenz und wenn man das Alter im Hinterkopf behält.

Aber, sie braucht Bandbreite und eine Möglichkeit, ihren Takt auszufahren.

Ersteres lässt sich dank maximalen 2.400 MHz auf dem RAM nicht wirklich aufbessern, zweiteres schon, durch die Deaktivierung des vierten Kernes. Nur, selbst mit dem Ryzen Controller (Lesertest) waren GPU-Taktraten jenseits der 900 MHz eher die Ausnahme, als die Regel und bei erzwungenen 1,2 GHz kam es gar zu Abstürzen.

Die Nachfolger APU Ryzen 5 4500U vom User @Karre dreht dann dank des LPDDR4-4.133 Kreise um meine Vega. Der Fertigungsprozess von 7nm hat hier halt auch gewisse Vorteile.

Wie der Zufall so will

Durch Zufall habe ich an einem Samstag dann den besagten Lenovo Laptop bei Geizhals gefunden.

Das Gerät kommt mit einem 16“ Display in 16:10, 350 Candela und 100% sRGB-Abdeckung daher.

Sowie einem Ryzen 7 6800H, der GeForce RTX 3050m, 1x 16GB DDR5-4800 von Samsung und einer Micron SSD mit 512 GB und PCIe 4.0. Preislich lag dieses Angebot, inklusive zweiten 16 GB RAM Riegel, bei 800€.

Gegenüber dem hp Laptop wurde zwar die Kernanzahl, und damit auch die Threads wieder verdoppelt. Aber, in meinem Anwendungsbereich ist das der absolute Overkill.

Windows fühlt sich nicht viel schneller an und Gimp, was bei einigen Berechnungen von 16 Threads profitieren könnte, muss erst noch zeigen, ob das nicht zu viel des Guten ist.

Kommen wir nochmal zu den technischen Details

Es handelt sich um ein Lenovo IdeaPad Gaming 3 16ARH7.

Der Ryzen 7 6800H verfügt über 8 Zen 3+ Kerne, inklusive Hyperthreading.

Angesiedelt ist die APU in der 45W Klasse bei AMD.

Ferner ist die Radeon 680M auf Basis der RDNA2 Architektur mit 12 CUs integriert, was dem Vollausbau in dieser Ryzen Generation entspricht.

Als Arbeitsspeicher kommt ein einzelnes Samsung Modul mit 16GB und einer Geschwindigkeit von 4.800 MHz zum Einsatz.

Für einen direkten Test zwischen Vega 8 und 680M ist das optimal, da beide Geräte so über die gleiche Bandbreite von 38 GB/s verfügen.

Da auch noch ein zweiter, leerer Steckplatz vorhanden ist, erhält der Arbeitsspeicher nach den ersten Tests ein Upgrade auf 32 GB, wobei das zweite Modul von Crucial stammt.

So kann man dann die Radeon und die GeForce besser vergleichen.

Denn, neben der iGPU gibt es noch die kleine RTX 3050 mobile mit 4 GB und max. 65 W TDP.

Als Datengrab kommt eine Micron SSD mit 512 GB und PCIe 4.0 @4x Anbindung zum Einsatz, erweitert durch eine Intel 660p mit ebenfalls 512 GB, aber QLC-Technik. Beide nutzen einen SLC-Cache, verfügen aber über keinen DRAM für die Mappingtabelle (ähnlich einer Inhaltsangabe).

Als Display kommt ein IPS-Panel mit max. 350 cd/m² (laut Hersteller), 16“ im 16:10 Format und einer Auflösung von 1920x1200 Pixeln. Während der unten aufgeführte Ryzen 5 ein 15,6“ Display mit Full HD nutzt, trumpft das neue Panel in der Höhe auf, denn da finden sich 20 mm zusätzlich ein.

Techn. Daten

| CPU | Ryzen 5 3500U | Ryzen 7 6800H | Core i3 10105 |

| Technologie | Zen+ (Picasso) | Zen3+ (Rembrandt) | Comet Lake |

| Kerne (Threads) | 4 (8) | 8 (16) | 4 (8) |

| Takt (Turbo) | 2,1 GHz (3,7 GHz) | 3,2 GHz (4,7 GHz) | 3,7 GHz (4,4 GHz) |

| L1 Cache | 384 KB (96 KB pro Kern) | 512 KB (64 KB pro Kern) | 256 KB (64 KB pro Kern) |

| L2 | 2 MB | 4 MB | 1 MB |

| L3 | 4 MB | 16 MB | 6 MB |

| Fertigung | 12 nm (verbesserte 14 nm) | 6 nm | 14 nm++ |

| TDP | 15 W | 45 W | 65 W |

| iGPU | Vega 8 | Radeon 680M | UHD-630 |

| Kerne | 8 CU | 12 CU | 24 EUs |

| Technologie | Vega | RDNA 2 | GT2 |

| Shader | 512 | 768 | 192 |

| Takt | Max. 1,2 GHz | Max. 2,2 GHz | Max. 1,1 GHz |

| DIE Größe | 210 mm² | 210 mm² | 126 mm² |

| Milliarden Transistoren | 4,94 | 13,1 (laut GPU-Z) | |

| Speicher | 32 GB | 32 GB | 24 GB (2x8 & 2x4) |

| Technologie | DDR4 | DDR5 | DDR4 |

| Takt | 2.400 MHz | 4.800 MHz | @2.133 MHz (bis 2.666 MHz) |

| Bandbreite Dual Channel | 38,5 GB/s | 77 GB/s | 34 GB/s (41,6 GB/s) |

| GPU | - | RTX 3050m | Radeon RX 6400 |

| Technologie | Ampere (GA107) | RDNA 2 (Navi 24) | |

| Fertigung | 8 nm | 6 nm | |

| TDP | 45 W | 53 W | |

| Kerne | 12 | ||

| Shader | 2048 | 768 | |

| GPU-Takt | Max. 1,3 GHz | Max. 2,3 GHz | |

| Speicher | 4 GB | 4 GB | |

| Speicher-Takt | 1.500 MHz | 2.000 MHz | |

| Speicherinterface | 128 Bit | 64 Bit | |

| Bandbreite | 192 GB/s | 128 GB/s* | |

| Milliarden Transistoren | 8,7 | 5,4 | |

| DIE Größe | 200 mm² | 107 mm² | |

| TDPs kombiniert (CPU+GPU) | 15 W | 90 W | 108 W |

Details

Rein von den Daten her, ist der Sprung also nicht gerade klein, auch wenn man in alltäglichen Aufgaben nicht viel davon mitbekommt.

Was aber sofort positiv ins Auge fällt, okay, eher ins Gehör ist die angenehmere Geräuschkulisse. Selbst wenn Prime95, Furmark (GeForce) und der 3DMark (iGPU) laufen, wird das System zwar lauter, driftet aber nicht ins hochfrequente ab, wie es noch beim hp Laptop ist.

Auch ist das verbaute IPS eine Augenweide, gegenüber dem alten TN-Panel und es schlägt sich im Vergleich mit einem Super-AMOLED von Samsung auch ganz gut. Letzteres deckt zum sRGB-Farbraum noch den Adobe-RGB-Farbraum komplett ab. Bei der manuellen Helligkeit liegen Lenovo und Samsung gleich auf, mit einem kleinen Vorteil für das Tablet.

Die wesentlich höhere Auflösung des Tablets dagegen vermisse ich persönlich nicht.

Hinweis: durch den Moiré Effekt ist eventuell das Raster der Displays leichter zu erkennen

Bei unterschiedlicher Kamerabelichtung

Die Tastatur ist die bei uns übliche QWERTZ-Ausführung mit zusätzlichen Ziffernblock und abgesetzten Pfeiltasten. Eine rein bläuliche LED-Beleuchtung lässt sich in zwei Stufen regeln.

Dazu kommt ein angenehmer Druckpunkt und auch akustisch macht diese einen guten Eindruck.

Unterhalb dieser ist ein großes, abschaltbares Touchpad, welches sich angenehm nutzen lässt. Das hp Touchpad fühlt sich beim Gleiten über dieses aber etwas angenehmer an, was aber reine Geschmacks- und Gewohnheitssache ist.

Kommen wir zu den Anschlüssen, diese befinden sich ungünstiger weise hauptsächlich auf der Rückseite. Da wäre der Stromanschluss, ein USB-C, ein RJ-45 für LAN-Kabel sowie ein HDMI-Anschluss. Links und rechts ist jeweils nur ein einzelner USB-A Port verbaut. Einen (Micro)SD-Karten-Leser hat sich Lenovo gespart, ärgerlich, sofern ich nicht die langsame USB 2.0 Geschwindigkeit der Kamera nutzen möchte.

HDMI -> LAN -> USB-C -> Power Anschluss

Der Powerknopf ist in der Mitte positioniert, genau zwischen Display und Tastatur. Die LED für das Netzteilkabel dagegen befindet sich hinter dem Display. Eine LED, jeweils Rot und Weiß gibt den Betriebspunkt an: laden/Ladung halten oder geladen.

Da Lenovo eine Schonung des Akkus zulässt, kann die Ladung bei 80% gehalten werden. Um diesen wieder schneller zu befüllen, existiert noch die Funktion Express-Laden.

Die beiden Lüfter sind unter Last, wie bereits erwähnt immer noch ganz angenehm. Und, über die Tastenkombination FN + Q lassen sich drei verschiedene Einstellungen wählen, Flüster-, Auto- und max. Betrieb. Letzterer lässt diese aber nicht dauerhaft mit hohen Drehzahlen arbeiten, sondern setzt auch hier wesentlich tiefer an. Das hat aber den Vorteil, dass die beiden Quirle nicht immer wieder aufdrehen, um gleich darauf abzuschalten (bei hp wäre das z.B. die UEFI-Einstellung „Fan Always on“). Je nach Betriebsart leuchtet der Powerknopf Blau, Weiß oder Rot.

Sicherheit

Zum Thema Sicherheit muss man hier hervorheben, dass die Micron SSD bereits verschlüsselt ist. Wobei ich mich wieder frage, wo zum Henker der Sicherheitsschlüssel hinterlegt ist, in OneDrive sollte es nicht sein.

Naja, beim zweiten Versuch, den Windows Offline Defender zu nutzen lief dieser auch durch, ohne die Bitlocker Schlüssel zu verlangen.

Hinweis: mittlerweile bietet Windows 11 Home eine automatische Bitlocker Verschlüsselung an, dafür ist die Pro Version nicht mehr nötig. Nur kann man in der Home Variante diese nicht ohne weiteres abschalten und beim Einbau einer bereits verschlüsselten SSD/HDD wird diese nicht automatisch entsperrt. Dies geschieht nur bei einer Neuinstallation, nach der alle Laufwerke automatisch freigegeben werden.

Benchmarks

Die verwendete Software stützt sich teils auf synthetische und teils auf echte Games oder Anwendungen. Aufgrund von Zeitmangel fällt der Umfang etwas geringer aus.

In den Diagrammen sind teilweise nur die Hauptkonkurrenten RX 6400 und RTX 3050m aufgeführt.

- Blender 3.6.0

- 3DMark von UL (Dx 11 u. 12, Raytracing)

- Car Mechanics Simulator

- Neon Noir, Raytracing von Crytek

- Final Fantasy XV

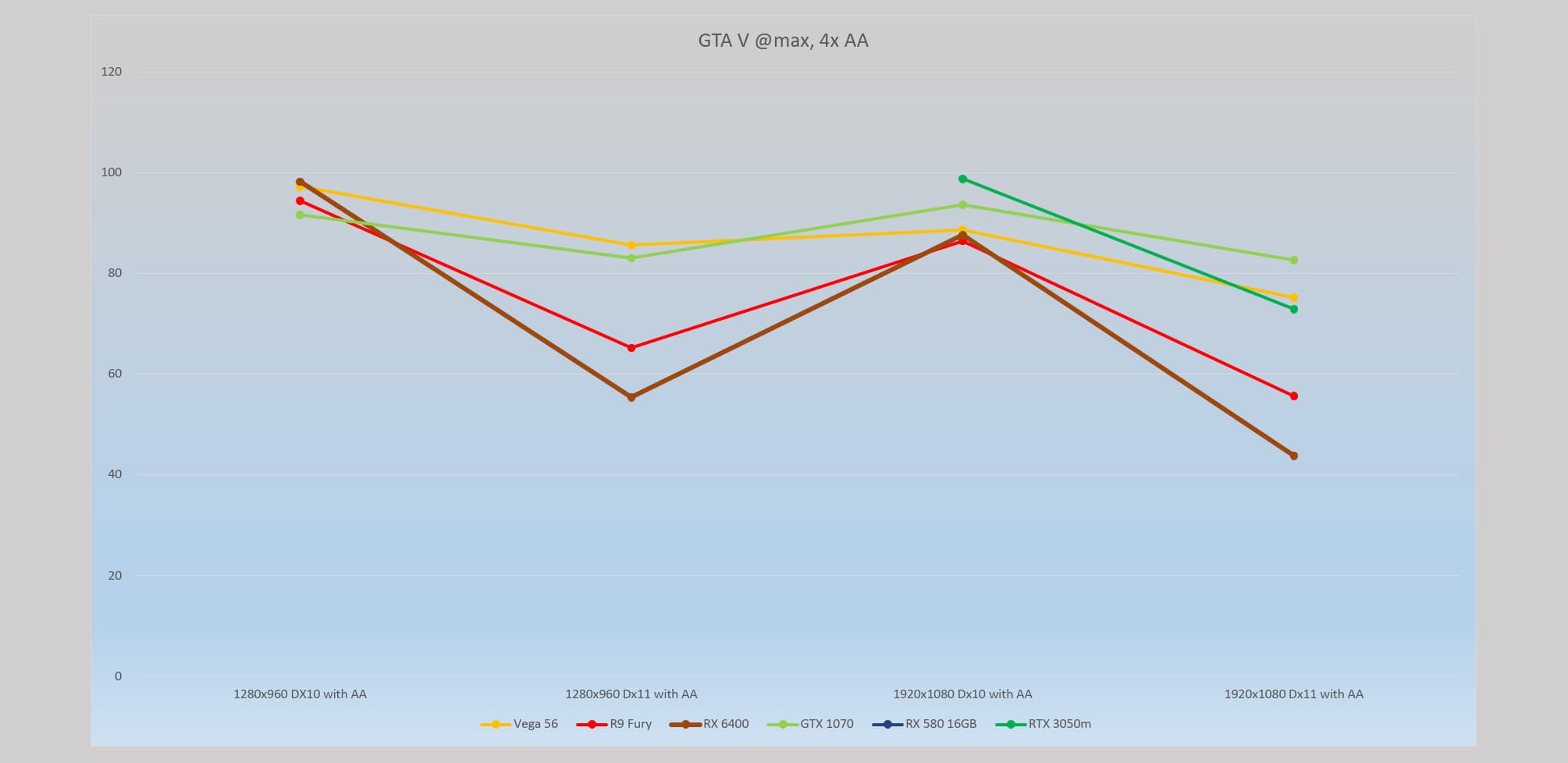

- GTA V (Dx 10 u. 11)

- PLA, ein chinesischer Benchmark auf Basis der Unreal Engine 3 (Dx9 u. 11)

- Superposition von Unigine

- PCMark von UL

- Cinebench R10 und R23

Theoretische Rechenleistung

| GPU | Vega 8 | Radeon 680M | RTX 3050m | UHD-630* | Radeon RX 6400 |

| Pixel pro s | 8,8 GPixel/s | 70,4 GPixel/s | 42,9 GPixel/s | Ca. 3,6 GPixel/s | 74,3 GPixel/s |

| Texel pro s | 35,2 GTexel/s | 105,6 GTexel/s | 85,9 GTexel/s | Ca. 28,8 GTexel/s | 111,4 GTexel/s |

| FP 16 | 2,25 TFLOPS | 6,76 TFLOPS | 5,5 TFLOPS | Ca. 921,6 GFLOPS | 7,13 TFLOPS |

| FP 32 | 1,13 TFLOPS | 3,38 TFLOPS | 5,5 TFLOPS | Ca. 460,8 GFLOPS | 3,56 TFLOPS |

| FP 64 | 70,4 GFLOPS | 211,2 GFLOPS | 85,95 GFLOPS | Ca. 115,2 GFLOPS | 222,8 GFLOPS |

Blender Benchmark

| System | Benchmark | Monster | Junkshop | Classroom | kombiniert |

| Ryzen 7 6800H | | 87,6 | 58,3 | 42,9 | 62,93 |

| Radeon 680M | | 137,0 | 66,9 | 60,9 | 88,27 |

| RTX 3050m | 709,4 | 384,9 | 373,2 | 489,17 | |

| Core i3-10105 | 38,2 | 24,3 | 18,5 | 27 |

3DMark

RX 6400 nicht aufgeführt

RDNA2 im Vergleich

Kurioserweise ist die iGPU Radeon 680M teilweise schneller, als die RX 6400. Denn die 680M verfügt nur über 77 GB/s Bandbreite, die noch mit der CPU geteilt wird, während die RX 6400 über 128 GB/s verfügt, inklusive dem 16 MB großen Infinity Cache.

Sobald der Test der RX 580 16GB abgeschlossen ist, werde ich die 6400 noch einmal durch den Test Parcours jagen.

Car Mechanic Simulator

Crytek Neon Noir

Final Fantasy XV

GTA V

PLA Benchmark

Superposition

PCMark

Die kleine RTX 3050m schlägt sich doch ganz wacker, gegen die Konkurrenz, wenn man bedenkt, das es sich um eine reine Notebook GPU mit nur 4 GB RAM handelt.

CPU Tests

Getestet habe ich im Cinebench R10, R23 und 2024, sowie dem UL PCMark (siehe oberhalb).

Cinebench 2024

| CPU | Multi Core | Single Core |

| Ryzen 5 3500U | 168 | 53 |

| Core i3-1015 | 287 | 65 |

| Ryzen 7 6800H* | 684 | 88 |

Weitere Cinebench Ergebnisse: Computerbase

Cinebench R23

Im R23 habe ich zusätzlich Kerne nach und nach deaktiviert, um zu schauen, wie sich das Power Budget auswirkt. Also können z.B. vier Kerne einenhöheren Takt ausfahren, wenn die restlichen vier Kerne über msconfig deaktiviert sind.

Hier hat sich gezeigt, das es absolut Kontraproduktiv ist, was die reine CPU Leistung betrifft.

Mit seinen 14.151 Punkten im Multi-Core liegt die CPU gleichauf mit dem älteren Ryzen 7 5700G, dem 7 5800X im Eco Modus und in Schlagdistanz zu einem Core i7-11700. Auch ein Core i9-9900K mit 5,2 GHz ist nicht all zu weit entfernt.

Diesen fünf CPUs ist gemein, das alle über acht Kerne und sechzehn Threads verfügen.

Ein CB User hat noch zwei Xeon E5-2690 v2 getestet, dies ist eine alte Ivy Bridge CPU im 22nm Verfahren und zehn Kernen mit HT. Diese alte Architektur ist kaum schneller, als der hier getestete Ryzen 7 6800H, trotz zwanzig Kernen.

Im Single Core liegt man in der Nähe des Ryzen 7 5800X und des Apple M1 (notebookcheck).

Der Core i9-9900K wiederum liegt 100 Punkte zurück. Ganz gut schlägt sich hier die Notebook CPU Core i7-1165G7 @15W, welche aber nur über vier Kerne verfügt.

Mein Core i3-10105 (4Kerne/8Threads) hat im Cinebench R23 5.343 und 1.140 Punkte. Der Pentium N3710 (6W CPU, 4Kerne) hat 632 sowie 192 Punkte.

Mein Ryzen 5 3500U (notebookcheck) erreicht dagegen 2.069 und 801 Punkte. Was ich mit der Kern Deaktvierung erreichen wollte, zeigt sich bei dieser CPU sehr deutlich: 2.310 Punkte im Multi-Core mit drei Kernen und sches Threads liegt doch deutlich über der Leistung bei vollen vier Kernen.

Weitere Ergebnisse zum Cinebench R23: Computerbase Test

Cinebench R10

Der i5-4210U ist eine Dual-Core Notebook CPU

Kritikpunkte

Update 26.02.2024: ich dachte erst, das eine Kunststoffnase beim Zusammenbau abgebrochen war, leider ist dies nicht der Fall gewesen, sondern eine lose Schraube hatte zu Bluescreens oder schwarzen Bildschirm geführt. Na hoffentlich sind keine Schäden entstanden.

Vor allem die Energiesparmaßnahmen sind grottig umgesetzt. So verhindern Programme sehr schnell, dass das Gerät in den Energiesparmodus gelegt wird, hier funktioniert teilweise weder die automatische Abschaltung nach x-Minuten noch das manuelle Eingreifen.

Auch der Ruhezustand ist ein zweischneidiges Schwert, denn sobald der aktiviert wurde und das Gerät runterfährt, darf man das Stromkabel nicht entfernen. Denn dies führt zu einem Restart des Laptops. Warum nur, Lenovo? Denn so hat das Gerät schon mal fröhlich vor sich hin geidlet, während es im Rucksack steckte. Und ja, es lässt sich im UEFI (BIOS) deaktivieren, aber welcher normale User, außerhalb unserer Bubble stellt das um?

Auch ist der zweite NVMe Steckplatz sinnvoll, aber auf Kontaktseite sitzt die SSD lose, so dass Windows die erst nach einem öffnen des Gerätes und unterlegen von Papier wieder erkannt hat.

Positiv ist dagegen die Laufzeit des 71 Wh Akkus. Denn selbst bei voller Beleuchtung hält dieser gut durch. Ja, eine genaue Angabe fehlt zum Zeitpunkt des Schreibens noch.

Fazit

Das Fazit fällt trotz der Kritikpunkte positiv aus. Gerade aus P/L Sicht stechen das einzelne 16 GB DDR5 Modul hervor, so wie der Bildschirm. Beides ist keine Selbstverständlichkeit und ersteres erleichtert das Aufrüsten, da man den vorhandenen RAM nicht „wegschmeißt“, sondern erweitert. Und dank 4.800 MHz stehen der CPU trotzdem 38 GB/s an Bandbreite im Single Channel Betrieb zu.

Da für gewöhnlich die GeForce am Werkeln ist, stört die Bandbreitenlimitierung auch nicht so stark, wie gegenüber einer Single Chip Lösung. Bisher ist mir nur Wolfenstein: The New Order bekannt, dass immer die Radeon nutzt, was bei dem Alter des Spiels aber kein Beinbruch ist. Das hat selbst die Vega 8 gut gestemmt.

Zu der Eingangsfrage, ob die acht Kerne sinnvoll sind, kann ich nur eines sagen: ja. So gut Windows doch manchmal läuft, schiebe ich einen Großteil davon auf die wesentlich höhere Leistung pro Kern, also den IPC (Instruction per Cycle) Gewinn gegenüber der Zen 1 Architektur. Ich wäre mit sechs Kernen auch ans Ziel gekommen, teilweise gar mit vier. Wesentlich wichtiger ist dabei die neu gewonnen Grafikleistung in Form der GeForce RTX 3050m.

Bezahlt habe ich für Laptop und den zweiten 16 GB RAM Riegel 800€, was im Angesicht des hellen und farbtreuen Bildschirms, der starken CPU und der Verwendung von DDR5 als Arbeitsspeicher durchaus ein guter Preis ist. Die Konkurrenz hat, rein vom Datenblatt her, teilweise wesentlich weniger geliefert.

Was ich mir wünsche

Dass was sich auch viele andere wünschen: einen Infinity Cache für die Radeon. Ob 16 MB, oder gar nur 8 MB wie bei der nie veröffentlichten RX 6300, wirklich einen Ausschlag geben? Kurioserweise liegt die Radeon 680M teilweise sogar vor der RX 6400. Ob dies mit besseren Treibern zu tun hat, kann ich erst nach Tests mit der RX 580 16GB sagen, da diese gerade im Desktop verbaut ist.

In reinen Office Maschinen, mit der Möglichkeit ab und zu ein aktuelleres Spiel zu spielen, hat durch die integrierte RDNA2 GPU jedenfalls wieder einen guten Schritt voran gebracht.

weitere Tests

- Gunnir index - intels erste Grafikkarte seit der i740

- Radeon RX 6400

- Radeon Vega 56

- Radeon RX 580 16 GB

- Vier Monitore an einer Grafikkarte - Retro Artikel

bereits verlinkt

Kommt gut in den Sonntag und viel Spaß beim lesen

Zuletzt bearbeitet:

(Nachtrag zu Bitlocker unter Windows 11 Home)