Hallo,

Ich möchte mir meinen ersten Gaming PC zusammenbauen und habe mich jetzt schon etwas ins Thema eingelesen. Bis jetzt habe ich weder Peripherie noch Gehäuse oder Komponenten.

Nun schwanke ich zwischen der RTX 4070 von NVIDIA und der RX 6800 XT von AMD.

Woran ich mich am meisten festhänge ist, dass die RTX 4070 nur 12GB VRam hat im gegensatz zu den 16GB der RX 6800 XT.

Gerade wo die Games momentan immer anspruchsvoller werden, frage ich mich ob 12GB noch ausreichen.

Da ich wirklich sehr unentschlossen bin und noch lange kein Profi, hoffe ich hier auf guten Rat.

Vielen dank im Voraus

1. Wie viel Geld bist du bereit auszugeben?

… ca. 650,-

2. Möchtest du mit der Grafikkarte spielen?

Ja.

... als Hobby und von Software habe ich um ehrlich zu sein noch nicht viel Ahnung.

4. . Wieviele und welche Monitore möchtest du nutzen? Wird G-Sync/FreeSync unterstützt? (Bitte mit Link zum Hersteller oder Preisvergleich!)

... /

5. Nenne uns bitte deine aktuelle/bisherige Hardware:

Bis jetzt habe ich noch keine Hardware aber ich würde wahrscheinlich als CPU den AMD Ryzen 7 5700x verbauen. Als Mainbord wahrscheinlich das 'ASUS Rog Strix B550-F Gaming (Wifi ll)(AMD,AM4,DDR4,ATX)'.

6. Hast du besondere Wünsche bezüglich der Grafikkarte? (Lautstärke, Anschlüsse, Farbe, Hersteller, Beleuchtung etc.)

... Möglichst leise und wenn möglich in Weiß erhältlich.

7. Wann möchtest du die Karte kaufen? Möglichst sofort oder kannst du noch ein paar Wochen/Monate warten?

... möglichst sofort.

Ich möchte mir meinen ersten Gaming PC zusammenbauen und habe mich jetzt schon etwas ins Thema eingelesen. Bis jetzt habe ich weder Peripherie noch Gehäuse oder Komponenten.

Nun schwanke ich zwischen der RTX 4070 von NVIDIA und der RX 6800 XT von AMD.

Woran ich mich am meisten festhänge ist, dass die RTX 4070 nur 12GB VRam hat im gegensatz zu den 16GB der RX 6800 XT.

Gerade wo die Games momentan immer anspruchsvoller werden, frage ich mich ob 12GB noch ausreichen.

Da ich wirklich sehr unentschlossen bin und noch lange kein Profi, hoffe ich hier auf guten Rat.

Vielen dank im Voraus

1. Wie viel Geld bist du bereit auszugeben?

… ca. 650,-

2. Möchtest du mit der Grafikkarte spielen?

Ja.

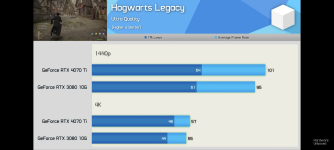

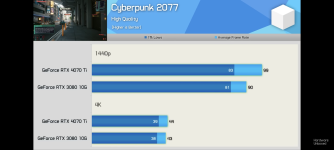

- Welche Spiele genau? … Genshin Impact, Sims 4, Hogwarts Legacy usw. Keine (Competitive) Shooter.

- Welche Auflösung? Genügen Full HD (1920x1080) oder WQHD (2560x1440) oder soll es 4K Ultra HD (3840x2160) sein? … Mindestens WQHD

- Ultra/hohe/mittlere/niedrige Grafikeinstellungen? … Hoch/Ultra

- Genügen dir 30 FPS oder sollen es 60 oder gar 144 FPS sein? … bin mir nicht sicher.

... als Hobby und von Software habe ich um ehrlich zu sein noch nicht viel Ahnung.

4. . Wieviele und welche Monitore möchtest du nutzen? Wird G-Sync/FreeSync unterstützt? (Bitte mit Link zum Hersteller oder Preisvergleich!)

... /

5. Nenne uns bitte deine aktuelle/bisherige Hardware:

Bis jetzt habe ich noch keine Hardware aber ich würde wahrscheinlich als CPU den AMD Ryzen 7 5700x verbauen. Als Mainbord wahrscheinlich das 'ASUS Rog Strix B550-F Gaming (Wifi ll)(AMD,AM4,DDR4,ATX)'.

6. Hast du besondere Wünsche bezüglich der Grafikkarte? (Lautstärke, Anschlüsse, Farbe, Hersteller, Beleuchtung etc.)

... Möglichst leise und wenn möglich in Weiß erhältlich.

7. Wann möchtest du die Karte kaufen? Möglichst sofort oder kannst du noch ein paar Wochen/Monate warten?

... möglichst sofort.