70.000 Stunden & 720 GPUs: Neuronales Netzwerk erlernt Minecraft mit YouTube-Videos

Dass eine Künstliche Intelligenz Spiele spielen kann, ist nicht neu. Insbesondere Schach-Algorithmen erlangten bereits große Bekanntheit, aber auch in StarCraft 2 ist eine KI erfolgreich. OpenAI gelingt es nun erstmals, eine KI eine Diamantspitzhacke in Minecraft herstellen zu lassen, wie zuerst SingularityHub berichtete.

Die erste von KI erzeugte Diamantspitzhacke

Das KI-Unternehmen aus San Francisco geht dabei nicht die ersten KI-Schritte in der Klötzchenwelt, früherer Versuche anderer Entwickler kamen bislang allerdings nicht unbedingt weit. Die Schwierigkeit liegt im nichtlinearen Spielablauf mit einer prozedural generierten Spielwelt ohne klare Ziele – ganz anders als auf einem Schachbrett oder einer StarCraft-Map. In einem Blogeintrag schildert das neunköpfige Entwicklerteam nun, wie auf Basis von rund 70.000 Stunden Minecraft-Videos auf YouTube ein Neuronales Netzwerk entstanden ist. Viele kurze Aufnahmen zeigen die KI in Aktion – etwa beim Umherklettern, Jagen von Nahrung, Einschmelzen von Erzen oder Fertigen von Gegenständen an der Werkbank.

Die Besonderheit: All das geschieht im Überlebensmodus, wohingegen frühere Minecraft-KIs häufig im Kreativmodus unterwegs waren oder aber in speziell angepassten, vereinfachten Eingabeumgebungen arbeiteten. So beispielsweise auch beim KI-Wettbewerb MineRL, im Rahmen dessen im Jahr 2019 keines der 660 teilnehmenden Teams bis zum Abbauen von Diamanten kam.

To the best of our knowledge, there is no published work that operates in the full, unmodified human action space, which includes drag-and-drop inventory management and item crafting.

OpenAI

OpenAI indes simuliert klassische Maus- und Tastatureingaben, wie sie auch ein echter Spieler tätigen würde. Jenem würde allerdings die verwendete Bildwiederholrate missfallen: Der Algorithmus simuliert mit lediglich 20 FPS, um mit weniger Rechenleistung auszukommen.

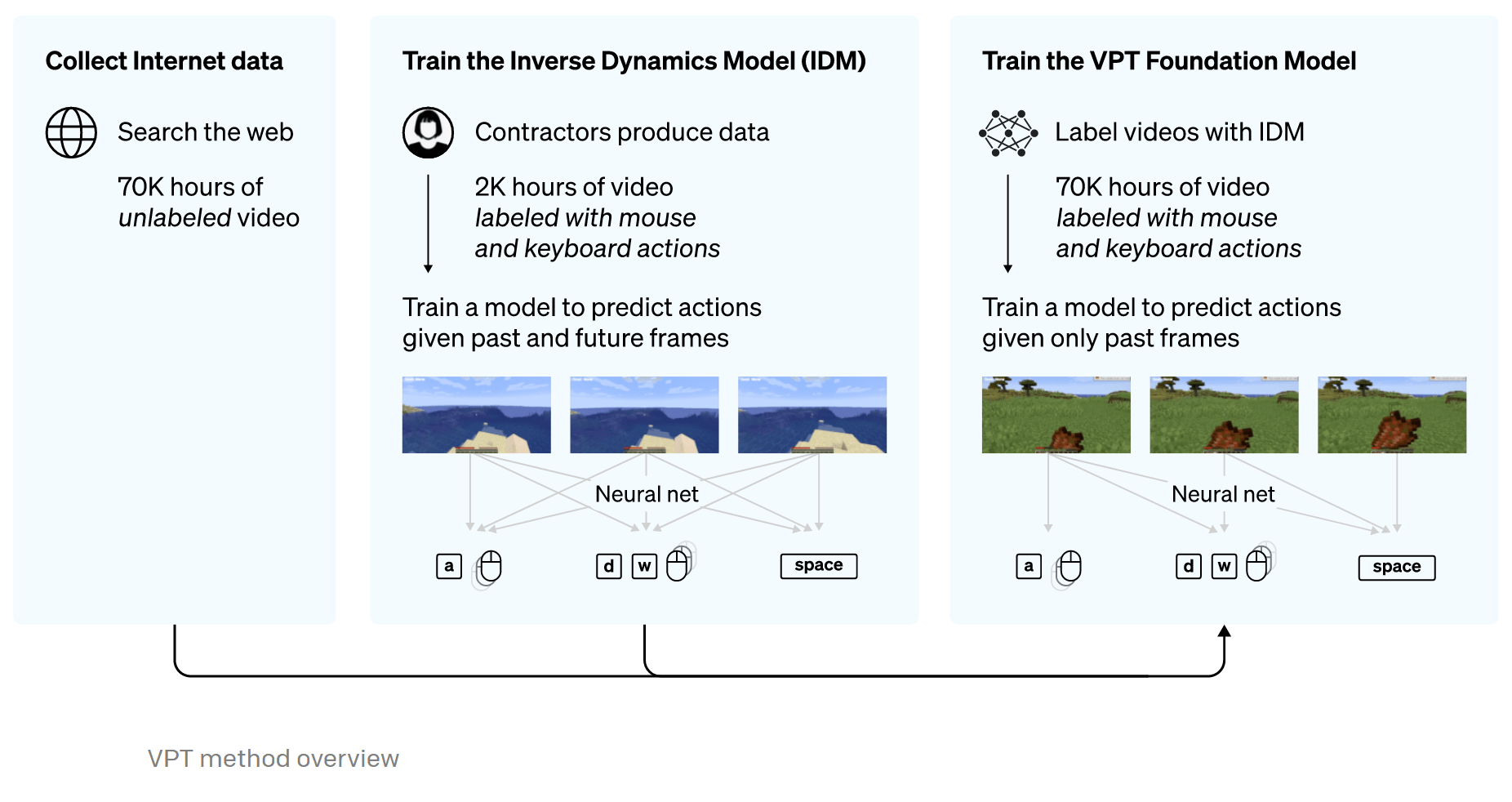

Video PreTraining beschäftigt Nvidia Volta und Ampere tagelang

Das Paper zum Projekt ist frei zugänglich, ebenso der Code via GitHub. Die Forscher schildern die Entwicklung ihrer Künstlichen Intelligenz ausführlich. Ihre Methodik nennen sie Video PreTraining. Zunächst wurde zu rund 2.000 Stunden an Minecraft-Videos von Hand protokolliert, welche Aktionen der Spieler in jedem Moment ausführt – also welche Tasten er drückt, wie er die Maus bewegt und was er eigentlich im Spiel tut. Damit wurde ein Inverse Dynamic Model trainiert, das entsprechende Beschreibungen zu 70.000 weiteren Stunden an Minecraft-Videos anfertigen konnte. Dabei handelte es sich um zu reinem Gameplay zusammengeschnittene 270.000 Stunden Material, das die Forscher von YouTube bezogen.

Im Grunde genommen wurde also zunächst ein Algorithmus geschrieben, der zu ihm zugeführten Spielszenen versucht zu erkennen, welche Eingaben seitens des Spielers zur gezeigten Sequenz geführt haben. Dabei wurden einzelne Aktionen isoliert und sowohl das Gameplay davor als auch danach betrachtet. Das sei für die KI viel einfacher, als das Geschehen nur auf Basis der Vergangenheit einzuordnen – so müsse der Algorithmus in ihrem Modell nicht erst versuchen vorherzusehen, was der Spieler im Video eigentlich vorhat, erklären die Forscher.

In order to utilize the wealth of unlabeled video data available on the internet, we introduce a novel, yet simple, semi-supervised imitation learning method: Video PreTraining (VPT). We start by gathering a small dataset from contractors where we record not only their video, but also the actions they took, which in our case are keypresses and mouse movements. With this data we train an inverse dynamics model (IDM), which predicts the action being taken at each step in the video. [...]

We chose to validate our method in Minecraft because it first is one of the most actively played video games in the world and thus has a wealth of freely available video data and second is open-ended with a wide variety of things to do, similar to real-world applications such as computer usage. [...]

OpenAI

Für das Erlernen der Zugehörigkeit von Eingaben zu Aktionen kamen insgesamt 32 Nvidia-Grafikbeschleuniger vom Typ A100 zum Einsatz – die Ampere-GPUs benötigten dennoch rund vier Tage zur Sichtung und Abarbeitung sämtlichen Materials. Noch länger dauerte mit rund neun Tagen die eigenständige Protokollierung der 70.000 Stunden an Minecraft-Videos, obgleich ganze 720 Volta-GPUs des Typs Tesla V100 verwendet wurden.

Behavorial Cloning bringt die erste Steinspitzhacke

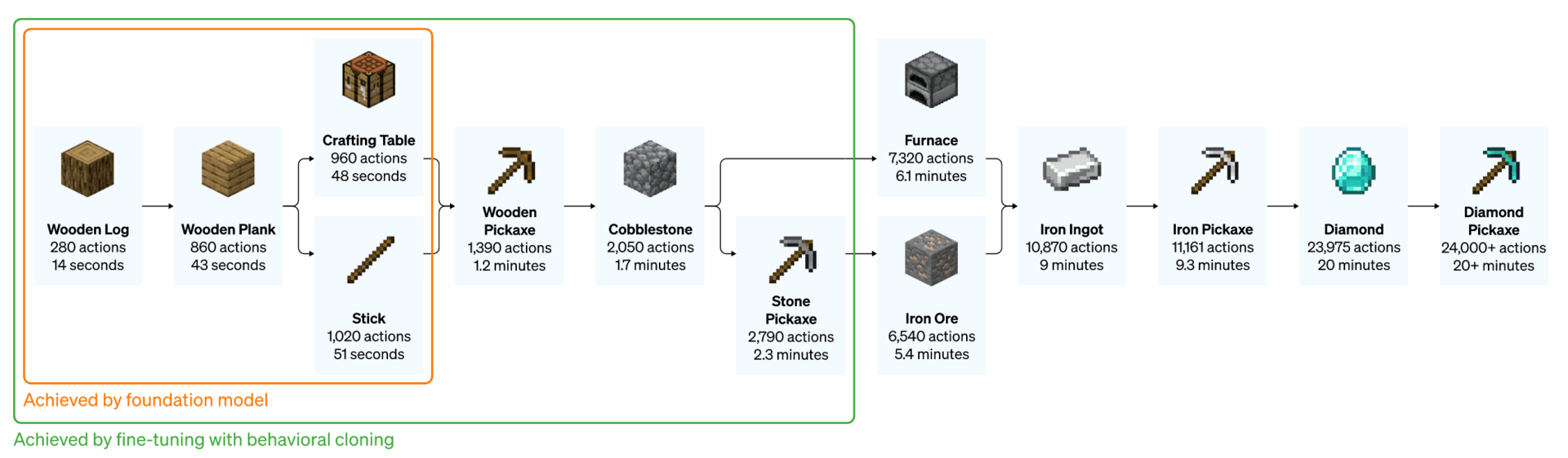

Das Ergebnis: Das neuronale Netz schafft es, in Minecraft umherzulaufen, Bäume zu fällen, das Holz weiterzuverarbeiten und sogar eine Werkbank herzustellen. Den OpenAI-Entwicklern ging das aber nicht weit genug; mit dem Konzept des Behavorial Cloning sollte die KI weiter optimiert werden. Das Feintuning sah es vor, den Algorithmus mit spezifischerem Gameplay zu füttern, um ihn auf ein konkretes Verhalten zu trainieren – beispielsweise das Bauen eines kleinen Hauses oder den typischen Ablauf der ersten zehn Spielminuten. Erneut kamen A100-Grafikkarten zum Einsatz, diesmal waren es allerdings nur 16 Stück. Mit den Berechnungen waren diese rund zwei Tage beschäftigt.

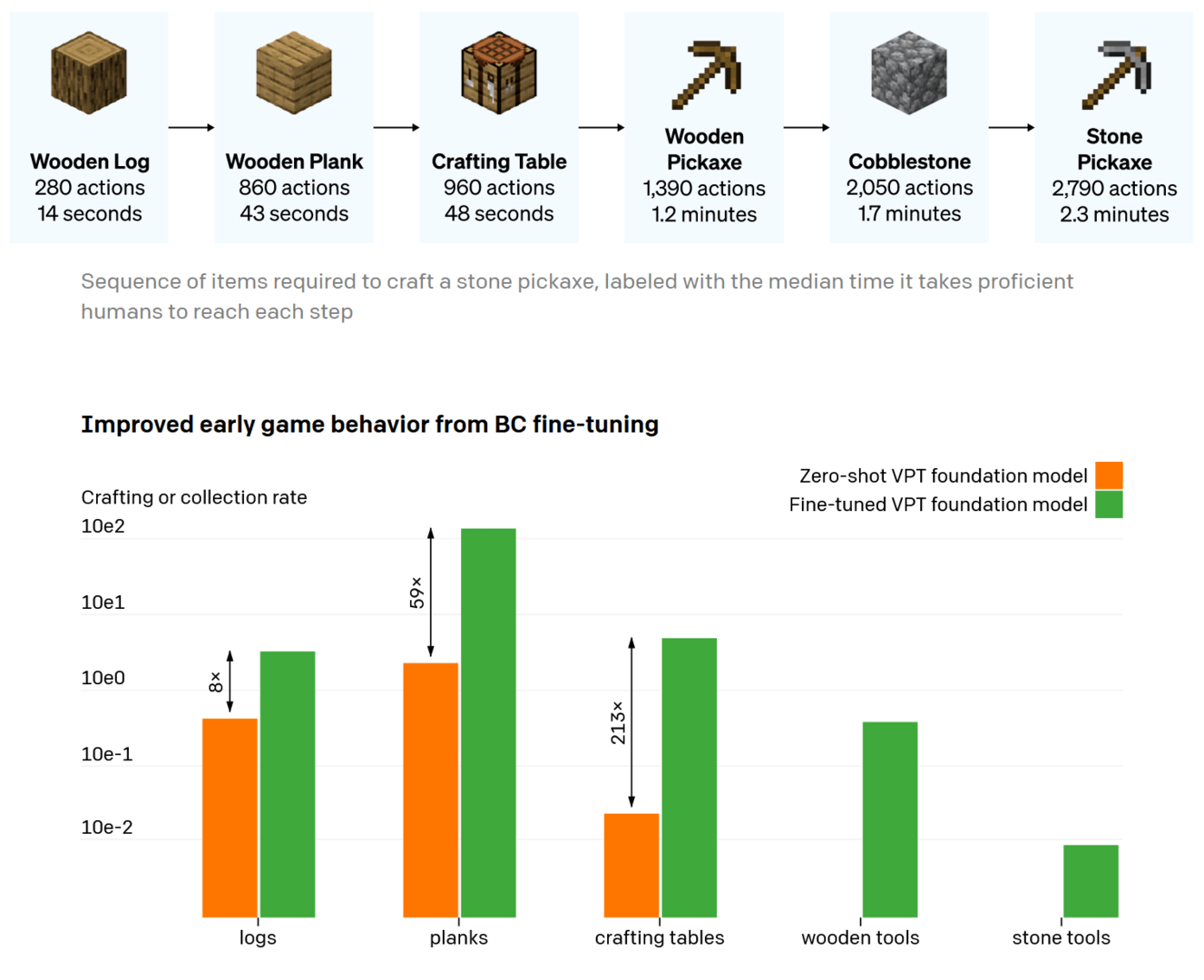

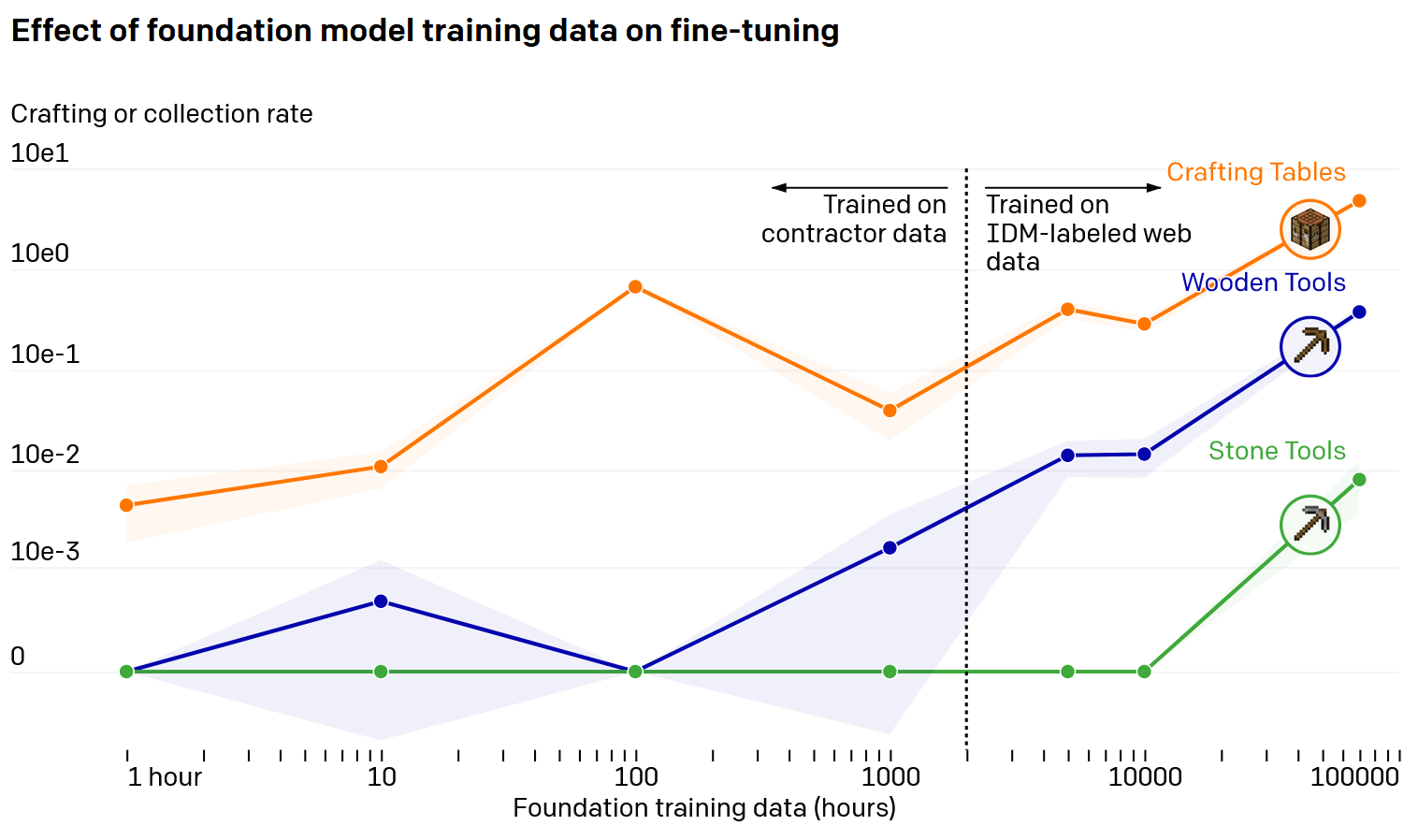

Und tatsächlich: Die Forscher beobachteten bei ihrer KI deutliche Verbesserungen. So benötigte beispielsweise das Fällen des ersten Baumes nur rund ein Achtel der Zeit. Die Effizienz beim Herstellen von Holzbrettern stieg um den Faktor 59; beim Herstellen einer Werkbank war es gar der Faktor 215. Außerdem fertigte das neuronale Netz nun Holzwerkzeuge, baute Stein ab und stellte anschließend eine Steinspitzhacke her. Gefüttert wurde der Algorithmus zu diesem Zweck mit rund 10.000 Stunden Video – für die Holzwerkzeuge hingegen reichten schon 100 Stunden Training.

Mit Reinforcement Learning ans Ziel

Als nächsten und letzten Schritt wählte das OpenAI-Team schließlich ein weiteres Feintuning mit Reinforcement Learning. Das Training wurde nun noch spezieller ausgerichtet, außerdem bekam die KI ein eindeutig definiertes Ziel: Sie sollte eine Diamantspitzhacke anfertigen. Darin inbegriffen waren offenkundig das Finden, Abbauen und Einschmelzen von Eisenerz, die Herstellung einer Eisenspitzhacke und letztlich das Suchen von Diamanten. All das konnte das neuronale Netz dank des zielgerichteten Trainings teilweise sogar schneller zustande bringen, als der durchschnittliche Minecraft-Spieler: Nach rund 4 Minuten war die Diamantspitzhacke fertig.

Eine Schwierigkeit waren dabei die Zwischenziele: Habe man der KI den Auftrag gegeben, mit einer soeben hergestellten Steinspitzhacke Eisen zu suchen, habe diese nach dem Crafting schnurstracks nach unten gebuddelt und die Werkbank zurückgelassen – dadurch dauerte die spätere Herstellung der Eisenspitzhacke wiederum länger. Folglich war ein weiteres Zwischenziel nötig: Das Abbauen und Aufnehmen des Crafting Tables; zudem mussten verschiedene Ziele unterschiedlich stark gewichtet werden.

Abermals benötigte das Verarbeiten der nötigen Gameplay-Schritte sehr viel Rechenleistung: 56.719 CPU-Kerne und 80 GPUs waren rund sechs Tage mit Machine Learning beschäftigt. Insgesamt 4.000 sukzessive optimierte Iterationen durchlief der Algorithmus, wobei insgesamt 16,8 Milliarden Frames eingelesen und verarbeitet wurden.

Weitere Anwendung in und außerhalb von Minecraft denkbar

In der neu erprobten Methodik des Video PreTraining sehen die neun Forscher großes Potenzial. Das Konzept sei gut auf andere Sachverhalte übertragbar, heißt es, auch Anwendungen außerhalb von Videospielen seien denkbar. Von Vorteil sei dabei, dass die KI auf den Umgang mit Maus- und Tastatureingaben ausgelegt wurde. Zur weiteren Entwicklung des neuronalen Netzes setzt man allerdings auch auf den am 1. Juli startenden MineRL-Wettbewerbs 2022. Die Teilnehmer dürfen das OpenAI-Modell verwenden, um die Künstliche Intelligenz für weitere spezielle Ziele zu trainieren – vielleicht entsteht auf diesem Wege schon bald die erste Netherit-Spitzhacke.

VPT paves the path toward allowing agents to learn to act by watching the vast numbers of videos on the internet. Compared to generative video modeling or contrastive methods that would only yield representational priors, VPT offers the exciting possibility of directly learning large scale behavioral priors in more domains than just language. While we only experiment in Minecraft, the game is very open-ended and the native human interface (mouse and keyboard) is very generic, so we believe our results bode well for other similar domains, e.g. computer usage.

We are also open sourcing our contractor data, Minecraft environment, model code, and model weights, which we hope will aid future research into VPT. Furthermore, we have partnered with the MineRL NeurIPS competition this year. Contestants can use and fine-tune our models to try to solve many difficult tasks in Minecraft.

OpenAI

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Im Podcast erinnern sich Frank, Steffen und Jan daran, wie im Jahr 1999 alles begann.